Publiée une fois par année, la Revue électronique suisse de science de l'information (RESSI) a pour but principal le développement scientifique de cette discipline en Suisse.

Présentation de la revue

Contenu du site

Se connecter

Open Access

Archives institutionnelles et archives centralisatrices: pratiques existantes et bonnes pratiques

Ressi — 31 décembre 2009

Lorraine Filippozzi, Haute Ecole de Gestion, Genève

Résumé

Cette étude a pour but de fournir une base documentaire solide au projet Info-Net Economy, futur portail thématique qui constituera le volet « Économie » de la bibliothèque électronique suisse E-Lib. Après avoir mis en évidence l’intérêt de proposer des portails centralisateurs et surtout l’opportunité que cela représente pour les professionnels de l’information, cette étude analyse les aspects organisationnels, techniques et marketing de projets similaires afin de mettre en évidence les bonnes pratiques à retenir.

Archives institutionnelles et archives centralisatrices: pratiques existantes et bonnes pratiques

Cette étude s’inscrit dans la première phase du projet Info-Net Economy (1), futur portail thématique qui constituera le volet « Économie » de la bibliothèque électronique suisse E-Lib (2). Ce portail sera notamment composé d’un accès aux publications électroniques issues des dépôts institutionnels d’un réseau de partenaires publics et académiques. Cette étude a pour objectif de retenir les bonnes pratiques en matière de dépôt institutionnel et de portails centralisateurs de ressources thématiques. Pour cela, une revue de la littérature concernant les portails centralisateurs de dépôts institutionnels et les archives ouvertes a été menée. Ces éléments de nature théorique ont été complétés par l’étude de projets similaires. Les bonnes pratiques retenues concernent principalement trois aspects : l’organisation, la technologie et la communication liées au projet. Mais avant des les aborder plus en détail, une description plus détaillée du contexte et une définition de la notion d’Open Access s’imposent.

1. Contexte de l’étude : Info-Net Economy

Info-Net Economy, qui fait partie du projet E-Lib, vise à offrir un point d’accès unique aux publications électroniques économiques suisses et à valoriser les ressources économiques provenant d’instituts suisses. Il doit favoriser les échanges entre institutions productrices d’informations économiques. Le portail contiendra les éléments suivants : un répertoire des différents acteurs économiques produisant des études/informations économiques (Hautes écoles, instituts spécialisés, offices spécialisés, etc.) ; un répertoire des publications électroniques de certains de ces organismes intéressés à être partenaires (11 en octobre 2009); un accès plus général à l’ensemble des sources d’information économiques utiles (accroissement de l’annuaire de sources ARESO (3)) ; un espace dédié aux échanges entre professionnels de l’information actifs dans le domaine, destiné à partager les produits documentaires réalisés ainsi que les bonnes pratiques.

La centralisation de ces informations sur un portail permettra de remédier au problème qui se pose actuellement en matière de recherche d’informations économiques validées : les ressources sont dispersées sur les sites des différentes institutions, ce qui nécessite de connaître ces différents acteurs. Même si certains sites proposent un regroupement de ressources, ils sont généralement limités à la sphère universitaire, les ressources d’autres types d’institutions restant méconnues. En outre, les avantages escomptés pour les partenaires sont les suivants : la valorisation de leurs publications ; la connaissance de nouvelles sources d’information et de nouveaux outils, du fait des échanges entre partenaires du réseau ; la garantie d’une meilleure visibilité pour leur service d’information documentaire mais aussi pour leur propre institution. Le réseau de partenaires créé pour Info-Net Economy regroupe des offices publics spécialisés, des instituts universitaires, des hautes écoles et des organisations faîtières qui publient dans le domaine de l’économie en Suisse et qui emploient des professionnels de l’information. En effet, le principal enjeu de ce projet est l’opportunité que représentent la centralisation et la diffusion des publications pour les professionnels de l’information, au niveau de leur institution, mais aussi au niveau plus global. Cette opportunité pourrait même constituer l’une des voies d’avenir de la profession.

En vue de la conception de ce portail spécialisé dans le domaine économique, et parallèlement à la phase de recensement des publications et des acteurs prévue durant la première partie du projet, une étude sur les répertoires institutionnels de recherche s’avère indispensable. De quoi faut-il tenir compte lors de la création d’un tel portail ?

La construction du portail d’accès aux publications spécialisées en économie provenant de notre réseau de partenaires se base sur les dépôts mis en place par ces derniers. Un dépôt institutionnel (institutional repository) est la collection numérique de la production intellectuelle d’une université ou d’un institut qui centralise, préserve et rend accessibles les connaissances générées par l’institution (4). Ces dépôts ont vu le jour grâce au principe d’archives ouvertes. Tel qu’entendu dans les universités et les hautes écoles suisses, il s’agit du dépôt des publications scientifiques sur un serveur institutionnel ou de la publication dans une revue fonctionnant selon le modèle Open Access (OA) (5). Les usagers ont ainsi un accès en ligne immédiat et gratuit aux articles de recherche : ils peuvent lire, décharger, copier et créer des liens vers le texte intégral sans réserve mais avec obligation de citation. Ce principe offre de nombreux avantages tant pour le chercheur que pour l’utilisateur : rapidité de publication, conservation des droits d’auteurs, accès gratuit et universel, etc. (6)

Ce principe défini, voici les différents projets similaires étudiés qui serviront de modèles pour mettre en valeur les bonnes pratiques retenues. Il s’agit d’un choix de dépôts institutionnels (ou archives institutionnelles), de dépôts centralisateurs (archives centralisatrices) (7) et de portails thématiques qui ont été sélectionnées en fonction de leur proximité géographique, de leur exemplarité et de leur originalité.

| Dépôts Institutionnels | Infoscience (8) Conçue comme une véritable archive institutionnelle, Infoscience centralise et conserve la production scientifique de l’EPFL. Infoscience est une référence en matière de dépôt institutionnel selon le classement Ranking of world repositories (9), où il est classé en septième position. |

Forschungsplattform Alexandria (10) Plateforme servant de vitrine à la recherche menée à l’Université de Saint-Gall, Alexandria a non seulement pour but de rendre publics les résultats de la recherche mené au sein de l’institution, mais aussi de mettre en valeur les instituts de recherche, leurs chercheurs (profils personnels) et les projets en cours. Alexandria n’est pas une archive institutionnelle au sens strict car il n’y a pas de vision d’archivage. Cette plateforme est néanmoins classée en huitième position dans le classement cité ci-contre. |

|---|---|---|

| Dépôts centralisateurs |

RERO DOC (11) |

Driver (12) Portail multidisciplinaire pour la recherche européenne en libre accès, Driver fédère les répertoires d’archives ouvertes européens. Il compte sur treize partenaires en Europe pour constituer le portail paneuropéen d’accès libre aux publications de recherche et regroupe à ce jour plus de 200 dépôts institutionnels ou thématiques, dont la plate-forme d’archives ouvertes française HAL (Hyper-article en ligne). Pour le moment, Driver couvre essentiellement des sujets tels que la biologie, l’anthropologie et l’informatique, avec un accès aux ressources par région géographique. |

| Portails thématiques | Econbiz(13) Conçue comme un portail thématique, la bibliothèque virtuelle des sciences économiques est un projet de collaboration entre la Deutsche Zentralbibliothek für Wirtschaftswissenschaften (ZBW) et l’Universitäts und Stadtbibliothek Köln (USB Köln). Elle contient un répertoire de signets électroniques, un métamoteur de recherche dans les catalogues des bibliothèques générales, des liens vers des bases de données en texte intégral, un agenda des manifestations scientifiques internationales et des services d’information. |

Economists online (14) NEREUS - Networked Economics Resources for European Scholars - représente un consortium de bibliothèques universitaires européennes, disposant de collections majeures en économie et se proposant de fournir collectivement de nouveaux contenus et de développer des services d'information innovateurs pour l'économiste. Le but est de créer un réseau européen de bibliothèques de recherche et de relier ainsi les ressources issues de la recherche universitaire en Europe. À travers le portail thématique Economists Online, l'accès en ligne à la production des principaux économistes universitaires constitue le service-clé de NEREUS. Ce projet consiste à numériser, organiser, archiver et diffuser la production complète des économistes, visant ainsi à rendre disponibles autant de textes intégraux que possible. |

Chacune de ces sources a été étudiée selon la même grille d’analyse, qui contenait les points suivants : contexte de création, objectifs, mode de fonctionnement, structure technique générale, contenu (types de publications), fonctionnalités (y compris web 2.0), interface, ergonomie, outil de recherche, types de recherche proposés, gestion du multilinguisme, format, récupération et qualité des métadonnées, promotion, et finalement les bonnes idées à retenir. Les conclusions de l’analyse de ces différents points ont été regroupées en trois parties : contexte et organisation, technologies et contenus offerts, et finalement promotion.

2. Contexte et organisation

Autant dans les projets de dépôts institutionnels que lors de la création de portails centralisateurs de ressources, le mode de fonctionnement est un facteur de réussite ou d’échec déterminant. Il est important de souligner les différents aspects à prendre en considération pour faire les choix les plus adaptés en fonction du contexte : mode de fonctionnement, type de partenaires, niveau de collaboration et rôle des professionnels en information documentaire dans de tels projets.

Mode de fonctionnement

Le mode de fonctionnement en réseau est très généralement adopté dans les projets de fédération de dépôts institutionnels (Econbiz, Driver, Economists online). Constitué autour d’un noyau dur de départ, le partenariat entre 2 à 10 institutions donne l’impulsion et assure le suivi du projet. Devenant un véritable centre de compétence, le réseau d’experts mis en place devient parfois même fournisseur de service pour les gestionnaires de dépôts. Les archives institutionnelles se sont structurées en réseaux nationaux, voire internationaux, avec pour objectif de partager les compétences, mais aussi de créer des outils et des services communs (15).

Type d’archives ouvertes

Il existe différents types d’archives ouvertes : elles peuvent être institutionnelles (liées à un organisme producteur, par exemple une université) ou centralisatrices (liées à plusieurs organismes producteurs, par exemple RERO-DOC qui sert de dépôt à plusieurs universités et hautes écoles), multidisciplinaires (elles couvrent plusieurs domaines de la connaissance) ou thématiques (focalisées sur un domaine de la connaissance, par exemple l’économie avec Repec (Research Paper in Economics) (16), ou les sciences de l’information et la bibliothéconomie avec E-lis (17)). L’impulsion de ces archives ouvertes institutionnelles, centralisatrices ou thématiques, provient le plus ouvent du milieu universitaire. Mais on trouve également des intituts de recherche tels que le Centre national de la recherche scientifique (CNRS) français, qui a créé le dépôt multidisciplinaire HAL (Hyper Articles on Line) (18), ont aussi intérêt à rendre publics les publications de leurs chercheurs. La multiplication des projets démontre l’intérêt des différentes communautés scientifiques à créer des archives ouvertes ainsi qu’à être présentes sur des portails centralisateurs dans un effort collaboratif de valorisation de la publication scientifique.

Niveau de collaboration

Toutefois, comment entretenir cette collaboration sur le long terme ? Comment créer un vrai centre de compétences ? En observant les projets similaires, on constate qu’il est nécessaire que les partenaires du réseau soient soutenus par leur instance dirigeante, qui doit être sensibilisée au principe des archives ouvertes. Les professionnels de l’information ont ici un rôle primordial à jouer. Pour convaincre les autorités de tutelle, ils peuvent s’appuyer sur les chiffres concernant l’Open Access et les dépôts institutionnels. Aux États-Unis, plus de 90% des universités ont institué un système de dépôt institutionnel ou sont en cours de réflexion pour y parvenir (19). Ce soutien au mouvement des archives ouvertes peut même être élevé au niveau national, comme c’est le cas pour HAL (20), qui est soutenu par le CNRS et auquel participent universités et centres de recherche publics (21). Dans la même optique, Repec (22) est né d’un effort collectif de volontaires provenant de plus de 60 pays dans le but d’améliorer la diffusion de la recherche en économie. Si, à l’heure actuelle, très peu de pays se sont dotés d’une politique gouvernementale de soutien à l’Open Access, celui-ci est très courant un niveau des universités (23). En Suisse, l’étude menée en 2009 par la Hochschule für Technik und Wirtschaft (HTW) de Coire a identifié 9 dépôts de hautes écoles universitaires et 8 dépôts en projet qui verront le jour d’ici un à deux ans (24). Le projet E-lib verra par ailleurs la création de la bibliothèque électronique suisse, portail scientifique national (25).

Rôle des professionnels en information documentaire

La démocratisation du principe d’archives ouvertes au sein des institutions de recherche académique représente une opportunité pour les bibliothèques scientifiques. En effet, en s’impliquant dans les projets mis en œuvre, elles obtiennent un nouveau rôle au niveau de l’acquisition, de l’évaluation et de la diffusion de la recherche (26). Elles peuvent se positionner en intermédiaire entre les chercheurs et les éditeurs, mais aussi entre les chercheurs et le public. Ce nouveau rôle renforce la proximité entre les bibliothèques et les chercheurs et s’inscrit dans l’évolution globale, voire la mutation de leur mission (27). L’information scientifique représente un enjeu de taille pour les bibliothèques académiques et de recherche car elle soulève des défis importants non seulement quant à sa diffusion et à sa conservation, mais aussi quant à sa maîtrise par les usagers. La formation des usagers revient au cœur de leur mission dans des projets de learning centers, ou centres d’apprentissage (28), qui offrent notamment des formations à la maîtrise de l’information et des technologies de l’information et de la communication. Les professionnels de l’information ont donc un rôle stratégique à jouer dans ce climat de changement de comportement des usagers et des modes de publication. Il est même possible, voire souhaitable, qu’ils obtiennent le leadership de projets liés aux archives ouvertes (29).

Cependant, les bibliothèques doivent parfois faire face à des difficultés d’intégration entre le pôle informatique qui réalise les dépôts institutionnels et les instituts de recherche qui les rempliront. Il devient alors nécessaire pour elles de faire valoir leurs compétences en matière d’information numérique et de prendre une place centrale dans sa conservation et sa diffusion. Elles sont en effet, par leur position d’intermédiaire, les plus à même de relayer les besoins et les demandes de leurs usagers (30). Cette collaboration avec les développeurs, qui ont une vision d’ensemble des différents systèmes en place et assurent la bonne intégration du dépôt au système d’information en place, est un des facteurs de succès de tels projets (31).

Si le soutien politique est nécessaire à la vie des centres de compétences mis en place, il est aussi central dans la diffusion du principe des archives ouvertes. Tous les projets étudiés ont pour base une politique interne régissant le dépôt des publications et la création d’archives institutionnelles. Ces politiques se basent sur la Déclaration de Berlin sur le libre accès à la connaissance (2003), où les signataires s’engagent, entre autres, à inciter les chercheurs à éditer leur travail selon les principes du libre accès et à encourager les établissements culturels à soutenir l'accès aux ressources sur Internet. Depuis, un nombre croissant d’institutions académiques ont mis en place leur propre dépôt et instauré l’obligation pour leurs chercheurs d’y déposer leurs publications. Il est difficile de recenser le nombre total de dépôts dans le monde, mais il existe un répertoire où les entrepôts d’archivage libre peuvent se déclarer (32).

Pourtant, malgré le soutien hiérarchique des organes de direction de la recherche, il reste un gros travail à accomplir pour sensibiliser et inciter les chercheurs à publier selon ce modèle. On observe en effet dans certains domaines une méfiance et une certaine résistance au changement. Elles sont peut-être dues à la méconnaissance du principe de l’OA et à la crainte d’une perte de qualité et de renommée. Les bibliothèques doivent contribuer à l’information de leurs utilisateurs dans le but de renforcer leur confiance et s’assurer qu’ils adhèrent aux projets de dépôts institutionnels. Elles doivent aussi offrir un support technique aux instituts pour éviter que chacun fasse comme il pense/peut et faciliter l’harmonisation des pratiques. Pour cela, elles peuvent s’appuyer sur les travaux effectués par des leaders des archives institutionnelles tels que SHERPA (33), consortium qui promeut la création d’archives dans tous les établissements de recherche et d’enseignement supérieur au Royaume-Uni. Un service particulièrement utile est Sherpa-RoMEO (Rights MEtadata for Open archiving) : il fournit une liste des licences de publications des éditeurs concernant l’archivage de leurs publications par les auteurs qui permet de savoir si l’éditeur permet ou non le dépôt de la publication dans une archive institutionnelle (34), et, si oui, quelles en sont les conditions (par exemple s’il y a une période d’embargo suivant la publication). Actuellement, selon les statistiques du site SHERPA-RoMEO, 95 % des périodiques donnent le droit aux auteurs d’auto-archiver, et il a été prouvé que l’autoarchivage augmente la visibilité et donc le lectorat (35). Communiquer et informer sur les enjeux liés aux dépôts institutionnels est donc la première bonne pratique à retenir lors de projets liés à l’Open Access.

3. Technique, contenu et fonctionnalités

Une fois le projet mis sur pied, il s’agit d’étudier les différents projets similaires afin de procéder à certains choix techniques concernant notamment la structure, les contenus et les fonctionnalités souhaités, ainsi que les outils existants et les normes à respecter.

Structure technique

La structure technique des différents portails similaires au futur portail Info-Net Economy repose sur le principe de la confédération de dépôts institutionnels hébergés localement. Ces dépôts, comme Infoscience (36) ou Alexandria (37), sont constitués non seulement des objets eux-mêmes, mais aussi de métadonnées descriptives. Dans une structure de fédération de dépôts, comme Driver (38), les publications des institutions partenaires restent dans leur dépôt local et le portail ne fait que signaler ces sources par les métadonnées qu’il y a récoltées et pointer vers elles par des liens. Il est ainsi possible de fédérer la recherche dans les métadonnées des différentes institutions productrices tout en leur en laissant la responsabilité de la gestion et la complète propriété.

Contenus et fonctionnalités

Ces portails offrent divers contenus et fonctionnalités. Au niveau du contenu, on trouve différents types de publications académiques : articles scientifiques en majorité, livres et chapitres de livres, travaux d’étudiants (mémoire de master et thèses de doctorat, parfois aussi mémoires de bachelor), mais aussi travaux de professeurs-chercheurs publiés ou non (pré-publications, working papers, papiers et actes de conférences, etc.) ainsi que, comme dans le cas de l’Archive Ouverte de l’Université de Genève (39), matériel de cours (supports, enregistrements, etc.). Ces contenus de type académique sont souvent complétés par des publications plus vulgarisées telles que des articles de journaux et des communiqués de presse. Dans certains cas il n’y a pas de limitation à la typologie des documents ; il est ainsi de moins en moins rare de voir des données brutes de recherche ou des contenus multimédia. Le contenu des dépôts est généralement détaillé dans leur politique, outil essentiel permettant de définir de manière précise la portée du dépôt. En plus des publications elles-mêmes, presque tous les sites observés proposent une rubrique « Actualités » qui recense aussi bien les nouveaux projets de recherche que la parution d’ouvrages. Ces différents contenus sont généralement mêlés et ce sont les fonctionnalités de recherche qui permettent de cibler l’un ou l’autre des contenus selon ses besoins. Le défi à relever est celui de l’ergonomie. En effet, comment structurer les différents contenus de manière simple pour rendre la recherche la plus intuitive possible ? Pour répondre aux différents besoins, les fonctions de recherche doivent être complètes. De la barre de recherche simple aux champs de recherche combinés de la recherche avancée, en passant par la navigation dans la classification thématique, les types de documents et les acteurs concernés, sans oublier les options de filtrage des résultats, il s’agit d’offrir une large palette de services. Deux exemples sont à signaler pour la simplicité de la recherche et la bonne exploitation des filtres de recherche : il s’agit d’Infoscience (EPFL) (40) et d’Alexandria (Université de Saint-Gall) (41). L’ergonomie de la fonction de dépôt des publications par les chercheurs est généralement bien soignée, et les marches à suivre sont claires et simples.

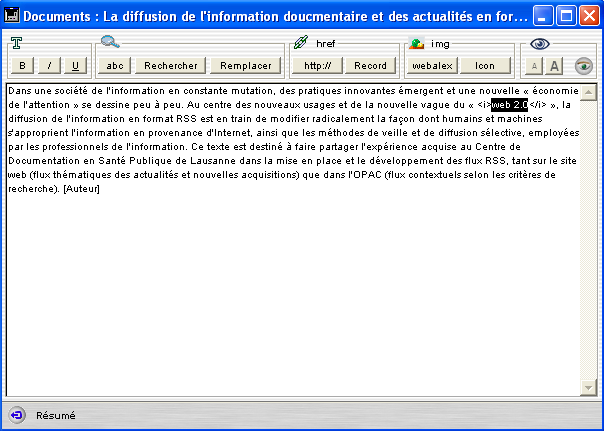

Les fonctionnalités de type web 2.0 sont encore peu présentes dans les portails de recherche académiques. Dans les projets observés pour cette étude, l’usage de flux RSS est courant pour signaler les nouveautés (Alexandria) ou les nouvelles publications sur une recherche effectuée (Infoscience). Cependant peu de possibilités d’interactions sont offertes aux usagers des portails, chercheurs ou grand public. Aucun des portails observés, de type académique, ne permet aux usagers de « tagger » eux-mêmes les notices ou de poster des commentaires au sujet des ressources. Les possibilités de recherche sémantique sont donc amoindries. Pourtant le projet Inspire (42), portail de nouvelle génération dans le domaine de la physique, prévoit de faire contribuer les usagers au « taggage » et au commentaire des ressources (43). Cet exemple permettra de démontrer la pertinence d’une telle approche. Il est intéressant de relever qu’Infoscience permet à l’utilisateur, une fois enregistré, de s’approprier les données en créant sa collection personnelle en ligne ou en paramétrant le moteur de recherche selon ses besoins. Par ailleurs, si tous les portails observés offrent des FAQ (Frequently asked questions ou Foire aux questions) en ligne, seul Econbiz (44) propose un véritable service de renseignement et de référence en ligne.

Le choix de proposer un site multilingue soulève la question de la gestion du multilinguisme. C’est un aspect particulièrement important dans un projet suisse tel qu’Info-Net Economy. Il s’agit en effet de proposer une interface, un outil de recherche et un affichage des résultats en plusieurs langues sans alourdir la présentation générale du site. La solution la plus couramment adoptée est celle de proposer une interface en plusieurs langues et des métadonnées dans la langue de la publication déposée. Dans ces cas, pour améliorer la recherche, les mots-clés peuvent éventuellement être traduits en plusieurs langues.

Outils et normes

Au niveau technique toujours, il est important de connaître et de bien comprendre les différents outils servant au dépôt de publications d’une part et à la recherche fédérée dans différents dépôts d’autre part.

Concernant les outils de dépôts, selon le Registry of Open Access Repositories (45), les deux outils logiciels les plus utilisés dans le monde sont Dspace (46) (plus de 400 utilisateurs) et Eprints (47) (plus de 300 utilisateurs, dont l’Université de Zürich). CDS-Ware/Invenio (48), le système développé par le CERN, arrive quant à lui en septième position et compte parmi ses utilisateurs l’EPFL et RERO-DOC. Il s’agit de systèmes d’entrepôts de données.

Cependant, pour que cette fédération des ressources soit possible, il faut appliquer les mêmes normes. En effet, l’aspect déterminant de ces portails est la recherche, qui passe forcément par les métadonnées, et à ce sujet le mot d’ordre est « standardisation ». On parle de dépôts compatibles OAI. Mais qu’est-ce qu’OAI ? Mouvement de promotion des archives ouvertes, l’Open Archive Initiative développe un ensemble de protocole et de standards d’interopérabilité facilitant la diffusion des contenus des documents. Le protocole central est OAI-PMH, Open Archive Initiative Protocol for Metadata Harvesting, ou « Protocole de collecte de métadonnées de l’Initiative Archives Ouvertes ». Il définit un standard pour transférer des collections de métadonnées. Il a été établi dans le cadre de l’Initiative Archives Ouvertes pour implanter des bases interopérables de pré-publications scientifiques soumises par leurs auteurs. L’objectif de l’Initiative Archives Ouvertes est donc très spécifique aux communautés de chercheurs. Pourtant le protocole se révèle aussi intéressant pour des applications plus patrimoniales.

Pour les métadonnées, le protocole OAI-PMH repose sur une norme de description bibliographique, le Dublin Core non qualifié : schéma de métadonnées numériques qui permet de décrire des ressources numériques et d’établir des relations avec d’autres ressources. Il comprend 15 éléments de description formelle (titre, créateur, éditeur), intellectuels (sujet, description, langue) et relatifs à la propriété intellectuelle. On peut convertir les notices primaires en format Dublin Core. De plus, le Dublin Core est facilement encodable en XML.

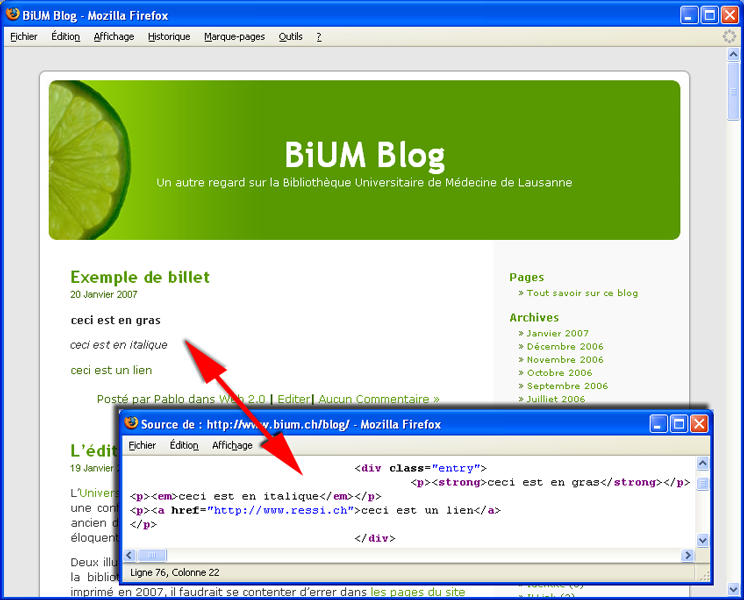

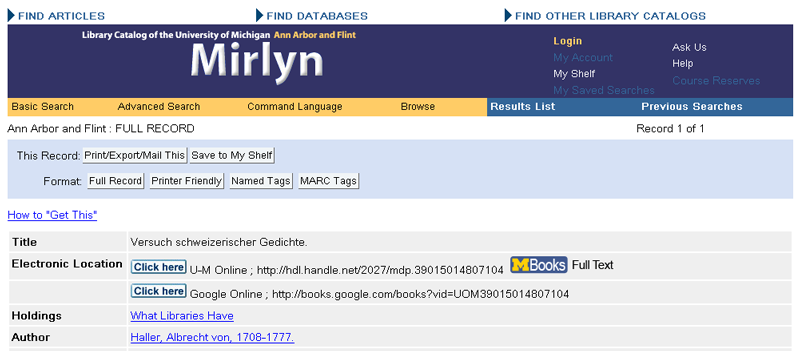

Un dépôt institutionnel qui applique la norme OAI-PMH possède une base de métadonnées qu’il « expose » aux moissonneurs (49). Ces métadonnées y sont disponibles dans différentes formats pour répondre à différents besoins. Si le format Dublin Core est l’exigence minimale imposée par la Norme OAI-PMH, le format MARCXML permet d’obtenir des métadonnées plus riches à partir de catalogues de bibliothèque par exemple. Ainsi le protocole permet de centraliser les métadonnées référençant diverses ressources tout en laissant ces ressources à leur emplacement initial. Il est alors possible d’accéder à ces ressources en architecture distribuée, en rassemblant les métadonnées et en les exploitant pour les besoins spécifiques d’un service. Dans le cadre de projets de portails tels qu’Info-Net Economy, les ressources sont gérées dans différents établissements. Pour fournir un accès commun à ces ressources, un système permet d’en rassembler les métadonnées dans une base commune. En bref, ce protocole d’échange permet de créer, d’alimenter et de tenir à jour, par des procédures automatisées, des serveurs de métadonnées qui signalent, décrivent et rendent accessibles des documents, sans les dupliquer ni modifier leur localisation d’origine (50). Il permet aussi l’agrégation de ressources hétérogènes d’origines diverses. Ce procédé de recherche et d’agrégation des ressources est nommé moissonnage, ou harvesting (voir Figure 1).

Moissonnage OAI-PMH

Le moissonnage OAI-PMH nécessite deux types d’acteurs : d’une part les entrepôts déclarés (fournisseurs de données) ; et d’autre part les moissonneurs (fournisseurs de services). Les fournisseurs de données exposent leurs métadonnées en implémentant le protocole OAI et en donnant accès à leur catalogue au moyen d’un entrepôt OAI, outil chargé de répondre aux requêtes formulées par les fournisseurs de service ; tandis que les moissonneurs parcourent les dépôts et recueillent les métadonnées à l’aide du protocole OAI. Les réponses sont données au format XML et contiennent, selon la requête formulée, des informations sur l’entrepôt, des identifiants, des métadonnées. Par « moissonner » on entend ici le fait de récupérer une copie des métadonnées en local puis de la rendre cherchable comme valeur ajoutée. Un même dépôt peut parfaitement être interrogé par plusieurs moissonneurs. Les moissonneurs permettent d’agréger les ressources provenant de différents dépôts OAI. Ils nourrissent une base XML, qui peut aussi être alimentée par d’autres moyens, y compris en ressources locales et par intervention humaine. Dans ce cas, il faut établir en amont le processus de recherche et de sélection des URL des bases à moissonner (automatique ou manuel, parfois les deux), avec la fréquence de visites et de mises à jour pour chaque base et déterminer, en aval, le stockage, l’indexation, l’exploitation et l’affichage des données (transformation XSLT). En l’absence de dépôt institutionnel moissonnable répondant à la norme OAI-PMH, il est donc possible d’alimenter une base de métadonnées au moyen de flux RSS adaptés pour signaler des publications disponibles sur un site web ou au moyen d’une application web 2.0 basée sur des requêtes URL pré-paramétrées, comme le prévoit le projet RODIN (51), outil pour l’agrégation et le couplage de sources d’information. Il est par ailleurs aussi possible de récupérer les données de certains dépôts non OAI au moyen de ce même type de requêtes.

Figure 1(52)

Le schéma ci-dessus (Figure 1) expose le principe du moissonnage, avec :

- à gauche les différents dépôts institutionnels fournisseurs de données, avec chacun leur entrepôt de métadonnées ;

- au milieu le moteur de moissonnage qui comprend un moteur de moissonnage et un agrégateur de métadonnées (fournisseur de services)

- et à droite l’interface de recherche fédérée proposée à l’utilisateur final.

Il existe des moteurs de moissonnage open source, parmi lesquels les plus utilisés sont OAIster (53), CiteBase Search (54), OAIHarvester2 (55), PKP Harvester (57), Framework SDX (57) ou encore Google Scholar (58). On peut aussi développer sa propre fonction de recherche dans les métadonnées de plusieurs archives sélectionnées (59), toujours au moyen de requêtes URL dédiées.

Ainsi, les données exposées OAI sont référencées par les moteurs de recherche de documentation scientifique au niveau mondial (comme Google Scholar, Bielefeld academic search engine), mais aussi par les moteurs de recherche simple (Google, Yahoo, MSN, etc.). Les dépôts créés peuvent donc être moissonnés à leur tour et ainsi gagner en visibilité. On constate ainsi que les différents types de dépôts sont complémentaires.

Si le jeu de métadonnées et la manière de les exposer aux moissonneurs est dictée par la norme OAI-PMH, l’indexation thématique de chaque document reste libre. Chaque institution décide donc de sa manière d’indexer, de suivre un thésaurus de vocabulaire contrôlé ou de laisser ce champ libre aux auteurs qui déposent leurs publications. Cela pose problème au moment de la centralisation des métadonnées de plusieurs institutions, car il faut établir des listes de concordances pour faciliter la recherche fédérée par sujet. Driver, portail centralisateur de plus de 200 dépôts, a pris l’option de laisser le champ sujet libre et ne propose donc pas de recherche par sujet ou de navigation dans la classification.

La standardisation des métadonnées concerne non seulement leur moissonnage et leur exposition, mais aussi leur conservation. Si le jeu de métadonnées requis par Dublin Core convient bien à la manipulation des données, il est limité en termes de gestion et de conservation. Des formats internes de gestion et de conservation existent, plus complets et recouvrant les champs requis par Dublin Core : actuellement le plus courant est MARC (60), plus précisément MARCXML, qui est facilement transformable en différents formats (HTML pour l’affichage direct, Dublin Core ou MODS pour supporter les protocoles de harvesting) (61).

Il est par ailleurs intéressant de relever l’autre projet de l’Open Archive Intitiative, conjoint à OAI-PHM : OAI-ORE (Open Archives Initiative Object Reuse and Exchange) (62). Ce protocole définit un standard pour la description et l’échange de ressources web complexes (exemple : une thèse est un tout composé d’un ensemble de chapitres, elle peut avoir différentes versions, être suivie d’articles, etc.). Tandis qu’OAI-PMH est centré sur les métadonnées, OAI-ORE prend en compte les ressources (les objets de la description). Il s’agit d’une nouvelle manière d'enrichir et d'utiliser les métadonnées décrivant les documents conservés dans des entrepôts OAI en vue de leur réutilisation. Les logiciels de dépôt d’archives Dspace et Eprints (63) supportent ce nouveau protocole.

En définitive, malgré les standards qui permettent l’agrégation des données, celle-ci ne se fait pas sans adaptations ni ajustements. En effet, il reste souvent un travail d’homogénéisation des données à effectuer, car la norme laisse une certaine marge de manœuvre au niveau des métadonnées descriptives. En particulier, le Dublin Core n’est pas interprété partout de la même manière. En effet, la « non-qualification » du Dublin Core, si elle laisse une certaine souplesse et une marge de manœuvre dans son utilisation, entraîne de légères disparités dans les métadonnées. Il en résulte un travail d’uniformisation qui peut être important en cas de nombreux dépôts à centraliser. Dans ces cas aussi, il faut veiller à la fusion des termes d’indexation et de la classification des différents dépôts en un thésaurus et un classement communs. Pour pallier à ce genre d’obstacles, Driver propose un guide très précis aux dépôts souhaitant être présents sur le portail. Ces instructions doivent obligatoirement être suivies pour que leur participation soit validée et leur données recherchables sur le portail. En contrepartie, Driver leur offre soutien et retours d’expériences sous forme de mentorat (64).

4. Communication

La communication est un aspect crucial lors de la création d’un dépôt d’archives ouvertes ou d’un portail centralisateur de ressources. Dès le départ, la communication entre partenaires de projets est déterminante du bon déroulement du projet. Ensuite, une fois le dépôt créé, il s’agit non seulement de convaincre les chercheurs de déposer leurs publications, mais aussi de sensibiliser les instances dirigeantes à l’importance de l’auto-archivage et à l’intérêt de figurer dans un portail centralisateur. La visibilité est un enjeu à mettre en avant et à développer.

Avec les partenaires

Le travail de communication commence donc au sein de l’équipe de projet. Autour d’un noyau dur de professionnels, il s’agit de mettre en place une véritable dynamique de collaboration et de partenariat autour d’objectifs communs. Le partage du savoir-faire est évidemment bénéfique à chacun, et une bonne répartition des tâches en fonction des compétences permet à chacun de s’impliquer activement. Pour les dépôts institutionnels, il est important d’obtenir une masse critique de contenu pour donner l’impulsion aux autres dépositaires potentiels. Pour les portails centralisateurs, une fois l’outil fonctionnel, le noyau dur de départ peut être étendu à d’autres partenaires.

Avec la hiérarchie

Tout au long du projet, la communication avec les instances de tutelles des institutions est nécessaire, car ce sont elles qui peuvent inciter, voire éventuellement imposer le dépôt obligatoire des publications. Ce soutien « politique » est nécessaire au bon fonctionnement des dépôts. Quant aux portails centralisateurs, il est important de souligner aux instances dirigeantes des partenaires de projets que leur participation constitue un gain en termes de visibilité et de promotion de la recherche.

Avec les usagers

La communication entre partenaires et avec les instances décisionnelles est certes importante, mais elle l’est aussi vis-à-vis du public. Il s’agit de promouvoir l’outil mis en place auprès des chercheurs et des usagers. Les chercheurs doivent être formés à l’utilisation du dépôt, et une aide à la saisie ainsi qu’une interface simple et conviviale sont nécessaires à leur appropriation de l’outil. Les arguments de promotion sont la visibilité offerte aux chercheurs et la valeur ajoutée par la centralisation des ressources et la recherche fédérée pour le public. Dans l’environnement actuel, les chercheurs attendent une recherche aisée et efficace, et nous nous devons de leur permettre d’être autonomes en leur offrant des interfaces simples où ils peuvent être autonomes dans leur dépôt d’une part, et obtenir des contenus directement utilisables d’autre part. Il s’agit de mettre à leur disposition non seulement un support technique, organisationnel et institutionnel, mais aussi de leur prodiguer information et formation ainsi que différents services associés à valeur ajoutée : saisie facilitée des références, réutilisation aisée des données, création automatique de listes bibliographiques, interopérabilité avec d’autres systèmes et analyse de l’impact. Infoscience (65) ou l’Archive ouverte de l’Université de Genève (66) proposent ainsi à leurs chercheurs une rubrique d’information sur l’Open Access, une aide au dépôt ainsi que des services à valeur ajoutée tels que l’extraction de listes bibliographiques re-exploitables, des flux RSS personnalisés, etc. L’étude menée par Driver (67) relève l’importance de ces services à valeur ajoutée dans le succès des dépôts observés.

L’effort de « marketing » est aussi important vis-à-vis du large public d’Internet. Il y a donc un vrai travail de référencement et de communication dans différents médias pour toucher le maximum de public. Exposer soi-même ses métadonnées pour se rendre moissonnable à un plus haut niveau est une suite logique au moissonnage des dépôts institutionnels. Il est important que les dépôts moissonnés par de plus grands portails reçoivent un feedback quant à leur interopérabilité et à la qualité des métadonnées qu’ils exposent. Collaborer dans des projets d’ampleur internationale leur permet aussi de gagner en visibilité. Des projets pionniers tels que Driver se veulent multidisciplinaires et collaborent volontiers notamment en partageant leur savoir-faire (68).

5. CONCLUSION

Inscrite dans le cadre du projet de portail Info-Net Economy, dont le cœur sera constitué d’un dépôt de métadonnées OAI-PMH, la présente étude met en évidence les bonnes pratiques à observer lors de la création de portails centralisateurs de ressources. De tels portails sont aujourd’hui nécessaires à la recherche, car les sources sont dispersées et peu valorisées. Le contenu de ces portails étant notamment puisé dans des dépôts institutionnels d’archives ouvertes, nous nous devions d’en explorer les tenants et les aboutissants.

Premièrement, on observe que le mouvement d’Open Access a enclenché une véritable révolution dans le monde de la publication scientifique qui permet un meilleur échange des savoirs dans les milieux académiques. Le succès des dépôts institutionnels, des dépôts centralisateurs de ressources et des portails thématiques repose en partie sur le mode de fonctionnement adopté et l’équipe de professionnels en charge du projet. Il reste cependant encore un gros travail d’information à effectuer auprès des universités pour sensibiliser les directions et les chercheurs. Communiquer et informer sur les enjeux liés aux dépôts institutionnels est donc la première bonne pratique à retenir. Ce rôle peut parfaitement être endossé par les bibliothèques ; cela représente même une véritable opportunité dans l’environnement évolutif de l’information scientifique. Aider les instituts et leurs chercheurs à valoriser leur travail sur le web est une nouvelle mission des bibliothèques académiques. Pour cela elles peuvent s’organiser en partenariats pour échanger les compétences et constituer des réseaux collaboratifs. Au niveau des universités, les bibliothécaires peuvent mettre à profit leurs compétences documentaires dans la création de dépôts institutionnels (comme dans le cas d’Infoscience à l’EPFL) ou proposer aux chercheurs de déposer leurs publications dans un dépôt centralisateur (tel que RERO-DOC en Suisse romande). Une fois le système de dépôt mis en place, la participation à des portails thématiques tels que Driver est souhaitable car elle augmente la visibilité potentielle des institutions productrices.

Puis, en termes de contenu, la bonne pratique à observer est l’établissement d’une politique claire qui définit ce qui entre dans le cadre du dépôt ou du portail. Techniquement, la centralisation des ressources provenant de différents dépôts est rendue possible par la norme OAI-PMH, elle-même basée sur la norme de description Dublin Core. Le moissonnage des métadonnées permet d’offrir ensuite une recherche fédérée sur tous les dépôts exposés. Ce procédé permet de rendre plus visible des dépôts peu connus, par exemple sur un portail thématique tel qu’Info-Net Economy, qui regroupera les ressources de différents acteurs suisses qui publient de l’information scientifique dans le domaine de l’économie. Appliquer les normes et les outils permettant l’harmonisation et l’échange des métadonnées est la troisième bonne pratique à observer.

Enfin, pour faire l’unanimité, les dépôts et les portails qui les moissonnent se doivent de mettre tous les atouts de leur côté en offrant des interfaces ergonomiques et riches en fonctionnalités à valeur ajoutée. Offrir un cadre de recherche convivial et des services à valeur ajoutée en profitant d’outils novateurs est la quatrième bonne pratique mise en évidence.

En conclusion, on peut souligner l’importance des protocoles et normes d’échanges des données, mais aussi relever que l’organisation et la communication liées aux projets sont tout aussi cruciales pour leur réussite. Réussite que l’on peine encore à mesurer, par manque d’indicateurs éprouvés (69). Si la démocratisation de l’Open Access et le nombre croissant de projets qui voient le jour est un succès en soi, ils doivent être poursuivis et enrichis selon des critères de qualité reconnus dans le milieu de l’information documentaire et de la recherche académique.

6. Notes

(1) Info-Net Economy [en ligne]. http://www.e-lib.ch/net_economy_f.html

(2) La bibliothèque électronique suisse, portail pour la communauté scientifique nationale qui proposera un accès centralisé à une vaste offre d'informations scientifiques et de services de bibliothèques dans un point d'accès unique.

E-lib [en ligne]. http://www.e-lib.ch/index_f.html

(3) ARESO : annuaire de ressources économiques de Suisse occidentale créé par la filière Information documentaire de la Haute Ecole de Gestion de Genève en 2008.

ARESO [en ligne]. http://campus.hesge.ch/areso/

(4) Définition de l’association des bibliothèques canadiennes de recherche, ABCR

(5) Voir à ce sujet le dossier proposé par l’Université de Genève : http://www.unige.ch/biblio/chercher/openaccess/brochure.pdf

(6) Pour plus d’informations et une bibliographie complète sur le sujet des publications en Open Access, voir le site de Charles W. Bailey Jr : http://www.digital-scholarship.org/

(7) Bosc, Hélène. Archives ouvertes : 15 ans d’histoire. Les archives ouvertes : enjeux et pratiques. Paris, ADBS, 2005. pp. 27-54.

(8) Infoscience [en ligne]. http://infoscience.epfl.ch/

(9) Ce classement a pour but de soutenir les projets d’archives ouvertes en les évaluant selon leur visibilité et leur impact. Ranking web of world repositories [en ligne]. http://repositories.webometrics.info/

(10) Forschungsplattform Alexandria [en ligne]. http://www.alexandria.unisg.ch/

(11) RERO-DOC[en ligne]. http://doc.rero.ch/?ln=fr

(12) Driver [en ligne]. http://www.driver-repository.eu/

(13) Econbiz [en ligne]. http://www.econbiz.de/

(14) Economists online [en ligne]. http://www.nereus4economics.info/

(15) Muriel Foulonneau, Réseaux d’archives institutionnelles en Europe : logiques de développement et convergences, Archive Ouverte en Sciences de l'Information et de la Communication [en ligne], 2007, http://archivesic.ccsd.cnrs.fr/sic_00205049/en/

(16) Repec [en ligne]. http://repec.org/

(17) E-LIS [en ligne]. http://eprints.rclis.org/

(18) HAL [en ligne]. http://hal.archives-ouvertes.fr/

(19) Lynch, Clifford A., Lippincott, Joan K., Institutional Repository Deployment in the United States as of Early 2005. D-Lib Magazine [en ligne], vol. 11, no 9, 2005. http://www.dlib.org/dlib/september05/lynch/09lynch.html

(20) Op. cit.

(21) Andre, Francis, Charnay, Daniel, Support of Open Archives at National Level : the HAL experience, Institutional archives for research : experiences and programs in open access [en ligne], Rome 30 November – 1 December 2006, http://archivesic.ccsd.cnrs.fr/docs/00/18/72/60/PDF/Rome_ISS_FANDRE.pdf

(22) Ibid.

(23) Chen, Kuang-hua, The unique approach to institutional repository. The electronic library [en ligne], vol. 27, no 2, 2009, pp. 204-221,

http://www.emeraldinsight.com/Insight/viewPDF.jsp?contentType=Article&Filename=html/Output/Published/EmeraldFullTextArticle/Pdf/2630270201.pdf

(24) Pfister, Joachim, Weinhold, Thomas, Zimmermann, Hans-Dieter. Open Access in der Schweiz : status quo und geplanter Aktivitäten im Bereich von Institutional Repositories bei Hochschul- und Foschungs-einrichtungen in der Schweiz. In Information : Droge, Ware oder Commons ? : Wertschöpfungs – und Transformationsprocesse auf den Informationsmärkten [en ligne]. Boizenburg : Werner Hülsbusch, 2009. Pp. 259-270

(25) Op. cit.

(26) Vezina, Kumiko. Dépôts institutionnels : principaux enjeux [en ligne]. 38ème congrès annuel – perspectives d’avenir : fonctions, réseaux et relations, Corporation des bibliothécaires professionnels du Québec, mai 2007

http://www.cbpq.qc.ca/congres/congres2007/Actes/Vezina.pdf

(27) Blin, Frédéric, Les bibliothèques académiques européennes : Brève synthèse prospective, BBF [en ligne], t. 53, no 1, 2008, pp. 12-18, http://bbf.enssib.fr/consulter/bbf-2008-01-0012-002

(28) Ibid.

(29) Jones, Catherine. Institutional repositories: content and culture in an Open Access environment. Oxford : Chandos Publishing, 2007.

(30) The research library’s role in digital repository services [en ligne], Association of research libraries, 2009, http://www.arl.org/bm~doc/repository-services-report.pdf

(31) Salo, Dorothea. Innkeeper at the roach motel. Library Trends [en ligne], vol. 57. No 2, 2008. http://minds.wisconsin.edu/handle/1793/22088

(32) University of Nottingham (UK). OpenDOAR : the Directory of Open Access Repositories [en ligne].

http://www.opendoar.org/

(33) SHERPA [en ligne]. http://www.sherpa.ac.uk/index.html

(34) SHERPA-RoMEO [en ligne]. http://www.sherpa.ac.uk/romeo/

(35) Harnad, Steven, Brody, Tim. Comparing the Impact of Open Access (OA) vs. Non-OA Articles in the Same Journals. D-Lib Magazine [en ligne], vol. 10, no 6, 2004. http://www.dlib.org/dlib/june04/harnad/06harnad.html

(36) Op. cit.

(37) Op. cit.

(38) Op. cit.

(39) Archives Ouvertes UNIGE [en ligne]. http://www.unige.ch/biblio/chercher/archiveouverte.html

(40) Op. cit.

(41) Op. cit.

(42) INSPIRE [en ligne]. http://www.projecthepinspire.net/

(43) Brooks, Travis. Giving researchers what they want: SPIRES, high energy physics and subject repositories. Genève, OAI6, juin 2009.

http://indico.cern.ch/getFile.py/access?contribId=20&sessionId=6&resId=1&materialId=slides&confId=48321

(44) Op. cit.

(45) Registry of Open Access Repositories (ROAR) [en ligne]. http://roar.eprints.org/index.php

(46) Dspace [en ligne]. http://www.dspace.org/

(47) Eprints [en ligne]. http://www.eprints.org/

(48) CDS-Ware/Invenio [en ligne]. http://cdsware.cern.ch/invenio/index.html

(49) Jones, Catherine. Institutional repositories: content and culture in an Open Access environment. Oxford : Chandos Publishing, 2007.

(50) François Nawrocki, Le protocole OAI et ses usages en bibliothèque [en ligne], Paris, Ministère de la culture et de la communication, 2005. http://www.culture.gouv.fr/culture/dll/OAI-PMH.htm

(51) RODIN [en ligne]. http://www.e-lib.ch/rodin_f.html

(52) François Nawrocki, op. cit.

(53) OAIster [en ligne]. http://www.oaister.org/

(54) Citebase search [en ligne]. http://www.citebase.org/

(55) OAI Harvester 2 [en ligne]. http://www.oclc.org/research/Software/oai/harvester2.htm

(56) Open archive harvester [en ligne]. http://pkp.sfu.ca/?q=harvester

(57) Sévigny, Martin, Pichot, Malo. SDX et la moisson OAI [en ligne]. Paris, Ministère de la culture et de la communication, 2005. http://www.nongnu.org/sdx/docs/html/doc-sdx2/fr/oai/moissonneur.html

(58) Google scholar [en ligne]. http://scholar.google.com/intl/fr/scholar/about.html

(59) Boutros, Nader. Moissonnage des données : exposée général sur les principes. Carrefour des acteurs de l’édition en archéologie, 1er décembre 2005.

(60) MARC Standards [en ligne]. http://www.loc.gov/marc/

(61) Jones, Catherine. Institutional repositories: content and culture in an Open Access environment. Oxford : Chandos Publishing, 2007.

(62) OAI-ORE [en ligne]. http://www.openarchives.org/ore/

(63) Op. cit.

(64) Feijen, Martin, et al. DRIVER : building the network for accessing digital repositories across Europe [en ligne]. Ariadne. Issue 53, October 2007. http://www.ariadne.ac.uk/issue53/feijen-et-al/

(65) Op. cit.

(66) Op. cit.

(67) A DRIVER's Guide to European Repositories : Five studies of important Digital Repository related issues and good Practices [en ligne], 2007, University of Amsterdam, http://dare.uva.nl/aup/nl/record/260224

(68) Driver support website [en ligne]. http://www.driver-support.eu/index.html

(69) Bosc, Hélène, Archives Ouvertes : quinze ans d’histoire, In Les Archives Ouvertes : enjeux et pratiques. Guide à l’usage des professionnels de l’information [en ligne], C. Aubry, J. Janik (eds.), Paris : ADBS, 2005. pp 27-54 http://cogprints.org/4408/2/Ouvragearchive.htm

Institutionelle und zentrale Archive: existierende Praktiken und Best Practices

Ressi — 31 décembre 2009

Lorraine Filippozzi, Haute Ecole de Gestion, Genève

Zusammenfassung

Das Projekt Info-Net Economy, zukünftiges Themenportal für den Bereich Wirtschaftswissenschaften der Elektronischen Bibliothek Schweiz E-lib, soll durch diese Studie eine solide Dokumentationsgrundlage erhalten. Nach einem Bedarfsnachweis zentraler Portale und einer Diskussion der damit verbundenen Möglichkeiten für Informationsfachleute werden die organisatorischen, technischen und marketingbezogenen Aspekte vergleichbarer Projekte untersucht und Best Practices aufgezeigt, die für eine Umsetzung zu berücksichtigen sind.

Institutionelle und zentrale Archive: existierende Praktiken und Best Practices

Diese Studie ist Teil der ersten Phase des Projekts Info-Net Economy (1), zukünftiges Themenportal für den Bereich Wirtschaftswissenschaften der Elektronischen Bibliothek Schweiz E-lib (2). Das Portal wird einen Zugang zu elektronischen Publikationen bieten, die aus den institutionellen Beständen eines Netzwerks öffentlicher und akademischer Partner stammen. Die Studie gibt eine Übersicht über die Best Practices als institutionelles Archiv und zentrales Ressourcenportal zu einem bestimmten Thema. Die Literatur zu zentralen Portalen und institutionellen Archiven wurde eingehend analysiert und mit einer Untersuchung ähnlicher Projekte ergänzt. Die resultierenden Best Practices betreffen insbesondere drei Aspekte: Projekt-Organisation, -Technologie und -Kommunikation. Bevor jedoch detaillierter darauf eingegangen wird, muss zunächst der Kontext genauer beschrieben und eine Definition des Begriffs Open Access geliefert werden.

1. Kontext der Studie: Info-Net Economy

Info-Net Economy bietet als Teil des Projekts E-lib einen Zugang im Sinn eines „Single Point of Access“ zu digitalen wirtschaftswissenschaftlichen Veröffentlichungen der gesamten Schweiz und wertet die wirtschaftlichen Ressourcen der Schweizer Institutionen damit auf. Der Austausch zwischen Institutionen, die wirtschaftswissenschaftliche Informationen veröffentlichen, wird gefördert. Das Portal wird die folgenden Elemente umfassen: ein Verzeichnis der verschiedenen Akteure, die wirtschaftswissenschaftliche Studien/Informationen hervorbringen (Hochschulen, spezialisierte Institute, spezialisierte Ämter usw.); ein Verzeichnis elektronischer Publikationen einiger interessierten Partnerorganisationen (11 Partner bis Oktober 2009); ein allgemeinerer Zugang zur Gesamtheit der nützlichen wirtschaftswissenschaftlichen Informationen (Erweiterung der Liste durch Quellen aus ARESO (3)); eine Plattform, über welche die im Bereich aktiven Informationsfachleute Dokumentationsprodukte und Best Practices austauschen können.

Die Zentralisierung dieser Informationen auf einem Portal soll ein Problem beheben, das sich gegenwärtig bei der Suche nach validierten wirtschaftswissenschaftlichen Informationen stellt: Die Ressourcen befinden sich verteilt auf den Websites der verschiedenen Institutionen; um auf sie zuzugreifen, muss man die verschiedenen Akteure kennen. Auch wenn manche Websites die Ressourcen eigens auflisten, beschränkt sich dies üblicherweise auf den universitären Bereich, und Ressourcen aus anderen Institutionen bleiben aussen vor. Zudem können die Partner mit grossen Vorteilen rechnen: Ihre Publikationen werden aufgewertet, durch den Austausch mit den Partnern im Netzwerk lernen sie neue Informationsquellen und Werkzeuge kennen und der Dokumentationsdienst sowie die gesamte Institution erhalten eine grössere öffentliche Sichtbarkeit. Das Partnernetzwerk von Info-Net Economy vereint spezialisierte Ämter, Universitätsinstitute, Fachhochschulen und Dachverbände, die im Bereich der Wirtschaftswissenschaften in der Schweiz publizieren und Informationsfachleute beschäftigen. Hauptaufgabe des Projekts ist in der Tat die Zentralisierung und Verbreitung von Publikationen für Informationsfachleute innerhalb ihrer Institution, aber auch auf einer umfassenderen Ebene. Diese Möglichkeiten könnten sogar ein zukunftsträchtiger Weg für den Berufszweig sein.

Im Hinblick auf die Gestaltung dieses auf den Bereich Wirtschaftswissenschaften spezialisierten Portals und parallel zur Erfassungsphase der Publikationen sowie der Akteure, welche während der ersten Projektphase vorgesehen ist, erscheint eine Analyse einiger institutioneller Forschungsrepositorien unerlässlich. Was muss bei der Schaffung eines solchen Portals berücksichtigt werden?

Der Aufbau eines Portals für den Zugang zu wirtschaftswissenschaftlichen Publikationen aus unserem Partnernetzwerk stützt sich auf die Archive der Partner. Ein institutionelles Archiv (oder Repositorium, institutional repository) ist eine digitale Sammlung der geistigen Produktion einer Universität oder einer Institution, in der das von der Institution generierte Wissen zentralisiert, erhalten und verfügbar gemacht wird (4). Diese Repositorien sind durch das Prinzip der offenen Archive entstanden. Nach Auffassung der Schweizer Universitäten und Fachhochschulen sollen dabei wissenschaftliche Informationen auf einem institutionellen Server oder in einer nach dem Modell Open Access (OA)(5) funktionierenden Zeitschrift bereitgestellt werden. Die Nutzer haben so einen direkten und kostenlosen Online-Zugriff auf die Forschungsartikel: Sie können sie unbeschränkt lesen, herunterladen, kopieren und verlinken, müssen jedoch stets die Quelle angeben. Dieses Prinzip hat sowohl für die Wissenschaftler als auch für die Nutzer zahlreiche Vorteile: schnelle Veröffentlichung, Wahrung des Urheberrechts, kostenloser und grenzenloser Zugang usw. (6)

Im Folgenden werden verschiedene ähnliche Projekte aufgelistet, die als Modell dienen. Dabei geht es um eine Auswahl von institutionellen Archiven, zentralen Archiven (7) und Themenportalen, die wegen ihrer geografischen Nähe, Beispielhaftigkeit und Originalität ausgewählt wurden.

| Institutionelle Archive | Infoscience (8) Angelegt als institutionelles Archiv im eigentlichen Sinne, zentralisiert und erhält Infoscience die wissenschaftliche Produktion der ETHL. Infoscience gilt gemäss dem Ranking of world repositories (9) weltweit als Referenz für institutionelle Archive und steht an siebter Stelle. |

Forschungsplattform Alexandria (10) Die Plattform Alexandria dient als Schaufenster für die Forschung der Universität St. Gallen und soll nicht nur die Ergebnisse der an der Institution tätigen Forschung publik machen, sondern auch die einzelnen Forschungsinstitute, Forschenden (persönliche Profile) und laufenden Projekte vorstellen. Alexandria ist kein institutionelles Archiv im engeren Sinn, da die Archivierungsperspektive fehlt. Dennoch wird die Plattform im erwähnten Ranking an achter Stelle geführt. |

|---|---|---|

| Zentrale Archive | RERO DOC(11) RERO-DOC ist die digitale Bibliothek des Westschweizer Bibliothekenverbundes RERO (Réseau des bibliothèques de Suisse occidentale). Sie wurde im Rahmen der Einführung offener Archive geschaffen und bietet den Forschenden der Universitäten und anderen teilnehmenden Institutionen eine Plattform zur Archivierung ihrer wissenschaftlichen Literatur. Es handelt sich also um ein zentrales Archiv für die Publikationen zahlreicher Schweizer Institutionen, die über kein eigenes institutionelles Archiv verfügen. |

Driver (12) Driver umfasst als frei zugängliches multidisziplinäres Portal für die europäische Forschung die Verzeichnisse von offenen Archiven in Europa. 13 Partner aus ganz Europa sind an diesem paneuropäischen Portal für einen freien Zugang zu wissenschaftlichen Publikationen beteiligt, in dem bis heute mehr als 200 institutionelle und thematische Archive verzeichnet sind, so z.B. die französische Plattform offener Archive HAL (Hyper-articles en ligne). Gegenwärtig sind in Driver hauptsächlich Fachgebiete wie Biologie, Anthropologie und Informatik vertreten, wobei der Zugang zu den Ressourcen nach geografischer Region aufgeteilt ist. |

| Themenportale | Econbiz (13) Die Virtuelle Fachbibliothek Wirtschaftswissen-schaften wurde als Themenportal angelegt und ist eine Zusammenarbeit zwischen der Deutschen Zentralbibliothek für Wirtschaftswissenschaften (ZBW) und der Universitäts- und Stadtbibliothek Köln (USB Köln). Sie umfasst Internetquellen, eine Metasuchmaschine für allgemeine Bibliotheks-kataloge, ein Linkverzeichnis zu Volltextdaten-banken, einen internationalen wissenschaftlichen Veranstaltungskalender und Informationsdienst-leistungen. |

Economists online (14) Die Networked Economics Resources for European Scholars (NEREUS) sind ein Konsortium europäischer Universitätsbibliotheken, die über grössere Bestände in Wirtschaftswissenschaften verfügen. Gemeinsam bieten sie neue Inhalte und entwickeln neuartige Informationsdienste für Wirtschaftswissenschaftler. Ziel ist Schaffung und Ausbau eines europäischen Netzwerks von Forschungsbibliotheken, das die Ressourcen, welche aus der universitären Forschung in Europa stammen, miteinander verbindet. Der wichtigste Dienst von NEREUS ist Economists Online, ein Onlinezugang zu den Veröffentlichungen der bedeutendsten universitären Wirtschafts-wissenschaftler. Die gesamte Produktion der Wirtschaftler wird digitalisiert, strukturiert, archiviert und zugänglich gemacht, so dass möglichst viele Dokumente im Volltext einsehbar sind. |

Jede dieser Quellen wurde nach demselben Raster analysiert: Kontext der Entstehung, Ziele, Organisationsstruktur, allgemeine technische Struktur, Inhalt (Arten von Publikationen), Funktionen (einschliesslich Web 2.0), Schnittstelle, Benutzerfreundlichkeit, Suchmaschine, mögliche Sucharten, Mehrsprachigkeit, Design, Erfassung und Qualität der Metadaten, öffentliche Kommunikation und sonstige gute Eigenschaften. Die Schlussfolgerungen wurden in drei Teile aufgeteilt: Kontext und Organisation, Technologien und Inhalte sowie Kommunikation.

2. Kontext und Organisation

Sowohl bei institutionellen Archiven als auch bei zentralen Ressourcenportalen ist die Organisationsstruktur ein wichtiger Faktor, der über Erfolg oder Misserfolg entscheiden kann. Es ist wichtig, die folgenden Aspekte näher zu beleuchten, um je nach Kontext eine geeignete Wahl zu treffen: Organisationsstruktur, Art der Partnerschaften, Niveau der Zusammenarbeit und Rolle der Fachleute aus dem Bereich Information und Dokumentation in derartigen Projekten.

Organisationsstruktur

Beim Zusammenschluss institutioneller Archive wird allgemein die Organisationsstruktur eines Netzwerks gewählt (Econbiz, Driver, Economists online). Um einen anfänglichen Kern werden 2-10 Partnerschaften eingegangen, welche die Fortdauer des Projekts gewährleisten. Wenn das Netzwerk sogar zu einem Kompetenzzentrum wird, können die versammelten Experten den Archivverwaltern manchmal auch Dienste anbieten. Die institutionellen Archive sind als nationale oder internationale Netzwerke strukturiert und sollen Kompetenzen verfügbar machen, aber auch Werkzeuge und gemeinsame Dienste bereitstellen (15).

Typen offener Archive

Es wird zwischen verschiedenen Typen offener Archive unterschieden: Entweder sie sind institutionell (an eine wissenschaftlich tätige Institution, z.B. eine Universität gebunden), zentral (an mehrere produzierenden Institutionen gebunden, wie z.B. RERO-DOC, das mehreren Universitäten und Hochschulen als Archiv dient), multidisziplinär (sie decken mehrere Wissensgebiete ab) oder thematisch (auf ein Fachgebiet konzentriert, wie etwa auf die Wirtschaftswissenschaften bei Repec (Research Papers in Economics) (16) oder auf die Informations- und Bibliothekswissenschaften bei E-LIS (17). Der Impuls zur Schaffung solcher offener institutioneller, zentraler oder thematischer Archive kommt meist aus dem universitären Bereich. Aber es finden sich auch Forschungsinstitute wie das französische Centre national de la recherche scientifique (CNRS), welches das multidisziplinäre Archiv HAL (Hyper Articles on Line) (18) ins Leben rief und ebenfalls Interesse hat, die Arbeiten seiner Forschenden publik zu machen. Die Vielzahl solcher Projekte zeigt, wie sehr die verschiedenen Wissenschaftsgemeinden daran interessiert sind, offene Archive zu schaffen und auf zentralen Portalen präsent zu sein, damit sie gemeinsam die wissenschaftliche Literatur aufwerten können.

Niveau der Zusammenarbeit

Wie kann eine solche Zusammenarbeit jedoch auf lange Frist gesichert werden? Wir baut man ein echtes Kompetenzzentrum auf? Bei der Betrachtung ähnlicher Projekte stellt man fest, dass es nötig ist, dass die Partner im Netzwerk von ihrer Führungsebene unterstützt werden: Die jeweilige Institutionsleitung muss für das Prinzip der offenen Archive gewonnen werden. Dabei fällt den Informationsfachleuten eine wichtige Rolle zu. Um die Vorgesetzten zu überzeugen, können sie sich auf einige Zahlen zum Open Access und den institutionellen Archiven stützen. In den Vereinigten Staaten haben über 90% der Universitäten ein System mit einem institutionellen Archiv bereits eingerichtet oder befinden sich in der Evaluierungsphase (19). Eine Unterstützung für die Bewegung der offenen Archive kann sogar auf nationaler Ebene festgestellt werden, wie etwa im Fall des Archivs HAL (20), das vom CNRS unterstützt wird und an dem sowohl Universitäten als auch öffentlichen Forschungszentren teilnehmen (21). Desgleichen ist Repec (22) durch die gemeinsame Anstrengung in mehr als 60 Ländern entstanden, mit dem Ziel, die Verbreitung wirtschaftswissenschaftlicher Literatur zu fördern. Heute verfügen zwar erst sehr wenige Länder über eine politische Unterstützung für Open Access, aber auf Universitätsebene ist diese gang und gäbe (23). In der Schweiz erfasste die 2009 durchgeführte Studie der Hochschule für Technik und Wirtschaft Chur (HTW) 9 Archive an universitären Hochschulen und 8 weitere Projekte, die bis in zwei Jahren angeschlossen sein werden (24). Das Projekt E-lib wird übrigens mit der Elektronischen Bibliothek Schweiz ein umfassendes nationales Wissenschaftsportal einrichten (25).

Rolle der Fachleute aus dem Bereich Information und Dokumentation

Die Demokratisierung des Prinzips der offenen Archive innerhalb der akademischen Forschungsinstitute stellt für die wissenschaftlichen Bibliotheken eine Chance dar. Indem sie sich an besagten Projekten beteiligen, übernehmen sie eine neue Rolle bei der Aufnahme, Evaluierung und Verbreitung der Forschung (26). Sie können sich zwischen den Forschenden und den Verlagen positionieren, aber auch zwischen der Forschergemeinschaft und dem allgemeinen Publikum. Diese neue Rolle fördert die Nähe zwischen Bibliotheken und Forschenden und ist Teil einer globalen Entwicklung, wodurch ihr Auftrag eine Änderung erfährt (27). Wissenschaftliche Informationen sind ein wichtiges Gut für Universitäts- und Forschungsbibliotheken, da sie nicht nur hinsichtlich ihrer Verbreitung und Erhaltung erhebliche Anforderungen stellen, sondern auch hinsichtlich ihrer Beherrschung durch die Nutzer. Die Schulung der Nutzer wird zu ihrer Hauptaufgabe und in Learning Centers (28) werden Kurse zur Informationskompetenz und zur Beherrschung der Informations- und Kommunikationstechnologien angeboten. Informationsfachleute spielen somit eine strategisch wichtige Rolle bei der Änderung des Benutzerverhaltens und der Veröffentlichungsmodalitäten. Es ist sogar möglich, wenn nicht gar wünschenswert, dass sie in Projekten mit offenen Archiven eine Führungsrolle einnehmen (29).

Dennoch bekunden die Bibliotheken manchmal Schwierigkeiten, die Informatikseite, welche die institutionellen Archive betreibt, und die Forschungsinstitute, die diese mit Inhalten beliefern, aufeinander abzustimmen. Dann müssen die Bibliotheken ihre Kompetenzen bei der Verwaltung digitaler Informationen geltend machen und bei der Erhaltung und Verbreitung einen zentralen Platz einnehmen. Durch ihre Zwischenposition sind sie in der Tat am ehesten in der Lage, Bedarf und Anfragen der Nutzer weiterzuleiten (30). Diese Zusammenarbeit mit den Entwicklern, die einen Überblick über die verschiedenen Systeme vor Ort haben und die Einbindung des Archivs in das aktuelle Informatiksystem gewährleisten, ist einer der Erfolgsfaktoren solcher Projekte (31).

Die politische Unterstützung ist nicht nur wichtig für den Betrieb der Kompetenzzentren, sondern auch für die Verbreitung des Prinzips der offenen Archive. Alle hier untersuchten Projekte können sich auf eine interne Politik stützen, der die Literatursammlung und die Schaffung institutioneller Archive untersteht. Diese Politik bezieht sich meist auf die Berliner Erklärung über den offenen Zugang zu wissenschaftlichem Wissen (2003), in der sich die Unterzeichner unter anderem verpflichten, die Forschenden dazu anzuhalten, ihre Arbeiten nach dem Prinzip des offenen Zugangs zu veröffentlichen, und kulturelle Einrichtungen zu ermutigen, den Zugang zu den Ressourcen über das Internet zu ermöglichen. Seither hat eine wachsende Anzahl akademischer Institutionen ihr eigenes Online-Archiv eingerichtet und die Forschenden dazu verpflichtet, ihre Veröffentlichungen darin frei zugänglich zu machen. Es ist schwierig, die Gesamtheit der offenen Archive weltweit zu erfassen, aber es gibt ein Verzeichnis, in das sich die frei zugänglichen Online-Archive eintragen können (32).

Trotz der Unterstützung der Leitungsorgane im Bereich Forschung bleibt viel zu tun, um die Forscher dafür zu gewinnen und dazu anzuhalten, nach diesem Modell zu veröffentlichen. In einigen Bereichen besteht grosses Misstrauen und Widerstand gegen Änderungen. Dies ist vielleicht auf die Unkenntnis des Prinzips des Open Access sowie auf die Furcht vor einem Qualitäts- und Ansehensverlust zurückzuführen. Die Bibliotheken müssen ihre Nutzer dahingehend informieren, dass ihr Vertrauen gestärkt und auch sichergestellt wird, dass sie sich an den Projekten institutioneller Archive beteiligen. Sie müssen den Forschungsinstituten auch eine technische Unterstützung bieten, damit nicht jeder handelt, wie er allein es für richtig hält, sondern damit die Praxis vereinheitlicht wird. Hierfür können sich die Bibliotheken auf die Arbeiten der Vorreiter institutioneller Archive wie SHERPA (33) stützen, ein Konsortium, das die Schaffung von Archiven in allen Forschungseinrichtungen und höheren Lehranstalten des Vereinigten Königreichs unterstützt. Ein besonders nützlicher Dienst ist Sherpa-RoMEO (Rights MEtadata for Open archiving): Er liefert eine Liste von Veröffentlichungsrechten der Verlage zur Archivierung der Veröffentlichungen durch die Autoren, aus der ersichtlich ist, ob der Verlag die Archivierung der Publikation in einem öffentlichen Archiv gestattet oder nicht (34) und falls ja, welches seine Bedingungen sind (ob z.B. nach der Veröffentlichung eine Embargo-Zeit eingehalten werden muss). Gegenwärtig geben laut Statistiken der Website SHERPA-RoMEO 95 % der Periodika dem Autor das Recht, selber archivieren zu lassen, und es wurde erwiesen, dass diese sogenannte Auto-Archivierung die Sichtbarkeit erhöht und damit die Leserschaft vergrössert(35). Die umfassende Kommunikation und Information über die Vorteile institutioneller Archive sind somit erste Best Practices, die für Projekte mit Open Access zu berücksichtigen sind.

3. Technologie, Inhalte und Funktionen

Sobald der Entscheid für das Projekt gefallen ist, müssen ähnliche Projekte sowie bestehende Werkzeuge und Normen, die einzuhalten sind, untersucht werden, um gewisse technische Entscheide zu fällen insbesondere hinsichtlich Struktur, Inhalte und gewünschter Funktionen.

Technische Struktur

Die technische Struktur von Portalen, die dem geplanten Portal Info-Net Economy ähnlich sind, beruht auf dem Prinzip der Zusammenführung lokal verwalteter institutioneller Archive. Diese Archive, wie Infoscience (36) oder Alexandria (37), bestehen nicht nur aus den Objekten selbst, sondern zusätzlich aus beschreibenden Metadaten. In einer Struktur einer Zusammenlegung von Archiven wie Driver (38) bleiben die Veröffentlichungen der Partnerinstitutionen in ihrem lokalen Depot und das Portal zeigt diese Quellen nur durch Metadaten an, die es gesammelt hat und die durch Verbindungen auf die Veröffentlichungen verweisen. So wird es möglich, die Suche innerhalb der Metadaten der produzierenden Institutionen zu vereinen und ihnen gleichzeitig die Verwaltungsverantwortung sowie das volle Eigentumsrecht zu gewähren.

Inhalte und Funktionen

Diese Portale bieten unterschiedliche Inhalte und Funktionen an. Inhaltlich findet man verschiedene Typen akademischer Veröffentlichungen: in der Mehrheit wissenschaftliche Artikel, Bücher und Kapitel aus Büchern, Studienarbeiten (Master- und Doktorarbeiten, manchmal auch Bachelorarbeiten), aber auch veröffentlichte oder nicht veröffentlichte Arbeiten von Professoren und Forschenden (Vorveröffentlichungen, Working Papers, Konferenz-Papers und -Proceedings usw.) sowie, wie etwa im Fall des Offenen Archivs der Universität Genf (39), Unterrichtsmaterialien (Skripte, Videoaufzeichnungen usw.). Diese akademischen Inhalte werden oft ergänzt durch allgemeinere Veröffentlichungen wie Zeitungsartikel und Medienmitteilungen. In einigen Fällen gibt es keine Begrenzung für den Dokumententyp; so finden sich immer häufiger auch rohe Forschungsdaten und Multimedia-Inhalte. Der Inhalt der Archive wird allgemein in der Absichtserklärung festgelegt; diese ist ein wichtiges Werkzeug, um den Umfang des Archivs zu definieren. Neben den Veröffentlichungen selbst bieten fast alle der untersuchten Websites eine Rubrik „Aktuelles“, die sowohl neue Forschungsprojekte aufführt, als auch auf Neuerscheinungen hinweist. Diese verschiedenen Inhalte werden oft unsortiert präsentiert und erst über die Suchfunktionen können einzelne Inhalte gezielt abgefragt werden. Die Hauptherausforderung liegt hier bei der Ergonomie. Wie können die verschiedenen Inhalte einfach strukturiert werden, damit möglichst intuitiv danach gesucht werden kann? Da unterschiedlichste Bedürfnisse befriedigt sein wollen, müssen die Suchfunktionen sehr umfassend sein. Es muss eine breite Palette von Diensten angeboten werden: vom einfachen Suchfeld bis zu den kombinierten Suchfeldern der erweiterten Suche und hin zur Navigation nach Themen, Dokumententyp und Akteuren, nicht zu vergessen die Optionen zur Einschränkung der Suchergebnisse. Zwei Beispiele stechen durch die Einfachheit der Suche und die gute Nutzung der Suchfilter heraus: Infoscience (ETHL) (40) und Alexandria (Universität St. Gallen) (41). Die Ergonomie der Funktion der Archivierung von Publikationen durch die Forschenden ist allgemein gut, und die Anweisungen sind einfach und klar.

Funktionen vom Typ Web 2.0 sind in den akademischen Forschungsportalen noch wenig vorhanden. In den in dieser Studie untersuchten Projekten ist die Verwendung von RSS-Feeds üblich zur Bekanntmachung von Neuerscheinungen (Alexandria) oder von neuen Publikationen zu einer durchgeführten Suche (Infoscience). Dennoch werden den Nutzern der Portale, Forschende oder allgemeines Publikum, wenige Interaktionsmöglichkeiten geboten. Keines der untersuchten Portale vom akademischen Typ erlaubt den Nutzern, selber Meldungen zu „taggen“ oder Kommentare zu den Ressourcen zu posten. Die semantischen Suchmöglichkeiten sind also beschränkt. Trotzdem plant das Projekt Inspire (42), ein Portal der neuen Generation im Bereich Physik, den Nutzern die Möglichkeit zu bieten, sich am „Tagging“ und den Kommentaren zu den Ressourcen zu beteiligen (43). Anhand dieses Beispiels wird klar, wie gut ein solcher Ansatz funktionieren kann. Interessant ist, dass der Nutzer bei Infoscience nach der Registrierung eine persönliche Datensammlung anlegen oder die Suchmasschine nach seinem besonderen Bedarf anpassen kann. Überdies werden zwar auf allen untersuchten Portalen Online-FAQ (Frequently asked questions) aufgelistet, aber nur Econbiz (44) bietet eine echte Beratung und Kurzauskünfte online an.

Der Entscheid, eine mehrsprachige Seite anzubieten, wirft die Frage nach der Behandlung der Mehrsprachigkeit auf. Dies ist bei einem Schweizer Projekt wie Info-Net Economy besonders wichtig. Es geht darum, eine Schnittstelle, eine Suchmaske und eine Ergebnisanzeige in mehreren Sprachen anzubieten, ohne dass die allgemeine Präsentation der Seite darunter leidet. Die am häufigsten verwendete Lösung besteht darin, die Schnittstelle in mehreren Sprachen und die Metadaten in der Sprache der archivierten Veröffentlichung zu fassen. Zur Verbesserung der Suche können die Schlagwörter gegebenenfalls in mehrere Sprachen übersetzt werden.

Werkzeuge und Normen

Immer noch auf der technischen Ebene ist es ebenfalls wichtig, die verschiedenen Werkzeuge für die Archivierung der Publikationen einerseits und die gemeinsame Suche in verschiedenen Archiven andererseits zu kennen und zu verstehen.

Bei den Archivierungswerkzeugen gehören gemäss dem Registry of Open Access Repositories (45) zu den zwei weltweit am meisten genutzten Programmen Dspace (46) (mehr als 400 Portale) und Eprints (47) (mehr als 300 Portale, darunter die Universität Zürich). CDS-Ware/Invenio (48), das vom CERN entwickelte System, steht auf dem siebten Platz und zählt als Anwender die ETHL und RERO-DOC. Dies sind alles Systeme zur Datenablage.

Damit diese gemeinsame Nutzung von Ressourcen möglich wird, müssen dieselben Normen eingehalten werden. Der bestimmende Faktor für diese Portale ist die Suche, die natürlich auf die Metadaten zugreift, und hier heisst das Motto „Standardisierung“. Man spricht allgemein von OAI-kompatiblen Archiven. Die Open Archive Initiative (OAI) ist eine Bewegung zur Förderung offener Archive und hat eine Reihe von Protokollen und Standards zur Interoperabilität entwickelt, welche die Verbreitung von Dokumenteninhalten erleichtern. Das zentrale Protokoll heisst Open Archive Initiative Protocol for Metadata Harvesting (OAI-PMH), auf Deutsch: Protokoll der Initiative für offene Archive zur Sammlung von Metadaten. In ihm wird ein Standard zur Übertragung gesammelter Metadaten festgelegt. Das OAI-PMH wurde im Rahmen der Open Archives Initiative entwickelt, um die von den Autoren eingereichten Vorveröffentlichungen mit einer interoperablen Basis zu erweitern. Die Open Archives Initiative ist also spezifisch auf die Wissenschaftsgemeinschaft ausgerichtet. Dennoch erweist sich das Protokoll auch für allgemeinere Anwendungen interessant.

Das Protokoll OAI-PMH stützt sich in den Metadaten auf eine Norm zur bibliografischen Beschreibung, den sogenannten nicht qualifizierten Dublin Core: Dies ist ein Schema digitaler Metadaten, mit dem die digitalen Ressourcen beschrieben und Beziehungen mit anderen Ressourcen angezeigt werden können. Es umfasst 15 Elemente formaler (Titel, Urheber, Verlag), intellektueller (Thema, Beschreibung, Sprache) und urheberrechtlicher Natur. Primäre bibliografische Informationen können ins Format Dublin Core umgewandelt werden. Zudem kann Dublin Core leicht als XML kodiert werden.