Publiée une fois par année, la Revue électronique suisse de science de l'information (RESSI) a pour but principal le développement scientifique de cette discipline en Suisse.

Présentation de la revue

Contenu du site

Se connecter

Publié par Ressi

Conférence nationale Open Access

Ressi — 20 décembre 2018

Benoît Epron, Haute école de Gestion, Genève

Conférence nationale Open Access

Le 26 octobre 2018, swissuniversities organisait une conférence nationale Open Access à l'Université de Lausanne.

A l'occasion de la semaine internationale de l'Open Access, cette journée souhaitait proposer un point sur l'Open Access dans un contexte suisse marqué par la mise en place de la stratégie nationale suisse sur l'Open Access et par l'annonce du Plan S (initiative de soutien à l’Open Access porté par la commission européenne et Science Europe).

Au travers des différentes interventions cette journée, qui a rassemblé 300 personnes environ, a permis de dresser un état des lieux des problématiques liées à la dynamique Open Access en Suisse.

Ces problématiques se retrouvent principalement à trois niveaux, académique, économique, politiques, repris par plusieurs intervenants. Nous proposons ici un compte rendu personnel de cette journée, il reflète notre propre lecture des enjeux et informations marquantes et ne prétend pas retranscrire l'intégralité des interventions et des débats.

Le premier plan est un plan académique. Tout au long de la journée ont été abordées deux facettes académiques de l'activité de publication scientifique. La première concerne la problématique de la diffusion et des usages. Souvent oublié, cet aspect des modèles OA de l'édition scientifique a été illustré lors de cette journée par la présentation de Mme Nouria Hernandez, rectrice de l'Université de Lausanne. Ainsi, lors de son intervention elle a évoqué la situation de Serval, dépôt institutionnel de l'Université de Lausanne et dont la fréquentation a quasiment doublé en septembre 2018 pour atteindre 100 000 consultations, notamment à l'occasion de l'intégration de Serval dans Google Scholar. Cette variation illustre par l'exemple un paradoxe des dépôts institutionnels, utilisés d'une part par les institutions universitaires comme infrastructures support pour l'Open Access et l'évaluation des chercheurs et dont d'autre part l'utilisation par les chercheurs eux-mêmes passe largement par Google Scholar, les rendant de fait peu visibles.

Sur le plan académique, la question des indicateurs de la recherche a également été largement abordée avec deux problématiques différentes s'y rattachant.

D'une part la nécessité d'imaginer de nouveaux indicateurs de la production scientifique permettant d'échapper à la dépendance actuelle vis-à-vis des plateformes fournissant actuellement les principaux indicateurs bibliométriques. Cette dépendance est donc double, elle concerne d'une part les indicateurs eux-mêmes qui restent uniquement quantitatifs et placent les revues et les éditeurs au centre des processus d'évaluation et de recrutement. Elle porte également sur les producteurs de ces indicateurs, plateformes d'éditeurs commerciaux qui s'appuient sur la maîtrise d'une part quasi-exhaustive des publications d'un domaine pour produire ces indicateurs.

Cette situation restreint le champ des possibles pour le développement de modèles Open Access pour la publication scientifique en rendant incontournables certaines revues et plateformes.

Sur le plan économique, la dynamique suisse de l'Open Access est confrontée à une situation de transition. Cette transition des modèles de publication académique est déjà bien avancée en Suisse. Ainsi d'après la présentation de Mme Angelina Kalt, Directrice générale du Fonds national suisse de la recherche scientifique, ce sont aujourd'hui 28% des publications scientifiques suisses qui sont disponibles en Green Open Access (auto-archivage de la publication par l’auteur dans une archive ouverte, souvent après une période d’embargo) et 11% disponibles en Gold Open Access (publication directement accessible en Open Access, souvent avec un financement en amont). Cela laisse donc 61% des publications non disponibles en Open Access en Suisse et place la Suisse devant les Pays-Bas, le Royaume-Uni, l'Autriche, la France, l'Allemagne et l'Italie, qui atteignent un taux de publication indisponibles en Open Access compris entre 64% et 72%.

Ce développement fort de l'Open Access en Suisse laisse toutefois une réelle marge de progression pour laquelle le FNS souhaite se positionner comme un levier d'accompagnement des politiques OA, que ce soit pour les revues ou pour les monographies.

L'ambition suisse pour le développement de l'Open Access vise un passage de la totalité des publications en Open Access à l'horizon 2024, soit après l'échéance prévue au niveau de l’Union européenne en 2020.

Du point de vue financier, la présentation de M. Michael Hengartner, Président de swissuniversities et Recteur de l'Université de Zurich, s'appuyait en partie sur l'étude Financial Flows in Swiss Publishing produite en 2016 pour le FNS. Il en a présenté quelques données et notamment le coût total d'accès à l'information en Suisse, soit approximativement 109 millions de francs suisses. Ce montant se répartit de la façon suivante : 70 millions pour les abonnements à des revues, 31 millions pour l'achat de monographies, 6 millions pour les APC (Articles Processing Charges, financement amont par le chercheur ou son institution pour rendre son article disponible en Open Access sans embargo) et 2 millions pour les infrastructures.

Les enjeux financiers relevés dans cette étude rejoignent les interrogations de Mme Nouria Hernandez qui s'inquiète de la capacité des institutions comme la sienne de supporter le triple coût de la publication académique de ses chercheurs aujourd’hui pour lesquels elles doivent assurer à la fois le prix des abonnements, celui des APC et enfin le coût de développement et de maintenance des infrastructures nécessaires à la mise en place des dépôts institutionnels.

A ces coûts il convient enfin d'ajouter les efforts de pédagogie et d'acculturation portés par les institutions scientifiques à destination des chercheurs et qui apparaissent prioritaires dans l'étude annuelle sur l'Open Access réalisée par l'EUA (European University Association). En effet, les trois actions prioritaires d'après cette enquête sont, par ordre d'importance, la sensibilisation des chercheurs, la mise en place d'incitations supplémentaires à destination des chercheurs et enfin la mise en place de politiques nationales de soutien à l'Open Access.

Cette enquête européenne présentée par M. Jean-Pierre Finance, Président de l'Open Science Experts Group, au sein de European University Association, a permis d'apporter d'autres éléments financiers à la réflexion. En effet, l'enquête chiffre à plus de 421 millions d'euros les dépenses annuelles pour les périodiques, les bases de données et les livres numériques, dont plus de 383 millions d'euros pour les seuls périodiques.

Plusieurs intervenants ont enfin balayé plusieurs enjeux politiques relatifs à l'Open Access. Le premier de ces enjeux a été la nécessité d'une organisation cohérente et unifiée des différents acteurs. C'est dans cette logique que devrait se mettre en place d'ici le premier trimestre 2019 une Open Access Alliance pilotée par swissuniversities (programme P-5) et regroupant l'ensemble des parties prenantes : Académies, éditeurs suisses, CSS (Conseil suisse de la science), etc. mais également des membres de projets comme Sliner, le FNS ou la délégation recherche de swissuniversities.

La place des HES dans les modèles Open Access a également été soulignée avec notamment la nécessité de concevoir des solutions qui permettent de prendre en compte les partenaires économiques impliqués dans l'activité de recherche appliquée des HES et pour lesquels l'ouverture des résultats doit se construire de façon cohérente avec leurs enjeux économiques et commerciaux.

La journée s'est terminée sur une intervention rafraichissante de M. Jacques Dubochet, prix Nobel de Chimie en 2017, qui a replacé, à travers son expérience de chercheur, "la connaissance comme un bien commun pour le bénéfice de tous".

- Vous devez vous connecter pour poster des commentaires

Cinquante ans de numérique en bibliothèque

Ressi — 20 décembre 2018

Alexis Rivier, Conservateur Ressources numériques et périodiques, BGE

Cinquante ans de numérique en bibliothèque

Dans l’essai d’Yves Desrichard, conservateur des bibliothèques et ancien rédacteur en chef du Bulletin des bibliothèques de France, les professionnels actifs depuis une vingtaine d’années ou davantage reconnaîtront des personnes, des sigles, des événements politiques qui ont façonné le destin numérique des bibliothèques françaises.

En France, l’histoire est une discipline prestigieuse et valorisée. Nombre d’historiens ont occupé de hautes fonctions à la Bibliothèque nationale, comme Jean-Noël Jeanneney, président de la BnF de 2002 et 2007 et préfacier de l’ouvrage. Pour autant le parcours rétrospectif sur ce facteur fondamental de transformation des bibliothèques qu’a représenté l’arrivée de l’informatique a été plutôt négligé, ou cantonné à l’intérieur d’ouvrages au périmètre plus large .

Cinquante ans de numérique en bibliothèque s’articule en cinq « temps », couvrant chacun approximativement une décennie. Suivre les faits et les avancées dans ce continuum chronologique s’avère efficace et très parlant.

Le premier temps est celui des pionniers, qui mettent au point les premiers formats de catalogage. Peu après, les premières politiques d’ «automatisation» des bibliothèques voient le jour.

S’ensuit le temps des découvreurs qui consolident les acquis, développent les fonctionnalités et s’emparent de technologies qui semblaient prometteuses : Minitel, CD-Rom, vidéodisque.

Le temps des bâtisseurs concrétise les chantiers d’informatisation de la BnF, la rétroconversion des catalogues, les réseaux informatisés.

Le temps des expérimentateurs suggère une nouvelle étape de tâtonnements. La montée en puissance des ressources numériques entraîne des stratégies de rassemblement autour des consortiums, puis une mobilisation en faveur de l’open access. Des services d’Internet affichent une croissance surprenante, les bibliothèques s’y adaptent : Web 2.0, archivage du numérique, grands programmes de numérisation.

Le dernier temps appartient aux médiateurs : la mise en concurrence des bibliothèques les oblige à repenser leurs fondamentaux, principalement dans la mise en relation des usagers avec des sources et des contenus d’information. Un certain renversement de perspective s’opère : l’usager devient prioritaire et non plus la collection, dont le statut doit être revisité. On ne peut s’empêcher de voir dans ce titre un hommage au dernier opus d’un grand nom de la bibliothéconomie française, disparu prématurément : Les bibliothèques et la médiation des connaissances de Bertrand Calenge.

Chaque partie relate de façon très complète les initiatives, les structures institutionnelles et les personnages qui ont forgé cette histoire, générant une floraison de sigles dont peu ont subsisté jusqu’à nos jours. La concision du livre (132 pages) en fait une excellente synthèse. Non sans modestie, Yves Desrichard estime cependant qu’une histoire complète de l’informatisation des bibliothèques reste à écrire…

Une fois posé à gros traits les étapes, quels sont les principaux enseignements de cette rétrospective ? Nous en proposons quelques-uns.

-

A ses débuts, l’informatisation des bibliothèques apparaît presque simultanément dans les pays développés. Mais l’avance des Etats-Unis est réelle. C’est à la Bibliothèque du Congrès que le format Marc, pierre angulaire de l’informatique en bibliothèque, a été défini en 1966. Le prétendu retard français est cependant minime : cette même année, Henri-Jean Martin travaille à la Bibliothèque municipale de Lyon sur un format de catalogage pour le livre ancien et en 1968 Marc Chauveinc conçoit le format Monocle à Grenoble. C’est également dans ces années-là que l’aventure commence en Grande-Bretagne , mais aussi en Suisse avec les projets Sibil à Lausanne et Ethics à Zurich. Il y a là une remarquable convergence, tant il apparut très tôt que l’informatique était un outil essentiel pour les bibliothèques.

-

On s’en doute, l’informatisation n’est pas une route paisible. Les réussites y côtoient les échecs. Ce n’est pas le moindre mérite de ce livre d’y faire place. Certaines idées viennent trop tôt, d’autres fois la réalisation est laborieuse. Enfin certaines technologies n’ont pas été confirmées. Parfois les bibliothèques sont confrontées à des temporalités qui les dépassent, le volontarisme ne suffit pas toujours. "Ceux qui ont réussi ne savaient pas qu'ils allaient réussir; ceux qui ont échoué ne savaient pas qu'ils allaient échouer." (p. 11). Deux cas sont symptomatiques. Le système centralisé Libra, voulu et conçu par le Ministère de la culture entre 1982 et 1989 pour combler le retard des bibliothèques centrales de prêt n’a jamais fonctionné correctement, et les lois de décentralisation ont précipité son abandon. Le projet d’informatisation de la BnF, aussi ambitieux dans son genre que celui de la construction du nouveau bâtiment sur le site de Tolbiac, a été émaillé de difficultés qui ont beaucoup ému la profession. Le système n’a été véritablement opérationnel qu’en 2002, soit 4 ans après les prévisions. Plus récemment le projet Relire, complexe montage technico-juridique au bénéfice d’une noble idée : la remise à disposition du public d’œuvres protégées par le droit d’auteur mais plus commercialisées, n’a pas eu l’effet désiré. Le dispositif a été décrié par les auteurs et invalidé par l’Union européenne.

-

Se pencherait-on sur le passé parce que le présent et surtout le futur inquiètent ? Yves Desrichard se défend de se prêter au jeu de la prophétie, mais sait que l’on attend de lui qu’il dise ce que l’examen du passé lui inspire pour l’avenir des bibliothèques. Le numérique a pris partout une telle place qu’il n’est plus perçu comme aussi désirable qu’au temps des pionniers.

A ses débuts l’informatisation est un facteur de modernisation accueilli avec enthousiasme. C’est un moyen de gérer un « monde physique » qui ne remet aucunement en cause la position de la bibliothèque, ni même son fonctionnement, ses instruments. L’informatique aide d’abord à mettre sur pied des outils de travail comme les catalogues sur fiches ou des bibliographies. Dans les années 1970, le groupe Gibus (Groupe informatiste de bibliothèques universitaires et spécialisées) prône un accès direct par les usagers aux données informatisées, mais c’est bien plus tard que le catalogue sera mis à disposition en ligne via les Opac.

La véritable fracture, et nous suivons l’auteur sur ce point, survient avec le développement de l’information primaire – les contenus – sous forme numérique. Les bibliothèques ont gardé le monopole de l’information imprimée mais ne maîtrisent qu’une petite partie des ressources numériques, celle de la numérisation de leurs fonds. Les ressources sont pour l’essentiel commercialisées et difficiles à acquérir par les bibliothèques. En témoigne la délicate mise en place de la plate-forme Prêt numérique en bibliothèques (PNB) permettant de prêter des ebooks. Malgré tout, cela stimule aussi les capacités d’adaptation des institutions, à l’instar de la création des consortiums Couperin et Carel, respectivement pour les bibliothèques universitaires et pour les bibliothèques de lecture publique. « La profession a toujours été aux avant-postes de l'expérimentation et de l'appropriation des outils informatiques et numériques » (p. 12). Elle a investi Internet avec enthousiasme et continue de le faire, dans la bataille pour l’open access et des contenus gratuits de qualité. Mais le public est capté par d’autres acteurs, puissants et très performants sur le plan des technologies, qui mettent en suspicion l’utilité des bibliothèques, même au niveau politique. J.-N. Jeanneney souligne dans sa préface « l’inquiétude » des professionnels et n’hésite pas à qualifier cette mutation de leur métier comme « la plus violente, en somme, depuis l’invention de l’imprimerie » (p. 10). A cela s’ajoutent des tendances contradictoires qui rendent peu lisibles l’évolution numérique. Le cas le plus typique est celui du livre électronique, dont Desrichard rappelle que « plus de 15 ans après sa première apparition », en 2000, il « continue à provoquer questionnements, enthousiasmes, critiques et incertitudes » (p. 84). C’est donc sur un optimisme prudent qu’il clôt son ouvrage.

Au fil de ce parcours de Cinquante ans de numérique en bibliothèque, on prend la mesure des conditions spécifiques liées au développement informatique de ce secteur en France : influence déterminante de l’Etat central et des ministères concernés, poids de la Bibliothèque nationale, volontarisme technologique. Mais au final, en raison de la globalisation des technologies, la situation des bibliothèques françaises n’est pas si différente de celle d’autres pays. Yves Desrichard a tracé une voie prometteuse.

Bibliographie

Yves Desrichard. Cinquante ans de numérique en bibliothèque. Paris: Electre-Ed. du Cercle de la Librairie, 2017 (collection Bibliothèques)

- Vous devez vous connecter pour poster des commentaires

Les bibliothèques de la Communauté du savoir

Ressi — 20 décembre 2018

Agnès Dervaux-Duquenne, bibliothécaire-responsable, Haute Ecole Arc Ingénierie

Les bibliothèques de la Communauté du savoir

Des solutions simples pour des défis complexes

Un des derniers livres blancs partagés sur le site http://www.archimag.com/ [1] nous propose une étude intitulée « Les défis des bibliothèques universitaires au cœur de l’enseignement, de l’apprentissage et de la recherche » [2].

Notre métier change, c’est une évidence, notre profession évolue, et nous aussi, les professionnel-le-s. Les défis identifiés se posent donc autant au niveau des lieux, des institutions et des objectifs que des ressources, des outils et enfin des compétences des personnels.

C’est une chance dès lors de faire partie d’une des institutions membres de la Communauté du savoir et de bénéficier des encouragements et des infrastructures mises en place pour se rencontrer, partager sur nos pratiques, nos savoir-faire, nos questions et nos solutions et tenter de développer des projets à haute valeur ajoutée avec nos collègues régionaux transfrontaliers.

Mais qu’est-ce que cette Communauté du savoir ?

La Communauté du savoir : historique et composantes

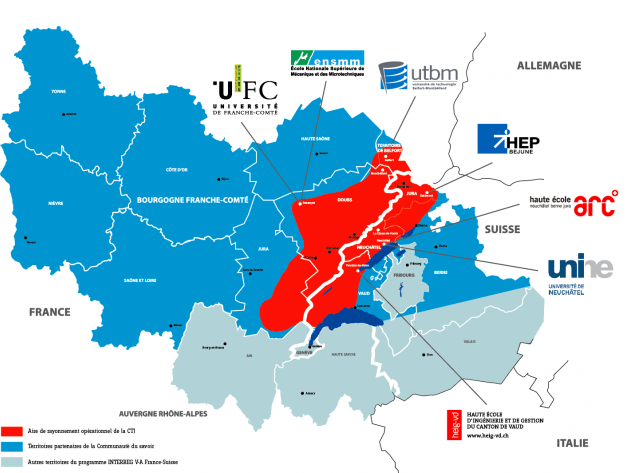

La Communauté du savoir (Cds) est un réseau visant à renforcer, valoriser et stimuler les collaborations franco-suisses dans l'Arc jurassien en matière d'enseignement supérieur, de recherche et d'innovation.

D'abord sous l'égide de la Conférence TransJurassienne, la Communauté du savoir a organisé tous les deux ans (2012, 2014, 2016) un colloque transfrontalier afin de permettre aux acteurs de la collaboration transfrontalière dans les domaines de l'enseignement supérieur, de la recherche et de l'innovation de se rencontrer et d'échanger sur les solutions à apporter aux problématiques inter-régionales générées par les frontières. Les colloques se sont tenus alternativement en France et en Suisse afin de permettre aux participant-e-s de visiter un établissement partenaire.

Le premier colloque de 2012 a été organisé à l'’École Nationale Supérieure de Mécanique et des Microtechniques (Besançon, France) et a réuni une centaine d'acteurs des échanges franco-suisses. Il a donné lieu à la signature d'une déclaration d'intention signée par 17 partenaires présents et a permis de créer les prémices d’une communauté du savoir, de la recherche et de l’innovation de l’Arc jurassien.

Le deuxième colloque de 2014 s’est tenu à la Haute Ecole Arc (Neuchâtel, Suisse) et a réuni environ 150 participant-e-s autour de la thématique : "La collaboration transfrontalière : aller au-delà des outils existants". C’est lors de ce colloque qu’ont été proposées de nouvelles pistes d'actions franco-suisses structurantes dans plusieurs domaines - dont les bibliothèques, et que le nom de cette communauté a été validé par les participant-e-s.

Le troisième colloque de 2016 a eu lieu à l'Atria de Belfort (France) sur le thème "Frontières : dynamique et enjeux d'un territoire transfrontalier", et a permis de mettre en lumière les avantages (également pour les acteurs publics et politiques) liés à la coopération au sein du réseau de la Communauté du savoir. La signature d’un accord-cadre entre sept membres académiques est venue consolider cette volonté de travailler ensemble et de soutenir activement le développement de leurs collaborations.

Les sept membres académiques sont les suivants :

- l’Ecole Nationale Supérieure de Mécanique et des Microtechniques (ENSMM) - Besançon

- la Haute Ecole Arc (HE-Arc) – Neuchâtel

- la Haute Ecole d’Ingénierie et de Gestion du canton de Vaud (HEIG-VD) - Yverdon

- la Haute Ecole Pédagogique des cantons de Berne, Jura et Neuchâtel (HEP-BEJUNE)

- l’Université de Franche-Comté (UFC)

- l’Université de Neuchâtel (UniNE)

- l’Université de Technologie de Belfort-Montbéliard (UTBM)

Inscrite dans un territoire de coopération qui couvre actuellement la Franche-Comté côté français et les cantons de Berne, Jura, Neuchâtel et Vaud côté suisse, la Cds est, par son existence et son développement, un facteur de dépassement de la frontière au profit d’une mise en commun de potentiels scientifiques, académiques, culturels et économiques de l’entier de l’Arc jurassien franco-suisse.

Depuis 2014, ce projet est soutenu par le programme européen de coopération transfrontalière Interreg V France-Suisse 2014-2020 et a bénéficié à ce titre d'un soutien financier du Fonds européen de développement régional (FEDER). Grâce à ces fonds, les premiers objectifs de la Cds ont pu être atteints, à savoir un soutien direct à la mobilité des personnes engagées, à l’organisation d’actions, de journées thématiques, de mises en réseau des structures d’innovation et de groupes comme celui des bibliothèques.

Actuellement, la dernière phase du projet Cds est en préparation et son objectif est de pérenniser les acquis et les actions de ce réseau dont l'autonomie de fonctionnement doit être atteinte au 1er janvier 2020.

Dans cette perspective, le projet se développera en 2019 autour de trois nouveaux objectifs qui rassemblent et prolongent ceux de la période 2015-2018 :

-

Un campus transfrontalier à même de poursuivre et d’impulser des projets de collaborations ;

-

Un incubateur de projets transfrontaliers destiné à accompagner au cas par cas la structuration et le montage de projets de collaborations ;

-

La pérennisation du réseau en vue de préparer le transfert des responsabilités et des financements aux établissements membres à l’horizon 2020.

Bilan Cds 2015-2018

Une évaluation globale réalisée en octobre 2018 a montré que, entre les projets et groupes de travail prospectifs, séminaires et journées thématiques, réunions de gouvernance et de coordination du réseau, webcasts et stages, 118 rencontres franco-suisses ont eu lieu entre 2015 et 2018 et 4263 personnes ont participé à ces échanges. Ces chiffres ont fini de convaincre les partenaires engagés de pérenniser leur soutien pour maintenir actifs les groupes engagés et tenter de poursuivre les démarches encore en réflexion.

Voici à quoi ressemble aujourd’hui le bilan de ces actions et préconisations.

Les groupes de travail dits de "proposition"

Cotutelles de thèse

A l'issue de ses séances de travail, la principale préconisation du groupe a été d’élaborer une procédure pilote entre les établissements partenaires de la Communauté du savoir en ciblant 3-4 diplômes de masters éligibles à l’inscription d’une formation doctorale donnée. L’idée est de démontrer la valeur ajoutée d'un réseau comme la Cds et notamment sa capacité à favoriser des synergies interdisciplinaires.

Formations continues

Le groupe de travail a livré les préconisations suivantes :

-

Proposer des partages d’expérience pédagogique entre les acteurs du réseau ;

-

Faciliter les échanges de pratiques en termes d’activités métier opérationnelles (intitulé des offres de formation, partenariats dans les formations continues, mise à disposition de ressources en ligne) ;

-

Constituer un annuaire des personnes-ressources dans chaque établissement.

Formations initiales

Sur la base d’une analyse des situations de formations bi ou tri-nationales existantes, de la typologie de ces situations sur la base de leur organisation (doubles diplômes, élaboration de titres commun, …), quelques recommandations ont été proposées :

-

combiner des formations existantes afin de déboucher sur des "doubles diplômes " ;

-

intégrer dans des programmes au sein de différents établissements des modules de cours/formations construits en communs ;

-

développer un « annuaire » d’enseignant-e-s (par discipline/compétence) qui pourrait faciliter l’émergence d’un tel ensemble de cours;

-

développer un référentiel d'aides à la mobilité des étudiant-e-s (identification de lieux de stages, ...).

Offensive Sciences

Ce groupe a orienté ses travaux sur trois niveaux :

-

Etudier le fonctionnement du programme de financement des travaux de recherche « Offensive Sciences » de la Région Métropolitaine Trinationale (RMT);

-

Explorer des pistes de réflexions autour de nouveaux outils de financement pour la recherche dans le réseau de la Communauté du savoir;

-

Exprimer des recommandations pour les futures programmations de la Communauté du savoir sur le sujet.

Toutefois, il était impossible pour ce groupe de produire des résultats directement exploitables, les enjeux évoqués étant plutôt de nature "politique". Les discussions devront donc se poursuivre au sein du comité de pilotage et des responsables d'établissements de la Cds, la mise en place éventuelle d'un fonds de ressources mutualisées relevant de ce niveau de décision.

En parallèle à ces différents groupes de travail, des études et actions ont été menées qui ont permis de proposer des guides de financements, un soutien à la mobilité des collaborateurs et collaboratrices des structures académiques de la Cds, la mise en place de stages et séminaires communs, l'identification d'expert-e-s pour la constitution de jurys et l'offre d'une solution de visioconférence flexible pour les membres de la Cds.

Un accent important a également été mis sur les actions de communication : site internet, cartographie en ligne des acteurs du territoire, Webcastings et captations d’événements organisés par les partenaires de la Cds, plateforme de partage de fichiers/documents (GED), nouveaux outils de communication (flyers, livrets) pour faciliter la diffusion des objectifs du réseau auprès des différents publics-cibles et pour favoriser l'appropriation des différents financements proposés par les enseignant-e-s et les étudiant-e-s.

Les groupes de travail dits "actifs"

Jurassic Labs

Les FabLabs mettent à disposition de nouveaux dispositifs de fabrication numérique et la connaissance de leur utilisation.

L'intérêt de ces ateliers est de faire sortir la créativité des bureaux d’études et des laboratoires universitaires en ouvrant à la population des lieux d'expérimentation accessibles.

L’autre force des FabLabs est de mettre en relation des types de personnes qui ne se rencontrent généralement pas, ou peu : étudiant-e-s et spécialistes de différents domaines ; universitaires et industriel-le-s, artistes et ingénieur-e-s, générations différentes.

Jurassic Labs propose d’étendre ces mises en réseaux, internes à chaque FabLab, à tous les FabLabs et structures de créativité (existants ou futurs) du territoire de la Communauté du savoir. Il propose également que ce réseau devienne le lien naturel de tous ces territoires pour ce qui est des questions de créativité et d’innovation. Les FabLabs offrent en outre l’avantage d’être neutres, entre industries et universités, entre économie publique, économie privée et économie collaborative, un territoire commun où tout le monde se sent à l’aise pour interagir.

L’objectif de Jurassic Labs est ainsi résumé : créer des ponts verticaux entre trois niveaux identifiés :

Sphère «maker» = espace citoyen ( Fablabs, HackerSpaces, MakerSpaces etc.).

Sphère «professionnelle» = espace de l’économie privée (réseau des centres créatifs [sens large], pépites, etc., connecté aux entreprises, start-ups, chambres de commerce, etc.).

Sphère «institutionnelle» = espace de l’économie publique (réseau des institutions [hautes écoles, universités], connecté au monde politique).

Deux actions principales ont pu être développées par ce groupe :

-

un FabLab mobile transfrontalier dans l'Arc jurassien, plus particulièrement à destination des publics scolaires, via des modules pédagogiques; une version expérimentale de ce FabLab mobile circulera côté France d’ici la fin 2018;

-

une forte implication au Crunch à Belfort en mai 2018, apportant ainsi un soutien « maker » aux 1'500 participant-e-s de ce hackathon universitaire et industriel.

ArcLab

Projet pilote et expérimental, l'action ArcLab a été mise en place à la rentrée 2018 avec pour objectifs l’identification et la définition de compétences pour des professions emblématiques du territoire, en lien avec les enjeux du 4.0 identifiés comme prioritaires par le Comité de pilotage.

Deux ateliers ont permis aux enseignant-e-s/chercheurs et chercheuses de la Cds d’identifier les professions sur lesquelles travailler et de poser les bases des compétences-clefs présentes et à venir, et profils-types qui les composent. A cette occasion, quatre professions emblématiques ont été identifiées (e-firmier-ère, community commerçant-e, digital transgénieur-e et digital transformateur-trice).

Cette expérimentation permettra la réalisation de vidéos thématisées sur chacune des quatre professions étudiées, à destination des établissements membres du réseau et des collectivités publiques.

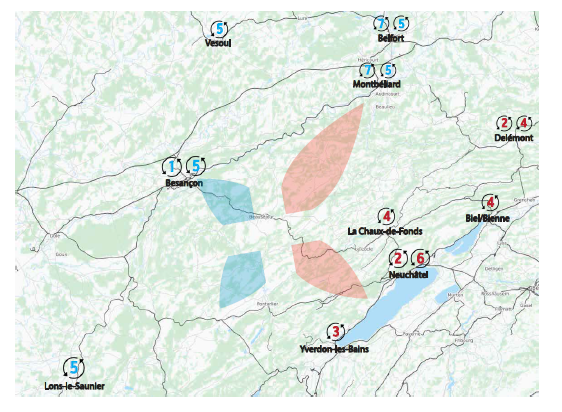

Les bibliothèques de la Cds

Chacune des 7 institutions partenaires dispose d'une (ou d'un réseau de) bibliothèque(s) que l’on peut identifier sur cette carte :

Ces bibliothèques partagent 20 lieux physiques et emploient 150 collaborateurs et collaboratrices environ. Certaines sont rassemblées en un seul lieu (pour des domaines différents), d'autres sont réparties sur un territoire géographique de type campus. Elles ont également en commun d'avoir comme principal public les étudiant-e-s et enseignant-e-s de leur établissement, ainsi que des chercheurs et chercheuses orientés "métier". Mais les personnes privées et professionnelles sont également bienvenues et présentes dans ces structures.

Toutes ensemble ces bibliothèques conservent et mettent à disposition de leurs publics environ 1.000.000 de documents papier et elles traitent environ 420.000 prêts par an. Organisées en consortiums dans leurs pays respectifs, elles proposent en outre un nombre imposant de ressources en ligne aux membres de leurs institutions.

Dès les balbutiements du réseau, ces mêmes bibliothèques se sont regroupées et ont immédiatement perçu l'intérêt qu'elles auraient à collaborer. Non seulement elles sont toutes pilotées au sein d'une institution d'enseignement supérieur mais en plus, les thématiques qu'elles couvrent sont parfois proches, voire très proches et donc complémentaires en terme de fonds documentaires (bibliothèques « jumelles » de part et d’autre de la frontière).

Très rapidement, elles ont mis en place des actions simples de collaborations basées sur une charte qui part du principe de base de réciprocité et qui favorise la mise en réseau de bibliothèques membres. Cette charte s’établit sur une base d’égalité et d’avantages mutuels.

Dès avant la signature de l'«accord-cadre» validé par les responsables des institutions partenaires en juillet 2017, les différentes actions prévues ont immédiatement été mises en œuvre ou en chantier. Il s'agit de :

1 : Accueil réciproque des étudiant-e-s des établissements membres de la Cds

Cela signifie que toute personne inscrite dans une de ces bibliothèques bénéficie gratuitement d’une carte de bibliothèque dans un autre établissement membre.

Ainsi les étudiant-e-s qui optent pour un parcours mixte (voir par exemple le partenariat mis en place entre la HE-Arc ingénierie et l'UTBM) ont accès aussi bien aux ressources de la bibliothèque de leur institution d'affiliation qu'aux ressources de la bibliothèque du lieu sur lequel ils poursuivent leur formation.

2 : Prêts entre bibliothèques

Les bibliothèques ont établi une procédure très simple qui permet, grâce à la mutualisation des liens vers les catalogues en ligne (voir plus loin), de demander en prêt entre bibliothèques un ouvrage détenu par une bibliothèque partenaire de l'autre côté de la frontière. La communication se fait par e-mail et une plateforme collaborative permet d'enregistrer les échanges ainsi convenus. Les prêts sont accordés gratuitement par les bibliothèques partenaires et les frais de livraison par poste sont centralisés et pris en charge par le budget Cds du groupe de travail. En effet, afin de favoriser les prêts transfrontaliers entre bibliothèques partenaires, les frais engagés pour la bonne marche de ces échanges de documents sont pris en charge par le réseau Cds.

3 : Mutualisation des catalogues

Par le biais d’une carte des bibliothèques partenaires publiée sur le site web de la Cds, les membres ont accès à tout moment aux catalogues des bibliothèques et à leurs coordonnées.

Un document interne partagé permet également de disposer des contacts-clés dans cette organisation pour que la communication se fasse directement avec la bonne personne (essentiellement les collaborateurs et collaboratrices qui gèrent le prêt entre bibliothèques).

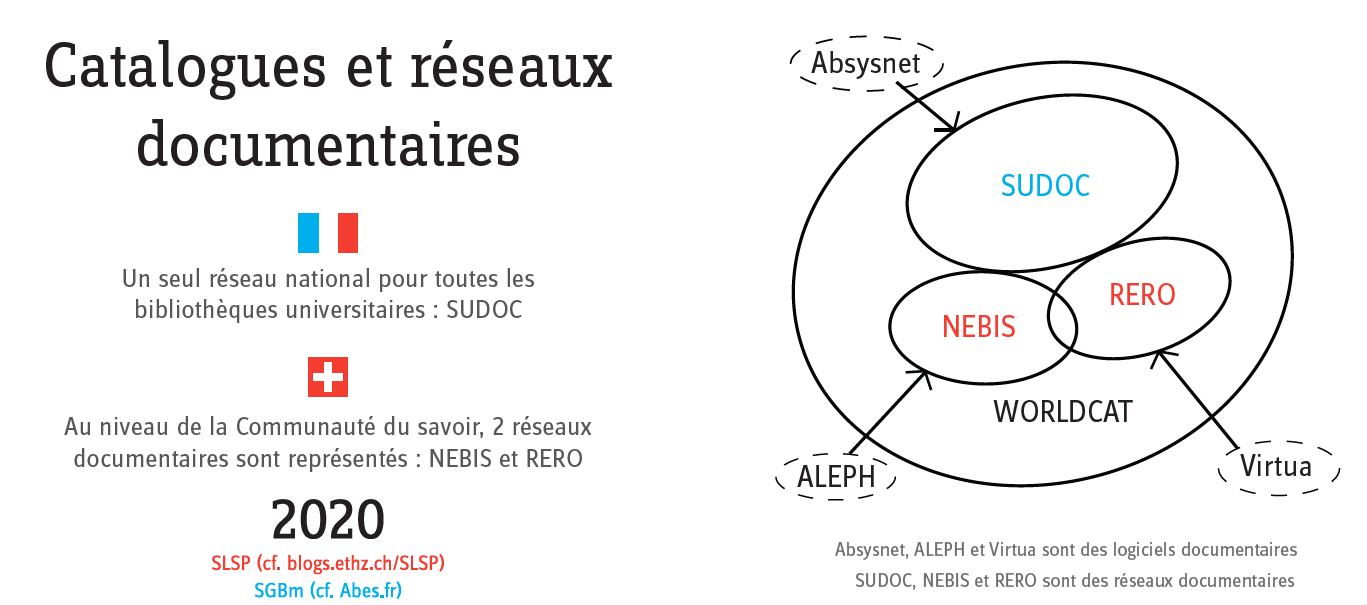

Cet aspect de la collaboration entre bibliothèques est bien sûr évolutif : si la plupart des fonds documentaires des partenaires français sont accessibles en interrogeant un seul catalogue (le Sudoc donne accès aux collections des bibliothèques de l’enseignement supérieur et de la recherche et permet de visualiser la localisation des exemplaires et donc leur disponibilité dans les bibliothèques participantes), les partenaires suisses sont membres soit du réseau Nebis, soit du réseau RERO dont l’interrogation est un peu plus complexe pour les collègues français. On s’aperçoit que dans ce cadre, la solution Worldcat peut être plus intéressante mais on se réjouit surtout de voir les bibliothèques académiques suisses rassemblées prochainement dans un seul réseau SLSP à l’horizon 2021.

4 : Cartographie des thématiques

En cours de réalisation, cette carte permettra de visualiser rapidement les thématiques fortes de chaque bibliothèque partenaire. Cet outil est conçu pour assister aussi bien les personnels concernés que les publics intéressés et leur permettra d’identifier plus facilement les catalogues à interroger en priorité pour obtenir des réponses précises et immédiates à leurs recherches documentaires. Il permet également de visualiser rapidement quelles bibliothèques sont complémentaires en termes de fonds et d’orienter ainsi immédiatement le public vers la bibliothèque qui répondra le mieux à ses attentes selon le lieu où il se trouve.

Une chargée de mission a été engagée par la Communauté du savoir pour une période de 7 mois afin de réaliser ce projet qui demande une analyse plus précise des partenaires, de leurs fonds et de leurs services parallèlement à leur offre de formation.

Une version beta de cette carte est publiée sur le site web de la Cds. Elle pourra être mise à jour au fur à mesure de l'évolution des politiques documentaires des bibliothèques partenaires et sera relayée également sur les sites web de ces mêmes bibliothèques.

5 : Mutualisation de supports de communication

Un ensemble de supports ont été réalisés sur budget de la Cds pour permettre aux bibliothèques participantes d’informer

- d'une part les équipes en charge de la mise en pratique des échanges convenus,

- et d'autre part leurs publics selon un processus « réseau » clairement identifié.

Pour leurs équipes, les membres du groupe ont élaboré des affiches qui permettent d'identifier clairement le rôle du groupe du travail et le cadre dans lequel il évolue. Ces affiches ont pour thèmes :

- Les systèmes éducatifs en France et en Suisse ;

- Le réseau de bibliothèques et notamment : les lieux, les personnels, les environnements de travail, les publics, les catalogues et réseaux documentaires des uns et des autres ;

- Les collections et chiffres-clés des bibliothèques ;

- La carte des bibliothèques des établissements partenaires.

Ainsi les personnels des bibliothèques qui, sur le terrain, mettent en œuvre les échanges convenus entre les membres du groupe de travail ont une meilleure compréhension des situations des bibliothèques et de leurs réseaux dans leurs pays respectifs, et peuvent à leur tour promouvoir les services de la Communauté du savoir en exploitant les avantages de ces échanges au bénéfice de leurs lecteurs et lectrices.

Un élément important de cette communication interne est évidemment l'engagement des parties à respecter la législation nationale et les règlements intérieurs de chaque structure en matière de propriété intellectuelle et commerciale, y compris en matière de reproduction des œuvres. Elles s’engagent également à les faire respecter par leurs publics.

Pour communiquer cette fois avec ces mêmes publics, existants ou potentiels, et les informer des services que ce réseau peut leur offrir, le groupe de travail a également conçu des supports d'information mutualisés qui peuvent être partagés sur les sites web des bibliothèques et/ou institutions partenaires ainsi que sur les réseaux sociaux quand les bibliothèques disposent de tels supports de communication. Faire connaître les accès supplémentaires aux ressources documentaires que permet l’affiliation des bibliothèques à la Communauté du savoir est également un enjeu important de cette communication.

Enfin, dans l’idée de profiter de retours d'expériences entre elles, les bibliothèques ont également en projet le partage entre professionnel-le-s uniquement d'une newsletter par laquelle chaque membre peut informer les autres d'une initiative ou d'une animation particulière et de ses résultats. Cet échange de bonnes pratiques permet aux partenaires d'exploiter à leur façon des formats d'expériences nouvelles en les adaptant à leur propre structure.

6 : Projet de service questions-réponses

Selon l'évolution de la prise en charge du réseau par ses partenaires en 2019, le groupe bibliothèques a pour projet de mettre sur pied un service de questions-réponses à l'échelle transfrontalière. Il fait actuellement l'objet d'une étude de faisabilité et devrait bénéficier du soutien ponctuel d'une personne externe pour la mise en place et la réalisation concrète de cette action. Il pourrait dans un premier temps être intégré pour une phase test dans les bibliothèques de l’UFC à Besançon et, dans un deuxième temps, fédérer les unes après les autres toutes les bibliothèques affiliées à la Cds. Un tel service serait d’une grande richesse pour tous les publics de nos bibliothèques quelle que soit leur localisation géographique.

En conclusion, le groupe de travail «bibliothèques» de la Communauté du savoir est fier d’avoir pu mettre en place très rapidement des services documentaires transfrontaliers simples tout en poursuivant une réflexion de fond sur les projets qui pourraient profiter aux publics des bibliothèques participantes, qu’ils soient étudiant-e-s, enseignant-e-s, chercheurs, chercheuses ou membres à quelque titre que ce soit des institutions partenaires.

Et même si immédiatement, au sein de cette communauté, notre démarche collaborative nous a permis d’enrichir nos services par un prêt entre bibliothèques au niveau international, d’enrichir nos connaissances « métier » par le partage de nos bonnes pratiques et de réfléchir à la faisabilité d’un service transfrontalier de questions-réponses, nous abordons également ensemble toutes les questions que l'évolution de notre métier va nous amener à nous poser dans un proche avenir et notamment :

-

La définition de thématiques partagées puisque développer nos partenariats permet de mutualiser les ressources et de miser sur des points forts dans une optique de complémentarité (réduire les coûts, gagner en efficacité, exploiter les compétences expertes) et de se tourner vers une économie d’accès plutôt qu’une économie de stock ;

-

L’identification d’un service commun et uniformisé pour un public de plus en plus mobile qui pourra bénéficier du développement des synergies particulièrement encouragées dans un environnement géographique européen;

-

La promotion des résultats de la recherche et de la valorisation des données en partageant nos archives institutionnelles et nos ressources en open access ;

-

L’accès aux ressources documentaires et la prise en charge de nouvelles responsabilités dans le domaine des données de la recherche;

-

La communication via les réseaux sociaux qui permettent de faire connaître nos services et activités et participent au rayonnement des bibliothèques.

Si les défis à relever se nomment « recentrer les bibliothèques au cœur de l’apprentissage » pour qu’elles soient le relais des savoirs, « connecter les chercheurs et chercheuses avec leur bibliothèque » afin qu’ils bénéficient d’une expertise à leur service et qu’ils puissent utilement préciser leurs besoins, « rendre visibles les bibliothèques et en simplifier l’accès » grâce au développement de solutions réciproques, alors nous sommes au bon endroit avec les bonnes personnes pour les relever !

Pour le groupe de travail des bibliothèques de la Communauté du savoir :

Agnès Dervaux-Duquenne, bibliothécaire-responsable

Haute Ecole Arc Ingénierie

Notes

[1][Consulté le 20.06.2018]

[2] ©Ex Libris

Sources et liens utiles :

http://www.communautedusavoir.org/

http://www.conference-transjurassienne.org/

http://www.communautedusavoir.org/nos-actions/les-bibliotheques-arc-jurassien/

Groupe de travail des bibliothèques - documents internes

© des illustrations : Cds

- Vous devez vous connecter pour poster des commentaires

Rechercher l’information stratégique sur le web : sourcing, veille et analyse à l’heure de la révolution numérique

Ressi — 20 décembre 2018

Claire Wuillemin, Haute Ecole de Gestion, Genève

Rechercher l’information stratégique sur le web : sourcing, veille et analyse à l’heure de la révolution numérique

À la suite de la co-direction d’un cabinet spécialisé en veille technologique et de plusieurs années à l’Infothèque du pôle universitaire Léonard de Vinci, Véronique Mesguich est depuis 2012 consultante et formatrice freelance pour les domaines de la maitrise de l’information, de la veille stratégique et de l’intelligence économique. Ce dernier livre constitue une mise à jour bienvenue des différentes éditions de Net Recherche (rédigées alors en collaboration avec Armelle Thomas), le dernier datant de 2013. Elle propose ici théorie, méthodes, outils et études de cas sur la recherche d’information sur le web et la mise en place d’une veille efficace. Bien que ce sujet ait déjà fait l’objet de nombreux ouvrages de qualité, ce livre va plus loin en remettant la recherche d’information et la veille dans le contexte actuel du numérique –Big data, internet des objets, intelligence artificielle et nouveaux supports comme les smartphones – et actualise les outils, sources et compétences nécessaires pour sa mise en œuvre.

Publié en 2018, Rechercher l’information stratégique sur le web : sourcing, veille et analyse à l’heure de la révolution numérique s’inscrit dans la préoccupation très actuelle de développer les compétences informationnelles afin que tout un chacun puisse développer une véritable littératie numérique et évoluer en homo numericus. Comme l’indique son titre, ce livre s’attache à des questions de recherche d’information et de veille, et cherche en particulier à fournir des réponses aux questions suivantes :

-

Comment optimiser la recherche d’information afin de minimiser la redondance et la perte d’information ?

-

Comment et où collecter de l’information stratégique ?

-

Comment juger la qualité de l’information recueillie ?

À cette fin, le lecteur est accompagné à travers un cheminement logique sur les vastes thèmes de la recherche d’information et la veille à l’aide d’une structure solide de cinq chapitres qui s’enchainent avec cohérence. Son livre s’ouvre ainsi sur un chapitre qui pose de manière étendue le paysage du web en 2018 c’est-à-dire les enjeux qui se posent aujourd’hui pour les utilisateurs et les professionnels de l’information mais définit également tous les aspects techniques qui y sont liés ainsi que les principales tendances qui se profilent pour ses usages et ses évolutions.

Quelles sont donc ces forces qui agitent le web ? Pour commencer, on notera l’avènement du mobile first au sein de Google, qui dans un avenir proche privilégiera la version mobile des pages web pour son indexation. Ce tournant est le témoin d’une utilisation du web de plus en plus nomade. Les veilleurs et autres professionnels de l’information devront également prendre en compte les nouveaux usagers des réseaux sociaux. Apparus il y a une quinzaine d’années, ces derniers sont devenus incontournables dans la panoplie des sources d’informations. Les questions politiques et économiques s’introduisent également dans le paysage du web : neutralité du web, contenus ouverts, gratuits ou payants, le droit à l’oubli numérique et le fameux RGPD (règlement général européen sur la protection des données personnelles). L’auteure n’entre pas forcément dans le détail de ces diverses actualités, choisissant parfois de les développer dans des chapitres ultérieurs ou de laisser le soin au lecteur de trouver davantage de réponses par lui-même. La force de cette partie est indéniablement la pertinence et la quasi-exhaustivité des thématiques qui y sont abordées, qui permettent au lecteur d’entrer dans le sujet de l’ouvrage avec la connaissance des forces et des tendances qui s’y exercent. On saluera finalement la présence d’un lexique sur le jargon et les grands concepts du web, fort utile pour déchiffrer les nombreux acronymes courants.

Véronique Mesguich se lance ensuite dans le vif du sujet à travers un chapitre conséquent qui se propose d’explorer le vaste sujet qu’est la recherche d’information. À l’instar de la partie précédente, l’auteure commence par un point de théorie en présentant les typologies et le fonctionnement de la recherche d’information ainsi que les différents outils mobilisés par celle-ci, en particulier les moteurs de recherche. Il est appréciable que le fonctionnement et les attributs de ces derniers soient expliqués en détail, car si un grand nombre d’internautes suit la devise du « je Google donc je sais », une minorité est au courant des subtilités du page ranking et autres algorithmes et des biais que ceux-ci peuvent amener dans les résultats. Une liste d’alternatives à Google plus respectueuses de la vie privée est d’ailleurs proposée. La seconde grande section de ce chapitre décrit en détail les subtilités du choix des mots-clés de recherche et de la construction de requêtes, notamment à l’aide d’opérateurs et des fonctions de recherche avancée additionnés aux techniques d’optimisation de la recherche. Là encore, un certain nombre d’opérateurs et d’astuces sont proposés pour les recherches sur Google, mais également sur Qwant, Facebook, Twitter, Linkedin, ResearchGate et Academia. Un tableau récapitulatif permet d’obtenir en un coup d’œil les principaux opérateurs, étayés d’une définition ainsi qu’une liste des différents outils qui les utilisent. Le chapitre s’achève avec une brève typologie des sources d’information, des outils de bookmarking et d’une synthèse sur la méthodologie générale de la recherche d’information.

Suite à cette présentation des méthodes, sources et outils pour satisfaire un besoin d’information ponctuel, le lecteur est ensuite invité à se plonger dans la veille proprement dite. Tout d’abord, il est question de définir la veille, c’est-à-dire sa typologie et son fonctionnement. Puis, il est brièvement question du plan de veille, de son rôle et de son utilité. On regrette que cette section ne soit pas allée un peu plus loin pour présenter cet outil, ni n’en n’ait fourni un exemple, qui se serait avéré utile pour illustrer le propos et donner une idée au néophyte de la forme que peut avoir ce tableau de bord essentiel de la veille.

Cette partie se poursuit avec l’automatisation de la collecte d’information. Sont bien évidemment mentionnés les flux RSS, les agrégateurs et générateurs de flux, les alertes dans les bases de données (pour douze bases de données différentes) sans oublier les agents d’alerte et de surveillance. Un précieux tableau proposé en fin de chapitre résume l’ensemble de ces outils en listant leur intérêt pour la veille, leurs avantages et inconvénients et leur coût. Un focus est ensuite fait sur la veille des réseaux sociaux. En effet, ceux-ci sont des sources relativement nouvelles dans la panoplie des veilleurs et l’hétérogénéité de leurs fonctionnements appelle à des outils et approches spécifiques pour en tirer les pépites informationnelles qu’elles contiennent. Dans cette idée, l’auteure propose des conseils et des ressources pour surveiller Twitter, Facebook, Linkedin, Instagram, Pinterest et Youtube.

L’avènement des réseaux sociaux n’a néanmoins pas que des avantages, car les fake news rôdent. Comment s’assurer de la qualité et l’authenticité de l’information dans ces conditions ? La masse de l’information, appelée parfois infobésité ajoute une seconde difficulté à cet effort. L’analyse de l’information n’est pas toujours naturellement évoquée dans la veille, pourtant il s’agit d’une étape importante de ce processus. Véronique Mesguich passe en revue les ressources et les méthodes manuelles et automatiques à disposition pour évaluer l’information. Une fois l’information validée, le travail n’est pas encore terminé : il faut encore faire parler les données afin de rendre leur essence intelligible pour une audience sans pour autant y apporter de modifications. À cet effet, un rapide panorama de la data-visualisation est proposé et illustré à l’aide d’un tableau qui fait correspondre à des types de représentation les outils existants pour les créer.

L’ultime chapitre de cet ouvrage est un ensemble d’études de cas. À travers dix exemples communs de besoin d’information, l’auteure guide le lecteur à travers enjeux, ingrédients et étapes nécessaires pour y répondre. Ces besoins vont de l’étude documentaire pour une étude de marché, à la navigation anonyme, la surveillance de la concurrence en passant par la recherche de contenus académiques pour la rédaction d’une bibliographie. Évidemment, tous les besoins informationnels ne seront pas couverts par ces exemples, mais leur diversité devrait répondre aux attentes les plus courantes. Cela est par ailleurs une bonne façon de passer en revue et de mettre en pratique l’ensemble des approches, méthodes et outils vus dans les chapitres précédents.

En guise de conclusion, Véronique Mesguich catalogue une fois encore les tendances pour le web et la recherche d’information observables au premier trimestre 2018 et s’interroge sur la révolution numérique et les paradoxes que celle-ci a engendrés : l’explosion de la quantité d’informations disponibles versus sa qualité, la mémoire du web ou comment sauvegarder ses contenus dans ce contexte de big data et de revendication croissante du droit à l’oubli numérique ? L’auteure clôt son livre avec un plaidoyer pour la littératie numérique, soulignant l’importance pour tout un chacun de développer ses compétences, et espère que les nouvelles générations de digitial natives sauront prendre ce virage et montrer le chemin à suivre.

Critique

Le livre de Véronique Mesguich tient les promesses de son titre. On soulignera la richesse indéniable des thématiques abordées et le fait que le propos ne se limite pas à des méthodes et des outils, mais donne une place méritée au contexte et à ses tendances. On saluera aussi l’équilibre entre les différentes thématiques et la manière logique dont les propos s’enchaînent. Le lecteur n’est jamais laissé à lui-même, mais bien accompagné au long du cheminement du livre.

On peut se demander quel sont les publics cibles de cet ouvrage. En effet, si le paysage est vastement posé en termes d’hétérogénéité complémentaire des thématiques abordées, l’auteur ne rentre pas toujours suffisamment dans les détails pour permettre aux néophytes de comprendre les enjeux profonds de certains sujets. En ce sens, le livre semble s’adresser davantage à un public d’étudiant en sciences de l’information ou à des amateurs éclairés. De leur côté, les professionnels ne seront peut-être pas (toujours) surpris par les contenus abordés, car un certain nombre de connaissances leur seront déjà acquises, ou ils pourraient être laissés sur leur faim vis-à-vis de certaines thématiques pour lesquelles on aurait pu espérer une prise de position de l’auteur. Toutefois, l’intérêt du livre réside dans la réelle et consciencieuse mise à jour des savoirs, des connaissances et des outils, qui sera toujours utile pour les professionnels de la veille et de la recherche d’information, mais également dans le fait que celle-ci se fait de manière neutre, mais critique. De plus, la qualité synthétique des contenus, ses nombreuses astuces et ses tableaux récapitulatifs en fait un excellent support de cours dans le cadre d’une formation en sciences de l’information.

Le seul point noir de cet ouvrage est à imputer à l’éditeur : l’impression en noir et blanc des pages altère la qualité des captures d’écran et des illustrations contenues dans le livre et surtout en freine la compréhension par le lecteur.

Rechercher l’information stratégique sur le web : sourcing, veille et analyse à l’heure de la révolution numérique est un ouvrage à mettre entre les mains de toutes les personnes qui cherchent à parfaire leurs compétences de recherche d’information et/ou de veille, ou qui souhaitent mettre à jour leurs connaissances sur ces sujets. On en encouragera également la lecture par les étudiants, quel que soit leur domaine, afin de les sensibiliser aux écueils du net à l’heure de la toute-puissance des GAFAM et de leur donner les armes nécessaires pour les éviter.

Bibliographie

MESGUICH, Véronique, 2018. Rechercher l’information stratégique sur le web : sourcing, veille et analyse à l’heure de la révolution numérique. Louvain-la-Neuve : De Boeck Supérieur. Information & stratégie. ISBN 978-2-8073-1578-5.

- Vous devez vous connecter pour poster des commentaires

Consommer l’information : de la gestion à la médiation documentaire

Ressi — 20 décembre 2018

Siham Alaoui, M.S.I., Étudiante au doctorat en archivistique, Département des sciences historiques, Université Laval, Québec (QC), Canada

Consommer l’information : de la gestion à la médiation documentaire

Les développements technologiques ont changé les rapports entre les archivistes, les archives et le grand public. La fonction des archives se modifie dans la société, d’autant plus que l’archiviste, ce gardien de la mémoire, jouit désormais de nouveaux rôles socioculturels dans la médiation documentaire. Les usagers changent de positionnement : autrefois des simples récepteurs passifs de l’information documentaire, ils deviennent des sujets numériques qui participent activement à la chaîne archivistique. Une telle participation oriente l’archivistique vers une nouvelle posture épistémologique, celle de la collaboration et de l’ouverture. Elle dicte la révision des mécanismes de la diffusion des archives et les modalités de leur exploitation. Cet ouvrage est un recueil des réflexions d’un ensemble de spécialistes, issues des présentations faites sur la thématique abordée au 45ème congrès de l’Association des archivistes du Québec (AAQ), tenu le 13, 14 et 15 juin 2017 sous le thème : Consommer l’information, de la gestion à la médiation documentaire. Il est édité par Martine Cardin et Anne Klein, respectivement professeures titulaire et agrégée en archivistique au département des sciences historiques de l’Université Laval. L’ouvrage est structuré en deux grandes parties : la première, plus courte, aborde les postures épistémologiques et éthiques de l’archivistique collaborative, tandis que la deuxième traite de la médiation documentaire entre les institutions, les archivistes, les archives et les usagers.

Martine Cardin et Christian Desîlets, en exposant le cas des archives de la publicité, abordent une nouvelle perspective de l’archivistique à l’ère du numérique, soit celle de l’archivistique ouverte. Cette nouvelle approche retrouve ses bases dans les fondements du marketing ouvert. Elle est issue d’un besoin de valorisation des archives, intervention qui nécessite désormais l’implication de l’usager et qui induit une médiation documentaire multidirectionnelle entre les parties prenantes d’un système d’exploitation des archives. Didier Devriese s’attarde sur la valeur du document d’archive et considère qu’elle n’est pas jugée seulement par le producteur de celui-ci, mais aussi par son usager. Il rappelle que les métadonnées documentant le contexte de création des documents d’archives favorisent leur réexploitation et leur restitution par les usagers actuels et potentiels. Il conclut que l’archiviste n’est pas le seul acteur à intervenir dans la médiation documentaire, puisque c’est aussi à l’usager qu’incombent la responsabilité de l’évaluation des archives et l’interprétation de leur signification. Jean-Philippe Legois rejoint la même conception de médiation collaborative, mais se positionne plutôt dans la sphère des témoignages oraux. Il se sert de l’exemple de la Cité des mémoires pour illustrer les particularités de la mémoire collective estudiantine en France et les enjeux liés à sa préservation. Dans ce sens, il évoque l’expression de l’archivistique intégrale pour mettre en avant le rôle de l’archiviste dans la constitution et la préservation de la mémoire sociétale à travers la collecte d’archives privées en lien avec les activités des institutions publiques. Toutefois, l’archiviste n’y est pas un intervenant unique puisque la gestion et la sauvegarde de la mémoire collective orale fait également appel à d’autres intervenants, dont les producteurs et les usagers.

Guillaume Boutard examine la médiation documentaire sous la loupe de la conservation collaborative et distribuée des œuvres musicales numériques. L’auteur souligne le principal défi lié à la conservation des œuvres musicales numériques : d’être en mesure d’étudier et de réinterpréter une œuvre, et non seulement de conserver une performance unique à travers la captation d’un événement. L’auteur explique la tension entre l’œuvre artistique et le cycle de vie de sa conservation, et souligne l’importance d’une médiation documentaire adaptée à la nature de telles œuvres. Après l’exposé d’une étude de cas, il met l’accent sur la collaboration dans les pratiques de la conservation des œuvres musicales numériques, et ce, dans un contexte de médiations technologiques.

Sylvain Senécal aborde une autre facette de la médiation documentaire, celle de la tension entre la préservation et l’oubli. Il postule que la mémoire revêt des aspects sociaux qui soutiennent les processus de la réinvention des connaissances. Elle constitue aussi un fruit de la transaction entre l’individu et la société. Son intelligibilité et sa valeur sont déterminées non seulement par l’archiviste, mais aussi par les créateurs/producteurs des archives. Ainsi importe-t-il d’établir une chaîne de médiation documentaire continue entre ces divers acteurs.

À l’ère du numérique, la médiation documentaire collaborative fait naître de nouvelles responsabilités pour les institutions culturelles et les archivistes à l’égard des usagers. C’est dans ce contexte que Paul Servais s’interroge sur l’avenir de la profession de l’archiviste et la relation de celui-ci avec les usagers. Les réflexions de l’auteur mobilisent les constats tirés d’un projet nommé : Archives et archivistes dans 15 ans. Selon lui, l’archiviste n’est plus perçu comme un simple gardien du trésor des archives : ses missions vont au-delà du périmètre des institutions publiques pour englober patrimoine et mémoire au service de la société. Il endosse un rôle plus actif dans la médiation documentaire avec les usagers, et ce, dans la diversité de leurs profils.

Stéphan La Roche fait le portrait de l’expérience du Musée de la civilisation dans la médiation documentaire/culturelle à l’ère du numérique. Il s’attarde sur les enjeux du numérique dans le milieu de la culture et du patrimoine, et met l’emphase sur la réingénierie culturelle des rôles et fonctions associés à la conservation de la mémoire publique. Il postule que la mise en ligne des œuvres ne garantit pas leur intelligibilité : c’est le point sur lequel les musées sont appelés à redéfinir leurs rôles. Le numérique autorise une dimension supplémentaire : il ouvre les portes au grand public pour s’impliquer dans le processus de l’établissement des interactions entre les contenus et les contextes. L’auteur expose ensuite l’expérience du Musée de la civilisation et ses interventions dans le cadre de la transition vers le numérique et la redéfinition des responsabilités qu’il implique pour les archivistes et les conservateurs du patrimoine.

Laure Amélie Guitard, en présentant les résultats de sa recherche doctorale, définit la médiation culturelle dans un contexte différent, celui de l’entrevue de référence entre l’archiviste et l’usager. Inspirée de la conception muséologique, l’auteure voit la référence comme un acte de communication. Elle liste et décrit les étapes et l’entrevue de référence et les concrétise par des exemples pertinents. Elle démontre que, finalement, l’archiviste est à la fois un agent de médiation culturelle (i.e. transmission des archives) et sémantique (i.e. transmission du sens en décortiquant la portée du besoin informationnel de l’usager et en lui suggérant les sources d’archives qui répondent le mieux à ses attentes).

Annaëlle Winand discute de l’exploitation des archives audiovisuelles numériques par les artistes dans le cadre du cinéma de réemploi, et plus précisément dans l’optique de la production des films expérimentaux. Elle projette un regard archivistique sur le travail du cinéaste Bill Morrison. Elle analyse l’œuvre Decasia sous quatre facettes, soit la matérialité, le contexte, le dispositif et le rôle assigné au public. Sa réflexion débouche sur le constat selon lequel la dimension affective de l’archive intervient dans le processus de la médiation documentaire, et ce, dans la mesure où elle incite le spectateur à devenir une partie intégrante de l’œuvre artistique.

Anne Klein et Yvon Lemay s’intéressent à la question de la diffusion et de l’exploitation des archives. Ils mettent tout d’abord le point sur l’évolution de l’archivistique, de la conception classique à la vision postmoderne. Cette transition redéfinit les missions de l’archiviste dans un vecteur sociétal plutôt qu’institutionnel. Les auteurs présentent le projet Archives et création (de 2013 à 2016) visant à étudier l’exploitation des archives numériques comme un levier à la construction de l’espace de médiation à créer entre l’archiviste et l’usager. Afin de valoriser l’exploitation dans la chaîne archivistique, ils proposent une révision du modèle australien de la gestion documentaire, soit le Records Continuum, en ajoutant cette fonction (i.e. exploitation) aux quatre autres dimensions comme dimension dialectique.

Le sujet de l’ouvrage s’inscrit dans la continuité de la polémique sur le repositionnement de l’archiviste dans une perspective de transition entre les sphères institutionnelle et sociétale, de même que sur le numérique et l’essor des pratiques culturelles. Aussi, il devient de plus en plus crucial de se focaliser sur l’usager qui est désormais perçu comme un acteur numérique actif dans la médiation documentaire. La diversité des perspectives adoptées par les auteurs constitue la richesse de l’ouvrage: les contributeurs se positionnent tantôt dans la perspective des sciences historiques, tantôt dans celle des sciences de l’information, de la muséologie, voire même des sciences sociales connexes, telles que la communication, les études cinématographiques et la musique. Toutefois, tous se rejoignent dans la même idée : percevoir l’usager au centre de la médiation documentaire, valoriser le rôle de l’archiviste dans la société et encourager l’esprit de collaboration archivistique. La variété des approches épistémologiques justifie bien à quel point l’archivistique est une discipline souple qui s’insère dans l’interdisciplinarité avec les autres sciences humaines et sociales.

L’aspect novateur de cet ouvrage réside dans la nouvelle approche de l’archivistique, soit celle de l’archivistique ouverte. Elle résulte de l’interdisciplinarité entre l’archivistique et le marketing ouvert. Cette nouvelle conception axée sur la collaboration, témoigne de la nécessité de la concertation des interventions archivistiques d’un ensemble d’acteurs, et non seulement l’archiviste. Aussi, elle implique le sens multidirectionnel selon lequel la médiation documentaire se réalise, où le consensuel en devient la pierre angulaire. Cet ouvrage est ainsi une référence incontournable pour la communauté archivistique – scientifique et professionnelle – qui s’intéresse aux mutations archivistiques actuelles, notamment dans une perspective sociétale.

Bibliographie

Cardin, Martine et Anne Klein. 2018. Consommer l’information : de la gestion à la médiation documentaire. Québec : Presses de l’Université Laval, 181p. ISBN : 139782763739243

- Vous devez vous connecter pour poster des commentaires

La Perspective du Continuum des archives illustré par l’exemple d’un document personnel

Ressi — 20 décembre 2018

Viviane Frings-Hessami, Monash University, Australie

Résumé

La théorie du Continuum des archives développée en Australie peut apparaître complexe et difficile à appliquer à des exemples concrets. Certains parmi ses écrits de base sont denses et compliqués, et la littérature archivistique n’offre pas beaucoup d’exemples pratiques de son application. Dans les pays non anglophones, la situation est exacerbée par des problèmes de traduction et par le manque de textes écrits par des auteurs qui se placent dans la tradition du Continuum. Cet article écrit par un auteur francophone qui a étudié et enseigné le Continuum en Australie s’efforce de combler cette lacune dans la littérature archivistique francophone. Il présente une explication du Continuum des archives illustrée par un exemple simple, celui d’une photo de famille. Il discute différentes utilisations de cette photo par des utilisateurs divers à des moments et dans des endroits divers et pour des fins diverses afin de montrer comment une perspective de Continuum peut être appliquée à des documents personnels aussi bien qu’à des documents d’affaires et comment elle peut encourager un système de gestion des archives efficace, orienté vers l’avenir et qui permettra de remplir les besoins de tous les utilisateurs.

Abstract

The Continuum theory developed in Australia may appear complex and hard to apply to concrete cases. Some of its core writings are dense and complicated, and there are not many practical examples of its applications in the archival literature. In countries where the main language is not English, the situation is compounded by problems of translations and by the paucity of texts written by authors who position themselves in the Continuum tradition. This article, written by a Francophone author who has studied and taught the Continuum in Australia, aims to address this gap in the Francophone literature. It presents an explanation of the Records Continuum illustrated by a simple example, that of a family photograph. It discusses multiple uses of the photograph by multiple users in different times and places and with different aims in order to illustrate how a Continuum perspective can be applied to personal records as well as to business records and how it can foster a records management system that is effective and forward-looking and that will meet the needs of all the users.

La Perspective du Continuum des archives illustré par l’exemple d’un document personnel

Introduction

La théorie du Continuum des archives développée en Australie peut apparaît complexe. Certains parmi les écrits de base sont compliqués, denses et parfois difficiles à suivre (Piggot, 2010 ; p. 180), et la littérature n’offre pas beaucoup d’exemples pratiques de son application. Dans les pays non-anglophones, la situation est exacerbée par des problèmes de traduction qui entraînent des confusions et par le manque de textes écrits par des auteurs qui se placent dans la tradition du Continuum. Dans cet article, je m’efforce de combler cette lacune dans la littérature archivistique francophone. Je me base sur mon expérience personnelle de six années passées à étudier, enseigner et faire des recherches sur le Continuum des archives à l’Université Monash où le modèle fut développé. Je présente une explication du Continuum des archives illustrée par un exemple simple que tous les lecteurs peuvent facilement relier à leur expérience personnelle, celui d’une photo de famille. Je discute différentes utilisations de cette photo par des utilisateurs divers à des moments et dans des endroits divers et pour des fins diverses et je montre comment une perspective de Continuum peut être appliquée à des documents personnels aussi bien qu’à des documents d’affaires et comment elle peut encourager un système de gestion des archives efficace, orienté vers l’avenir et qui permettra de remplir les besoins de tous les utilisateurs.

Le modèle du Continuum des archives

Le modèle du Continuum des archives (Records Continuum) fut développé à l’Université Monash à Melbourne en Australie dans les années 1990 par Frank Upward et ses collègues Sue McKemmish, Livia Iacovivo et Barbara Reed afin d’expliquer les contextes complexes dans lesquels les documents sont créés et gérés à l’ère du numérique et de représenter les différentes perspectives selon lesquelles des documents peuvent être perçus (McKemmish 2017; Upward, 1996, 1997). Il s’appuie sur une tradition qui remonte à la notion d’un continuum entre les documents et les archives articulée pour la première fois dans les années 1950 par Ian Maclean, le directeur de la section des archives de la Bibliothèque nationale d’Australie (Maclean 1959, McKemmish, 2017). Le modèle met l’accent sur la continuité entre les documents et les archives et conteste la notion que les archives ne comprennent que les documents qui ont été sélectionnés pour être préservés à perpétuité. Dans la tradition du Continuum, les archives sont considérées comme archives dès le moment de leur création (McKemmish et al., 2010) et le concept de recordkeeping (écrit en un mot) englobe la création et la gestion des documents et des archives durant toute la durée de leur existence et quels que soient les usages qui en sont faits (McKemmish 2017; McKemmish et al., 2010).

Étant donné que le terme « archives » en français peut aussi être appliqué aux documents d’archives dès le moment de leur création[1], j’ai choisi de traduire Records Continuum par « Continuum des archives » et recordkeeping par « gestion des archives »[2]. Ces deux expressions représentent bien l’idée que les documents qui ont le potentiel de devenir un jour des archives permanentes doivent être traités avec soin dès le moment de leur création. Le recordkeeping, dans la tradition du Continuum, inclut aussi la gestion des systèmes d’archivage qui doivent être développés en tenant compte des besoins de l’organisme et des exigences législatives et mis en place avant que les archives ne soient créées de sorte que quand les archives sont créées, elles peuvent être immédiatement captées dans des systèmes qui préserveront leurs caractéristiques essentielles (McKemmish, 2017). La captation dans des systèmes archivistiques et l’attribution de métadonnées situent les archives dans un contexte précis à un moment précis et leur donnent un caractère fixe. Cependant, les archives sont perçues comme étant « toujours en devenir » (always in a process of becoming) (McKemmish, 1994 : p. 200), c’est-à-dire qu’elles sont toujours susceptibles d’être transformées par des nouveaux utilisateurs dans des contextes nouveaux.

Les caractéristiques fondamentales du Continuum des archives qui le distinguent d’autres modèles sont ses quatre dimensions. Les quatre dimensions ne sont pas des phases ou des étapes et elles ne se suivent pas dans un ordre déterminé, contrairement aux étapes du cycle de vie ou aux trois âges des archives. Elles coexistent parce que les archives sont impactées par les actions de différents acteurs et parce qu’elles peuvent être perçues de manières différentes par des utilisateurs différents.

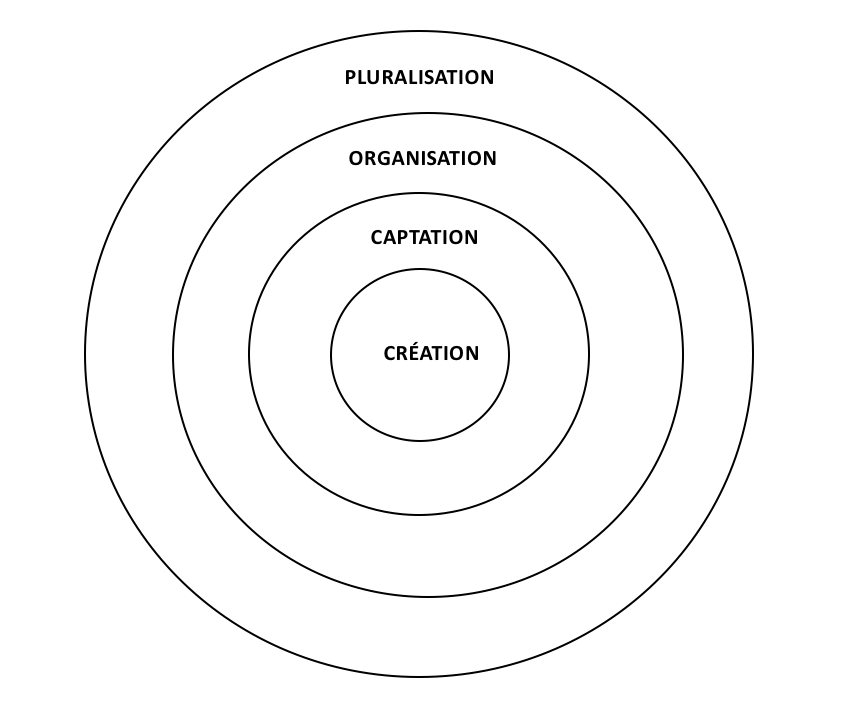

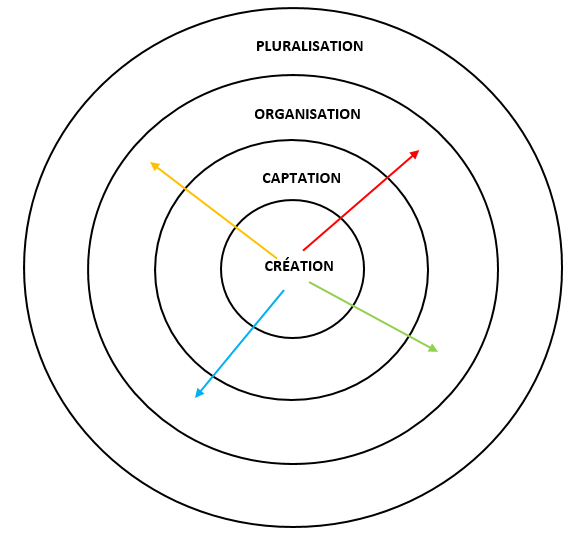

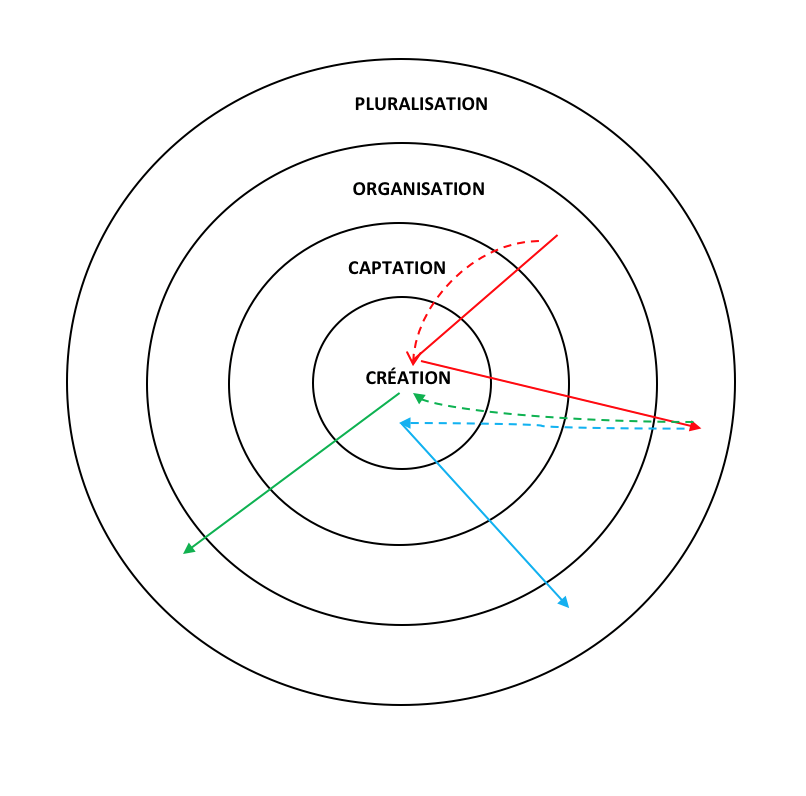

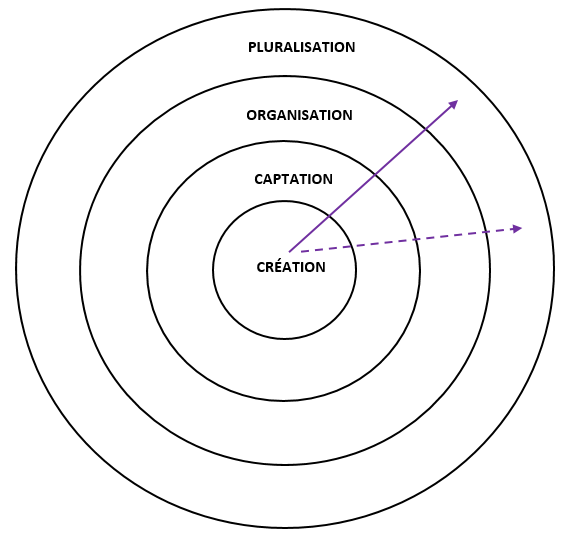

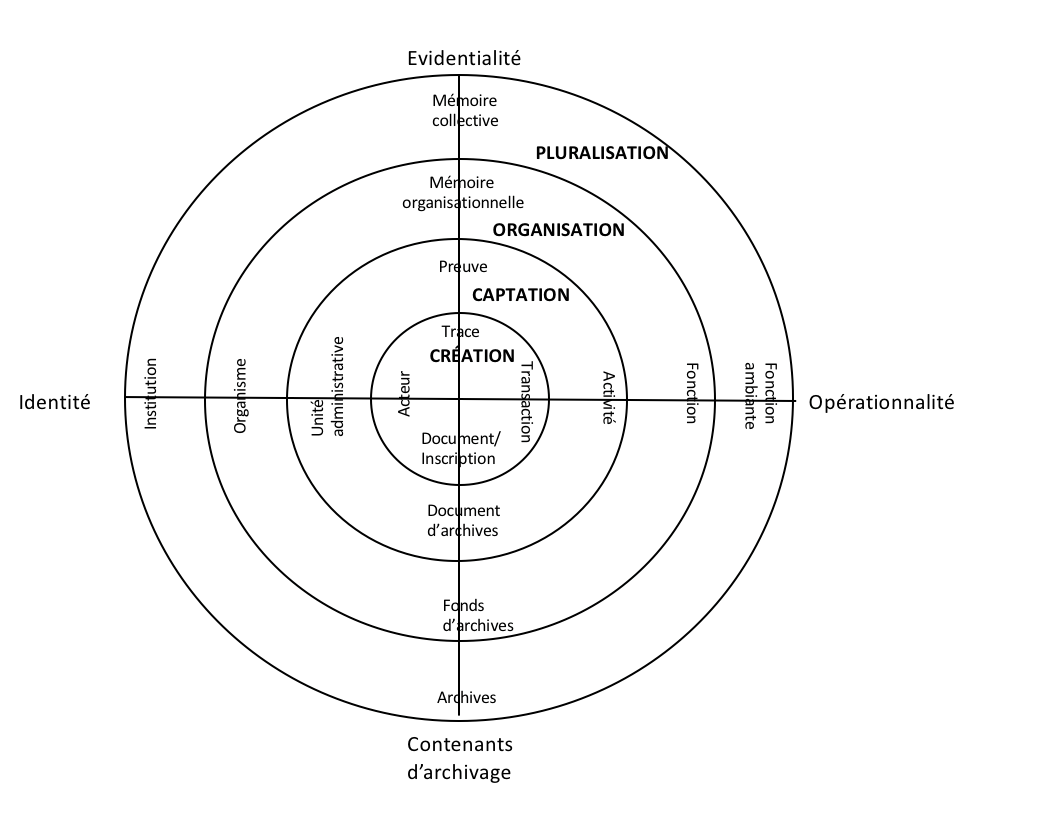

Les quatre dimensions du Continuum des archives sont généralement représentées par quatre cercles concentriques (figure 1). Dans la première dimension, celle de la Création, des transactions prennent place et laissent des traces sous la forme de documents ou d’inscriptions[3]. Dans la deuxième dimension, celle de la Captation, les documents sont captés dans des systèmes d’archivage qui les situent dans un contexte précis et ajoutent les métadonnées nécessaires pour qu’ils puissent être utilisés comme preuves des transactions qui ont été performées. Les documents deviennent ainsi des records, des documents d’archives[4]. Dans la troisième dimension, celle de l’Organisation, les documents d’archives de différents services sont intégrés dans un système d’archivage au niveau d’un organisme de sorte qu’ils constituent des archives qui pourront être utilisées comme preuve des fonctions performées par l’organisme. Dans la quatrième dimension, celle de la Pluralisation, les archives sortent en dehors des confins de l’organisme qui les a créées et gérées de sorte qu’elles peuvent contribuer à la mémoire collective de la communauté générale et être réutilisées de façons multiples.

Figure 1 : Les quatre dimensions du Continuum des archives

Étant donné que les dimensions coexistent dans le temps et l’espace, une représentation tridimensionnelle en forme de cône ou de sphère serait mieux appropriée pour représenter le Continuum des archives, mais elle serait plus difficile à dessiner et à utiliser comme un outil pédagogique. La représentation plate du Continuum des archives avec ses quatre cercles concentriques permet de représenter sur un diagramme différentes perspectives selon lesquelles un document peut être perçu et les voies diverses qu’il peut suivre comme Barbara Reed (2005b) l’a fait dans un des textes clés du Continuum des archives et comme je vais le faire dans la section suivante.

Une photo de famille

Tout document, que ce soit un document personnel ou un document politique de la plus haute importance, peut être interprété différemment par des personnes différentes. Le même document peut être utilisé de diverses façons ou peut être analysé selon des perspectives diverses. Je vais illustrer ceci par un simple exemple, celui d’une photo de mariage.

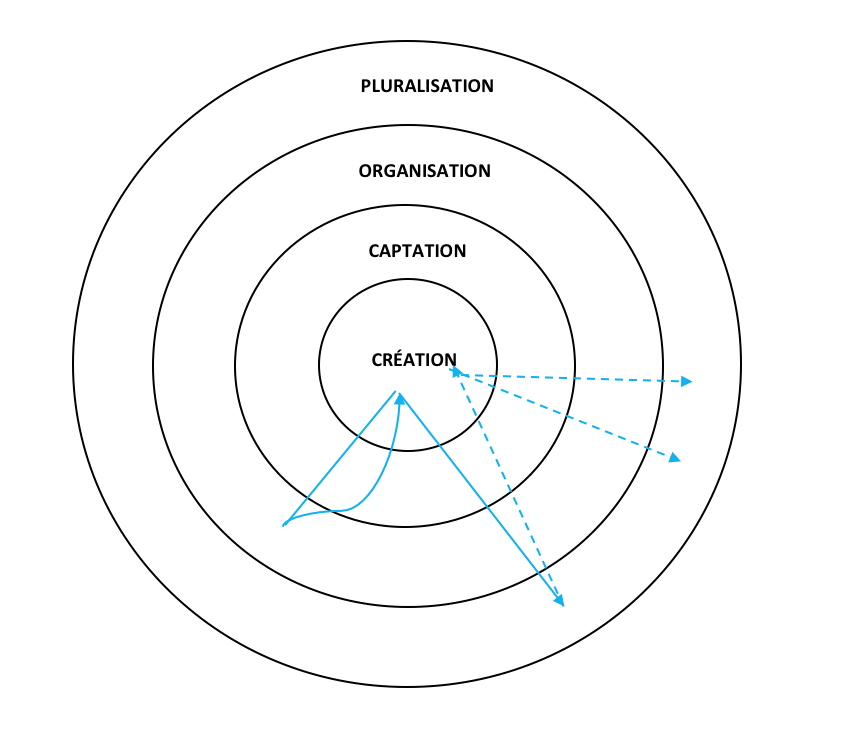

Figure 2 : Une photo de mariage

La photo présentée ci-dessus (figure 2) fut prise au mariage de Daniel et Sophie au mois de septembre 1996 par le photographe engagé pour prendre les photos du mariage avec un appareil photographique argentique. Plusieurs exemplaires furent imprimés pour le jeune couple qui choisit d’en garder un pour eux et de donner les autres à quelques-uns de leurs parents et amis. Chacune de ces photos est un document différent qui va suivre une trajectoire différente. Toutes ces trajectoires peuvent être représentées sur le diagramme du Continuum des archives. Prenons quelques exemples :

-

Les mariés : Daniel et Sophie insèrent la photo dans leur album de mariage avec les autres photos de leur mariage. Pour chaque photo, ils indiquent les noms des personnes présentes et parfois ajoutent quelques commentaires. Pendant les premiers mois après leur mariage, ils gardent l’album sur une petite table dans leur salon et le feuillettent souvent. Après quelques mois, l’album trouve sa place définitive sur une étagère à côté de leurs autres albums photos.

-

Les parents : Les parents de Sophie reçoivent une photo. Ils la mettent dans un de leurs albums photos avec d’autres photos du mariage et d’autres photos de Sophie. Ils indiquent la date du mariage, mais pas les noms des personnes présentes. Ils gardent cet album avec leurs autres albums qui contiennent des photos de famille.

-

Une cousine : Daniel envoie une photo par courrier à sa cousine qui habite en Australie. Elle la garde dans l’enveloppe avec laquelle elle est arrivée. Quoiqu’elle soit contente de la recevoir, elle ne prend pas le temps de la mettre dans un album photo et n’écrit pas la date, l’endroit ou les noms des personnes derrière la photo. Elle garde cette enveloppe dans une boîte avec les lettres envoyées par sa famille.

-

Une amie : Sophie donne une photo à une de ses amies qui l’insère dans un album de souvenirs qui contient des photos de ses amies d’école. Elle indique le lieu, la date et le nom des personnes qu’elle connaît et décore la page avec des petits dessins. Elle garde cet album sur une étagère dans sa chambre.

Représentons maintenant ces actions sur le diagramme du Continuum des archives. Chacune des trajectoires commence dans la première dimension, mais chacune suit un chemin séparé puisque les photos sont captées dans des systèmes différents. La photo en possession de Daniel et de Sophie est insérée dans leur album de mariage (ligne rouge sur la figure 3). La copie donnée aux parents de Sophie est incluse dans un album de photos de Sophie (ligne verte), la copie donnée à l’amie de Sophie dans un album de souvenirs (ligne orange) et la photo envoyée à la cousine de Daniel dans une enveloppe (ligne bleue).

Figure 3 : Quatre utilisations de la photo