Publiée une fois par année, la Revue électronique suisse de science de l'information (RESSI) a pour but principal le développement scientifique de cette discipline en Suisse.

Présentation de la revue

Contenu du site

Se connecter

Publié par Ressi

Service de gestion des données de recherche à la Bibliothèque de l’EPFL : historique, services et perspectives

Ressi — 20 décembre 2017

Eliane Blumer, Coordinatrice données de recherche, Bibliothécaire de liaison pour les Sciences de la Vie

Jan Krause, data librarian

Service de gestion des données de recherche à la Bibliothèque de l’EPFL : historique, services et perspectives

Introduction

Tout service réussi répond à un besoin. Dans ce cas, le besoin est double, d’une part celui des chercheurs et d’autre part celui de l’institution. En effet, au cours des dernières années, les principaux bailleurs de fonds ont mis en place des exigences plus poussées en matière de gestion de données. En parallèle, les éditeurs ont également élevé leurs critères en ce sens. De plus, la complexité et la quantité des données ne cessant d’augmenter, certains chercheurs ressentent le besoin d’être épaulés par leur organisation. Par ailleurs, depuis le début de l’année la nouvelle direction de l’EPFL a mis un point fort sur l’ouverture de la science et sa reproductibilité (open science), ce qui inclut une meilleure gestion ainsi qu’une ouverture plus large des données de la recherche.

Pour répondre à ces besoins croissants, le service de gestion des données de la recherche de la Bibliothèque de l’EPFL a mené deux projets en parallèle : la création de son offre de service et une participation très active au projet national Data Life-Cycle Management (DLCM). Chacun nourrissant l’autre et permettant le développement de compétences. Cet article décrit l’historique de la mise en place du service de gestion des données de recherche à la Bibliothèque de l’EPFL. Il s’arrête sur les services offerts à ce jour et se termine sur les perspectives d’évolution.

Historique de la mise en place du service

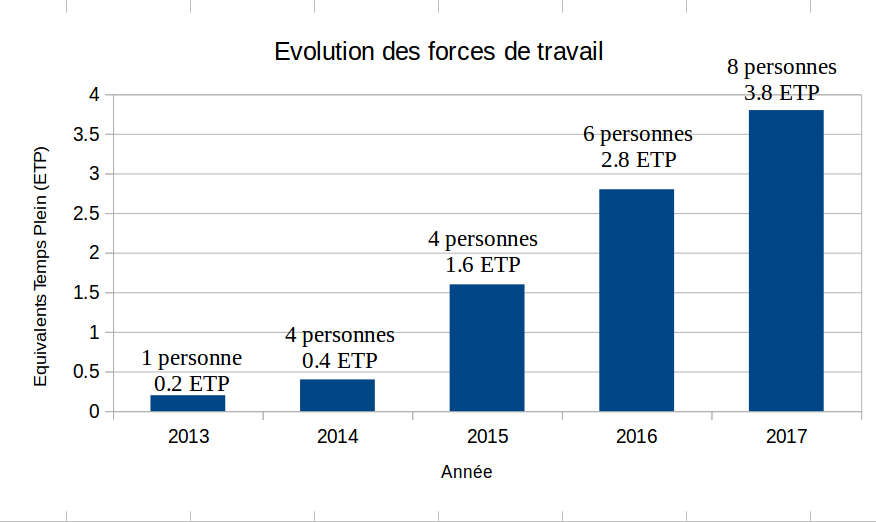

L’implication des bibliothèques universitaires dans la gestion des données de la recherche se situe dans la continuité de leurs missions. En effet, les données sont désormais considérées comme des éléments de publications scientifiques à part entière dans le cadre de la dissémination de la recherche. Le partage des données de recherche devient donc crucial. Il s’agit d’une extension des compétences en matière de métadonnées, de licences, de dépôts institutionnels, notamment. Pour cette raison, entre 2012 et 2013, le dossier « Données de la recherche » a été intégré dans les axes stratégiques de travail au sein de la Bibliothèque, qui a su anticiper les besoins institutionnels. Le travail a démarré d’un côté avec un état des lieux des services offerts dans d’autres institutions internationales, et de l’autre avec la mise en place de collaborations liés aux données de la recherche au sein de l’institution. En pratique, la gestion des données de recherche a été insérée dans le cahier des charges de deux personnes entre fin 2013 et début 2014, ce qui représentait une charge de 0.4 ETP au total.

Tout au long de 2014, le projet de mise en place des services de support pour les chercheurs en matière de gestion de données a été poursuivi, et une première action de sensibilisation a été réalisée avec la conférence « Open Research Data – The Future of Science ». Ce fut l’occasion de se réunir avec les chercheurs et les autres acteurs impliqués au sein de l’institution (le Research Office, le service informatique), et d’échanger avec d’autres acteurs concernés en Suisse (professionnels de l’information, etc.).

Cette même année, la Bibliothèque s’est focalisée sur la mise sur pied du projet national Data Life-Cycle Management (DLCM)[1]. Nous avons été particulièrement actifs dans la soumission commune de la proposition de projet auprès du fond swissuniversities P-2 Information Scientifique. Celle-ci a permis d’obtenir un fond de cinq millions au total destiné à répondre au niveau national aux besoins les plus imminents des chercheurs en matière de gestion de données, incluant le planification, la gestion active, la préservation ainsi que le training et consulting. Dans ce contexte, la Bibliothèque de l’EPFL s’est engagée activement en tant que responsable d’un axe de travail, ce qui lui a permis d’augmenter ses forces de travail d’1.0 ETP via des fonds mixtes. De manière générale, la Bibliothèque de l’EPFL a bénéficié du projet DLCM qui a joué le rôle de moteur national pour les institutions participantes.

En 2015, le service se formalise. La Présidence de l’EPFL approuve en janvier un projet de service d’accompagnement des chercheurs pour la rédaction des Data Management Plans (DMP) en phase pilote pour six mois. L’objectif du service était de soutenir les chercheurs qui devaient répondre aux requêtes en matière de gestion de données de la recherche de la Commission Européenne dans le cadre de l’Open Data Pilot du programme de financement Horizon 2020. Le projet a été ensuite confirmé et stabilisé après le pilote. C’est également dans ce contexte et au cours de cette année que les effectifs ont pu être augmentés de 0.8 ETP.

Une page web a été également insérée dans le site de la Bibliothèque, mettant en évidence les différents services impliqués dans la gestion des données à l’EPFL. De plus, un article présentant les enjeux de la bonne gestion des données ainsi que le service est publié dans le journal institutionnel[2].

Côté sensibilisation, la Bibliothèque a de nouveau organisé un événement, étalé sur quatre dates autour la thématique de l’Open Science, cette fois-ci avec une orientation plus pratique, avec entre autres des workshops sur [3] et la fouille de textes et de données (data and text mining).

Côté formation, une première offre a été mise en place, avec l’intention de couvrir les besoins institutionnels. Une formation généraliste d’une journée (« Optimizing Research Data Management »), accessible via le Service de Formation du Personnel et destinée à l’ensemble de l’EPFL avec un fort accent sur la recherche a été créée.

Dès 2016, un module de gestion des données de recherche dans la formation en compétences informationnelles à destination des doctorants a été initié ; il se focalise sur la publication de jeux de données. Des formations ciblées pour des groupes de recherches sont aussi offertes à la demande. Dans ces cas, une étude des besoins du laboratoire est effectuée au préalable, d’une part via un sondage auprès des membres du groupe et d’autre part en se basant sur une enquête plus approfondie auprès d’une ou deux personnes choisies. Finalement, des propositions d’améliorations sont faites et discutées avec l’ensemble du groupe pendant une demi-journée ou une journée entière. Le but étant de prendre des décisions débouchant sur des actions concrètes.

Sur le plan de la sensibilisation, la Bibliothèque de l’EPFL a notamment agi via la co-organisation de la conférence opendata.ch à Lausanne, en prenant en charge la partie dédiée aux données de recherche, les autres partenaires se focalisant sur les aspects gouvernementaux et commerciaux de l’open data.

Sur le plan pratique, pour renforcer les actions de support pour les chercheurs dans la rédaction des DMPs, la Bibliothèque a créé en 2016, en collaboration avec l’Ecole Polytechnique Fédérale de Zürich (ETHZ), une Data Management Checklist ainsi qu’un premier modèle de Data Management Plan (en partenariat aussi avec le Digital Curation Centre). Ce modèle répond au lancement du Open Data Pilot d’Horizon 2020[4], le programme européen de financement de la recherche et de l’innovation. Le pilote portait sur neuf domaines scientifiques[5] et comprenait la nouvelle exigence de fournir un DMP. Plus précisément, ce type de plan consiste à répondre à un ensemble de questions spécifiques, telles qu’illustrées dans le tableau 1 ci-dessous. En d’autre termes, il s’agit d’un document définissant pas à pas la gestion des données, depuis leur création jusqu’à leur archivage. Étant donné que Horizon2020 est l’un des deux bailleurs de fonds les plus importants pour l’EPFL, il est évident que ceci a demandé une forte implication du service pour répondre au besoin des chercheurs. Il était également important de remplir ces exigences pour la direction et de maintenir le niveau de financement obtenu.

Par ailleurs, le projet DLCM ayant été accepté, une partie importante des forces de travail s’est orientée sur ce projet. Notamment, sur la réflexion autour du portail DLCM, ainsi qu’un travail préliminaire sur le projet de préservation à long terme. Ceci a permis à l’équipe de la Bibliothèque de renforcer son réseau et ses compétences

En 2017, Martin Vetterli a été nommé président de l’EPFL. Dès son entrée en fonction, celui-ci a fait remonter l’Open Science au premier plan des préoccupations stratégiques de l’institution. En particulier, la direction a apporté son soutien à la démarche de la Bibliothèque et de son service de gestion des données de recherche. Des actions pragmatiques ont été entreprises en étroite collaboration avec la Bibliothèque tel qu’un hackathon basé sur l’ouverture de données de l’EPFL[6] ou encore une école d’automne pour les doctorants, Open Science in Practice, a été mise en place. La bibliothèque s’y est fortement impliquée, notamment en proposant les modules sur le DMP, la publication et la préservation de données. De plus, la formation interne déjà en place sur le data management planning a vu sa demande augmenter et a été donnée quatre fois.

Ce fut également le moment opportun pour lancer le nouveau site web http://researchdata.epfl.ch , déjà en préparation. Celui-ci comporte les sections suivantes : Planification et financement, Travailler avec les données, et Publication et préservation. Les informations-clés concernant le support et les formations y sont disponibles.

Toujours en 2017, le Fond national suisse de la recherche scientifique (FNS) exige des DMP dès la soumission des projets, et ceux-ci sont devenus une part importante du service. De façon similaire, Horizon2020 a étendu son Open Data Pilot à l’ensemble des disciplines, rendant le DMP systématiquement obligatoire. En réponse à ceci, [7] à été élaboré, toujours en collaboration avec l’ETHZ.

Ce n’est pas uniquement l’accroissement des forces de travail qui a permis de monter ce service, mais également la collaboration avec d’autres services et institutions ainsi que l’organisation d’un bon nombre d’événements clés internes et externes à l’EPFL sur plusieurs années.

Figure 1 – Evolution des forces de travail de l’équipe, financement EPFL et DLCM confondus.

Les services à ce jour

Globalement, les services en matière de données de la recherche offerts par la Bibliothèque peuvent être divisés en deux catégories : le soutien et les formations.

Soutien

Le soutien se décline en plusieurs variantes.

Le plus fréquemment, il s’agit d’assister les unités de recherche à rédiger un DMP. Il s’agit souvent de répondre à l’exigence d’un bailleur de fonds, particulièrement le FNS ou Horizon2020. Moins fréquemment, les groupes désirent travailler sur un DMP dans le simple but d’améliorer leur pratique.

Dans d’autres cas, notre apport consiste à amener une expertise spécifique quant à une problématique précise. Il peut par exemple s’agir de choisir un dépôt pour la publication de données, ou une licence appropriée, ou encore un renseignement quant à la politique d’un éditeur en matière de partage de données.

Afin d’optimiser le support, nous avons créé différents guides. Parmi les plus utilisés, il y a le [8], élaboré en collaboration avec la bibliothèque de l’ETHZ. Ce document propose des recommandations ainsi que des exemples de réponses pour chaque question du bailleur de fonds (voir tableau 1).

Tableau 1 - Questions à développer pour le Data Management Plan du Fonds national suisse de la recherche scientifique

|

1 Data collection and documentation 1.1 What data will you collect, observe, generate or reuse? 1.2 How will the data be collected, observed or generated? 1.3 What documentation and metadata will you provide with the data? 2 Ethics, legal and security issues 2.1 How will ethical issues be addressed and handled? 2.2 How will data access and security be managed? 2.3 How will you handle copyright and Intellectual Property Rights issues? 3 Data storage and preservation 3.1 How will your data be stored and backed-up during the research? 3.2 What is your data preservation plan? 4 Data sharing and reuse 4.1 How and where will the data be shared? 4.2 Are there any necessary limitations to protect sensitive data? 4.3 I will choose digital repositories that are conform to the FAIR Data Principles. 4.4 I will choose digital repositories maintained by a non-profit organization. |

Par exemple, concernant la question sur le copyright et la propriété intellectuelle, la recommandation suivante est proposée :

|

« Attaching a clear license to a publicly accessible data set allows other to know what can legally be done with its content. When copyright is applicable, Creative Commons licenses are recommended. However, Creative Commons licenses are not recommended for software. Amongst all Creative Commons licenses, CC0 "no copyright reserved” is recommended for scientific data, as it allows other researchers to build new knowledge on top of a data set without restriction. It specifically allows aggregation of several data sets for secondary analysis. Several data repositories impose the CC0 license to facilitate reuse of their content. In order to enable a data set to get cited, and therefore get recognition for its release, it is recommended to attach a CC-BY “Attribution” license to the record, usually a description of the dataset (metadata). To get recognition, data sets can be cited directly. However, to increase their visibility and reusability, it is recommended to describe them in a separated document licensed under CC BY “Attribution”, such as a data paper or on the institutional repository. When the data has the potential to be used as such for commercial purposes, and that you intend to do so, the license CC BY-NC allows you to keep the exclusive commercial use. Reuse of third-party data may be restricted. If authorised, the data must be shared according to the third party’s original requirement or license. If you need guidance in the publication and license choice, you can check the suggested “Data publication decision tree” |

Pour ce même point, trois exemples sont aussi donnés :

|

Example 1: The research is not expected to lead to patents. IPR issues will be dealt with in line with the institutional policy. As the data is not subjected to a contract and will not be patented, it will be released as open data under Creative Commons CC0 license. Example 2: This project is being carried out in collaboration with an industrial partner. The intellectual property rights are set out in the collaboration agreement. The intellectual property generated from this project will be fully exploited with help from the institutional Technology Transfer Office. The aim is to patent the final procedure and then publish the work in a research journal and to publish the supporting data under an open Creative Commons Attribution (CC BY) license. Example 3: Data is suitable for sharing. They are observational data (hence unique) and could be used for other analyses or for comparison for climate change effects among many things. Reuse opportunities are vast. For this reason, we aim to allow the widest reuse of our data and will release them under Creative Commons CC0. |

De plus, d’autres documents ont été élaborés et mis à disposition sur le site web, dont :

- Modèle pour Horizon 2020

- Formats de fichier recommandés pour la préservation à long terme

- Arbre de décision pour choisir une stratégie de publication des données

Un cas type de demande d’assistance pour la rédaction d’un DMP

Souvent, les demandes de soutien débutent par un mail reçu sur la boîte email researchdata@epfl.ch Prenons l’exemple fictif d’un message avec pièce jointe envoyé par une chercheuse en Sciences de la Vie constitué du modèle DMP FNS pré-rempli ainsi que de plusieurs questions. Imaginons que, dans le DMP, la nature des données produites ainsi que les droits de partage (embargo, données sensibles etc.) ne sont pas détaillés. Comme il y a beaucoup de points à couvrir dans ce cas, nous contactons la personne en lui proposant un entretien afin de discuter de vive voix de ses questions. Dans des cas plus simples, nous répondons directement par email ou par téléphone.

Le rendez-vous fixé, deux collègues de l’équipe données de recherche ainsi que le/la bibliothécaire de liaison de la discipline concernée se réunissent pour préparer ensemble le retour. L’équipe se rend compte que d’autres parties du DMP ont été traitées de façon superficielle ou manquent. C’est souvent concernant la préservation à long-terme, les métadonnées, les formats de préservation et les licences.

Lors de la réunion, les questions de la chercheuse sont traitées, puis, l’ensemble du document est passé en revue et des suggestions d’amélioration sont faites. En sciences de la vie, lorsque le projet est réalisé avec des partenaires industriels, les droits doivent être discutés avec tous les acteurs impliqués. On insiste également sur le fait que les données personnelles ou sensibles, sont soumises à des exigences légales, et en fonction de la situation, nous renvoyons la chercheuse vers le Human Research Ethics Committee's (HREC)[9]. Pour la gestion des données actives, nous renseignons sur les différents outils appropriés, et, le cas échéant nous renvoyons vers le service informatique concerné (stockage, cahier de laboratoire électronique, gestion des versions, etc.). En ce qui concerne les métadonnées, nous proposons des standards appropriés, en soulignant l’importance de décrire les jeux de données de façon à ce qu’ils soient FAIR[10], comme l’exigent la plupart des bailleurs de fonds. Pour la partie préservation à long-terme, nous rappelons que l’EPFL ne propose pas (encore) de solution interne. Dans le cas présent, une fois les données anonymisées, elles pourront être publiées gratuitement sur Zenodo.org [11]. Nous profitons de l’occasion pour discuter un peu plus en détails de l’initiative du FNS, ainsi que du budget disponible pour la gestion des données du projet.

A la suite de la réunion, nous renvoyons un message contenant tous les documents et informations utiles en pièce jointe.

Le soutien tel que décrit ci-dessus s’est avéré pertinent et apprécié. Cependant, au sein d’une institution forte de milliers de chercheurs organisés en environ 353 groupes de recherche, il n’est pas possible de revoir en détail le data management plan de chaque projet. C’est une des raisons pour lesquelles il est important de former les collaborateurs concernés.

Formation

- Présentation : court exposé non-interactif d’une thématique visant un public spécifique.

- Atelier court : d’une durée de deux heures, souvent combiné avec une pause sandwich à midi, visant généralement les chercheurs.

- Atelier d’une demi-journée : souvent utilisé pour la formation sur mesure d’un groupe de recherche, ou un module pour l’école doctorale.

- Atelier d’une journée et plus : visant généralement un public hétérogène : personnel EPFL en général, une école doctorale, bibliothécaires spécialistes.

La Bibliothèque propose une gamme de formations, tant à l’interne qu’à l’externe. La priorité est évidemment de servir l’institution, néanmoins, l’équipe « données de recherche », s’efforce de répondre aux sollicitations externes dans la mesure de ses forces. En effet, les interventions externes constituent une occasion précieuse de s’enrichir et d’échanger.

Nos formations prennent différentes formes, en fonction du contexte. Voici la panoplie que nous utilisons :

Un cas type : la formation destinée au personnel EPFL

Description

Savoir gérer et organiser ses données de recherche devient l’une des conditions sine qua non pour garantir la qualité, la pérennité ainsi que la reproductibilité de ses données dans la durée. De plus, de nombreux bailleurs de fonds exigent aujourd’hui de savoir préparer un plan de gestion des données pour obtenir un financement. Ce cours d’introduction vous permettra d’acquérir les connaissances et ressources indispensables pour améliorer et optimiser l’organisation ainsi que le partage de vos données de recherche pour le long terme.

Objectifs

- Acquérir les connaissances de bases et découvrir les ressources à votre disposition pour mieux gérer vos données.

- Se sensibiliser aux bonnes pratiques en matière de gestion des données de la recherche tout au long du cycle de vie.

- Saisir les bénéfices d’une telle pratique et savoir répondre aux nouvelles exigences des bailleurs de fond dans ce domaine.

- S’approprier les outils à votre disposition pour optimiser la gestion de vos données au quotidien et à long terme.

- Connaître les étapes et outils pour optimiser la préparation d’un plan de gestion des données.

- Partager votre expérience avec vos collègues.

Parcours de formation :

- Définitions et cycle de vie des données de recherche.

- Avantages d’une meilleure gestion et positions des bailleurs de fonds.

- Présentation théorique des bonnes pratiques pour organiser et partager ses données de recherche.

- Mise en pratique de solutions en fonction des disciplines des participants à cette formation.

- Conseils personnalisés et partages d’expériences.

Public cible

Tout collaborateur souhaitant acquérir de nouvelles compétences pour une meilleure gestion de ses données de recherche. Cette formation est un prérequis pour suivre le cours pratique qui porte sur l’utilisation du logiciel de cahier de laboratoire électronique.

Autres informations

Cette formation offrira des bases théoriques et pratiques. Tout au long de la journée, des exemples concrets seront discutés et mis en pratique selon les besoins précis des participants. Chaque participant aura l’opportunité de pratiquer sur un ordinateur mis à sa disposition et pourra explorer les ressources et solutions disponibles pertinentes dans le cadre son domaine de recherche.

Conclusion

En résumé, la Bibliothèque a su anticiper les évolutions de la recherche scientifique et les nouveaux besoins des chercheurs afin de mettre en place un service adapté. Il a été nécessaire de rassembler plusieurs facteurs pour y parvenir. Tout d’abord, comme l’ensemble des compétences requises pour un tel service n’était pas centralisé à la bibliothèque, il a été essentiel d’établir des collaborations internes et externes. Cela a été l’occasion de devenir une plateforme centralisant les demandes. Ensuite, le contexte politique a été favorable. Premièrement, au niveau institutionnel, avec une volonté claire de soutenir l’Open Science. Deuxièmement, le contexte politique suisse et international a permis de s’engager dans le projet DLCM et de répondre au besoin des chercheurs, lié principalement aux exigences des bailleurs de fond FNS et Horizon2020.

Dans ce domaine en évolution perpétuelle, il est nécessaire de continuer d’innover. Pour commencer, les activités liées à la gestion des données de recherche de la Bibliothèque s’inscrivent dans une stratégie plus large, et qui est actuellement en train d’être approfondie. De plus, si l’on se restreint plus strictement au sujet de cet article, divers développements sont prévus. Pour commencer, les services et outils mis en place continueront d’être améliorés, notamment une nouvelle version du modèle de DMP pour le FNS est prévue. Par ailleurs, des nouveautés sont prévues, citons par exemple la mise en place d’un dépôt institutionnel pour les données, d’un cours crédité pour les doctorants, ou encore d’un service de data stewards travaillant en étroite collaboration avec les laboratoires.

Remerciements

Nous tenons à remercier chaleureusement tous nos collègues de l’équipe des données de recherche et au-delà, qui ont pris le temps de relire et améliorer cet article. Merci en particulier à Lorenza Salvatori d’avoir complété cet historique.

Notes

[1] Accepté en août 2015, DLCM vise à développer ses services en partant des besoins de la communauté. D'entrée de jeu, 49 chercheurs spécialisés dans des disciplines variées ont été interviewés à travers la Suisse. Concrètement, le projet rassemble les forces de l'EPFL, de la HEG / HES - SO, de l'UNIL, de l'UNIBAS, de l'UNIZH, de l'ETHZ, de l'UNIGE et de SWITCH. Pour répondre aux besoins identifiés dans ces interviews, cinq groupes de tâches, appelés tracks , ont été mis en place » Krause & Blumer, Hors-Texte 110, Novembre 2016, p. 27sq. Les cinq tracks sont : Lignes directrices et politiques ; Données actives de recherche ; Préservation à long terme ; Conseil, formation et enseignement ; Diffusion. Plus d’information : https://dlcm.ch

[2] « Les données de recherche: une mine d’or à domestiquer et valoriser » Flash No. 04, mai 2015. https://mediacom.epfl.ch/files/content/sites/mediacom/files/Flash/Flash%2004-2015.pdf

[3] Voir : http://jupyter.org

[4] Voir : https://ec.europa.eu/programmes/horizon2020/

[5] Voir : http://www2.unavarra.es/gesadj/servicioBiblioteca/piloto_de_datos/4.%20p...

[6] Voir : http://datajamdays.org/

[7] Voir : https://researchdata.epfl.ch/files/content/sites/researchdata/files/doc/EPFL_SNSF_DMP_Template.docx

[8] Voir : https://researchdata.epfl.ch/files/content/sites/researchdata/files/doc/EPFL_SNSF_DMP_Template.docx

[9] Voir : https://research-office.epfl.ch/research-ethics/research-ethics-assessment/epfl-human-research-ethics-committee/hrec

[10] Les données FAIR, signifient: Findable, Accessible, Interoperable and Reusable. Voir: https://www.force11.org/group/fairgroup/fairprinciples

[11] Dépôt de données de recherche. Voir: https://zenodo.org

- Vous devez vous connecter pour poster des commentaires

eLectures : la lecture numérique grand public à la BCUL

Ressi — 20 décembre 2017

Laurent Albenque, directeur adjoint

Charlotte de Beffort, responsable du service du prêt

Christophe Bezençon, responsable du service des collections

Françoise Simonet, responsable des renseignements et formation des usagers

Bibliothèque cantonale et universitaire de Lausanne, site Riponne, Pl. de la Riponne 6, 1014 Lausanne

Résumé

Cet article a pour but de présenter un retour d’expérience après 2 ans d’exploitation de la plateforme eLectures à la Bibliothèque cantonale et universitaire de Lausanne (BCU Lausanne ou BCUL) qui permet à toute personne inscrite d’emprunter des livres numériques dans un catalogue d’environ 11'000 titres.

Après un historique du projet qui rappelle les difficultés de le mener en Suisse, si loin des éditeurs français, nous observerons l’offre documentaire de la plateforme, puis nous nous concentrerons sur une partie plus « marketing » en décrivant les options prises pour la promotion d’eLectures, le profil de ses usagers, la médiation à leur égard et les relations avec le fournisseur. Nous détaillerons ensuite quelques perspectives d’avenir pour ce service qui a trouvé son public mais qui en a encore à conquérir.

Summary

The aim of this article is to provide a feedback after 2 years of operations of the eLectures platform at the Bibliothèque cantonale et universitaire de Lausanne (BCU Lausanne or BCUL). This platform allows every registered user of the library to borrow e-books in a catalogue of about 11'000 titles.

After a description of the project background, which is a reminder of the extra difficulties to lead it in Switzerland, so far away from French editors legislative context, we will discuss the documentary offer of the platform. Then we focus on the marketing side of the project describing options taken to promote eLectures, the profile of its users, the mediation towards them and the relationships with suppliers. Eventually, we will detail future prospects for this offer which found its audience but still has to reach a part of it.

eLectures : la lecture numérique grand public à la BCUL

Introduction : l’offre numérique à la BCUL

C’est tomber dans les poncifs que de dire que le numérique occupe de plus en plus de place dans l’offre documentaire d’une bibliothèque telle que la Bibliothèque cantonale et universitaire de Lausanne (BCU Lausanne ou BCUL pour la suite de cet article). Les ressources numériques représentaient, en 2016, 60% de ses dépenses d’acquisitions.

Mais c’est aussi un peu simplificateur de s’arrêter à ce chiffre-là. En effet, l’offre numérique est très majoritairement destinée à la communauté universitaire : 98% des dépenses pour ce type de collections ont été faites pour ce public particulier. Cette disproportion est le résultat de deux phénomènes dont on ne sait pas vraiment s’ils sont, ou non, dépendants l’un de l’autre : l’offre et les conditions d’accès à cette offre d’une part, la manière de « consommer » l’information de l’autre.

Concernant l’offre, la documentation numérique vulgarisée ou grand public francophone reste relativement anecdotique et essentiellement destinée à une vente directe auprès des particuliers [1]. L’offre numérique pour les usagers de bibliothèques est non seulement limitée mais souvent restreinte au territoire français. Cela ne nous empêche pas de fournir l’accès à plus d’une vingtaine de ressources numériques conçues pour le grand public. Le second barrage entre les usagers et ces collections sont les conditions d’accès. Souvent liées à une adresse IP, elles ne peuvent être consultées que sur site physique par le wifi ou par les postes fixes mis à disposition. A ce stade, tous les avantages liés à la mobilité et à la légèreté du numérique s’effondrent. En effet, malgré leur dématérialisation, les documents numériques nécessitent une présence sur place… comme pour les « bons vieux ouvrages de référence poussiéreux ». A ce jour, pour le grand public, nous ne pouvons offrir d’accès à distance que pour notre offre eLectures, objet de cet article, et à Vodeclic, plateforme d’auto-formation informatique. A noter que, grâce au VPN ou aux divers systèmes d’identification qui lui sont destinés, la communauté académique peut accéder à toutes les ressources numériques depuis n’importe quelle connexion internet.

Si on parle de la manière de consommer l’information, il est évident que les pratiques académiques se tournent vers le numérique pour échanger des informations, des données de recherche et leurs résultats, c’est une consommation dans un cadre professionnel qui se veut aussi efficace que possible. Pour la documentation ou la littérature « de loisirs », on remarque que même si les usagers en Suisse semblent largement équipés en terminaux mobiles [2], l’usage de ces derniers ne prend pas le dessus sur les livres papiers (c’est évidemment différent pour la musique, les films et, dans une certaine mesure, pour la presse). Ce n’est en tout cas pas une attente forte de la part de nos usagers. Il y a donc un travail important à réaliser pour faire connaître une offre et donner la possibilité d’un accès facile et intuitif. En clair, le lecteur « grand public » ne va pas se ruer sur cette offre, il va falloir la lui apporter et lui en démontrer les avantages.

Etude sur l’utilisation actuelle et les attentes vis-à-vis de l’offre numérique de la BCUL

Constatant la richesse de l’offre numérique universitaire, la BCUL a fait le choix de proposer de la lecture numérique à distance à l’intention du grand public vaudois. Ce choix s’inscrit dans la suite d’une enquête que le site Riponne de la BCUL avait menée en 2012 auprès de ses usagers et les attentes de ceux-ci relativement à l’offre numérique en bibliothèque.

Deux approches méthodologiques complémentaires avaient alors été mises en place : une enquête en ligne auprès des usagers actifs du site de la Riponne, lancée début septembre 2012, qui a reçu de très bons échos, le taux de participation s’étant élevé à 24%, suivie de 16 entretiens individuels en face-à-face organisés en octobre et novembre.

Les résultats de l’enquête ont montré que :

- 85% des usagers possédaient un ordinateur portable, 57% un ordinateur de bureau, 47% un Smartphone, 17% une tablette et 7% une liseuse. En cela, ils rejoignaient le taux d’équipement constaté en Suisse (voir plus haut).

- La plupart des usagers étaient curieux et ouverts à l'idée du numérique tout en restant encore très attachés à la version papier. L'offre numérique était vue comme importante avant tout en tant que complément de l'offre papier.

- Les ressources numériques étaient perçues comme difficiles à repérer dans l'offre de la BCUL et leur utilisation difficile. Le souhait des répondants était de pouvoir accéder à des personnes de référence pour les renseigner et les aider.

- L'accès à distance et le téléchargement étaient des conditions indispensables pour une utilisation fréquente et régulière d’une future offre numérique BCUL.

Mise en œuvre du projet

Exploration des solutions existantes

Suite à l’enquête de 2012 sur les ressources numériques grand public, un groupe de travail interne a établi un catalogue de propositions de suites à donner, avec une vingtaine d’actions réparties selon quatre axes : communiquer et accroître la visibilité, accompagner les usagers et les former, améliorer l’accès et réfléchir au développement de l’offre numérique.

C’est ce dernier point qui nous a conduit à étudier l’offre numérique consacrée à l’actualité littéraire.

Le choix – nous étions en 2013, rappelons-le – s’est porté assez rapidement sur la société française Numilog, un des seuls acteurs sur le marché francophone à l’époque proposant une collection numérique ET accessible à distance dans le segment principal qui nous intéressait.

Considérant l’expérience concluante de la Médiathèque Valais avec Numilog, nous avons fait part de notre intérêt à cette société du groupe Hachette. Suite au test de la ressource organisé durant le mois d’octobre 2013, nous avons conclu qu’il serait intéressant de travailler avec Numilog, au moins à titre transitoire. En effet, bien que le catalogue proposé n’ait pas été à la hauteur de nos attentes (principalement en termes d’étendue de l’offre), ni la plateforme suffisamment intuitive à notre appréciation, l’absence d’alternative francophone faisait alors de Numilog un fournisseur quasi-incontournable. Le dossier n’a finalement pas abouti, Numilog nous ayant annoncé début 2014 que, pour des raisons de « géoterritorialité », les éditeurs ne seraient plus en capacité de desservir la Suisse.

Nous avons ensuite cherché à identifier un partenaire commercial suisse romand. Lors d’une rencontre en janvier 2014, nos interlocuteurs de la librairie Payot se sont dits sensibles à notre souhait de travailler avec eux dans le domaine du livre électronique, sans toutefois être en mesure de nous faire une proposition.

Les recherches se sont alors tournées vers une plate-forme québécoise lancée en mars 2012, « pretnumerique.ca ». Une phase de test avait débuté dans plusieurs établissements de lecture publique en France avec le projet français Prêt Numérique en Bibliothèque (PNB). Ce projet apportait le double avantage d’un catalogue plus large avec une importante marge d’accroissement, particulièrement en langue étrangère ; et d’un accès public via une plateforme éprouvée (identique à pretnumerique.ca).

Nous avons donc finalement approché la société Feedbooks, Hadrien Gardeur, son directeur, nous ayant annoncé fin avril 2014 l’ouverture à la Suisse des catalogues d’éditeurs impliqués dans PNB, et un test a été lancé le 23 juillet 2014.

Choix et description de la solution Cantook-PNB-Feedbooks

Avant d’aborder la période de tests et d’implémentation à la BCU Lausanne, revenons quelques instants sur la formule choisie : PNB [3].

Le projet français PNB repose sur le hub de la société Dilicom, par lequel éditeurs, distributeurs, libraires et clients finaux (comme les bibliothèques) sont mis en relation. Ce projet, lancé en 2014, est coordonné par le ministère de la culture français. Pour ce projet, trois acteurs ont été choisis (au niveau national) :

- Libraire (Feedbooks dans notre cas). Feedbooks possède deux offres distinctes en fonction du public (une offre plus fournie pour les particuliers que pour les bibliothèques)

- Interface usager (Cantook de la société De Marque dans notre cas). Mise à disposition de l’interface usager permettant :

- Le prêt de livres numériques par les lecteurs eux-mêmes,

- La gestion des prêts et la mise en valeur des collections par les professionnels de la BCU Lausanne.

- Tiers de confiance (Dilicom). Il constitue une garantie pour tous les acteurs : les bibliothèques et les distributeurs doivent avoir un correspondant qui atteste de la situation de leurs achats et de leurs prêts. C’est chez Dilicom que les libraires passent leurs achats, leurs lignes comptables avec les distributeurs et toutes les écritures nécessaires à la bonne fin d’une transaction. Au travers de Dilicom ne circule donc que de l’information. Dilicom comptabilise les achats de livres électroniques et les demandes de prêts.

Le processus est donc le suivant : Feedbooks transmet ses fichiers, les métadonnées associées, à Cantook. Cantook les met à disposition sur sa plateforme pour les rendre accessibles au public et permet le prêt. Les demandes de prêt sont ensuite transmises à Dilicom.

A ce stade, il est important de noter que la bibliothèque n’est jamais dépositaire des fichiers. Ceux-ci transitent directement du distributeur au lecteur. La bibliothèque ne possède pas, même temporairement les livres électroniques, elle ne possède que les métadonnées des titres et des licences qui sont constituées par des droits de prêt.

Implémentation à la BCUL

Les tests ont eu lieu durant l’été 2014, tests beaucoup plus concluants que ceux effectués quelques mois auparavant sur la solution Numilog.

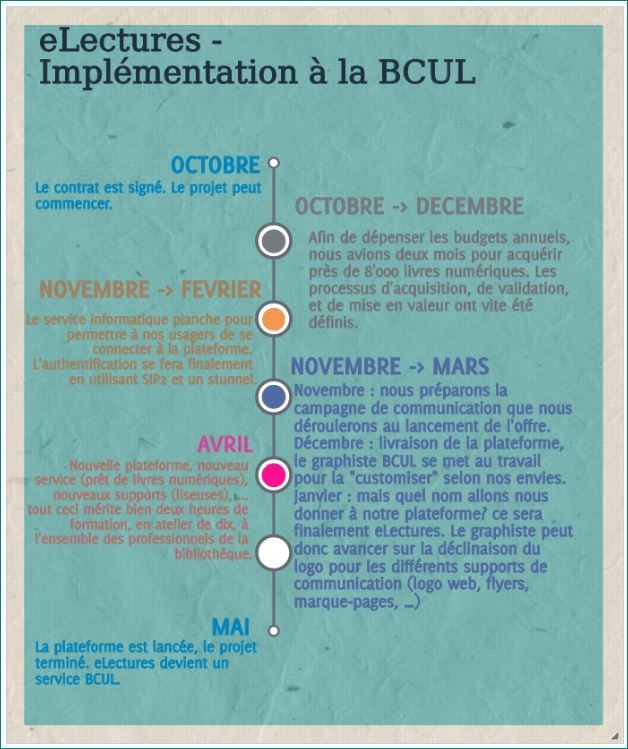

Le contrat avec Feedbooks est alors signé au mois d’octobre, pour un lancement de la plateforme en mai 2015. Ce projet a nécessité la coordination et le travail de plusieurs entités au sein de la bibliothèque : le service des finances, celui des ressources électroniques, les responsables de collections, les services informatique, communication et les services publics. En voici les principales étapes :

Graphique 1 : Calendrier d’implémentation d’eLectures à la BCU Lausanne (2014 - 2015)

L’offre documentaire

Politique des éditeurs français

Ayant forcément constaté, à partir de la fin des années 1990, les ravages d’un passage au numérique non maîtrisé par rapport au chiffre d’affaires de l’industrie musicale mondiale, les éditeurs français sont aujourd’hui moins enthousiastes que leurs homologues anglo-saxons sur le sujet. Si leur prudence peut se comprendre, elle ne fait pas toujours l’affaire des bibliothèques.

Outre la question du piratage, la crainte principale des éditeurs est toujours la même, que le prêt numérique en bibliothèque cannibalise les ventes des livres physiques qui restent au cœur de leur modèle d’affaires. Cette volonté se retrouve dans les conditions d’achat et de prêt faites aux bibliothèques.

Avant tout, il est faux de penser qu’une bibliothèque (ou un particulier) « achète » un livre numérique. Ce que nous achetons, c’est le droit d’accéder à un texte et non pas le texte lui-même. Pour un particulier, ce droit d’accès est censé être sans limite une fois l’ouvrage acheté. Mais il ne peut ni le prêter ni le donner, au contraire de ce qui se fait avec un ouvrage papier. Pour une bibliothèque, les licences sont limitées dans le temps et comportent un nombre total de prêts autorisés par ouvrage acheté : la licence expire lorsque tous les prêts ont été consommés ou, si ce n’est pas le cas, lorsqu’elle arrive au terme de la durée fixée par l’éditeur. L’autre paramètre à prendre en compte dans une décision d’achat est le prix. Contrairement au modèle anglo-saxon, où le prix du livre numérique est significativement plus bas que celui de l’édition papier, les éditeurs français maintiennent un prix du numérique plus élevé que celui de la version papier (+ 30 ou 50%).

Enfin, le gros avantage du livre numérique est la possibilité de prêter simultanément à plusieurs lecteurs le même ouvrage. Techniquement, le nombre de prêts simultanés possibles est bien entendu illimité. Dans les faits, chaque éditeur intègre une limite dans la licence. C’est un avantage proposé par les groupes français comme Madrigall, Editis, La Martinière ou encore Actes Sud. Le prêt simultané n’existe par contre pas chez les éditeurs anglo-saxons.

Outre ces deux conditions de base, de nombreuses licences sont hybrides, Les éditeurs combinent ainsi des conditions différentes en fonction des titres. Par exemple, ils proposent des licences mono-utilisateur pour les nouveautés, multi-utilisateurs pour les titres plus anciens, voire illimitées pour les titres tombés dans le domaine public.

Pour résumer, ces licences sont relativement coûteuses pour les bibliothèques et les laissent face à un double verrou : un nombre limité de prêts sur une durée elle aussi limitée. Heureusement, sous la pression des bibliothèques, certains éditeurs ont fait évoluer leurs conditions dans un sens plus favorable aux besoins. Sans entrer dans les détails, la durée de licence a souvent été allongée pour les titres de fond et le nombre de prêts totaux possibles augmenté pour les nouveautés. Par contre, en parallèle, ces améliorations se sont aussi accompagnées d’une hausse du prix de la licence ou d’une baisse du nombre de prêts simultanés possibles.

Aujourd’hui, les licences proposées ont généralement une durée de 5 à 10 ans, avec un nombre de prêts totaux entre 25 et 60. Le nombre d’emprunts simultanés varie de 5 à 15 avec des exceptions : aucun chez Albin Michel, 50 chez Izneo (groupe Dargaud). Le groupe Hachette se singularise par des conditions plus proches de celles des grands groupes mondiaux dont il fait partie : une licence et un nombre de prêts illimités qui s’accompagnent d’un prix d’achat des nouveautés équivalent à trois fois le prix de la version papier et de l’impossibilité de faire des emprunts simultanés.

Les marges de négociation des bibliothèques sont limitées, hormis le boycott d’éditeurs dont les conditions sembleraient par trop extravagantes. Mais le système fonctionne et répond à un besoin naissant du public. Se posera néanmoins, à terme, la question du poids financier à donner à ces ressources au sein des budgets d’acquisitions et de la pérennité de l’offre. Ce sont là des questions que connaissent déjà les bibliothèques universitaires.

L’offre proposée par la BCUL.

La constitution de notre catalogue a été tributaire de l’offre de notre fournisseur qui, pour les bibliothèques suisses, se limitait à moins de 20'000 titres à la fin 2014, dont plus du quart en anglais. Depuis, l’offre pour la Suisse a rejoint celle de la France et de la Belgique avec plus de 128'000 références disponibles à l’été 2017.

Plusieurs choix guident la constitution de notre catalogue. Un équilibre entre une offre francophone de fiction (53% de nos titres) et une offre documentaire (31%) qui nous permet de répondre à notre vocation de bibliothèque grand public tout autant qu’universitaire. L’inscription à la BCUL étant limitée aux plus de 14 ans, nous avons naturellement exclu les livres jeunesse de nos achats. Enfin, souhaitant nous adresser au public allophone, bien présent dans le canton de Vaud, nous avons constitué un fonds de livres en anglais (fictions et documentaires) qui représente 16% de notre catalogue.

Après une première phase où notre catalogue s’est nourri principalement de l’achat de titres de fond pour constituer la base de notre catalogue, nous avons ensuite mis l’accent sur l’achat régulier de nouveautés. Cet équilibre permet à la fois de répondre à l’appétence bien connue du public pour les nouvelles publications (tout particulièrement pour la rentrée littéraire), tout autant qu’aux demandes plus pointues de certains de nos lecteurs.

Il est évident que la constitution récente de ce catalogue numérique (avec près de 11'000 titres pour eLectures à la BCUL) ne lui permet pas, et de loin, d’atteindre la richesse d’un fonds physique anciennement constitué qui compte plusieurs millions de documents. Plusieurs enseignements peuvent néanmoins être tirés de l’usage qu’en font nos lecteurs.

Les nouveautés de littérature et les policiers s’arrogent la plupart du temps la totalité du hit-parade des prêts. Il est rare qu’un essai s’y glisse. En cela, la lecture numérique suit la même tendance que les prêts physiques. La possibilité d’emprunts simultanés accentue d’ailleurs le poids des titres les plus prêtés dans le total des transactions. A l’opposé, une analyse plus fine montre que beaucoup d’ouvrages de fond sont aussi empruntés, même si ce n’est qu’une seule fois sur deux années d’exploitation d’eLectures. C’est moins visible, à première vue, que pour un titre emprunté plusieurs dizaines de fois sur la même période mais cela contribue tout autant au succès de l’offre.

Les outils statistiques mis à disposition ne nous permettent pas d’aller plus loin sur ce point. Ils restent pour l’instant assez généralistes : nombres de prêts, d’usagers et de connexions, livres les plus empruntés, répartitions des prêts par grandes thématiques. Il nous appartiendra de travailler avec Cantook pour en améliorer la souplesse d’utilisation et surtout les adapter à nos besoins. Une lecture plus fine des usages nous permettra ainsi de mieux adapter nos achats. C’est une volonté qui est d’ailleurs partagée par tous les acteurs, utilisateurs comme fournisseurs.

La fiction représente 70% des prêts, dont 15% de romans policiers et de science-fiction. Les documentaires constituent les 30% restants. Pour ces derniers, les domaines les plus représentés sont les sciences humaines (incluant l’Histoire), les biographies et le tourisme (guides de voyage). Ces chiffres incluent les ouvrages en anglais qui s’élèvent à environ 8% des prêts. On voit donc ici l’importance des collections dans les choix de nos lecteurs, même si les nouveautés et les titres les plus prêtés sortent du lot.

Quelle place pour les éditeurs suisses ?

Dans l’absolu, en tant que bibliothèque cantonale, nous souhaiterions pouvoir proposer à nos usagers du contenu d’auteurs ou d’éditeurs suisses, romands et vaudois afin de les mettre en valeur. En réalité, nous ne pouvons qu’offrir des auteurs suisses publiés en France et dont l’éditeur offre une version numérique. Les éditeurs romands, même les plus importants, semblent encore plus frileux que les Français vis-à-vis de l’édition numérique [4] et donc, si ce pas-là n’est pas encore franchi, celui de le proposer à des bibliothèques pour le prêt n’est pas non plus en ligne de mire.

Nous avons donc pris l’option de proposer ce qui était disponible auprès de notre fournisseur et des éditeurs français avec l’espoir que notre offre prenne de l’ampleur et fasse mieux connaître la lecture numérique dans nos contrées auprès de nos éditeurs. Le temps faisant, l’espoir de voir la littérature suisse mieux représentée sur ces plateformes se réalisera peut-être. Nous aurions alors avec nous l’expérience d’avoir déjà monté ce genre d’offres et un public réceptif et adepte de ces technologies.

Nécessité de faire connaître eLectures pour la faire vivre

Formation des professionnels : un nouveau dynamisme

Lancer une telle offre, pour un public généraliste, sans accompagnement, nous semblait téméraire. Or, pour accompagner, il fallait que les professionnels, et en particulier ceux travaillant dans les services au public, soient au point sur les différentes facettes de la prestation (contenu, fonctionnement de la plateforme et du prêt numérique, connaissance des supports, etc.)

Nous avons donc organisé, dans les mois précédant le lancement de la plateforme, une formation des collaborateurs, basée principalement sur l’expérimentation personnelle.

En 2014, l’offre de livres numériques de loisirs en français était peu développée. En revanche la BCUL a été pionnière dans le test de tablettes et de liseuses, en mettant à disposition des collaborateurs du matériel pour expérimenter. Les collègues étaient donc pour la plupart en possession d’une tablette et à l’aise avec son utilisation. Notre objectif principal était que tous se créent une pratique de lecture numérique, des compétences d’utilisation courante de la plateforme et du téléchargement sur des supports mobiles. Différents ateliers ont été proposés, touchant tous les collaborateurs du site Riponne ainsi que des personnes relais des autres sites de la BCUL. Des présentations ont également été organisées et ont concerné une part importante des collaborateurs des différents sites de la BCUL.

Ces actions ont été l’occasion de mettre en avant de nouvelles compétences, et ont servi de mise à niveau pour l’ensemble du personnel.

Enjeux et constat

Les formations ont permis à tous de se familiariser avec la plateforme et les outils nécessaires à l’emprunt de livres numériques, ce qui a facilité le transfert et donné une plus grande aisance aux collègues des guichets pour renseigner les usagers sur la prestation.

Un petit groupe de bibliothécaires, volontaires, a participé dès le départ aux ateliers et au support en ligne. L’expérience de résolution des problèmes des usagers a permis un approfondissement des connaissances au sein du groupe, et créé un appui à deux niveaux : les questions simples sont gérées par tous et, pour les plus compliquées, les usagers sont redirigés d’abord en interne, puis vers le support de la plateforme en cas de besoin.

Pour être efficace, il est néanmoins indispensable de rester au courant de l’évolution des technologies, en l’occurrence les différentes applications de lecture, les modèles de liseuses, les changements à venir au niveau des DRM. Le rythme n’est pas forcément facile à suivre, surtout si l’on souhaite assurer l’assimilation des informations par tous.

Du côté des bibliothécaires, c’est un constat très majoritairement positif. Ils ont été impliqués dès le départ, et le fait d’être « au front » au guichet a encouragé les uns et les autres à s’approprier la plateforme. Plusieurs se sont pris au jeu et se sont acheté des liseuses.

Plan de communication au lancement

Le lancement de l’offre nous semblait un moment crucial. Notre souhait était de marquer le coup et de créer le « buzz ».

Il fallait bien sûr informer nos usagers de cette nouvelle prestation, mais, offre numérique oblige, et la BCUL étant une bibliothèque cantonale ouverte à tous, il semblait important d’élargir la démarche à la population vaudoise a minima. Forts de ce constat, allait-on viser un lancement « classique », avec une présentation physique dans divers lieux du canton, ou une communication plus digitale ?

En partant du principe que la promotion devait être numérique, nous avons lancé une communication hybride, avec une part digitale importante, grâce au service de communication de la BCUL et d’une agence externe. Le budget de cette campagne n’a pas dépassé les quelques milliers de francs.

De petites vidéos ont ainsi été réalisées avec le message récurrent suivant :

« Jusqu’à l’été, suivez et partagez les aventures de l’homme-bulle eLectures à travers 6 vidéos de 30’’ décalées où les circonstances sont autant d’occasions de profiter de l’offre eLectures », avec pour chacune un slogan en lien avec une spécificité de la prestation:

- eLectures - en toute légèreté ! à Le stockage important sur un support de 100 et quelques grammes

- eLectures vous suit partout à La lecture où que l’on se trouve

- eLectures, à portée de clic ! à Le téléchargement à distance

- eLectures – avec vous tout le temps ! à L’accès 24/24, 7/7

- eLectures - des livres toujours à la page ! à De nouveaux achats réguliers

- eLectures - Nouvelle offre, toujours gratuite ! à La gratuité

Les vidéos ont été diffusées à une semaine d’intervalle sur la chaîne YouTube de la BCUL[5], le site web, Twitter et Facebook.

Pour la part classique de la promotion, un logo a été créé, des signets réalisés, et des affiches placardées dans plusieurs villes du canton. Un « homme sandwich » a distribué des signets au centre-ville et à la gare de Lausanne. Plus traditionnel aussi, un stand pour les cafés numériques a été installé à l’entrée du site Riponne, afin de pouvoir présenter l’offre aux lecteurs.

Formation des lecteurs, accompagnement, renseignements

La mise en place d’une offre numérique va de pair avec un accompagnement des utilisateurs, sur place et à distance, nous en étions convaincus dès le départ.

Un dispositif de formation a donc été mis en place, comprenant :

- L’animation d’ateliers en présentiel,

- Le support en ligne, par e-mail ou téléphone,

- La mise à disposition de tutoriels et de FAQ.

Les ateliers de découverte et de prise en main :

Pendant les 6 premiers mois, une plage a été réservée tous les lundis, sur le site Riponne de la BCUL. Les ateliers sont allés de la présentation générale de la plateforme eLectures à un accompagnement pas à pas dans l'emprunt du premier livre numérique (création d'un adobe ID, réactualisation du mot de passe BCUL, installation des logiciels nécessaires…). Ces ateliers étaient également importants pour nous, à ce stade du projet, car ils nous ont permis de cibler quels étaient les points particulièrement problématiques. A partir de 2016, les ateliers ont été maintenus sur une base mensuelle.

Quelques personnes sont venues plusieurs fois, ayant entre-temps acheté une liseuse, ou amenant avec elles leur ordinateur portable pour débloquer un problème. De façon générale, les ateliers sont également l’occasion d’échanges, tant au niveau technique que du contenu de l’offre ou du plaisir de lire.

Un accompagnement sur place complète le support par e-mail ou par téléphone

Parallèlement à l'accompagnement sur place le support se fait également à distance, par e-mail et par téléphone. Les demandes sont parfois standards mais souvent dépendantes de la configuration des équipements personnels des usagers. Les problèmes ne sont pas toujours faciles à déceler mais, avec le temps, l’équipe qui répond aux questions en ligne a pu établir une sorte de catalogue des problèmes les plus fréquents et de leurs solutions.

Dans l’ensemble, nous avons eu très peu de cas pour lesquels nous n'avons pas trouvé de solution, et ceux-ci ont été transmis au support informatique de la plateforme.

L’aide en ligne et les FAQ

Nous n’avons pas créé de documentation propre, car la plateforme propose une aide en ligne [6]et une FAQ, en français et en anglais. Les guides de démarrage, très bien faits, permettent une entrée en matière pas à pas, et sont d’une grande utilité pour ceux qui se lancent. C’est aussi un bon outil vers lequel sont renvoyés les usagers qui prennent contact avec nous.

Constat

La majorité des usagers empruntent le numérique de manière autonome. Et si un obstacle est rencontré, c’est souvent relativement trivial, par exemple un mot de passe expiré, qui peut être réglé par e-mail.

Le support eLectures, que ce soit en présentiel ou à distance touche majoritairement des usagers très attirés par l'idée de lire sur liseuse ou tablette, mais pas (du tout) par les aspects techniques de la chose. Plusieurs nous interpellent régulièrement afin d'obtenir de l'aide. Pour certains, il suffit parfois d'une mise à jour du système d’exploitation ou du logiciel Adobe Digital Edition, ou d'un changement de paramètres de téléchargement des fichiers pour que le moteur se grippe… et que le lecteur se perde.

De nouveaux eLecteurs s’inscrivent chaque mois sur la plateforme. Il faut dès lors s'attendre à poursuivre cette médiation numérique dans le futur. Les solutions ne sont pas toujours évidentes, mais il est gratifiant de voir un lecteur repartir heureux d’avoir réussi à télécharger son livre, ou qui nous signale lors d'un passage à quel point sa tablette ou sa liseuse lui convient.

A noter que nous avons aussi eu une poignée d’usagers qui ont baissé les bras, et déclaré qu’ils préféraient passer du temps à lire un livre plutôt qu’à résoudre des problèmes informatiques.

Au niveau quantitatif

La part des personnes touchées par les ateliers est très minoritaire. Une septantaine d’ateliers ont été organisés depuis le lancement de l’offre, dont la moitié dans les 6 premiers mois.

Elle est en revanche beaucoup plus importante par e-mail. En deux ans, l’équipe qui gère les questions a répondu à plus de 570 messages. Pour l’année 2016, cela correspondait par exemple à 25% des questions d’usagers par e-mail sur l’adresse d’information du site Riponne.

Prêt de liseuses

Le prêt de matériel a tout de suite fait sens afin d’aider à la promotion de la lecture numérique. Le prêt de liseuses a plusieurs atouts. Tout d’abord, il offre une visibilité (non négligeable) à l’offre virtuelle de prêt numérique. De plus, cela valorise les compétences du personnel qui devient référence dans l’utilisation des différents outils.

La mise en place du prêt de liseuses a nécessité en amont :

- L’achat du matériel (choix des liseuses, définition des conditions de prêt, commande, équipement, …),

- L’ajout d’information sur le site web et sur eLectures directement pour en faire la promotion,

- La formation des collaborateurs à l’utilisation de ce matériel (transfert de livres numériques mais aussi réinitialisation de l’appareil au retour de prêt).

Le prêt de liseuses a tout de suite été un succès, l’ensemble du parc a été prêté dès le premier jour et tous les appareils étaient réservés à leur retour.

Face à ce succès, nous avons essayé, 4 mois après le lancement de la plateforme eLectures, le prêt de liseuses pré-chargées. Cette offre était proposée dans une optique de faciliter le prêt de livres numériques, dont la création d’un identifiant Adobe nous paraissait être un frein. Cependant, cette offre n’a pas rencontré son public et n’a pas été reconduite.

Enfin, après deux ans de mise en service et sur les 13 liseuses mises en circulation, une seule liseuse a rencontré un problème et la garantie a couvert les frais de réparation. Aucune autre liseuse, malgré plus d’une trentaine de prêts chacune, n’a subi de dommage.

Investissement des professionnels dans l’animation d’eLectures

Passée la période de lancement d’eLectures et en plus de la promotion régulière qui en est faite auprès du public, il est crucial de faire vivre notre catalogue et de donner envie à nos eLecteurs de revenir sur notre plateforme. La spécificité de l’offre numérique, aussi bien en bibliothèque que pour les libraires en ligne, est le manque de visibilité de l’offre, au-delà des références présentées sur la page d’accueil.

Deux outils assez classiques, bien connus des bibliothécaires, sont ici à notre disposition pour nous aider à mettre en valeur le catalogue. Ainsi, on peut créer des sélections thématiques en s’appuyant sur l’actualité littéraire, l’actualité générale ou simplement nos envies, ou encore écrire des avis, « Bouche à oreille » à la BCUL, sur les titres au catalogue. Les sélections nous permettent ainsi de valoriser notre fonds. Les avis ont un effet plus ponctuel mais plus fort sur les prêts du titre concerné. Dans les deux cas, la recherche par auteur permet de redonner de la visibilité à toute une œuvre. Par la magie du clic, c’est un moyen immédiat de « faire » du prêt, mais aussi de mettre en valeur les compétences des bibliothécaires.

Dans le cadre d’une offre numérique, il est important de renouveler régulièrement ces sélections et ces coups de cœur afin de ne pas lasser l’utilisateur fréquent. Le succès de ce type de promotion est renforcé par une utilisation des médias sociaux. La newsletter BCUL fait ainsi systématiquement mention dans ses rubriques de titres eLectures. La promotion croisée avec les ressources documentaires physiques in situ est évidemment un plus. Enfin, une sélection ou un avis sur des titres eLectures sont réutilisés, quand cela est possible, pour faire la promotion de leur contrepartie physique.

Quel lectorat pour eLectures ?

Le public ciblé

Nos deux objectifs principaux, lorsque nous avons décidé de nous lancer dans une offre numérique, étaient qu’elle soit « grand public » et accessible à distance.

En tant que bibliothèque publique, nous souhaitions développer une offre « pour tous ». Cela n’excluait bien évidemment pas le public de l’université mais il s’agissait d’inclure nos « autres » usagers, principalement actifs sur le site du centre-ville, avec une offre d’actualité et de loisirs, pendant numérique de l’offre physique de la bibliothèque.

A partir de là, on ouvrait la possibilité d’élargir la population actuelle de nos lecteurs, en touchant :

- Les plus distants, donnant ainsi à la BCUL l’occasion de jouer pleinement sa carte cantonale, en atteignant également les régions plus éloignées de Lausanne,

- Ceux qui ne peuvent se déplacer physiquement à la BCUL, que ce soit pour des motifs professionnels, de santé ou de disponibilité.

On savait par ailleurs qu’une offre numérique intéresserait potentiellement d’autres types d’usagers, comme par exemple les grands lecteurs ou les pendulaires, qui allaient ainsi alléger leur sac.

Enfin, l’idée était à la fois d’attirer de nouvelles personnes, mais aussi de fidéliser nos lecteurs actuels avec une offre numérique accessible à distance et donc aussi disponible pour ceux qui ont quitté l’université ou disposent de moins de temps ou d’occasion de se déplacer dans une bibliothèque.

Analyse du lectorat deux ans après le lancement de l’offre

En l’état, nous pouvons nous baser uniquement sur les statistiques proposées par la plateforme (nombre de prêts, nombre d’usagers, liste des usagers) et sur quelques données observées soit au niveau des emprunts, soit dans les interactions que nous avons avec certains eLecteurs. Seule une enquête permettrait de fournir des données plus précises, notamment qualitatives, sur ce lectorat d’un service numérique.

Le profil d’usage

Dans son enquête dans les médiathèques en Auvergne-Rhône-Alpes, Mabel Verdi Rachemacher (Verdi Rachemacher, 2017) distingue trois types d’usagers : les convaincus, qui ont eu une expérience de lecture numérique satisfaisante et dont la pratique est stabilisée ; les dubitatifs, qui ont eu une expérience satisfaisante mais préfèrent lire en version imprimée ; et enfin les désenchantés, qui font un bilan négatif de leur expérience.

Dans l’utilisation d’eLectures, nous observons les deux postures extrêmes : des personnes qui s’inscrivent à la prestation, empruntent un ou deux livres et ne reviennent pas. Nous avons également un nombre assez important de grands lecteurs, qui empruntent par lot de 10 livres numériques chaque mois, et ceci depuis leur inscription numérique. Un de nos lecteurs emprunte un nouveau livre chaque jour, et nous a dit le lire dans ses déplacements durant la journée. Dans les usages cycliques, on remarque des lecteurs qui n’empruntent pas de manière régulière, mais intensivement à des périodes données, vraisemblablement avant un départ en vacances.

Sur le plan quantitatif ensuite.

Dans son article du Livres Hebdo paru en février 2017, Véronique Heurtematte (Heurtematte, 2017) donne les informations suivantes : à Montpellier Méditerranée Metropole, l’offre touche 1’000 lecteurs sur les 54’000 que compte le réseau (1,9%). A Grenoble, les prêts concernent 1’300 des 35’000 usagers (3.7%). La BCUL compte elle environ 29'000 lecteurs actifs, dont 1'800 sont inscrits à eLectures. Le ratio (6,2 %) est comparativement bon.

Le profil des usagers eLectures

Il faut mentionner que ces données de profil ne sont pas stockées dans la plateforme, qui n’enregistre que les données nécessaires à la gestion du compte : numéro de carte, mot de passe, adresse e-mail. Comme il faut être inscrit dans le réseau Renouvaud pour emprunter dans eLectures, les données ci-dessous proviennent du SIGB.

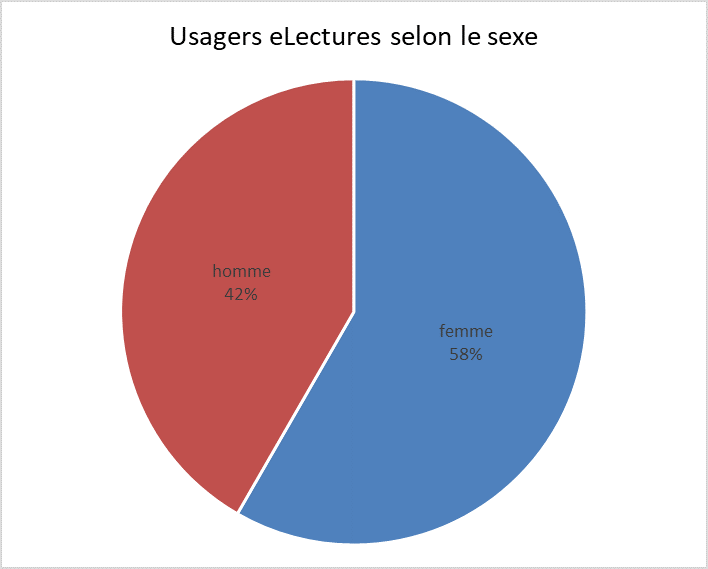

Selon le sexe : les inscrits sur la plateforme sont à 58% des femmes. Pour la lecture en général, l’enquête OFS 2014 sur les pratiques culturelles en Suisse (OFS, 2017) et la brochure présentant les premiers résultats de l’enquête (OFS, 2016) notent que les femmes sont plus nombreuses à lire des livres que les hommes, et particulièrement si on parle de la lecture pour les loisirs. En revanche, il semblerait que la parité se retrouve, au niveau Suisse, pour la lecture d’e-books pour les loisirs.

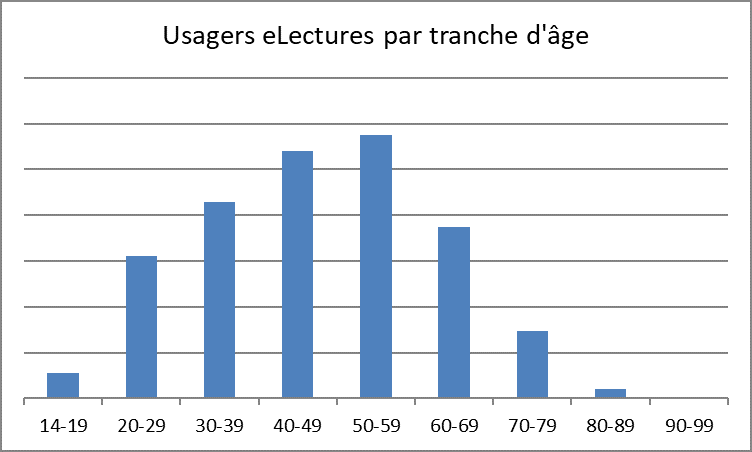

Selon l’âge : comme le montre le graphique ci-dessous, toutes les tranches d’âge sont représentées, avec une prédominance des quadragénaires et quinquagénaires. Assez réjouissante, la présence des trentenaires en troisième position, soit un public moins présent physiquement dans les bibliothèques. A titre de comparaison, les données de l’OFS (2017) montrent que les 30-44 ans sont de plus grands amateurs d’e-books. Pour l’anecdote, le lecteur « jeune depuis le plus longtemps » est né en 1925.

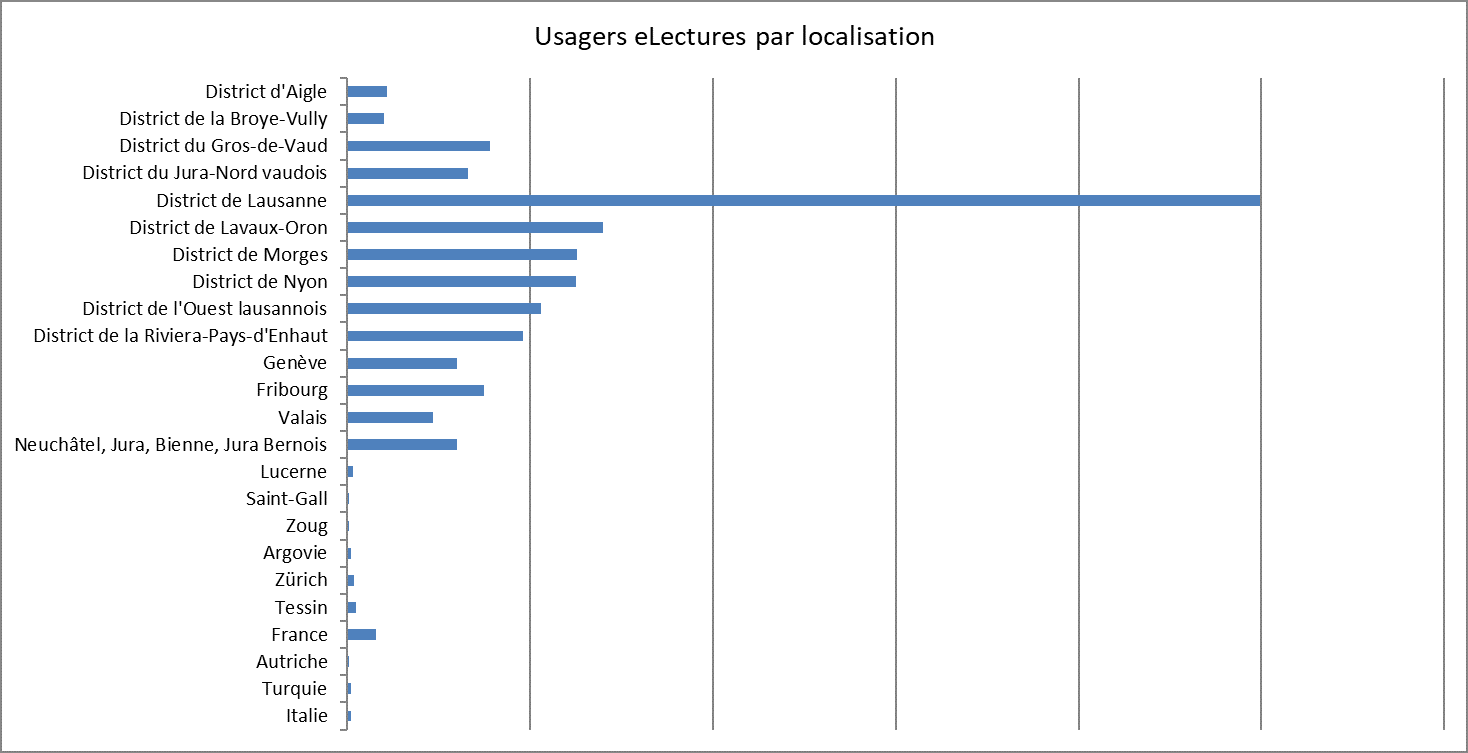

Selon le lieu : Un objectif initial était de toucher tout le canton. Force est de constater que l’utilisation pour l’instant reste bien concentrée sur les agglomérations vaudoises. Cela va dans le sens de l’enquête de l’OFS 2014 citée plus haut qui souligne que la plupart des activités culturelles sont pratiquées plutôt par des citadins et les habitants d’une agglomération.

Comme on peut le lire dans le graphique, la grande majorité des utilisateurs de la plateforme habite dans le district de Lausanne (46% des usagers « vaudois »). Les habitants du canton de Vaud représentent à eux seuls 82% des usagers de eLectures, les 18% restants étant composés d’autres cantons romands (16%), des cantons alémaniques et du Tessin (1%) et de l’étranger.

eLectures, produit de substitution ou gain de nouveaux lecteurs ?

Proposer une offre numérique apparaît pour de nombreuses bibliothèques comme un choix stratégique. La bibliothèque évolue, ses services aussi. Si l’on souhaite rester en phase, les bibliothèques doivent s’adapter. On est également dans une démarche de diversification des prestations offertes et des publics.

Il reste néanmoins très difficile de définir de manière précise si une telle offre est, au niveau du lectorat, plutôt un produit de substitution ou une opportunité d’attirer un nouveau lectorat et de renouveler les publics. C’est sans aucun doute un peu des deux.

Dans une bibliothèque comme la nôtre, le nombre de lecteurs actifs (c’est-à-dire qui emprunte physiquement au moins un document dans le cours d’une année civile) est stable. Cela signifie un équilibre entre ceux qui cessent d’emprunter, et les nouveaux lecteurs qui s’inscrivent. C’est un processus normal, surtout dans le cadre d’une bibliothèque qui touche des apprenants (gymnasiens, étudiants à l’UNIL) qui sont mobiles une fois leur formation terminée.

Même si le nombre de prêts effectués sur la plateforme eLectures est tout à fait satisfaisant, on ne peut pas dire qu’il y ait une percée au niveau des statistiques d’emprunts. On ne peut pas non plus lire dans les statistiques de prêts de documents physiques s’il y a substitution ou non. Il y a de toute façon une limite à ce que qu’un individu peut lire en un mois, même en étant un grand lecteur. Ce que l’on peut constater, c’est qu’une partie du public d’eLectures emprunte également des documents physiques sur nos sites. Certains se sont mis au numérique quand ils ont vu par exemple que le Prix Goncourt 2016 était disponible tout de suite en numérique et sans file d’attente...

A-t-on gagné des nouveaux lecteurs grâce à eLectures ? Oui clairement. Ce n’est pas chiffrable car certains sont venus s’inscrire sur place sans mentionner qu’ils s’intéressaient à eLectures. Cependant de nombreuses personnes nous ont contactés, parfois de loin, en nous disant s’inscrire pour le numérique uniquement.

Relations avec les fournisseurs

Fonctionnement quotidien de la plateforme et réponses du support technique

Les relations avec notre fournisseur se limitent surtout au support qu’il offre en cas de problèmes. Les acquisitions et les renouvellements d’abonnement (à la plateforme) sont des processus bien rodés qui se déroulent efficacement. En revanche, le support technique (c’est-à-dire, en cas de problème avec un appareil ou à l’ouverture d’un fichier), constitue le principal point faible de notre fournisseur et ce pour trois raisons principales.

La première, et la plus importante, est l’absence d’un interlocuteur clair et identifié. Dès lors, en cas de problème, nous envoyons, telle une bouteille à la mer, un e-mail à une adresse générique qui fait preuve de bien peu de réactivité. Le fournisseur répond à ce problème que la messagerie est bien relevée, qu’ils traitent la question, sans nécessairement répondre à l’interlocuteur qui l’a soulevé. La solution consiste donc à tester régulièrement pour savoir si oui ou non le problème est résolu.

La seconde raison est le manque de communication de notre fournisseur envers ses clients. Par exemple, lorsqu’un éditeur décide, pour les nouveaux titres, de réduire le nombre de prêts simultanés de ses documents nous n’en sommes pas informés. Cette problématique est réelle pour les acquéreurs qui découvrent alors qu’il faut acheter davantage d’« exemplaires » pour pallier le changement de pratique de l’éditeur mais rendre cela transparent pour l’usager ; la volonté étant de conserver un niveau de service équivalent.

La troisième raison est que les problématiques remontées ne concernent en général pas directement l’offre ou sa mise à disposition sur la plateforme. Pour preuve, les deux problèmes principaux rencontrés en 2017 ne relevaient pas de Cantook Station. Le premier problème est apparu avec la mise à jour 10.3.1 du système d’exploitation iOS d’Apple. En effet, le code comportait une erreur qui empêchait l’ouverture des fichiers avec les applications de lecture Bluefire Reader et Aldiko sur iOS (iPhone et iPad). Le second qui consistait en un message d’erreur incompréhensible à l’ouverture des livres résultait du fait que certains distributeurs de livres numériques transmettaient des fichiers qui contenaient des erreurs de validité au niveau du verrou numérique.

A la décharge de notre fournisseur, la qualité du support est aussi en lien avec sa position. En effet, celui-ci est toujours « entre deux feux » : il distribue des documents qu’il n’a pas générés (donc il n’a pas la main sur leur qualité) et les met à disposition sur des appareils qu’il ne développe pas (iPad, liseuses…). Là encore, il est tributaire des développements de ces sociétés.

Avantages et inconvénients de l’externalisation pour la BCUL

Le choix d’un service hébergé en local ou dans le cloud est d’ordre institutionnel. Il y a des avantages et des inconvénients aux deux solutions mais ce n’est pas le propos de l’article. Ainsi, nous vous proposons de détailler ici les avantages et inconvénients de la solution choisie, c’est-à-dire celle de l’hébergement à distance.

Tout d’abord, nous avons accès à un catalogue déjà constitué, dont l’ensemble des négociations avait été effectué par le diffuseur. Cette offre initiale évolue constamment, que ce soit avec l’intégration de nouveaux éditeurs ou par l’enrichissement d’une collection déjà existante. Ce dernier est le fruit du travail direct de notre distributeur, travail de négociation et de médiation pour lequel nous ne sommes pas qualifiés. La délégation de la négociation trouve toutefois ses limites et notamment pour de petits éditeurs locaux, peu représentatifs du besoin de l’ensemble des clients et pourtant tellement précieux pour les usagers des bibliothèques locales.

La souscription à une plateforme externe permet aussi de bénéficier du travail de tous les clients précédents et notamment des demandes d’amélioration qu’ils ont effectuées. Un des gros points forts de l’offre mise à disposition est l’aide, extrêmement complète et très bien structurée qui nous permet de minimiser les explications par e-mail avec nos lecteurs en renvoyant vers celle-ci.

Les autres clients sont donc un atout pour faire évoluer ce type d’offre car les besoins sont sensiblement les mêmes (contrairement à un SIGB par exemple où chaque bibliothèque a ses exigences particulières). En revanche, dès que l’on souhaite des développements spécifiques (ex. ajout de statistiques), le fait d’avoir un besoin « hors norme » par rapport aux autres clients est une réelle faiblesse et les chances de voir le développement aboutir sont minces.

Enfin, la BCUL aurait aimé pouvoir mettre à disposition ses livres numériques dans son catalogue de « livres papiers » et permettre ainsi aux lecteurs de découvrir cette offre. Malheureusement, et malgré l’utilisation de protocoles standards par les deux outils, cela reste, pour l’instant, une volonté non aboutie. Nous allons travailler avec nos fournisseurs, ExLibris et Cantook, afin de pouvoir offrir cette amélioration à nos lecteurs.

Perspectives d’avenir

Pérenniser notre fonction de médiation

La médiation autour de l’offre de livres numériques est indispensable, d’une part parce que ceux-ci sont peu, voire pas visibles dans l’espace physique de la bibliothèque (et difficiles à rendre visibles) et, d’autre part, parce que l’aspect technique peut rebuter certains usagers peu à l’aise avec ces questions, mais pour qui le numérique apporte des avantages certains (ex. grossissement des caractères, pour ne citer qu’un aspect).

La plupart des bibliothèques le remarquent : le numérique ne fonctionne pas tout seul. Florent Dufaux fait le même constat (Dufaux, 2016) pour l’expérience de Labo-Cités à Genève.

En présentiel, aux guichets du site Riponne, on observe déjà un déplacement du type de questions posées par les usagers : de plus en plus sont en lien avec les équipements techniques (wifi, impression, internet, bureautique). Ainsi, si on propose une offre comprenant une part technique importante on doit l’accompagner et avoir des bibliothécaires prêts à y répondre et cela même si la foire aux questions (FAQ) est bien construite. Une partie du lectorat numérique est autonome ou le devient, mais, on l’a vu, ce n’est pas le cas de tous. Chaque mois de nouveaux lecteurs découvrent eLectures. Nous continuerons donc de proposer cette fonction de médiation sur la durée.

S’adresser à toute la population vaudoise

Une telle offre numérique est une formidable opportunité pour notre institution de se rapprocher de son public principal : l’ensemble de la population vaudoise. Alors que les institutions culturelles vaudoises sont encore concentrées dans l’agglomération lausannoise, eLectures est un médium qui permet de faire connaître la BCU Lausanne dans tout le Canton en proposant un offre accessible à l’ensemble de ses habitants. Le bouche-à-oreille prenant le relais, dans un second temps, de la promotion institutionnelle.

Pour l’équipe en charge de ce projet, on peut avancer qu’eLectures sera une vraie réussite lorsque, en plus d’une utilisation importante et régulière, les proportions d’usagers provenant des différents districts du Canton seront équilibrées.

Continuer à promouvoir eLectures

Un service de ce type-là doit rester vivant. La réalité des licences des livres numériques implique une vie active de cette « collection ». Alors que les collections physiques de la BCU Lausanne ont un taux de rotation annuel de 7% [7], il est évidemment ni intéressant ni rentable financièrement qu’un tel taux se retrouve sur une plateforme de prêt de livres numériques. Actuellement, le fonds eLectures est à plus de 100% de taux de rotation (chiffres de juillet 2016 à juin 2017).

Mais cela n’est possible que si la promotion d’eLectures se fait de manière continuelle à travers la communication institutionnelle ou une mise en valeur par l’intégration de ces documents dans notre outil de découverte public. Actuellement, cette solution n’a pas pu être mise en place à la BCU Lausanne mais ce travail de moissonnage de nos livres électroniques est en cours avec De Marque (via le protocole OPDS). La mise à disposition de l’offre eLectures via l’interface publique procure une visibilité sans égale et augmentera le public touché par celle-ci.

La promotion passe également par l’animation de la plateforme avec des sélections régulières liées à l’actualité de la BCU Lausanne ou du monde ou par la rédaction de nos « Bouche-à-oreille », coups de cœur des bibliothécaires imprimés traditionnellement sur des signets, qui se voient ici offrir une nouvelle vie numérique.

Bref, la promotion d’eLectures doit être envisagée comme un continuum, année après année, et surtout, budget après budget.

Utilisation des réseaux sociaux

Qui dit numérique, dit réseaux sociaux, la BCUL est présente sur différentes plateformes mais principalement Twitter et Facebook [8]. Etant donné que la charge de faire vivre ces comptes est répartie sur une multitude de collaborateurs, nous avons facilement la possibilité de promouvoir une sélection de documents, un titre en particulier faisant écho à l’actualité ou de donner des informations pratiques sur le service. Il est cependant difficile d’évaluer l’impact de ce mode de communication sur les emprunts de e-books. Cela dit nous partons du principe que plus le nom du service circule, plus il y a de chance que l’effet « bouche à oreille » atteigne son public.

Nous savons par contre que des pics d’emprunts suivent de quelques heures l’envoi de la newsletter institutionnelle à tous nos usagers actifs. Cette dernière contient systématiquement au moins deux « avis du bibliothécaire » sur des documents de nos collections avec un lien, via notre blog, vers eLectures si nous en proposons une version numérique. Si on considère qu’entre juin 2015 et mai 2017, nous mesurions en moyenne 37 prêts par jour, cet indicateur pouvait monter à 60 ou 70 dans les jours qui suivaient l’envoi d’une newsletter.

Comme on l’a déjà souligné lorsque nous traitions de la médiation, un service numérique de ce type ne peut pas vivre tout seul et il est difficile de le rendre visible aux usagers. Les tentatives de promotion dans nos locaux par différents moyens aident à faire connaître l’offre mais il y a toujours une étape difficile à franchir : celle de convertir un usager potentiel se trouvant dans la bibliothèque en usager actif sur le net. La présence sur les réseaux sociaux est donc importante pour créer des liens vers la plateforme, la faire connaître et continuer d’attirer un public distant.