N°21 décembre 2020

Sommaire - N° 21, Décembre 2020

Visions d'ailleurs :

-

Apprendre « en commun » : L’expérience des ateliers de contribution à Wikipédia dans les bibliothèques publiques de Montréal - Marie D. Martel

Études et recherche :

- Formation en gestion des données de recherche: propositions de dispositifs d’e-learning pour le projet DLCM - Marielle Guirlet, Manuela Bezzi, Manon Bari

- The Knowledge & Learning Commons – a library’s evolution driving cultural change at the United Nations in Geneva - Viviane Brunne, Sigrun Habermann

- La place des ressources documentaires des bibliothèques académiques dans la lutte contre les Fake News. Le cas du COVID-19 - Benoît Epron, Séverine Gaudard

- Les bibliothèques face à la vague - Florence Burgy, Benoît Epron

Comptes-rendus d'événements :

- A review of the Swiss Research Data Day 2020 (SRDD2020): 48 experts shared their experiences on emergent approaches in Open Science - Pierre-Yves Burgi, Lydie Echernier

- Conférence annuelle LIBER 2020 online : compte rendu d’évènement - Piergiuseppe Esposito

Recensions :

Editorial n° 21

Editorial n°21

C’est un vingt-et-unième numéro riche en contributions de recherche que nous avons le plaisir de vous présenter.

Ce numéro comporte une innovation de taille : la rubrique Visions d’ailleurs.

Cette rubrique consiste à donner un aperçu des préoccupations, des pratiques et des sujets de recherche de spécialistes en sciences de l’information en dehors des frontières de la Suisse, et constitue ainsi un témoignage sur une expérience, une recherche ou encore un point de vue spécifique depuis l’étranger.

Le comité de rédaction a en effet pensé que cela pouvait constituer un apport instructif et complémentaire pour les lecteurs de RESSI et susciter des idées et échanges fructueux.

Cette rubrique est inaugurée par Marie Martel, professeure adjointe à l’EBSI de Montréal. Son article intitulé « Apprendre en commun : l’expérience des ateliers de contribution à Wikipedia dans les bibliothèques publiques de Montréal » relate une expérience très intéressante du rôle possible des bibliothèques au service de l’inclusion numérique, en l‘occurrence dans la réalisation et conduite des ateliers de contribution à Wikipedia, et en démontre les limites et les impacts.

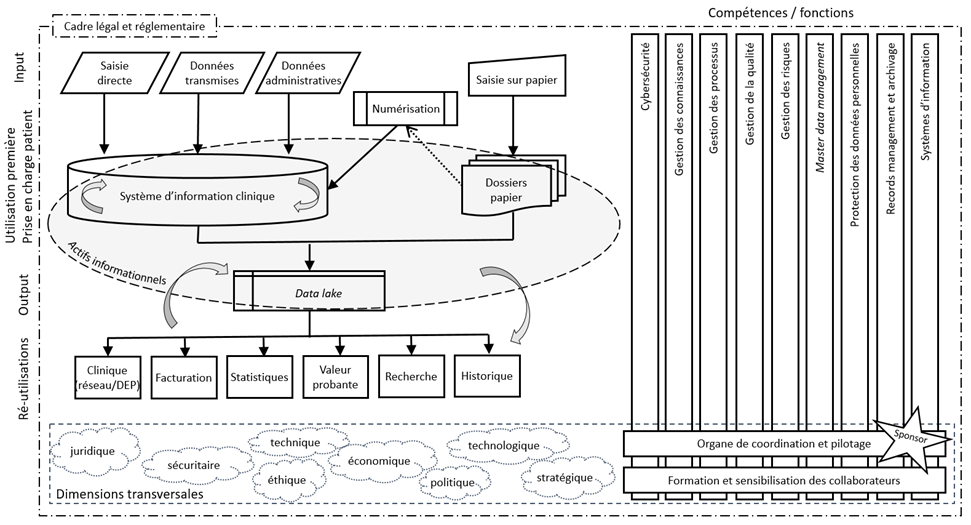

Dans la rubrique Etudes et Recherches, vous trouverez un premier article intitulé Données médicales et dossiers patients comme actifs informationnels : la gouvernance de l’information dans les hôpitaux universitaires suisses. Ecrit par Anna Hug Buffo, archiviste principale aux Hôpitaux Universitaires de Genève (HUG), l’article fait un état des lieux des composantes de la gouvernance de l’information dans les hôpitaux universitaires suisses et propose un schéma général des flux des données médicales et de leurs diverses réutilisations.

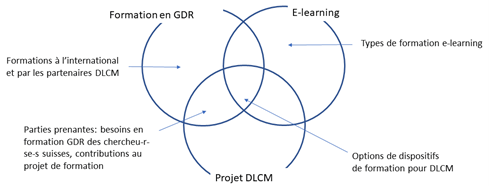

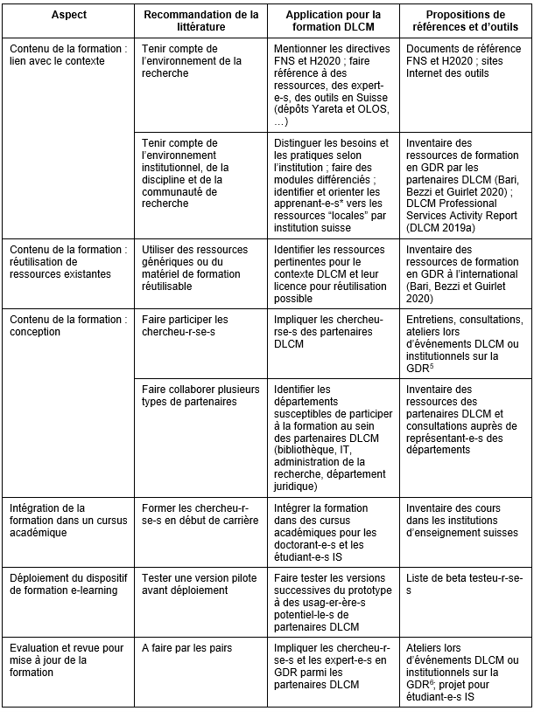

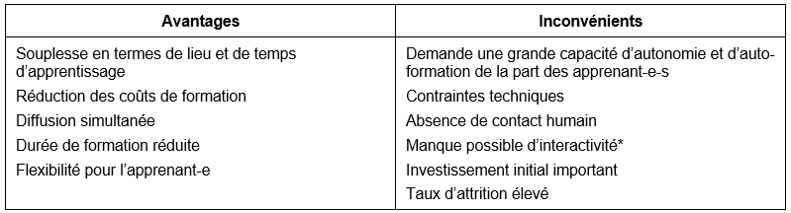

Une deuxième contribution, signée par Marielle Guirlet, Manuela Bezzi et Manon Bari, diplômées du Master en Sciences de l'Information HEG, HES-SO (2020) intitulée Formation en gestion des données de recherche: propositions de dispositifs d’e-learning pour le projet DLCM, donne des recommandations et des propositions d’options pour la conception d’un dispositif de formation d’e-learning en gestion des données de recherche.

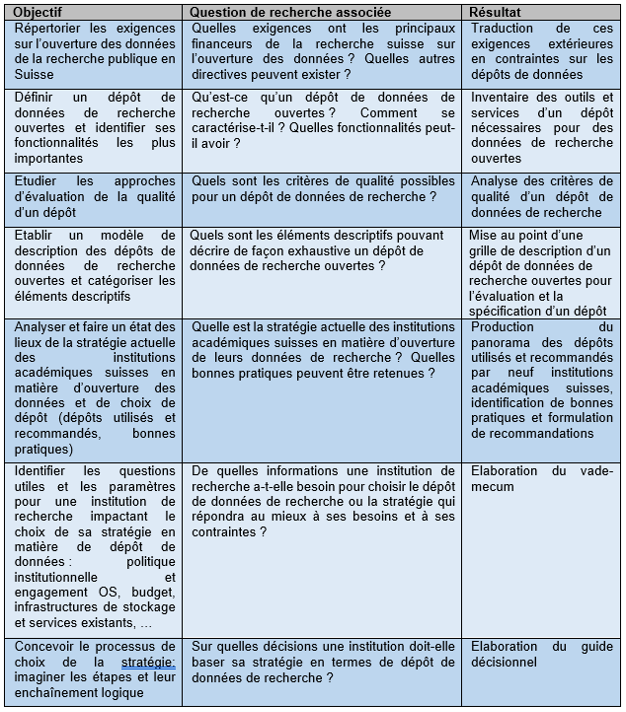

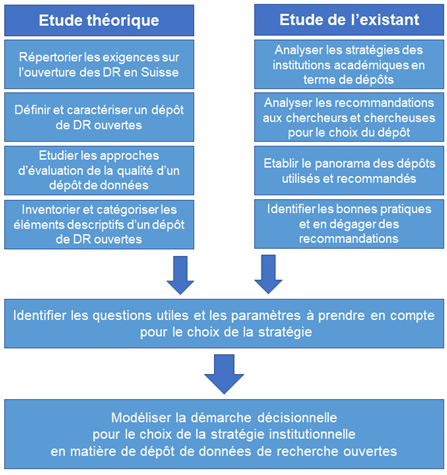

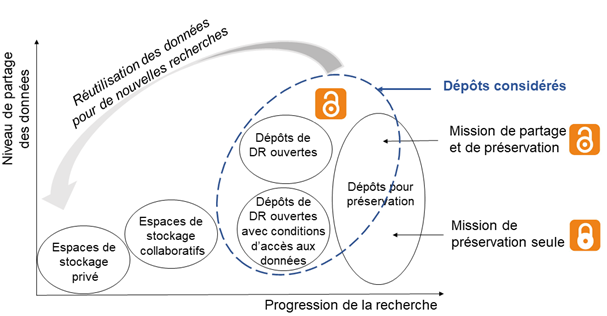

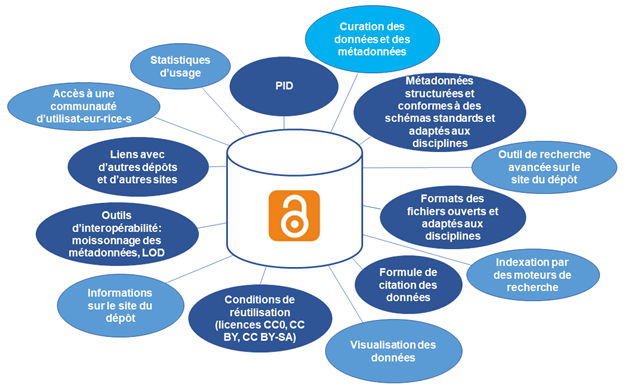

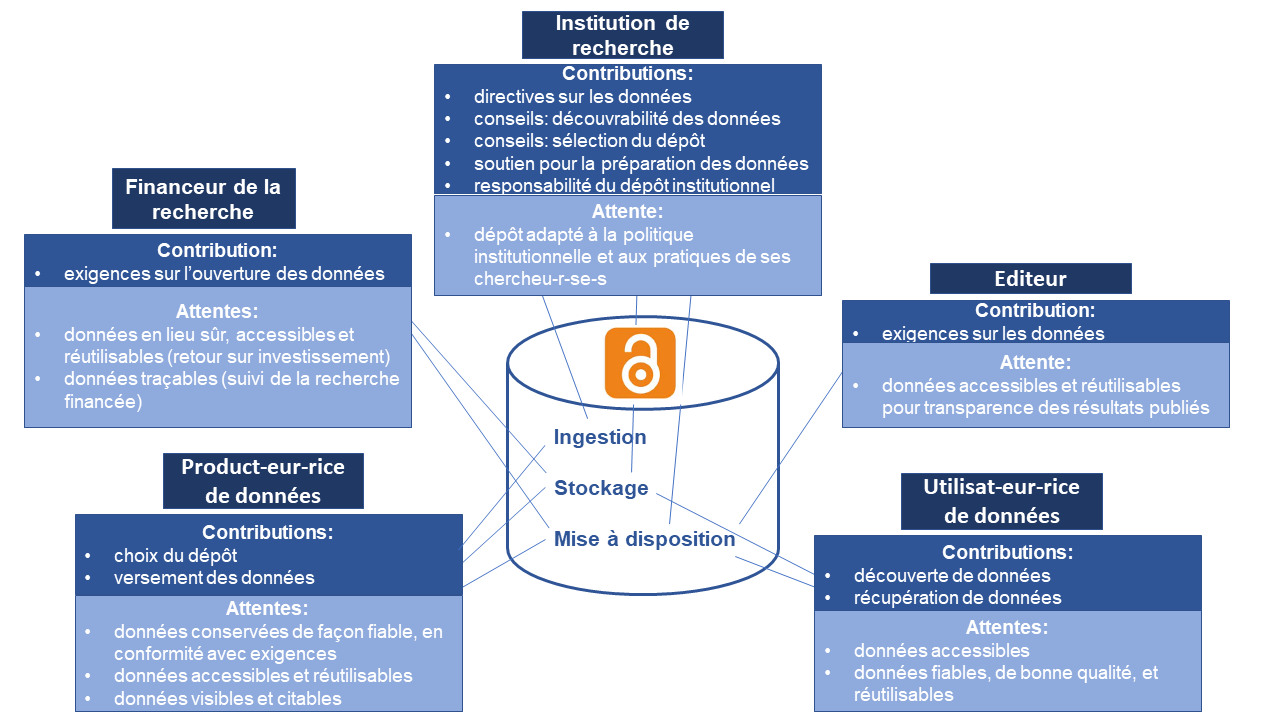

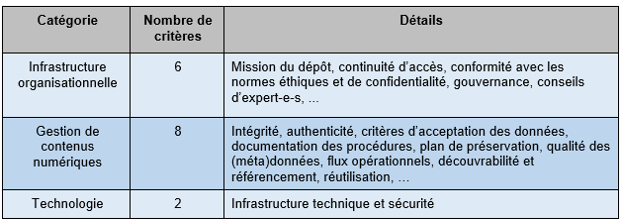

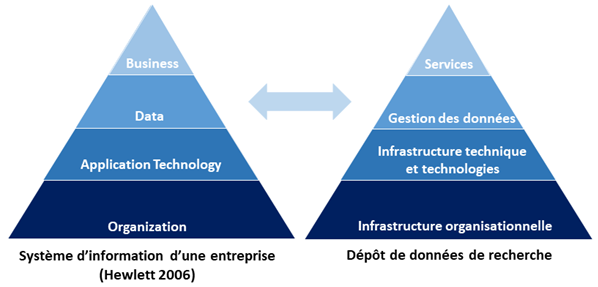

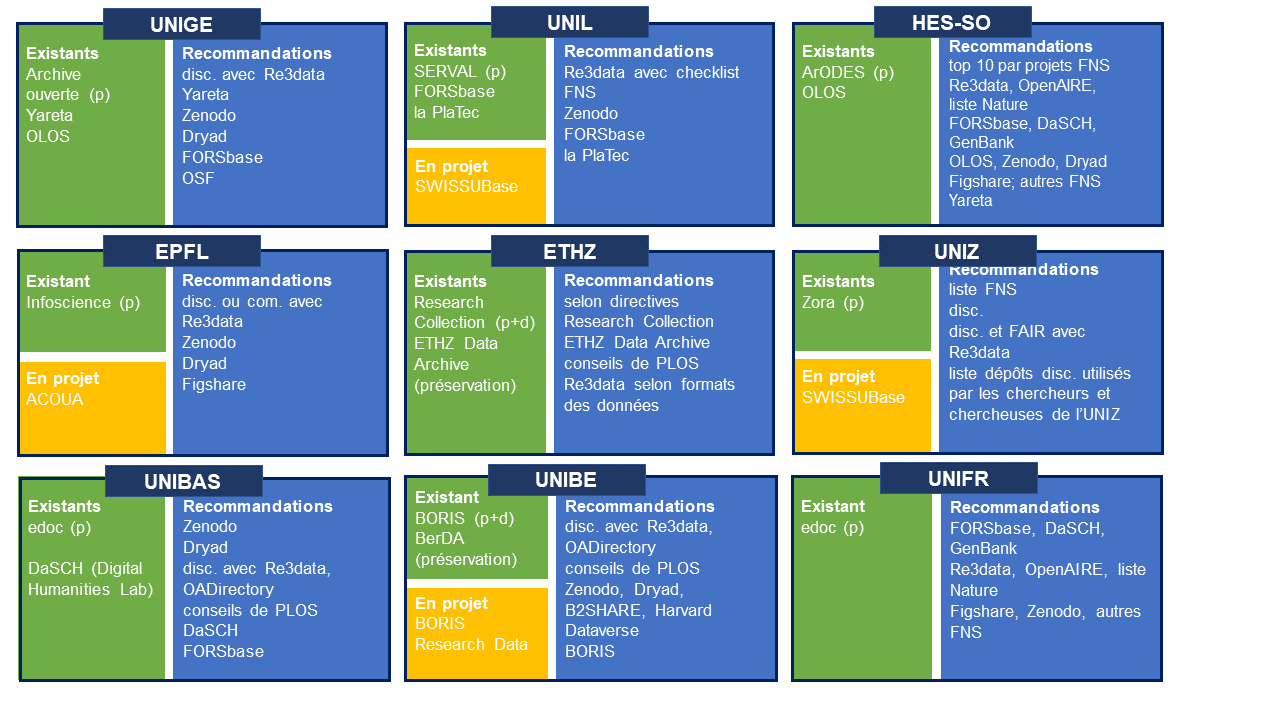

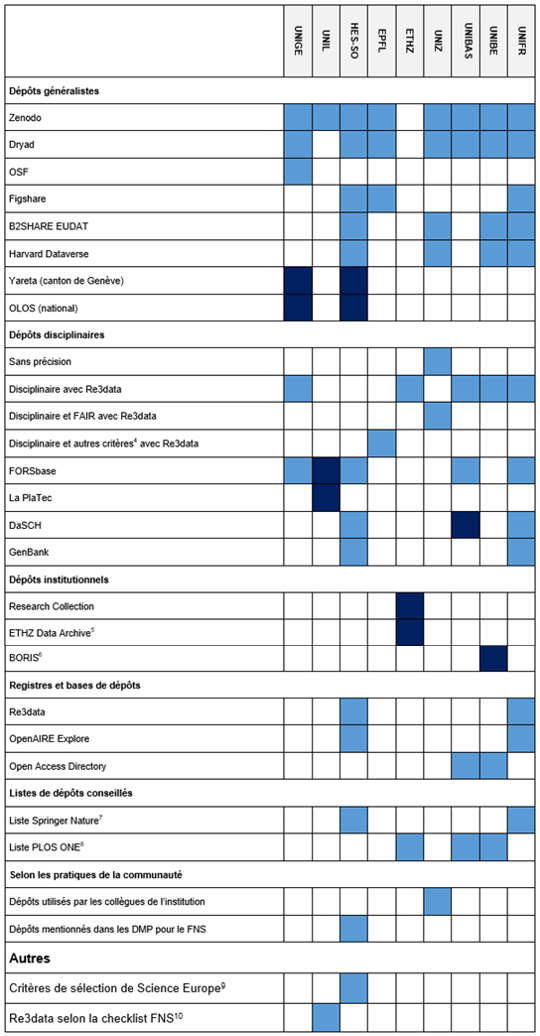

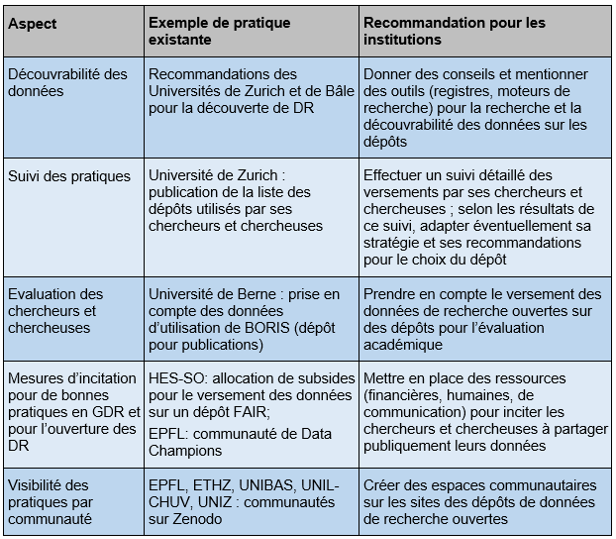

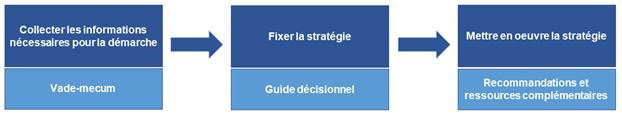

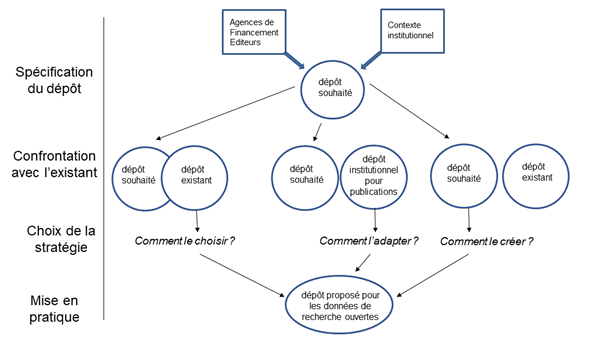

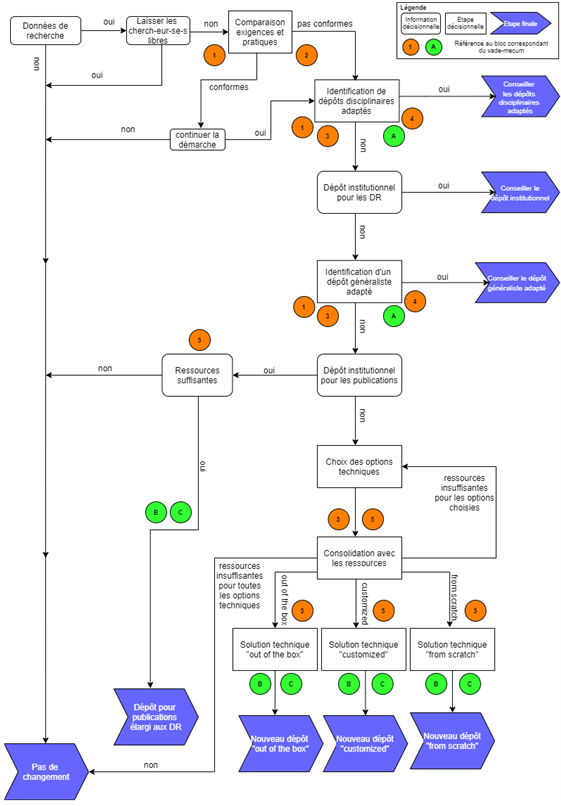

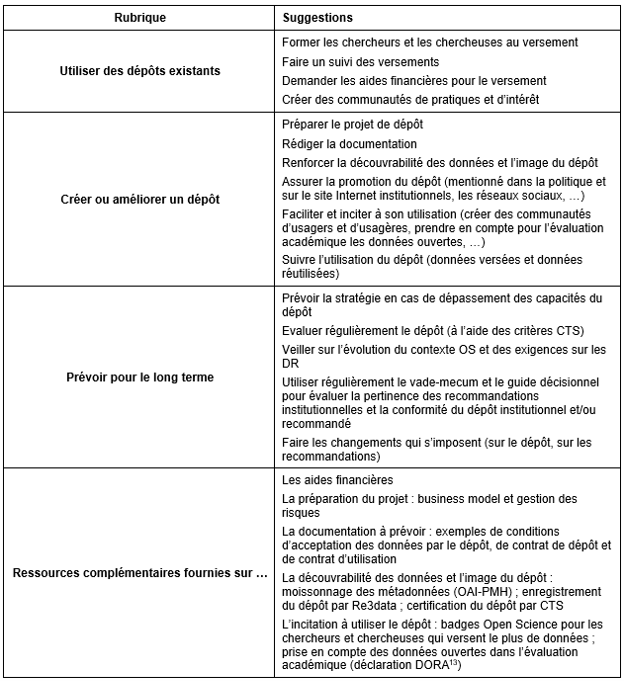

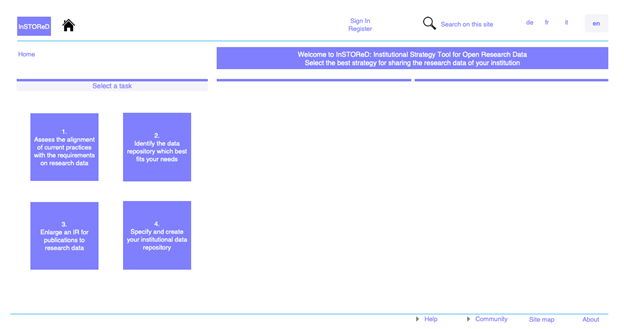

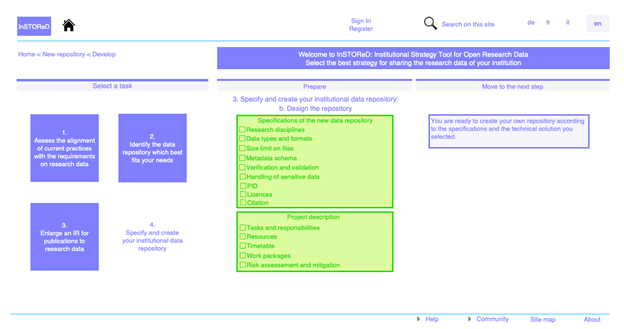

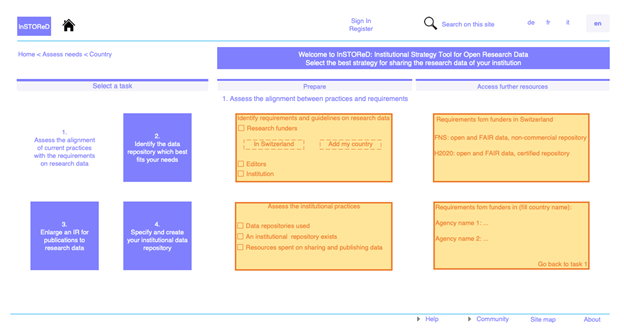

Une troisième contribution, signée également par Marielle Guirlet, co-auteure du précédent article, est intitulée Ouverture des données de recherche dans le domaine académique suisse : outils pour le choix d’une stratégie institutionnelle en matière de dépôt de données. L’article donne les informations nécessaires pour aider les institutions universitaires suisses à choisir leur stratégie de dépôt des données de recherche : soit orienter ses chercheurs et chercheuses vers un dépôt existant (et lequel) soit créer un nouveau dépôt, et il donne les spécifications que ce dépôt doit remplir.

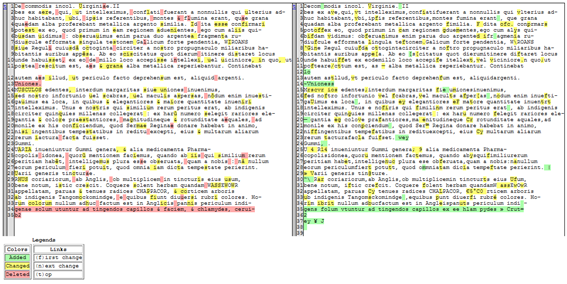

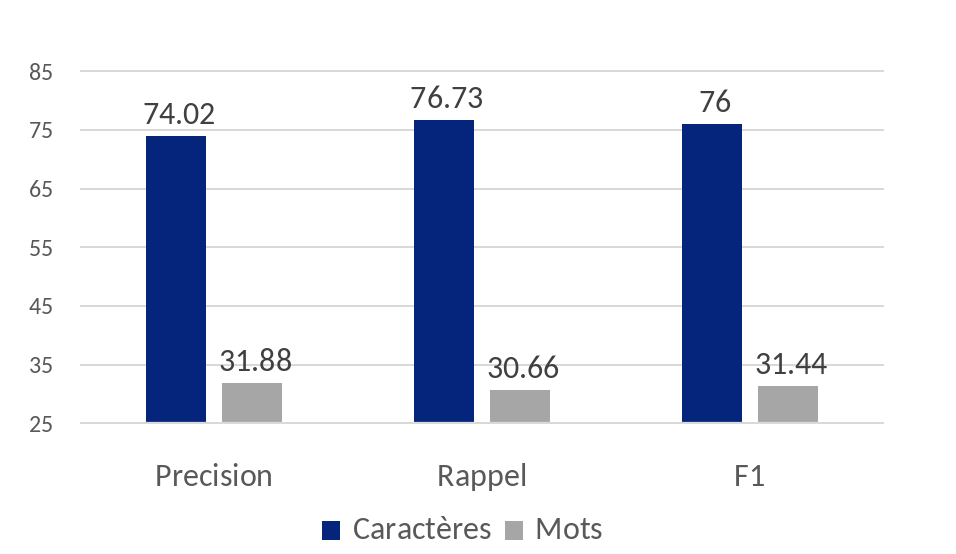

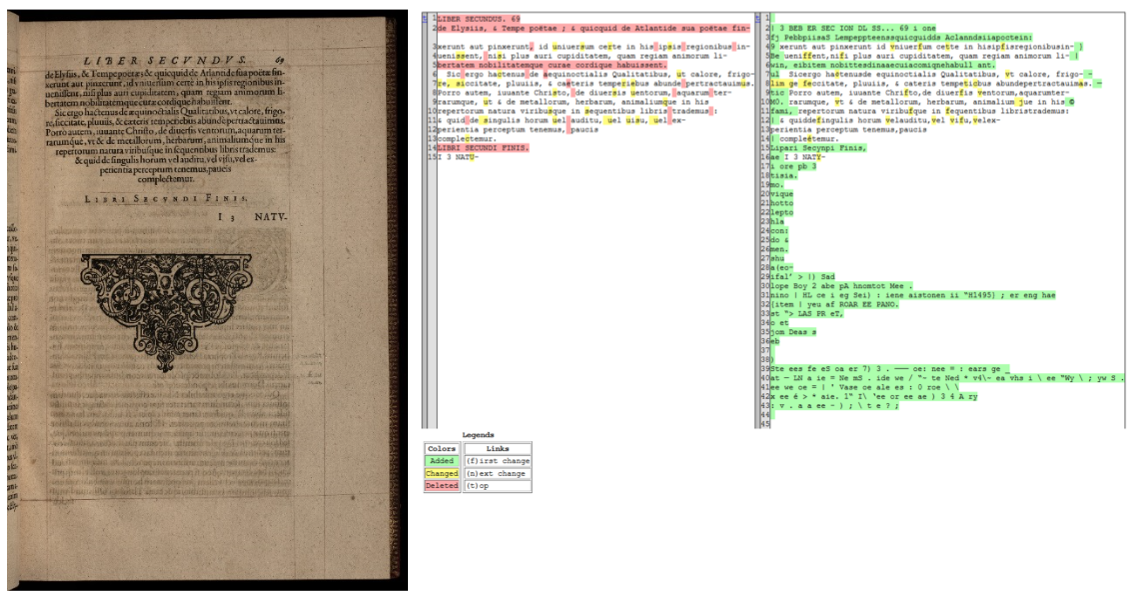

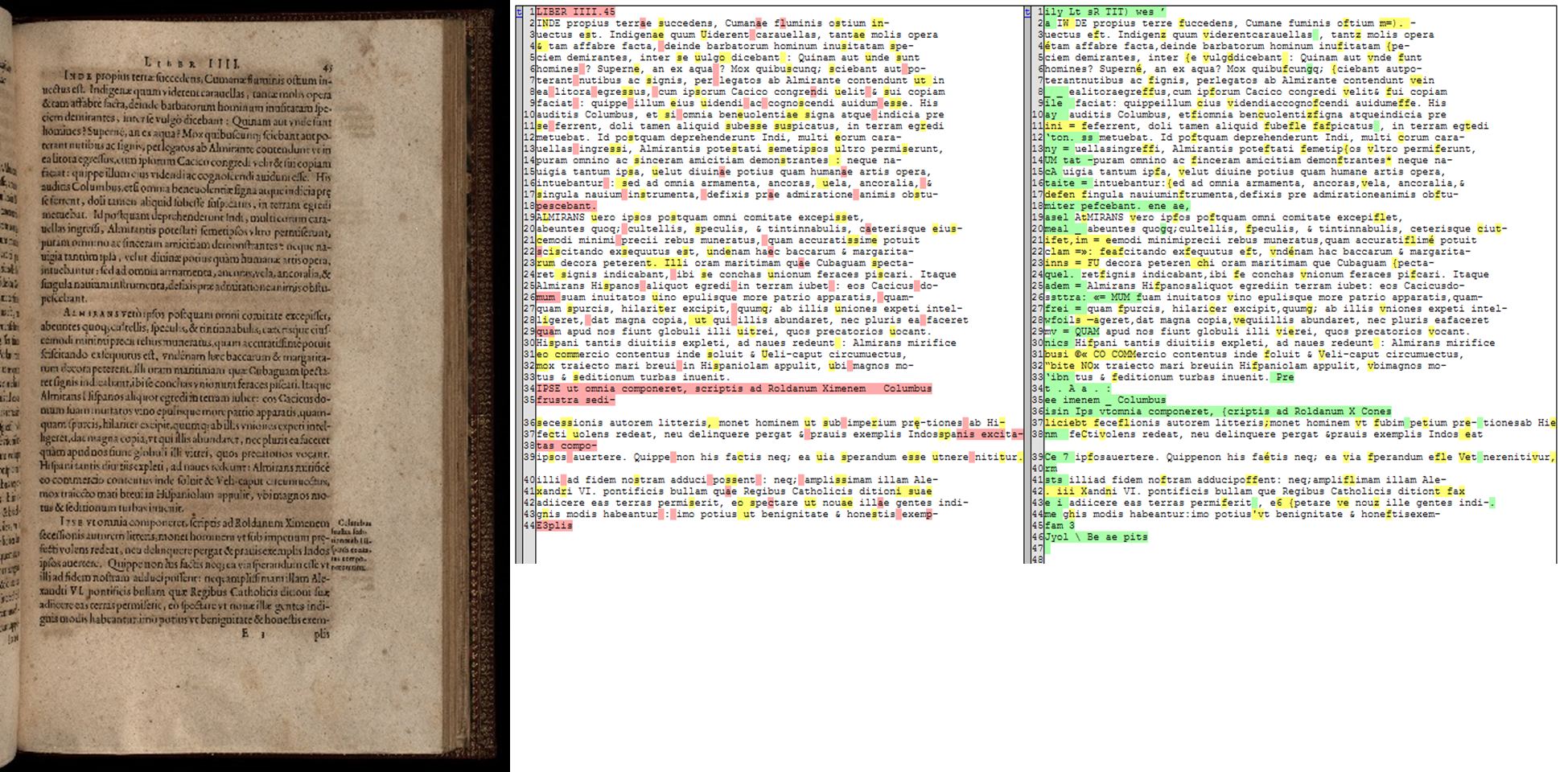

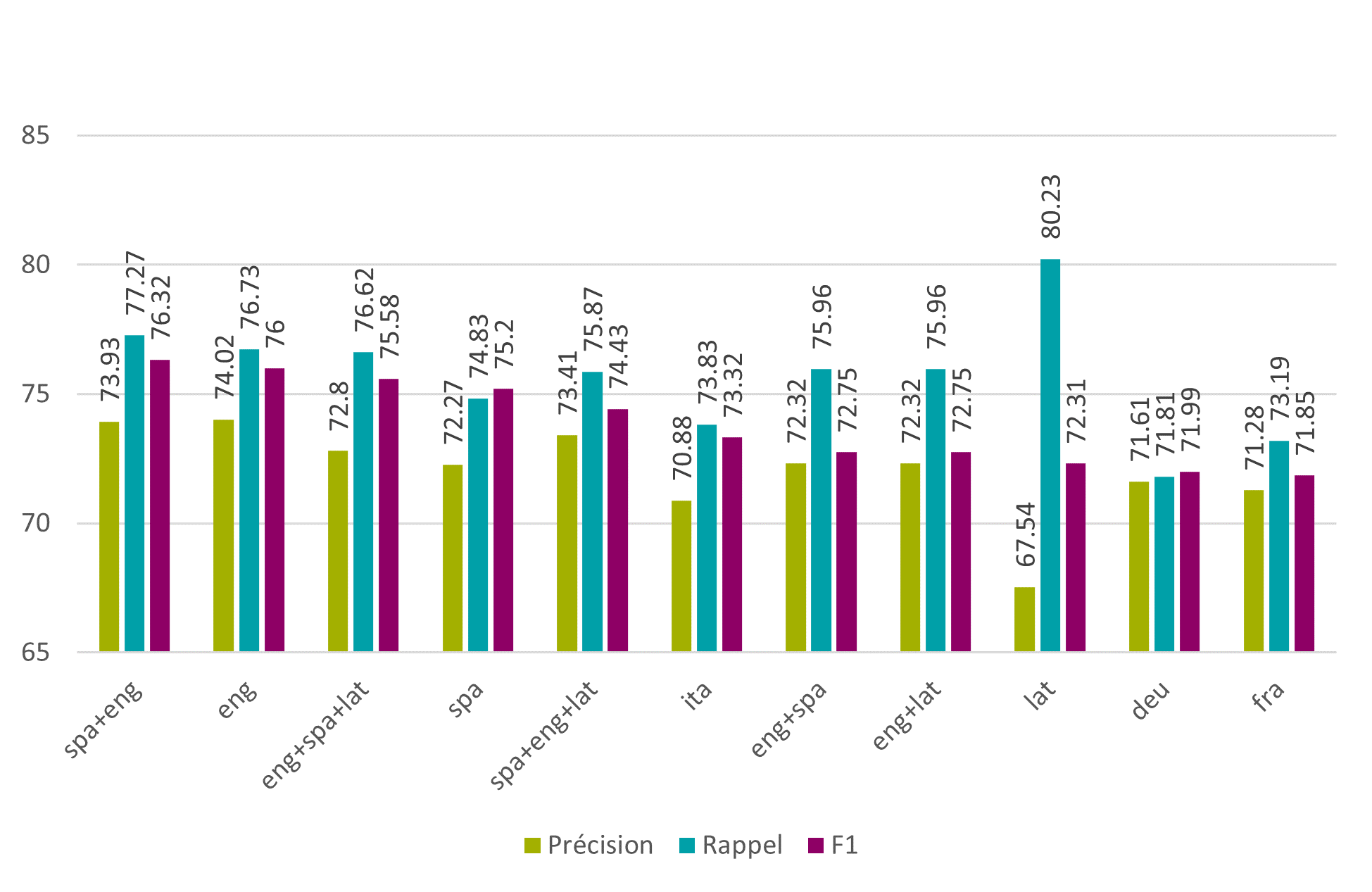

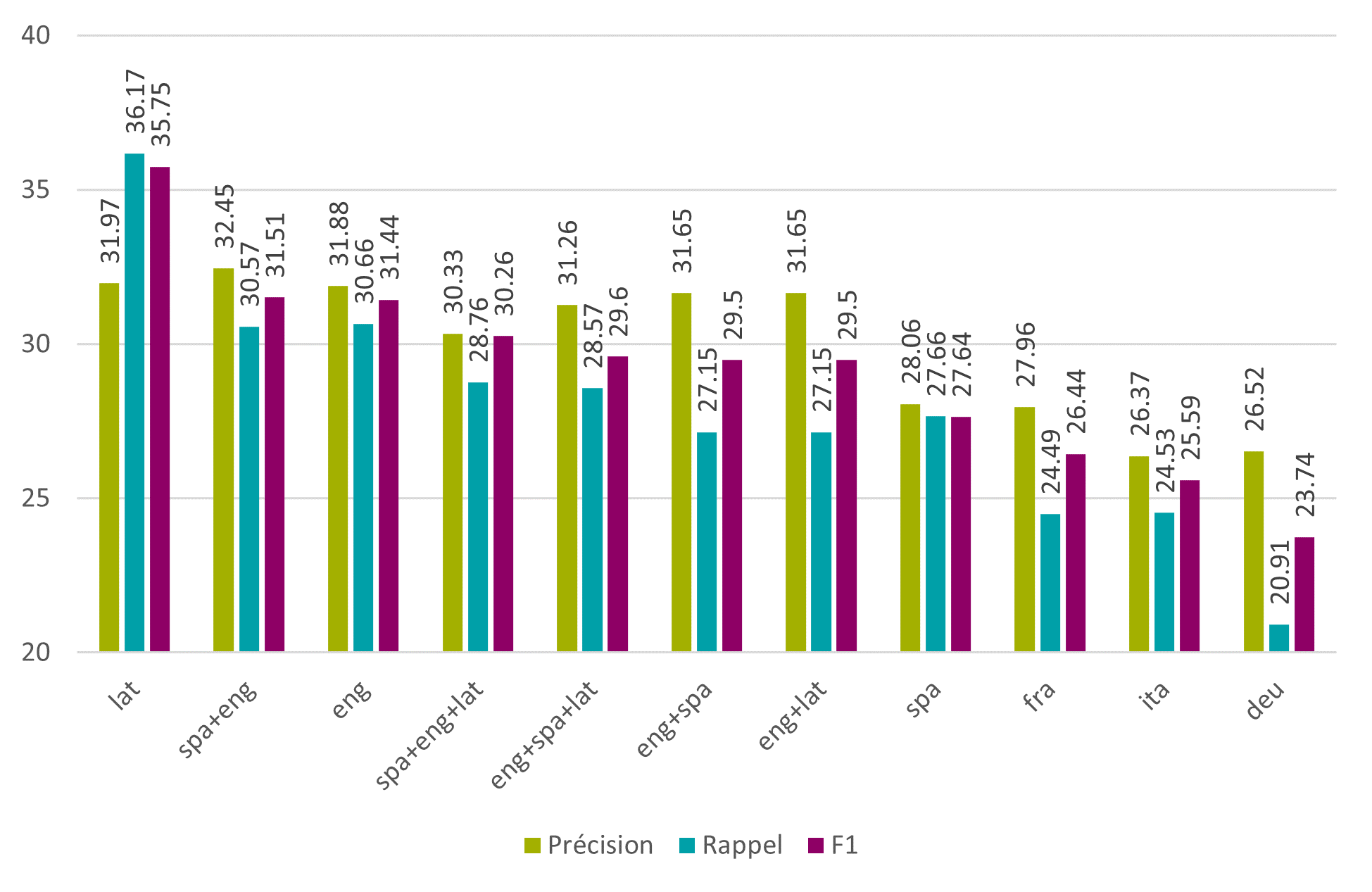

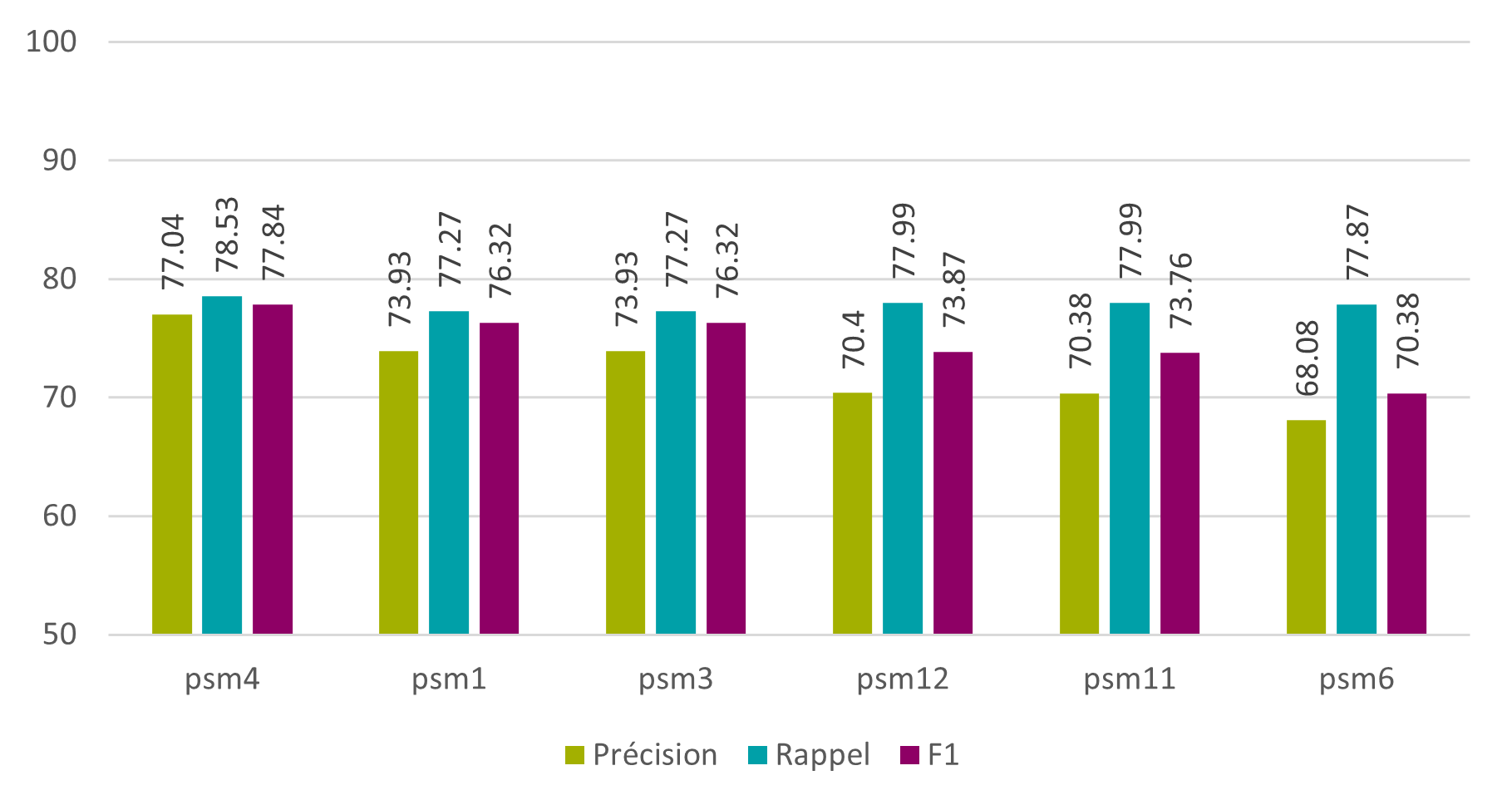

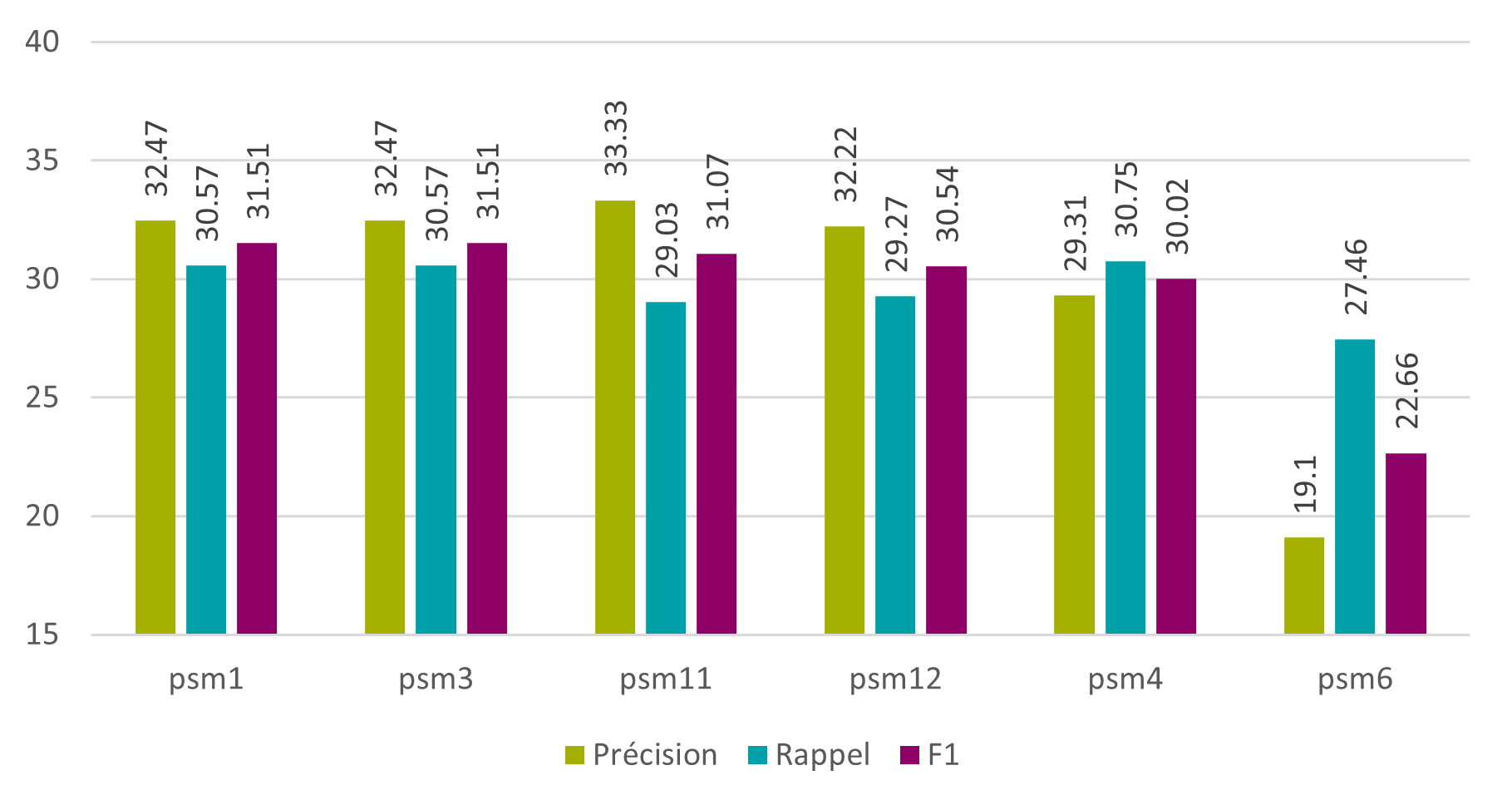

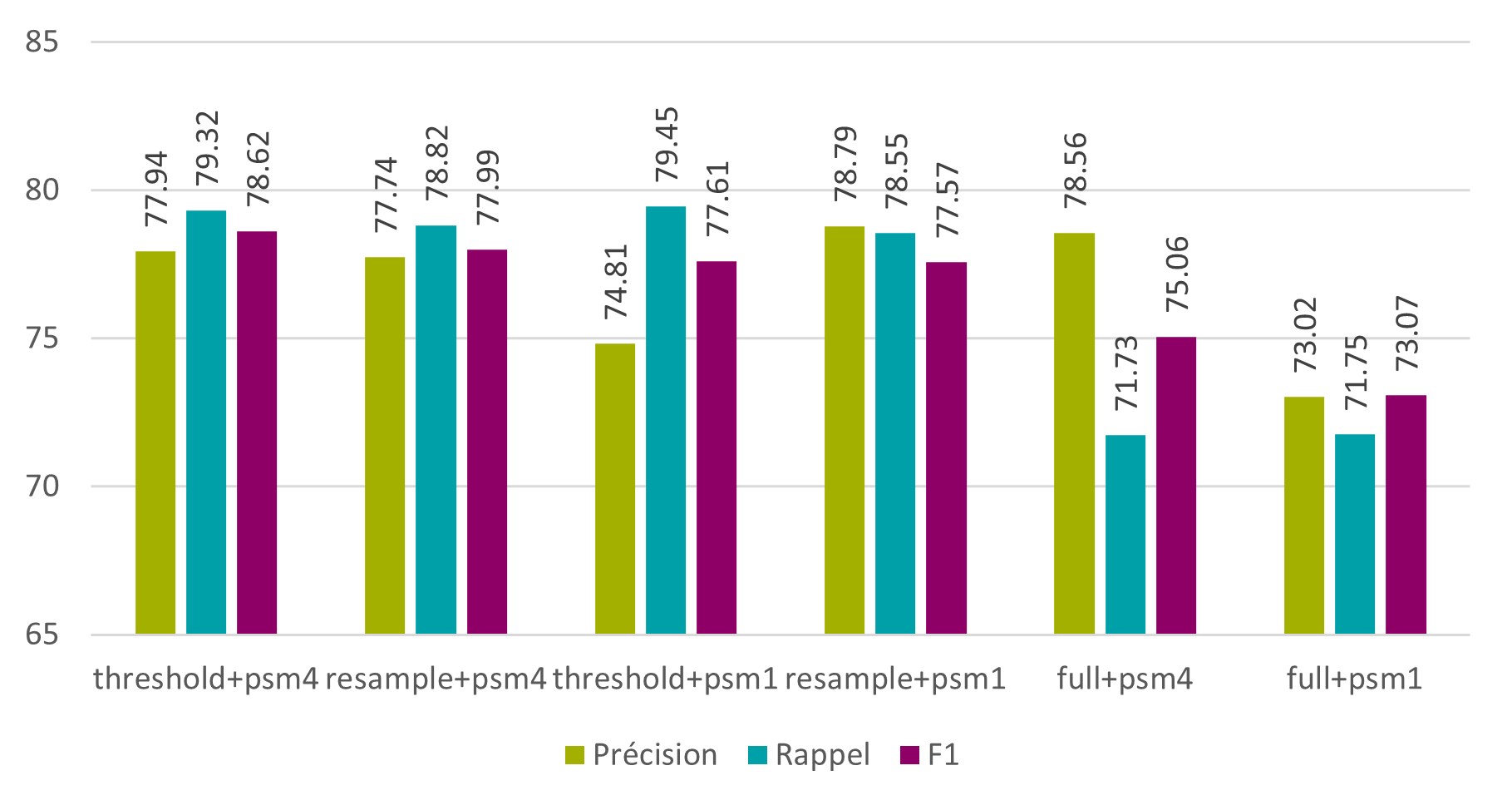

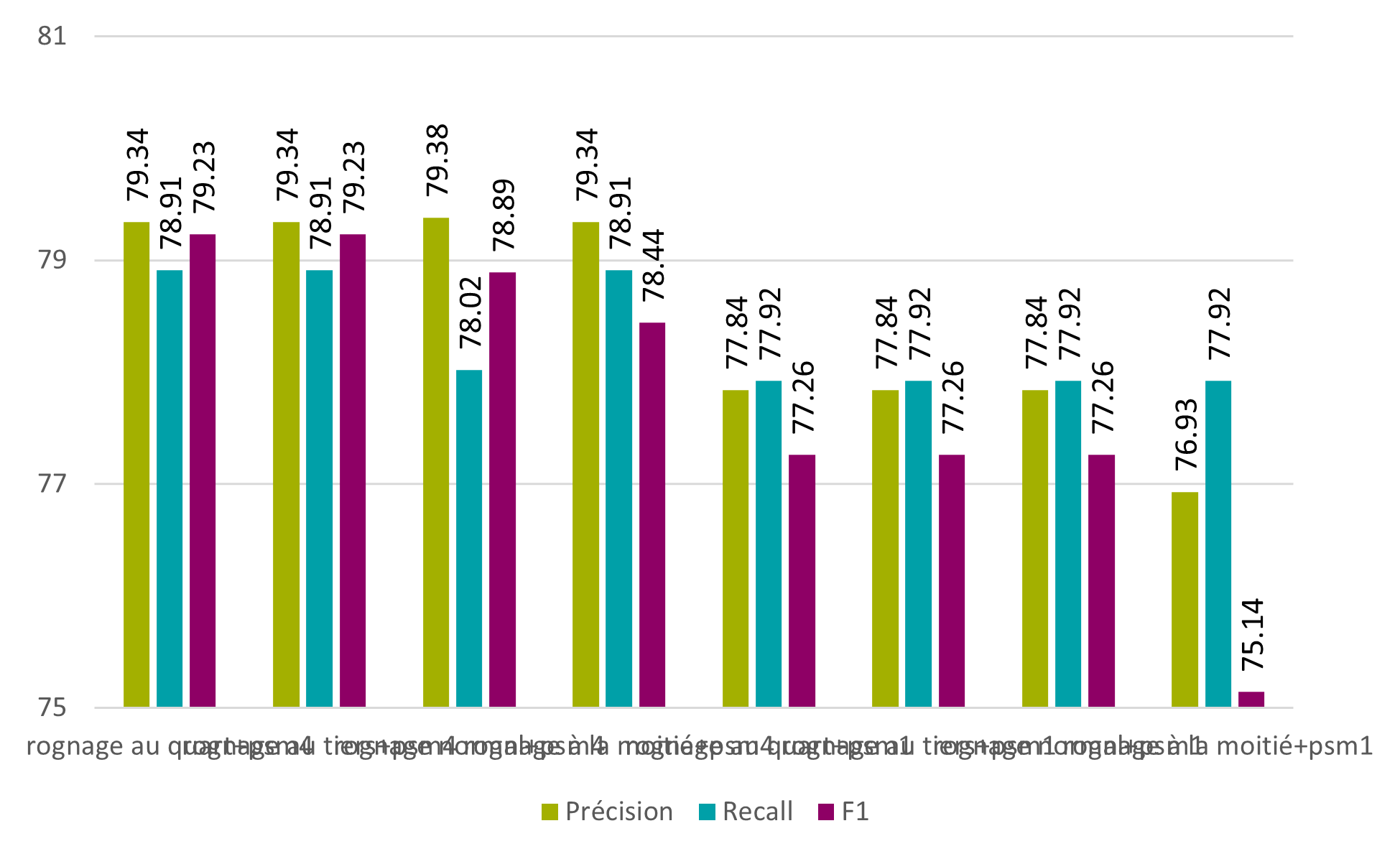

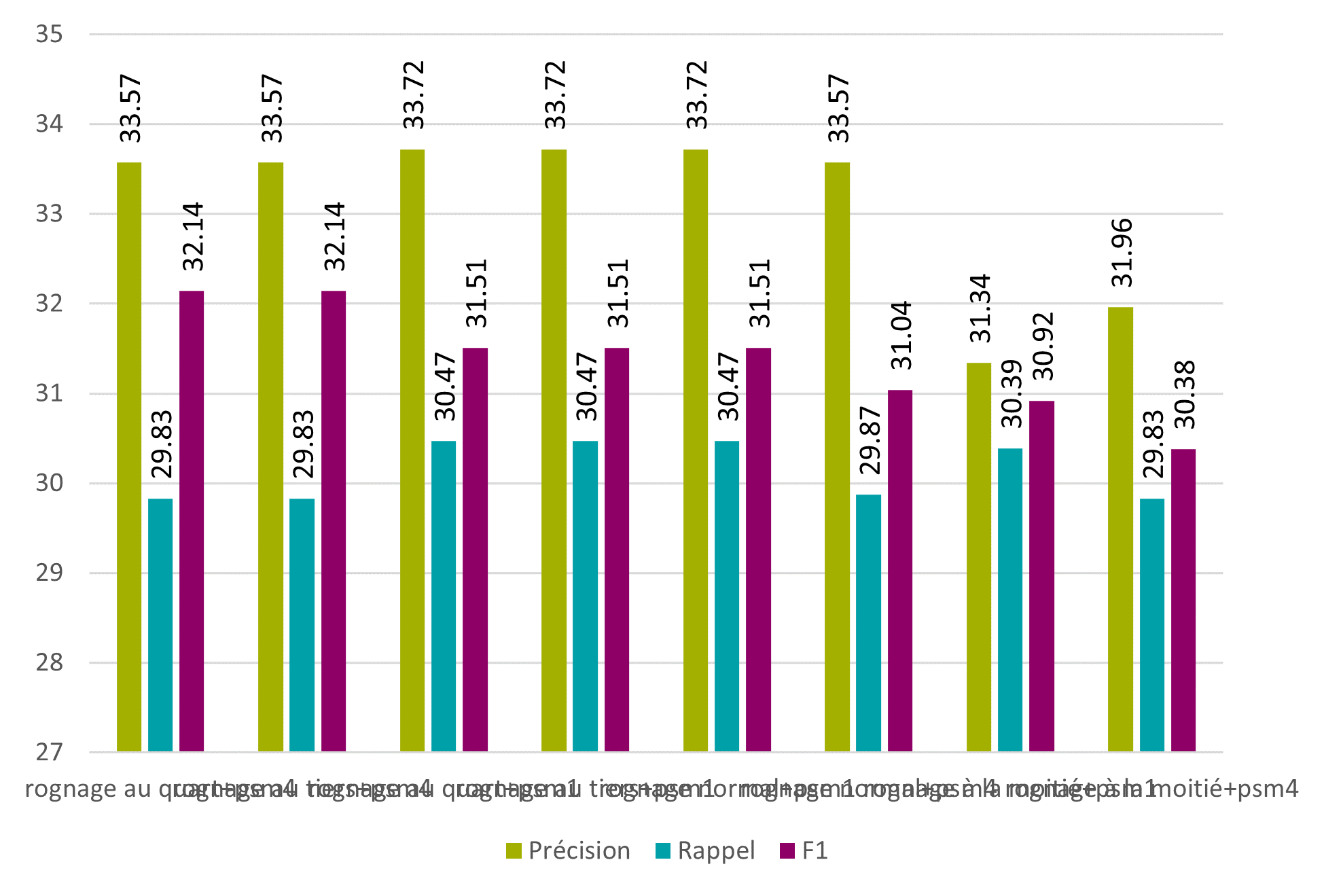

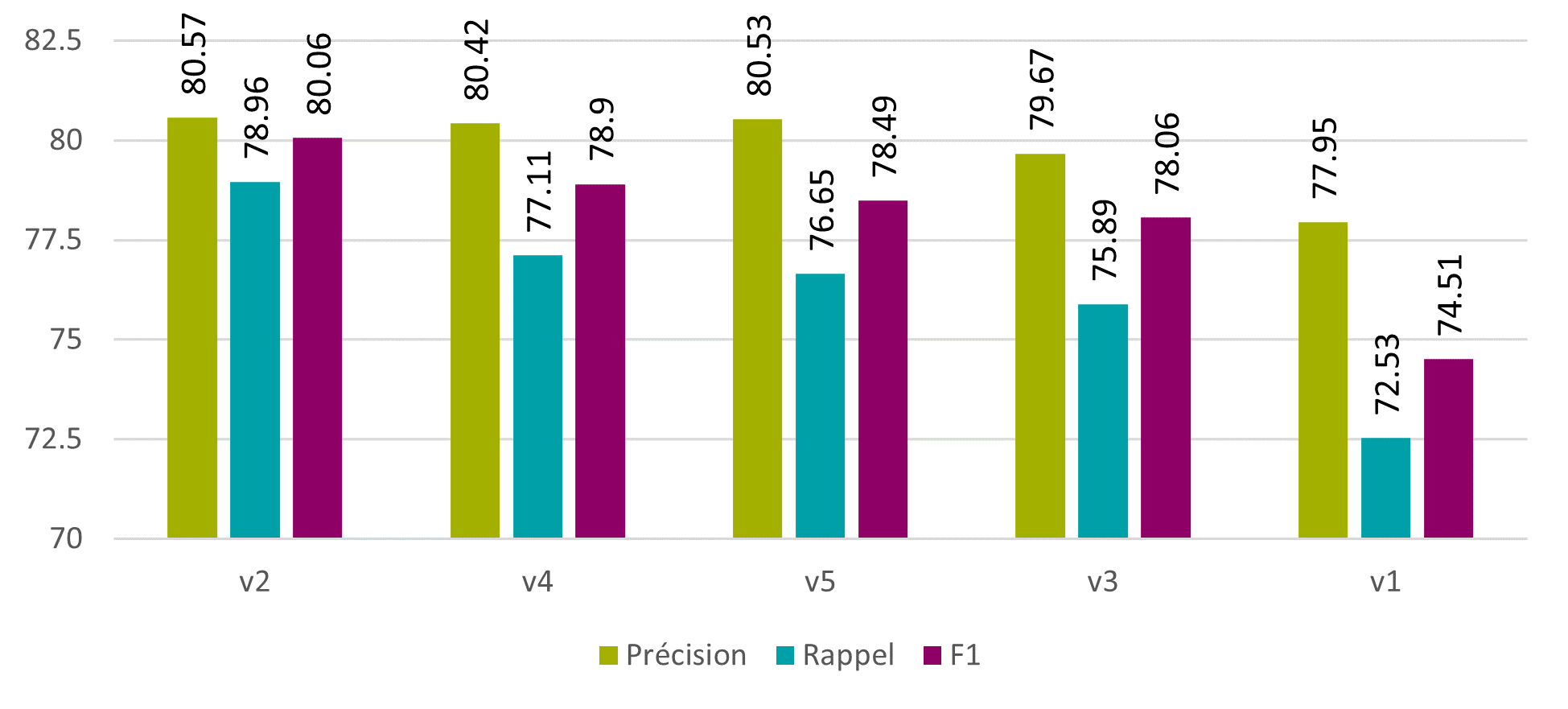

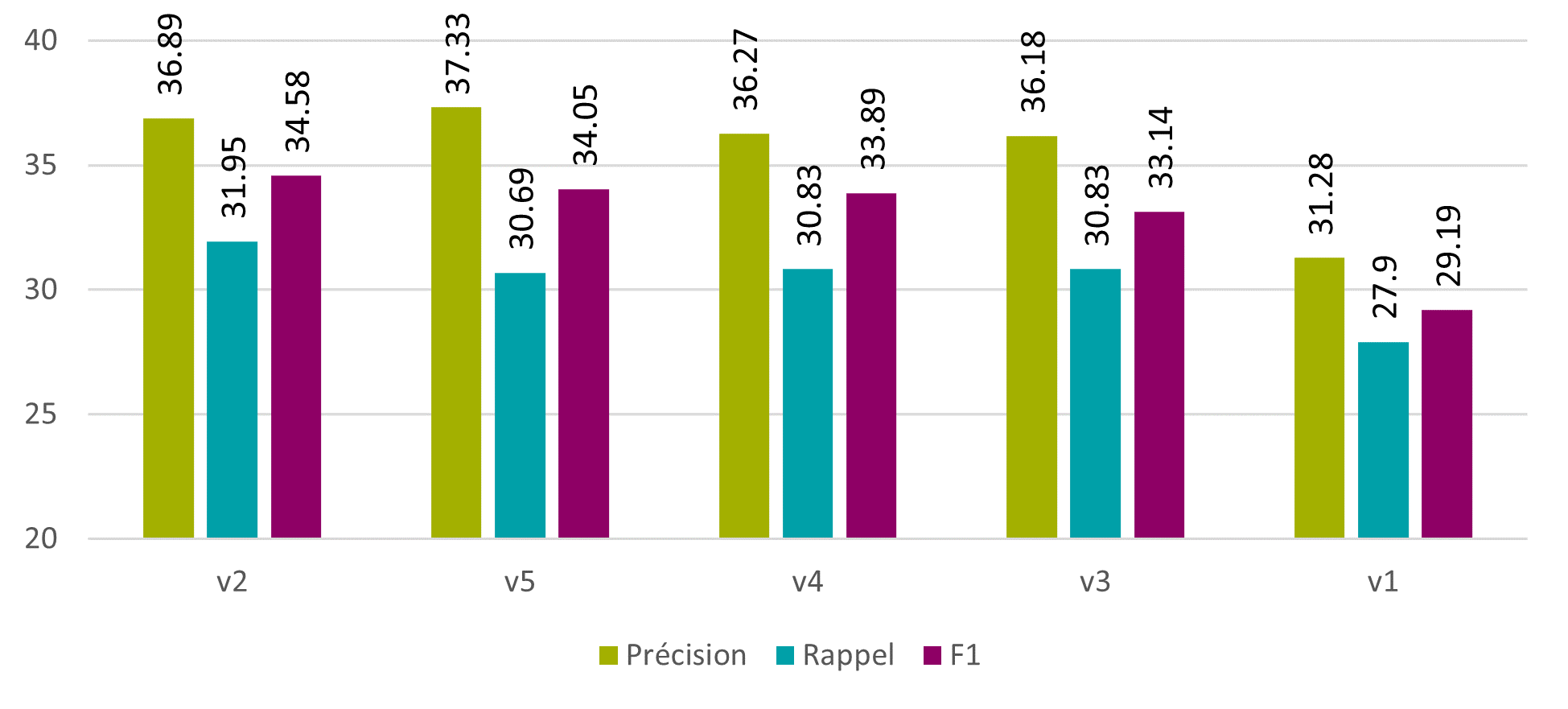

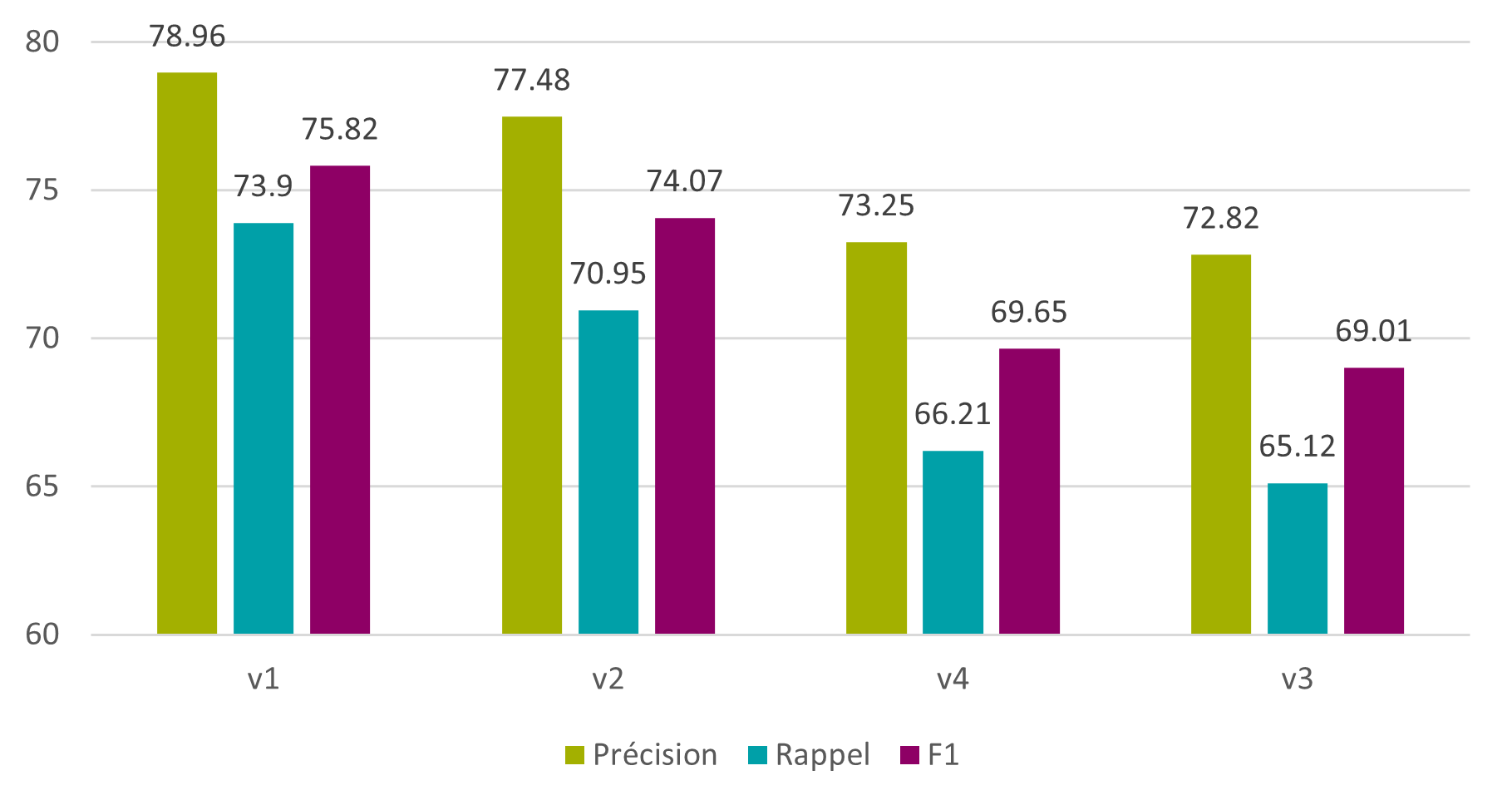

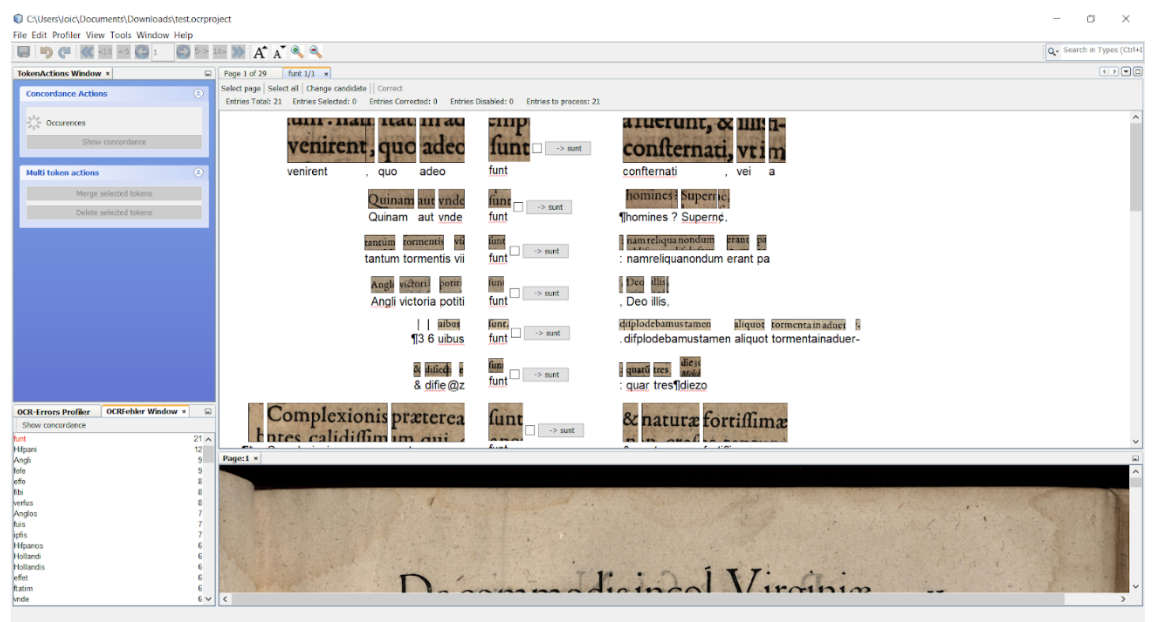

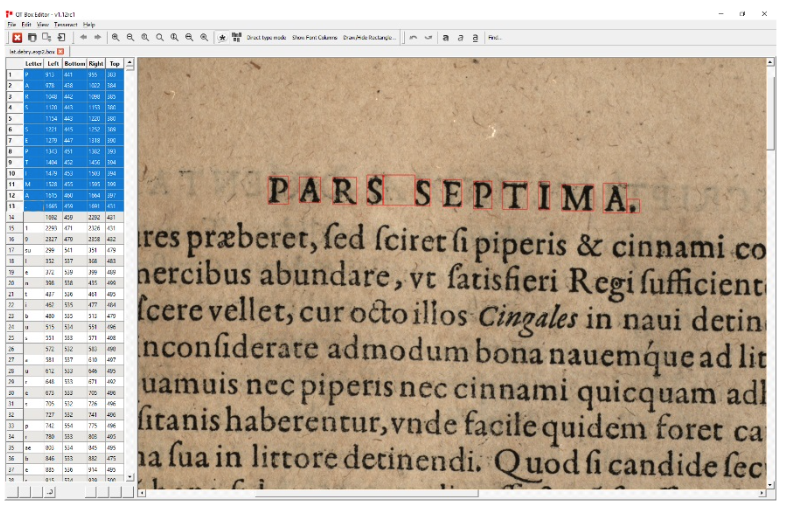

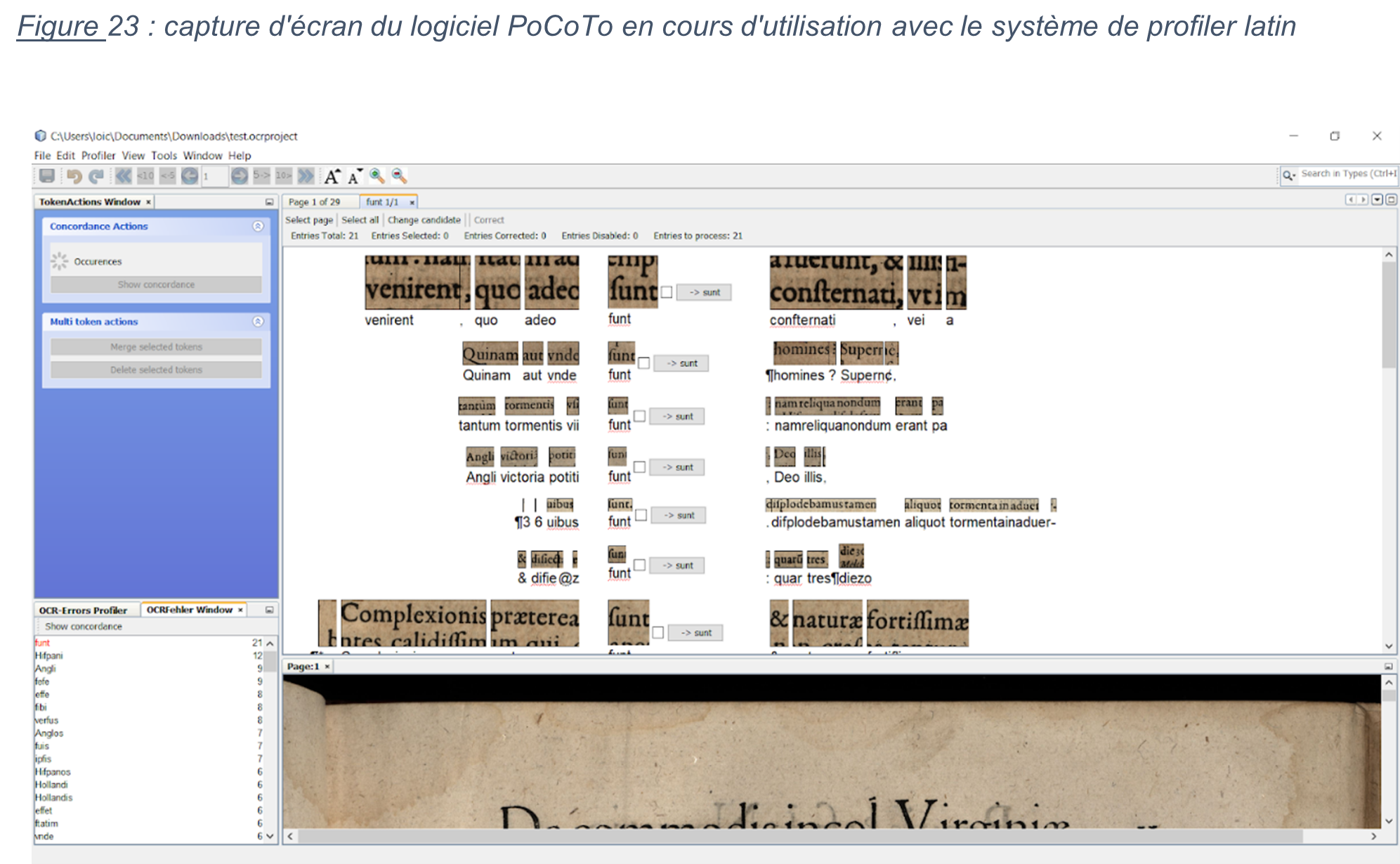

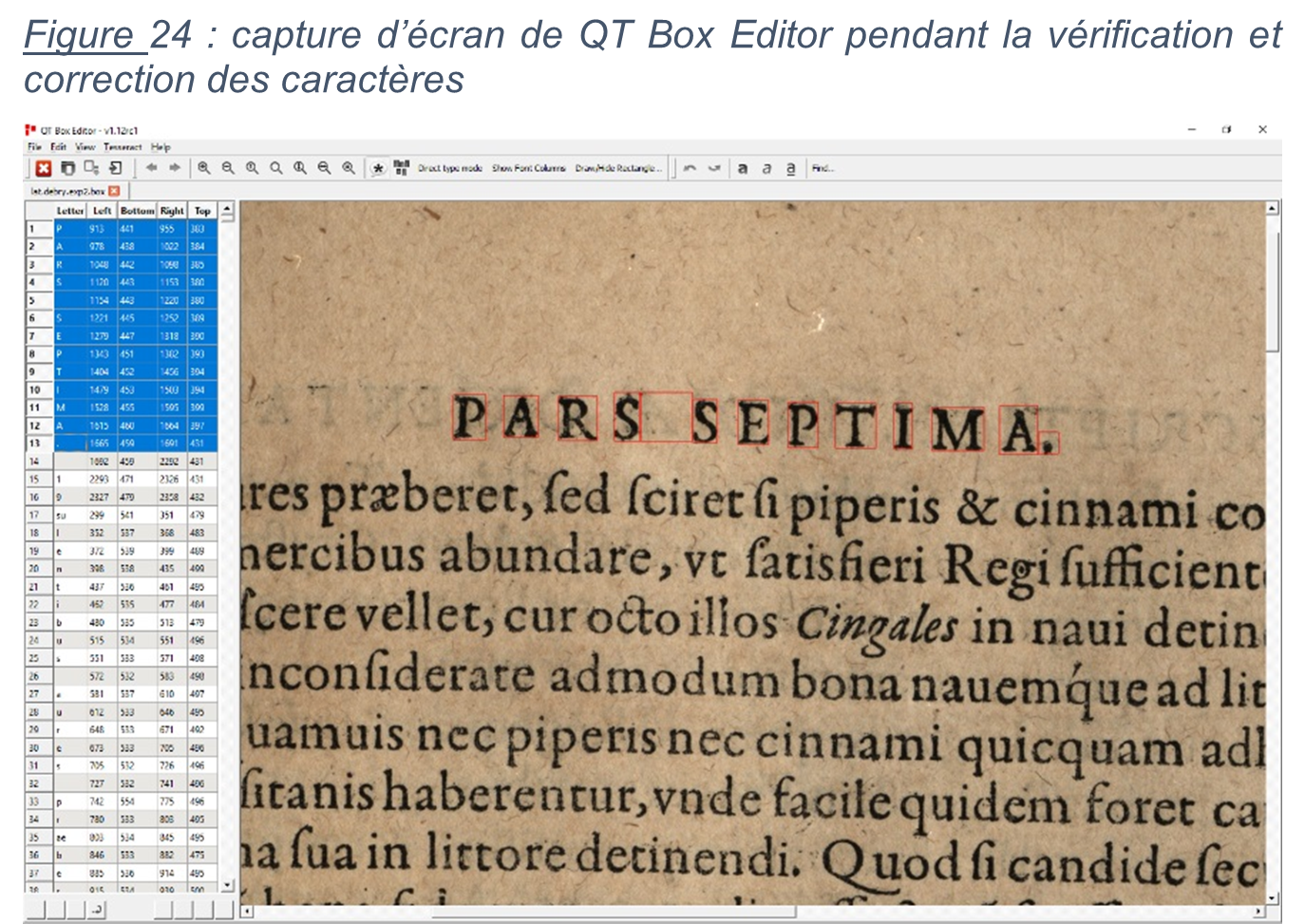

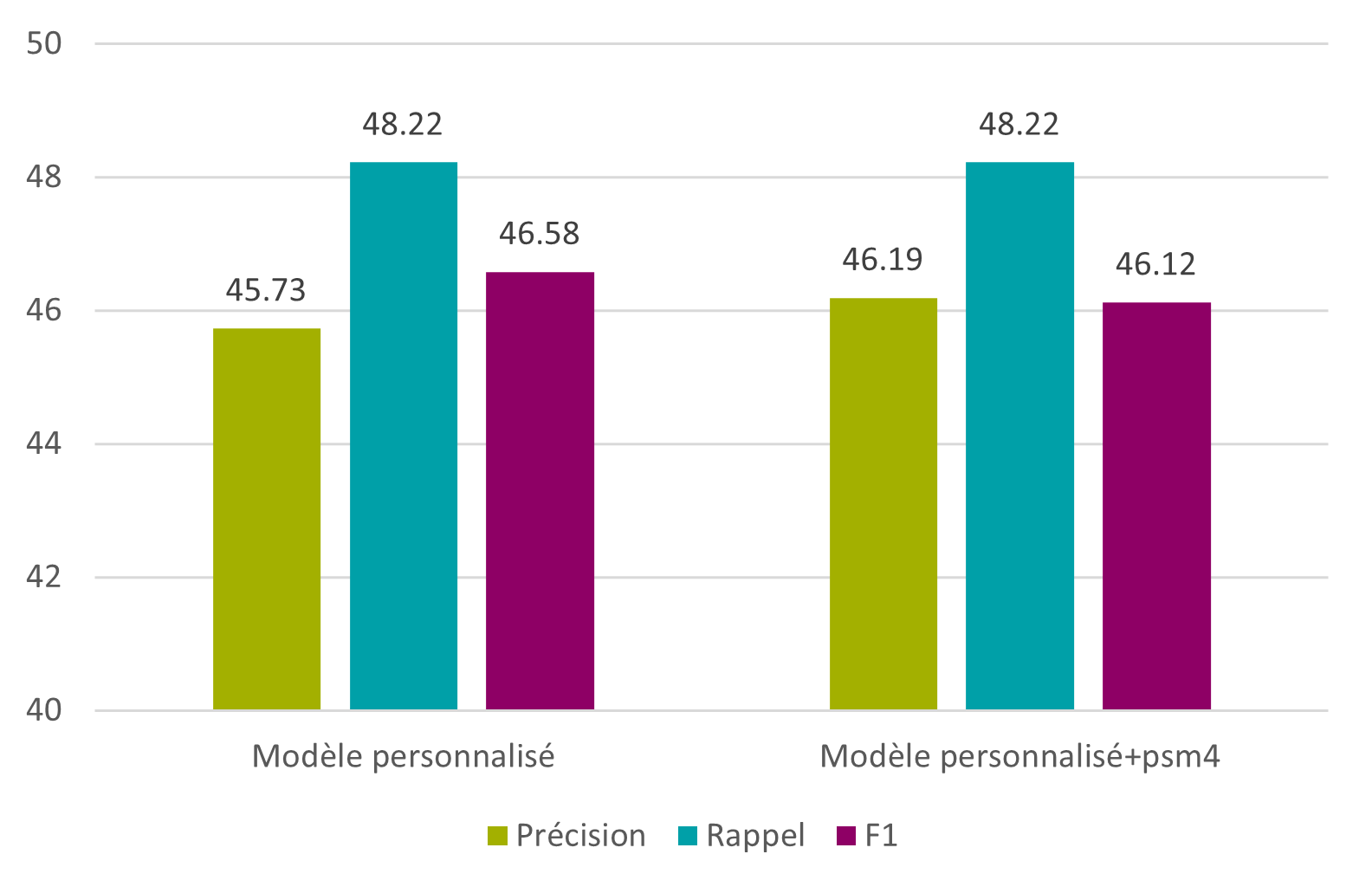

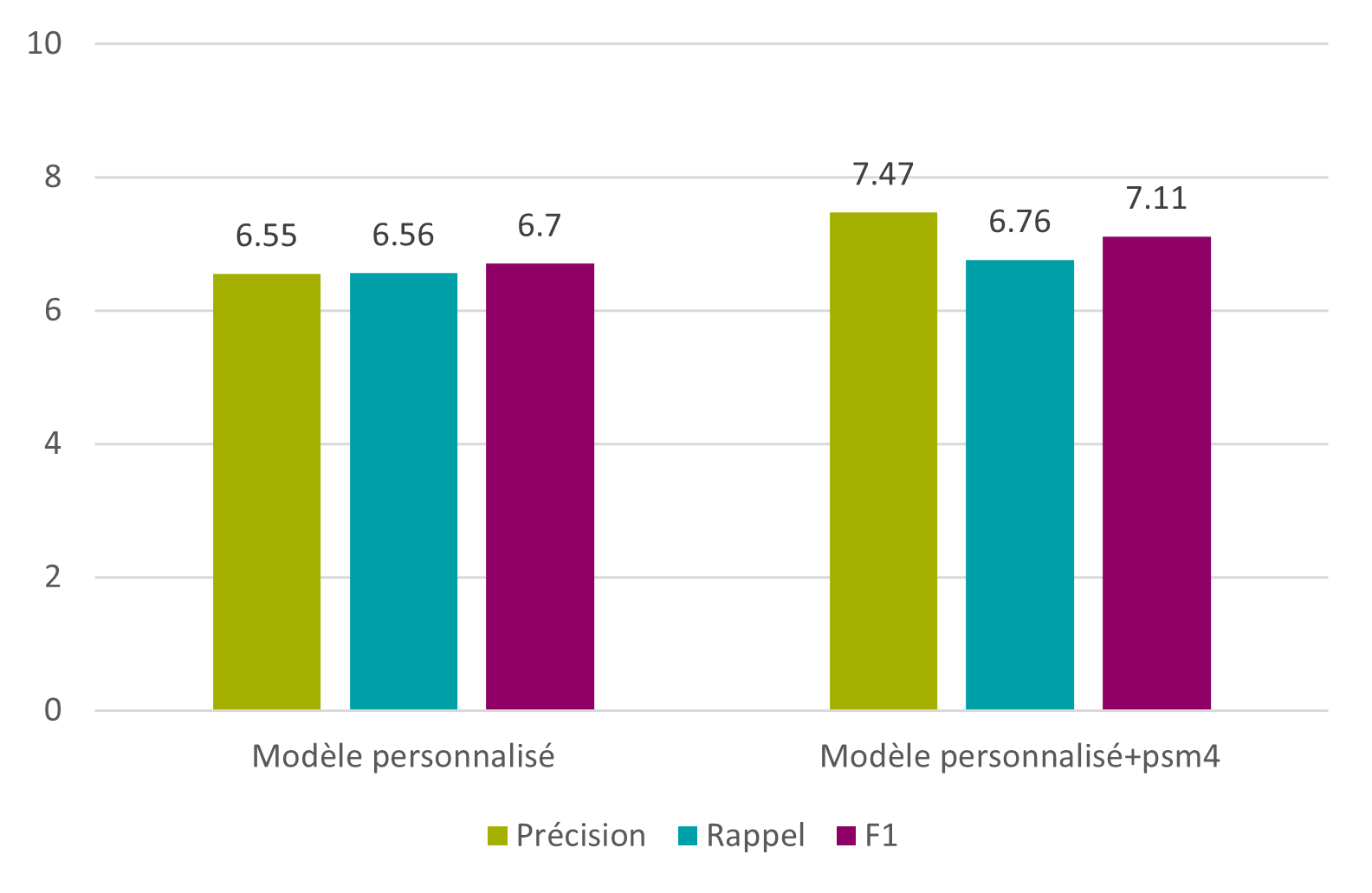

Un quatrième et dernier article de recherche, signée Florence Burgy, assistante HES dans la filière Information documentaire de la HEG-Genève est intitulée L’océrisation d’imprimés anciens : les sciences de l’information au service des Humanités. Il relate le projet de recherche mené en collaboration avec le Bodmer Lab, qui a consisté à océriser des imprimés latins de la Renaissance, afin d’en obtenir une transcription et la rendre explorable par la recherche plein texte. Il donne les conclusions des tests d’océrisation faits avec plusieurs logiciels, dont Tesseract, qui a fourni les meilleurs résultats.

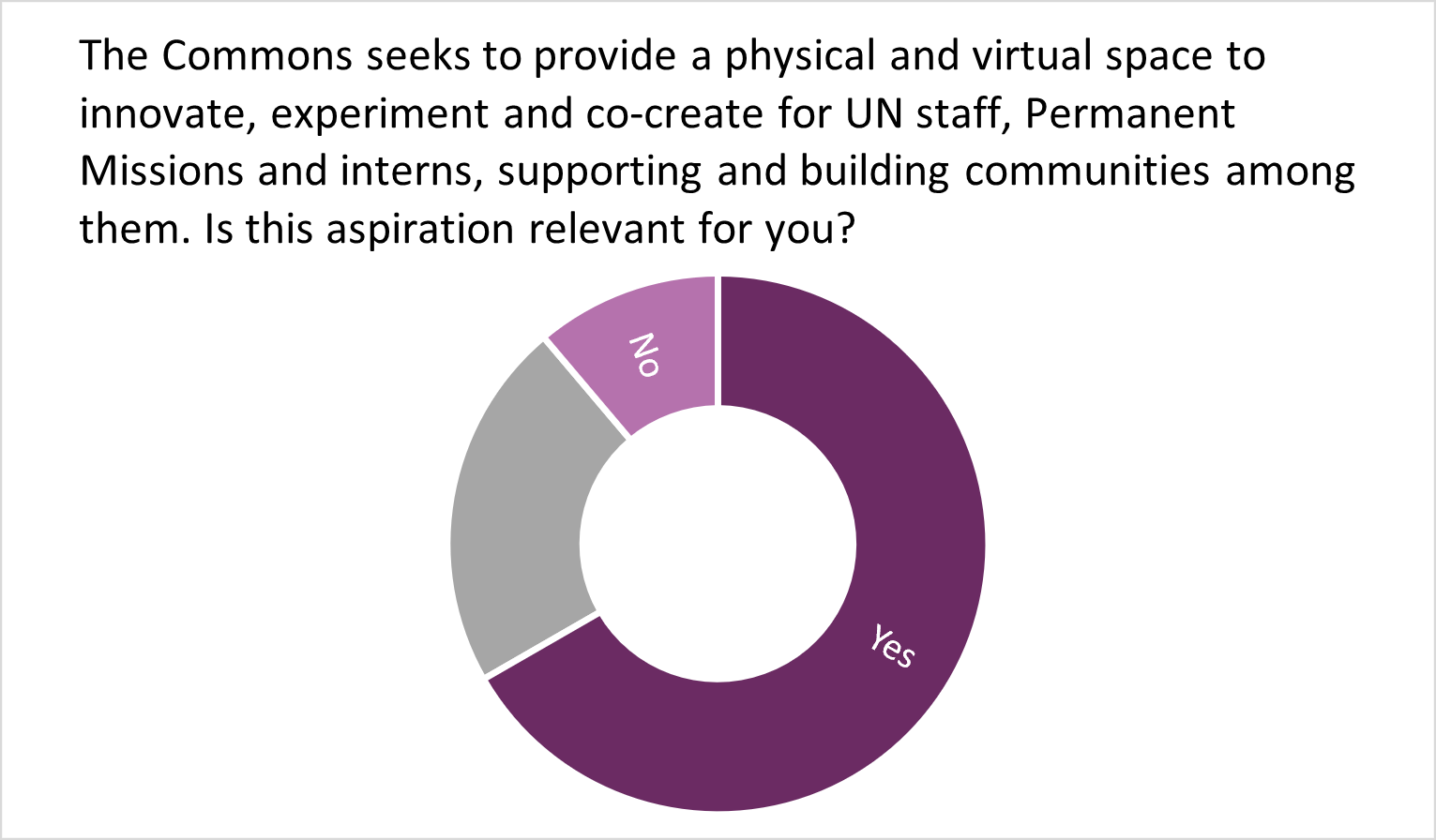

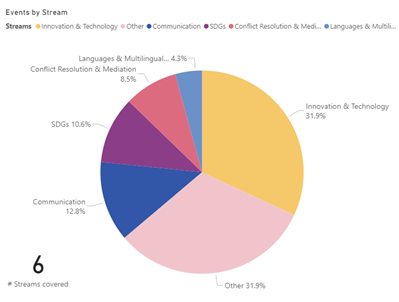

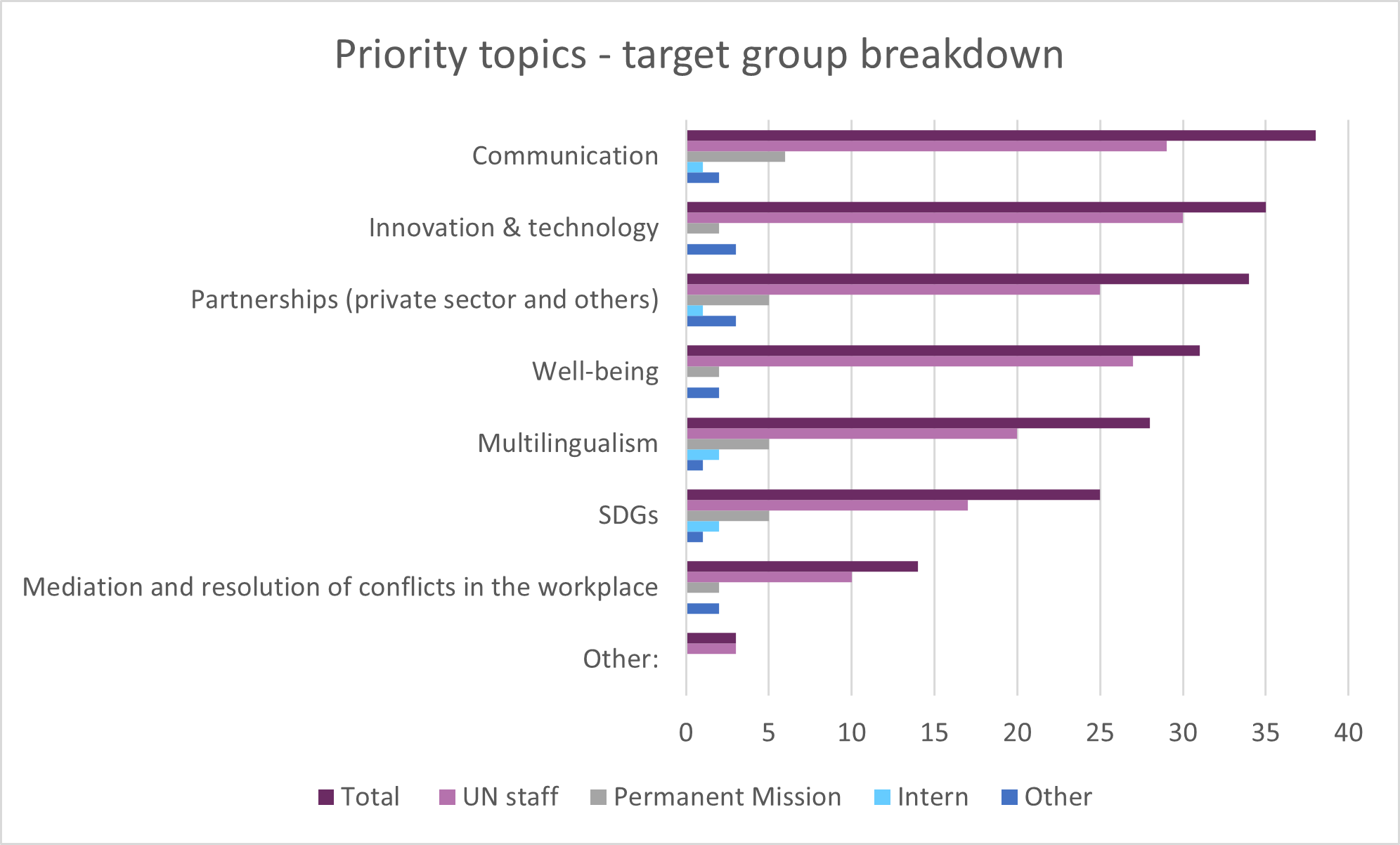

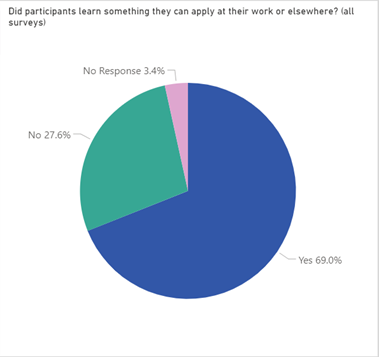

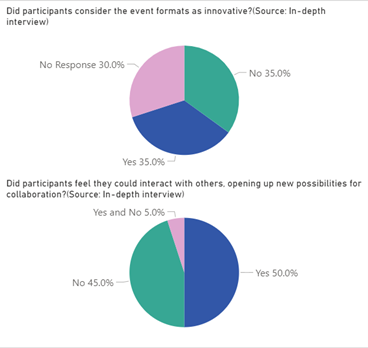

Dans la rubrique « Compte rendus d’expérience », nous vous proposons une contribution en anglais, signée Viviane Brunne et Sigrun Habermann, respectivement, Programme Manager à la bibliothèque des Nations Unies à Genève (UNOG) et manager de la même bibliothèque, intitulée The Knowledge & Learning Commons – a library’s evolution driving cultural change at the United Nations in Geneva. Cet article retrace le développement de l’Espace commun «Savoirs et formation des Nations Unies Genève, Commons» depuis ses premières étapes expérimentales vers un programme plus structuré, conçu en co-création avec ses utilisateurs. Il analyse également les expériences plus récentes tirées du semi-confinement dû au Covid-19, et propose des pistes de développement.

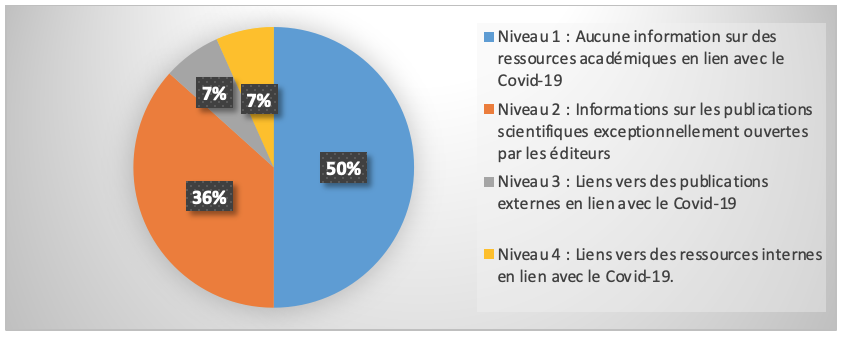

RESSI se devait aussi, en cette année de crise sanitaire et de fermeture temporaire des bibliothèques en Suisse de faire un bilan de l’utilisation des bibliothèques pendant cette période. On trouvera donc un premier article de Benoît Epron, professeur HES associé dans la filière Information documentaire de la HEG-Genève et de Séverine Gaudard, co-responsable de la PME Clio-Archives. Intitulé La place des ressources documentaires des bibliothèques académiques dans la lutte contre les Fake News : le cas du COVID-19, il relate les enseignements d’un projet sur 6 mois et donne des pistes pour accroître le rôle des bibliothèques universitaires dans la lutte contre les fake news. Et un deuxième, également de Benoît Epron et de Florence Burgy, assistante HES à la HEG-Genève, intitulé Les bibliothèques face à la vague, synthétise les pratiques d’utilisation de la bibliothèque - y compris d’e-books- lors du semi-confinement du printemps 2020, en prenant l’exemple de plusieurs bibliothèques romandes (bibliothèque municipale de Vevey la Médiathèque Valais, la BCUL-site Riponne) et de Bibliomedia,

Pour la rubrique Compte rendu d’événement, on trouvera deux contributions.

La première émane de Piergiuseppe Esposito, chargé de missions à la BCU Lausanne. Intitulée Conférence annuelle LIBER 2020 online, elle résume les sujets et débats évoqués à la conférence annuelle LIBER, (Ligue des Bibliothèques Européennes de Recherche) qui s’est tenue à distance, en juin 2020, sur le thème Building Trust with Research Libraries.

La seconde, rédigée en anglais et intitulée A review of the Swiss Research Data Day 2020 (SRDD2020): 48 experts shared their experiences on emergent approaches in Open Science a été écrite par Lydie Echernier et Pierre-Yves Burgi, et revient sur le symposium Swiss Research Data Day 2020, qui s’est tenu à Genève, à distance, en octobre 2020. Les auteurs sont respectivement coordinatrice du projet DLCM, Division Systèmes et technologies de l'information et de la communication (STIC) à l’Université de Genève, et directeur du projet DLCM, directeur SI adjoint, Division Systèmes et technologies de l'information et de la communication (STIC) à l’Université de Genève.

Pour la rubrique des recensions, on trouvera le compte rendu de l’ouvrage d’Alain Jacquesson, ancien directeur de la BGE et membre du comité de rédaction de RESSI, et Gabrielle von Roten, ancienne cheffe du service de coordination des bibliothèques universitaires de Genève, Histoire d’une (r)évolution : l’informatisation des bibliothèques genevoises, 1963-2018 sous la plume d’Alex Boder, maître d’enseignement dans la filière Information documentaire de la HEG-Genève.

Finalement, on trouvera la recension de l’ouvrage intitulé The non-sense guide to research support and Scholarly Communication de Claire Sewell, recension signée Thomas Pasche, assistant HES dans la filière Information documentaire de la HEG-Genève. L’ouvrage détaille les rôles possibles des bibliothécaires dans le domaine de l’aide à la recherche académique.

Nous vous souhaitons une très bonne lecture et nous remercions vivement les auteurs de cette édition, ainsi que les fidèles - et les nouveaux ! - réviseurs, et ceux qui ont contribué à la mise en ligne de RESSI.

Nous sommes prêts à recevoir vos propositions d’article à tout moment, et nous vous encourageons à faire part de vos commentaires sur l’évolution de RESSI et à contribuer à faire connaître RESSI autour de vous.

Le Comité de rédaction

Apprendre « en commun » : L’expérience des ateliers de contribution à Wikipédia dans les bibliothèques publiques de Montréal

Marie D. Martel, professeure adjointe, EBSI (Université de Montréal)

Apprendre « en commun » : L’expérience des ateliers de contribution à Wikipédia dans les bibliothèques publiques de Montréal

1. Contexte

Wikipédia célèbre ses 20 ans cette année. Née en 2001, la rencontre inévitable entre cette dernière et le monde des bibliothèques n’a guère tardé. Du rejet à la suspicion puis à la collaboration, des initiatives conjointes se mettent en place à partir de 2012, tant dans les bibliothèques universitaires que publiques, sous la forme de journées contributives, ou édit-a-thons, qui constituent encore aujourd’hui un des principaux scénarios de médiation wikipédienne. Dans cette mouvance, des ateliers de contribution ont été déployés et intégrés dans le calendrier régulier de certaines institutions québécoises comme à la Grande bibliothèque et dans le réseau des Bibliothèques de Montréal. Les retombées de ces activités sont à géométrie variable, oscillant entre l’enthousiasme et la déception, mais d’une façon générale, il est reconnu que ce n’est pas la performance (soit le nombre de participant.e.s ou le nombre de contributions) qui constitue un bon indicateur pour mesurer la valeur de ces activités. L’impact est ailleurs et nous y reviendrons par le biais de ce récit ethnologique qui est porté par les questions : Comment pourrait-on créer une communauté créatrice de savoirs communs numériques en bibliothèque ? Comment pourrait-on évaluer et accroître l’impact des ateliers contributifs impliquant les bibliothèques et Wikipédia - ou plus généralement, les projets soutenus par la fondation Wikimédia ?

Nos analyses et nos conclusions, ancrées dans une pratique réflexive(1), sont principalement influencées par les situations observées directement sur le terrain au cours de ces dernières années à organiser, animer, expérimenter des ateliers de contribution en bibliothèque(2). Après une brève chronologie des initiatives québécoises, nous explorerons momentanément un cadre de référence visant à inscrire ces actions dans un contexte qui les justifie en regard des finalités et des missions des bibliothèques aujourd’hui. Cette « réflexion sur l’action » nous permettra de partager un certain nombre de constats instructifs en s’attachant particulièrement aux leçons que l’on peut tirer pour faciliter l’aménagement social de ce projet wikipédien en bibliothèque et valoriser encore l’apport de ces ateliers contributifs au sein des communautés.

2. Les bibliothèques québécoises et Wikipédia : Un bref historique

Le premier motif de l’intérêt des bibliothèques à l’endroit de l’encyclopédie a été d’abord été critique. À partir de 2005, plusieurs études en sciences de l’information analysent ce projet d’encyclopédie libre et questionnent la qualité du contenu de Wikipédia (son étendue, son actualité, sa fiabilité) et son statut d’ouvrage de référence au sens traditionnel du terme(3).

À partir de 2010, la British Library entreprend une collaboration avec la Wikimedia Foundation et une première expérience de wikipédienne en résidence dans cette même institution révèle les nombreuses opportunités issues du croisement entre Wikipédia et les institutions de mémoire(4). Les avantages en termes de valorisation du patrimoine et des collections numériques qui sont extraites dans le cadre des projets GLAMs (pour Galleries, LIbraries, Archives, Museums) aident peu à peu à dissiper la méfiance, et en même temps les réserves sur la qualité du contenu tendent à s’estomper.

Au Québec, plutôt que de passer par les institutions de mémoire, c’est d’abord par le biais de journées contributives à l’échelle locale que seront scellées les premières relations entre Wikipédia et le monde des bibliothèques. Un atelier consacré à Jean Talon(5), premier intendant de la Nouvelle-France, se déroule à la bibliothèque de l’Université Laval le 18 février 2012(6). Une année plus tard, le 6 avril 2013, à la Bibliothèque Mile End (aujourd’hui Mordecai-Richler) se tient la première activité de type édit-a-thon en bibliothèque publique au Québec. L’activité porte sur le Projet Mile End, lancé au mois de février, initié par l’organisme d’histoire locale, Mémoire du Mile End, et le chapitre Wikimédia Canada. La bibliothèque met son espace et la documentation sur le quartier à la disposition des participant.e.s et une bibliothécaire du réseau des bibliothèques de Montréal est du nombre des contributeurs(7).

Plus tard, la même année, le samedi 19 octobre 2013, lors d’une journée organisée par l’Association canadienne française pour l’avancement des sciences (ACFAS) et Wikimédia Canada dans le cadre du Mois international de la contribution francophone, se tient un atelier de contribution qui inaugure un partenariat soutenu entre Bibliothèque et archives nationales du Québec (BAnQ), et Wikimédia Canada(8). Ce premier événement à la bibliothèque nationale se prolonge dans le programme des Mardi, c’est Wiki, des ateliers qui se tiennent tous les premiers mardis du mois depuis 2014 en proposant une formation, plus qu’un atelier à proprement parler, réunissant conjointement des formateurs wikipédiens et des bibliothécaires. BAnQ est progressivement devenue un des partenaires canadiens les plus actifs du mouvement des GLAMs en s’investissant dans une diversité de projets tant de médiation que d’extraction de ses collections dont des fonds d’archives photographiques(9).

Du côté des bibliothèques de Montréal, les activités reprendront sur une base régulière entre 2016 et 2018, avec plus d’une vingtaine d’ateliers contributifs(10). Ces initiatives ont été menées, dans la très grande majorité des cas, en collaboration avec le Café des savoirs libres (CSL), un collectif rassemblant des bibliothécaires et des libristes engagés dans la création des communs du savoir. Suite à une invitation lancée au réseau des bibliothèques, ces ateliers mensuels accueillent entre 6 et 10 participant.e.s par événement. Les rencontres comptent principalement des membres du CSL qui reviennent à toutes les activités, quelques usagers et généralement un membre du personnel de la bibliothèque dont la participation est, selon le cas, plus ou moins instrumentale. Certains usagers participants viennent de l’extérieur de Montréal, mais leur provenance est surtout locale. Les événements se déroulent les soirs de la semaine entre 17h et 20h. Après une programmation nomade se déplaçant dans une bibliothèque différente à chaque séance, une stratégie alternative est progressivement privilégiée avec une série de rencontres récurrentes dans une même bibliothèque dans le but d’explorer la possibilité de démarrer une communauté locale d’adeptes qui deviendrait autonome dans la durée.

En plus des ateliers locaux, quelques édit-a-thons thématiques ont été organisés en lien avec le Festival international de la bande dessinée de Montréal, la Journée internationale des femmes, le Mois de l’art et des rites funéraires, le centenaire de la bibliothèque centrale de Montréal, etc. Après 2018, les rendez-vous des ateliers contributifs dans les Bibliothèques de Montréal sont devenus plus irréguliers, CSL ayant choisi de poursuivre son engagement à la bibliothèque de la Cinémathèque québécoise où la structure s’était engagée de façon intentionnelle dans l’organisation de ces activités avec un projet sur les « Savoirs communs du cinéma »(11). Avant ce déménagement, la période d’activités qui s’étendait de 2016 à 2018 a été l’occasion de recueillir une série d’observations, d’expérimenter différents scénarios d’usage, d’interroger aussi le sens et la portée de ces ateliers en bibliothèque: c’est cet épisode que nous allons considérer.

3. Un cadre de référence pour mieux comprendre les bibliothèques wikipédiennes

Pourquoi organiser ce type d’activités, à savoir des ateliers contributifs wikipédiens, plutôt que d’autres actions en bibliothèque ? Les raisons qui expliquent et justifient la collaboration entre les milieux documentaires et la Fondation Wikimedia sont nombreuses et relativement bien documentées depuis quelques années. On peut en rappeler quelques-unes : la convergence des missions autour de l’accès libre aux savoirs; un intérêt soutenu pour la connaissance appuyée par des sources fiables. En particulier à cette époque où l’on discute âprement de post-vérité et de fausses nouvelles, les édit-a-thons offrent l’occasion de créer des contenus en ligne en pressant les éditeurs de recourir à des sources d’information fiables - incidemment susceptibles d’être trouvées en bibliothèque, ce qui permet du même coup de valoriser les collections. Ces activités deviennent aussi un excellent tremplin pour améliorer les compétences en littératie de l’information non seulement en initiant une réflexion critique sur les sources, mais aussi sur le caractère construit de l’information et sur les licences régissant l’accès et l’usage des savoirs(12). Pour plusieurs participants, l’atelier wikipédien devient un atelier de littératie numérique qui permet de combler tour à tour des lacunes tant en matière d’alphabétisation technologique, de pratiques numériques ou de valeurs associés à la culture et la citoyenneté numérique.

Au plan international, l’IFLA (International Federation of Libraries Association) a produit en 2016 une étude d’opportunité sur les bénéfices d’une collaboration avec Wikipédia, dans laquelle cette association invite les bibliothécaires à s’engager davantage pour faire de leur bibliothèque, une bibliothèque wikipédienne(13). Cet argumentaire appuie la reconnaissance de Wikipédia comme source d’information et défend son rôle comme plate-forme pour la culture et les connaissances locales qui sont soutenues par les bibliothèques publiques. Au moment où l’IFLA met à disposition cette étude, elle lance une seconde campagne de contribution mondiale auprès de la communauté des bibliothécaires. Cette campagne, menée entre le 15 janvier et le 3 février 2017, encourage les bibliothécaires à ajouter une source (au moins) dans l’encyclopédie libre. Imaginez un monde où chaque bibliothécaire ajouterait une référence de plus à Wikipédia... dit l’accroche de cette campagne qui se déroule désormais chaque année depuis 2017(14)

Les activités wikipédiennes bénéficient d’un discours sur les bibliothèques dirigées par la communauté (« community-led ») et d’une vision de la bibliothèque qui supportent les capacités créatives des publics. Dans cette veine, R. D. Lankes, auteur influent en bibliothéconomie, soutient que la finalité des bibliothèques consiste à « faciliter la création de connaissances dans les communautés en vue d’améliorer la société.»(15)

On assiste, par conséquent, à l’émergence de dispositifs qui sont de plus en plus structurés dans le milieu des bibliothèques à travers les associations internationales, la formation, la théorie et la pratique. Pour les bibliothécaires, en particulier, membres de CSL, cette initiative est aussi, de façon prioritaire, en phase avec un discours sur les bibliothèques comme « maisons des communs », c’est-à-dire comme espace de création, de valorisation et de défense des savoirs libres.(16)

Du point de vue du contexte interne, notamment celui de la Direction des Bibliothèques de Montréal, les ateliers de contribution dans le réseau s’inscrivent dans le Plan d’action Montréal Ville intelligente et numérique en contribuant au développement des compétences numériques. Ces activités ont été identifiées comme des indicateurs de la réalisation du Chantier sur la littératie numérique constituant une des actions de ce plan pour les bibliothèques de Montréal. Cet intérêt venu de services extérieurs à celui des bibliothèques ont contribué à légitimer cet engagement. Les ateliers étaient aussi alignés sur le Plan stratégique des Bibliothèques de Montréal 2016-2019 qui visait à « Consolider et développer des services, des programmes et des activités de littératie numérique et technologique.»(17) .

4. Carnet de terrain : Des constats et des enjeux

Chaque atelier s’avère une occasion inédite de s’interroger sur le format, les ressources nécessaires, les finalités et les retombées du projet, afin d’en tirer des leçons et de bonifier la proposition.

a. L’espace 1 : le territoire et l’équipement. Le modèle est au départ inspiré des ateliers mobiles des voyageurs du code avec l’intention de se déplacer à chaque séance dans une nouvelle bibliothèque(18). L’hypothèse est qu’une rencontre animée par l’équipe de CSL suffira à poser les bases d’une communauté wikipédienne locale qui poursuivra ensuite de manière autonome les ateliers à la façon d’un club de lecture. Un des premiers obstacles très basiques est l’équipement dont la quantité et la qualité sont variables d'un établissement à l’autre. Les bibliothèques n’avaient pas toujours l’équipement informatique requis pour recevoir une dizaine de participants, et les usagers, même avertis d’apporter leurs propres outils (suivant la formule BYOD) ne sont pas toujours dotés d’autre chose que d’un téléphone portable. En outre, l’intention de conduire des ateliers, mais surtout de créer une dynamique d’apprentissage actif et collaboratif, amènent progressivement les organisateurs à délaisser le cadre rigide du laboratoire informatique et le format de la « classe ». Cette orientation appelle un ajustement en termes d’équipements mobiles adaptés à une configuration spatiale flexible. La solution proposée par la Direction des bibliothèques de Montréal consiste à mettre sur pied une flotte d’ordinateurs portables rangés dans des valises que transportent les bibliothécaires membres de CSL. Un projecteur portatif complète l'équipement et les bibliothèques fournissent généralement l’écran, sinon le mur blanc pour la présentation et la démonstration.

Il est apparu assez évident, toutefois, qu’une seule séance pour établir une communauté numérique était pour le moins utopique. Le modèle sédentaire et la voie de l’accompagnement sur un même site, avec un ancrage communautaire dans la durée, associé à un programme thématique basée sur une série de rencontres typiquement sur le modèle des « clubs » offrent des conditions plus favorables et productives.

b. Le temps : le programme et les heures d’ouverture. Le point précédent pose déjà un repère en matière de temporalité en privilégiant une périodicité que nous avons identifiée comme mensuelle en se fondant sur les disponibilités des participants. Par ailleurs, en considérant que ce sont des activités bénévoles qui se déroulent généralement le soir, l’enjeu des heures d’ouverture en soirée s’est posé puisque les horaires des bibliothèques à Montréal ne sont pas toujours compatibles avec cette contrainte. Pour y surseoir, les bibliothèques sont retenues en tenant compte de leur accessibilité ou, le cas échéant, en proposant une activité en dehors de leurs horaires habituels.

c. La collaboration : 1+1+1. Ces ateliers sont d’abord portés par l’engagement du collectif CSL qui constitue un premier levier de collaboration - avec son noyau de participants réguliers. L’originalité des ateliers montréalais consiste à accueillir conjointement des formateurs liés à Wikimédia et aussi à Openstreetmap (OSM), parfois eux-mêmes membres de CSL, qui diversifient la proposition en présentant aussi la cartographie libre; ce qui permet également d’accroître les publics intéressés. De plus, dans les arrondissements où l’on retrouve une société d’histoire active, les ateliers de contribution suscitent un intérêt particulier avec un désir de s’impliquer; ces organisations locales représentent un second levier de collaboration. La démarche tend à confirmer que les communautés ne se créent pas ex-nihilo mais plutôt en s’attachant aux projets des communautés d’intérêts déjà existantes sur le territoire(19). Encore faut-il que la bibliothèque, troisième levier de la collaboration, entretienne déjà des relations significatives avec des organismes culturels, éducatifs ou des groupes ayant des affinités ou des expertises spécifiques(20).

d. Le personnel : mobilisation et coapprentissage. Malgré la bonne volonté et l’intérêt manifeste d’accueillir ces ateliers par les gestionnaires des bibliothèques, la participation du personnel sur le terrain, pour différentes raisons, s’est avérée un autre enjeu notable. La première année, en dépit des invitations explicites adressées aux bibliothécaires dans les bibliothèques visitées, aucun d’entre eux n’a participé aux ateliers à l’exception de deux - et dont l’un avait été fortement incité, sinon contraint, de le faire par sa hiérarchie. Ces expériences nous ont amenés à créer une typologie en trois temps comprenant « le bibliothécaire qui ouvre la porte » (et qui se sauve); « le bibliothécaire qui dit un mot pour légitimer l’activité » (et qui se sauve - mais qui revient de temps à autres pour vérifier que tout est encore légitime); et, enfin, le bibliothécaire qui s’assoit, ce qui est un signe d’attention plus marqué, mais pour dix minutes - parce qu’il n’ose pas se sauver considérant qu’il reconnaît des collègues qui font partie du collectif.

Toutefois, les organisateurs des ateliers avaient dès le départ pour objectif d’initier au moins un membre de la bibliothèque aux rudiments de la contribution, y voyant un élément stratégique pour la pérennité des apprentissages et la mise en place d’une communauté durable. La deuxième année, cette demande est devenue une condition pour accepter de conduire un atelier dans une bibliothèque qui proposait sa candidature. Cette nouvelle condition a permis de former une dizaine de bibliothécaires dans le réseau et, en même temps, de créer les pages des bibliothèques hôtes sur lesquelles ceux-ci s’exerçaient. On peut suggérer d’expliquer cette attitude relativement peu volontariste a priori par l’état de sous-dotation affectant les bibliothèques montréalaises, autant que québécoises. Selon nous, l’enjeu était également d’ordre culturel, en termes professionnels, et découlait d’une conception de l’offre qui est abordée dans la perspective d’une prestation de services, où la bibliothèque définit son engagement communautaire, non pas sur le mode d’une approche de « planification en collaboration avec la communauté »(21), mais à partir d’un rôle instrumental ⎼ fort utile au demeurant pour ce type de programmes venus de l’extérieur mais plus limité en termes d’investissements relationnels ⎼ de « prêteuse de salle ». Les ateliers contributifs n’étaient pas assimilables, selon CSL, à un atelier comme un autre, il comportait une invitation à expérimenter une forme de médiation professionnelle négociée en commun. L’enjeu de l’engagement du personnel n’a jamais été tout à fait résolu et les activités ont été interprétées, au final, comme des situations avec une portée interculturelle où les bibliothécaires-hôtes sont appelés à expérimenter, comme les autres, le passage d’une culture de la prestation de services à une culture de la relation communautaire (community-led) et de la culture numérique, conçu en termes de participation active, de collaboration, d’échanges horizontaux, de bricolage de matériaux et de contenus pour créer des communs numériques qui émergent avec de nouveaux savoirs professionnels.

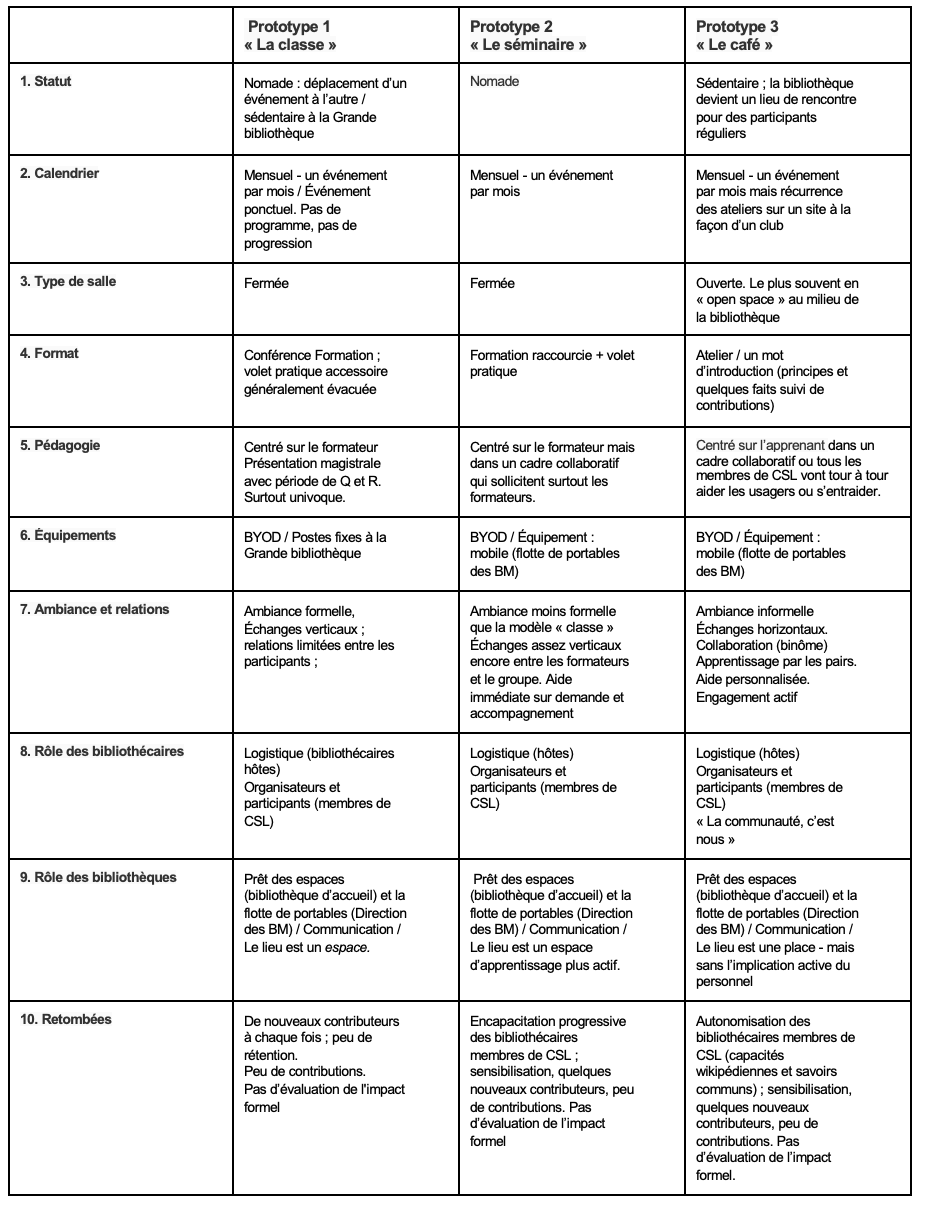

e. L’espace 2 : L’aménagement social. Cette intention relationnelle avec un parti pris pour la culture numérique était portée par un questionnement touchant le design des ateliers. Les observations et les notes de terrain indiquent trois approches, trois prototypes avec des pratiques socio-spatiales distinctes qui ont été expérimentées et qui se sont succédé dans le but d’aménager les rencontres et l’apprentissage « en commun ». Un tableau comparatif présente les caractéristiques de ces prototypes en annexe(22).

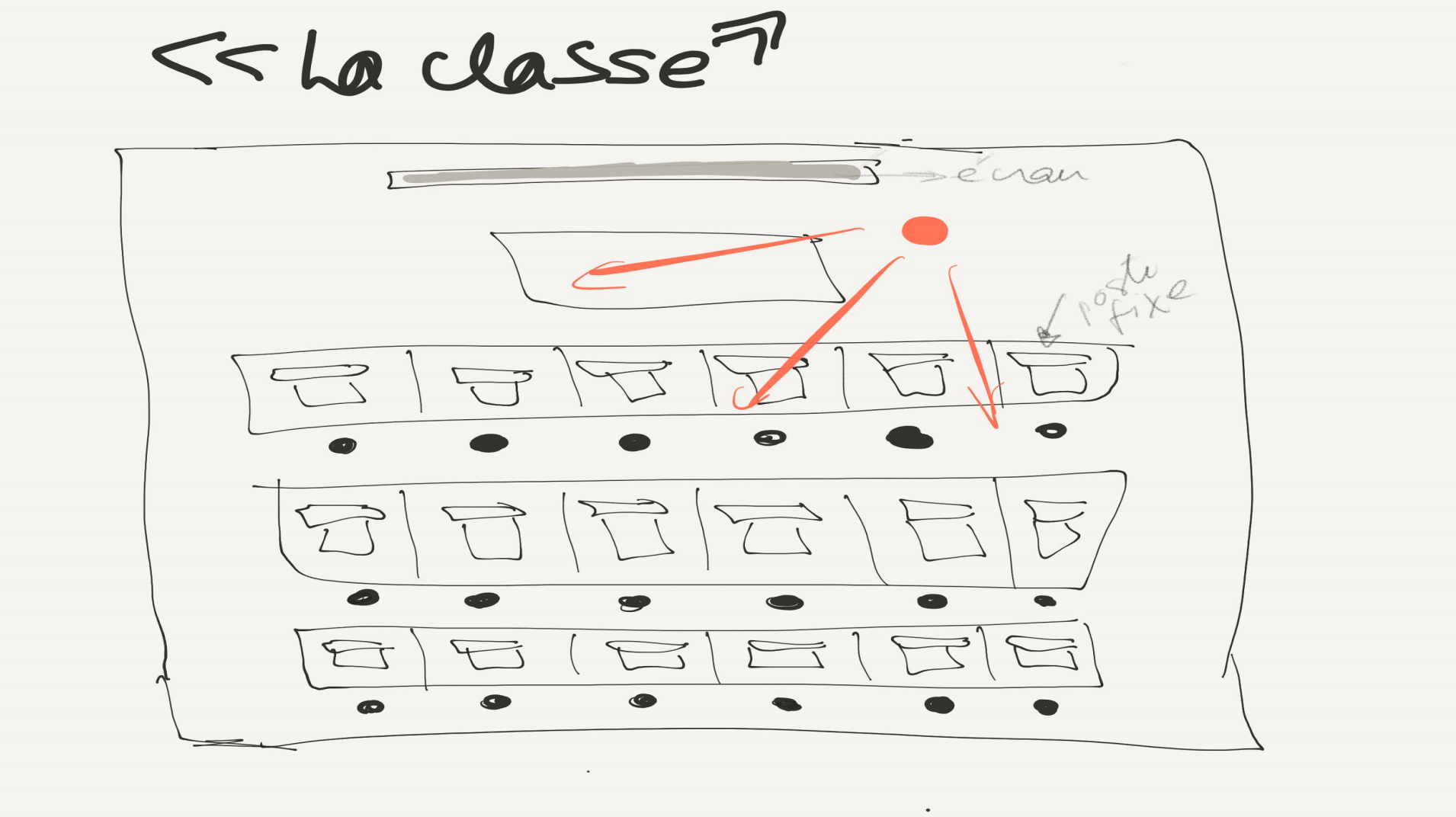

Prototype 1 : « La classe » ou le plan en rangée (voir schéma 1). Le premier dispositif adopté est celui de la salle fermée avec une organisation des participants en rangée sur le modèle de la classe. Les séances sont des formations de type magistral où les contenus sont abordés de manière aussi détaillée que possible en trois heures à peu près. Même si l’intention est de mettre en pratique les acquis, la durée de la présentation est telle que le volet atelier est généralement évacué. Les échanges, les collaborations, les contributions sont quasi absents. La conférence est donnée par les experts de Wikipédia et d’Openstreetmap. De nouvelles personnes se joignent à chaque séance bien qu’il était envisageable que des participant.e.s reviennent et suivent les déplacements des activités à travers le réseau des bibliothèques. Le modèle de la classe est aussi celui qui est privilégié à la Grande bibliothèque au même moment, et si les rencontres ne sont pas nomades, la rétention des participant.e.s est aussi faible.

Figure 1 : La classe

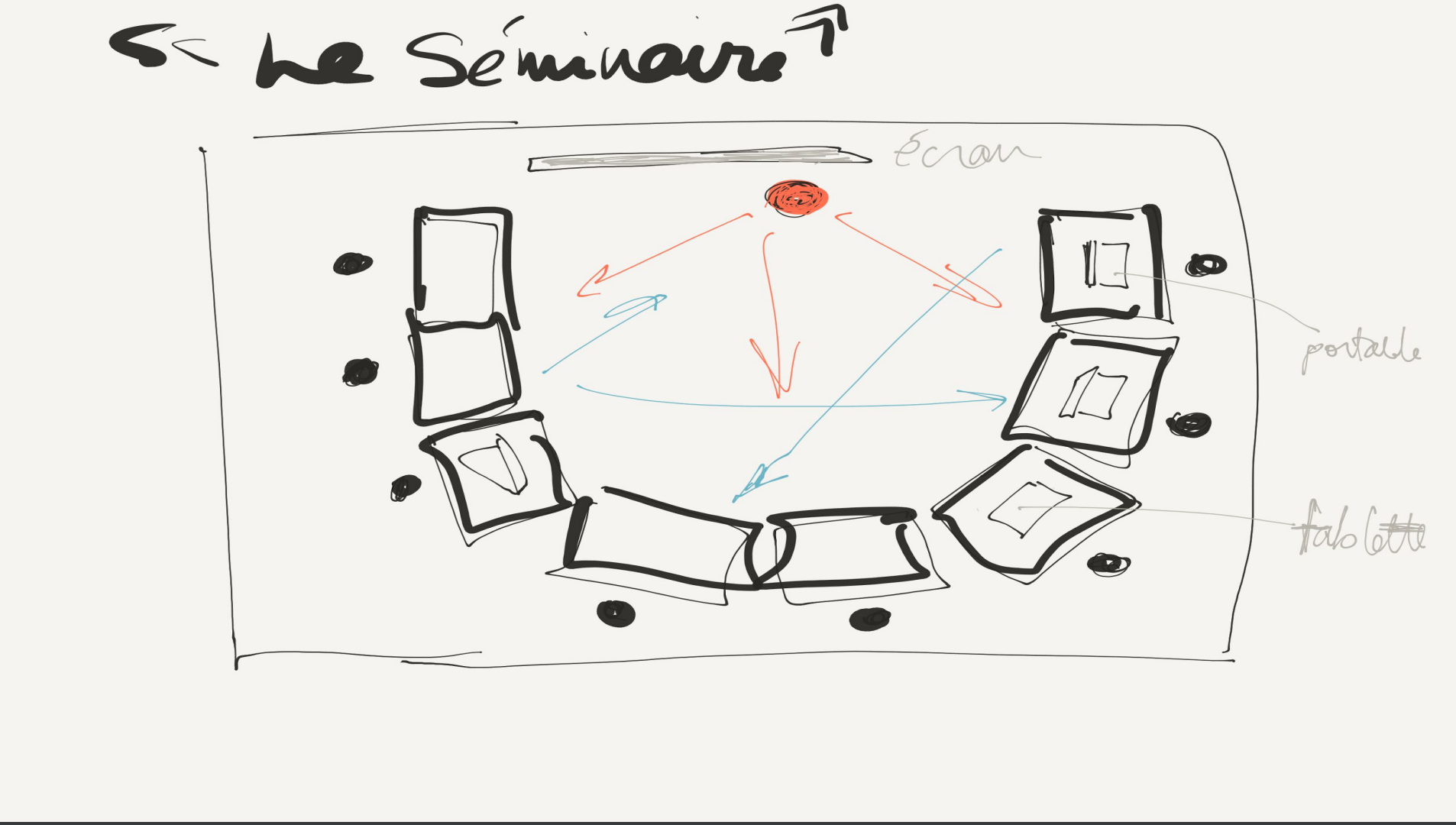

Prototype 2 : Le séminaire ou le plan en « U » (voir schéma 2). Le second scénario est un modèle de transition qui reflète l’intention de rompre avec le cours magistral pour se rapprocher d’un format de rencontre informel, moins centré sur le formateur, plus actif et, en ce sens, plus près de ce qui est annoncé et visé, c’est-à-dire, un atelier avec un volet “hands on”. La salle est organisée de manière à placer les tables en forme de U avec un écran et un projecteur au sommet du U pour la présentation. Les participant.e.s se côtoient, ils peuvent se voir. La rencontre prévoit deux parties d’une durée égale, soit une présentation donnée par les représentants de Wikimania Canada et de OpenStreetMap Montréal, suivie d’un atelier d’initiation. Peu à peu, une version alternative de ce modèle se met en place, ce qui représente un changement notable : ce sont les bibliothécaires membres de CSL qui commencent à prendre en charge la partie consacrée à la formation sur Wikipédia.

Figure 2 : La classe

Sans avoir procédé à une évaluation de l’impact en bonne et due forme, le critère associé au volet contributif apparaît plus conséquent, certains participants ouvrent un compte, apprivoisent les plate-formes (Wiki ou OSM), contribuent au sujet de leur choix ou à ceux qui sont proposés en lien avec des articles touchant le quartier ou la bibliothèque. Un accompagnement est pratiqué et des conversations surviennent, non seulement, par le biais des Q et R aux présentateurs, mais aussi entre les membres du CSL et les participants. Du point de vue du nombre de participants, de la rétention ou du nombre de contributions, les résultats sont à peine plus éloquents. En revanche, les apprentissages acquièrent une qualité expérientielle et suscitent un intérêt; les échanges deviennent le mode de communication qui occupent une part significative de la rencontre.

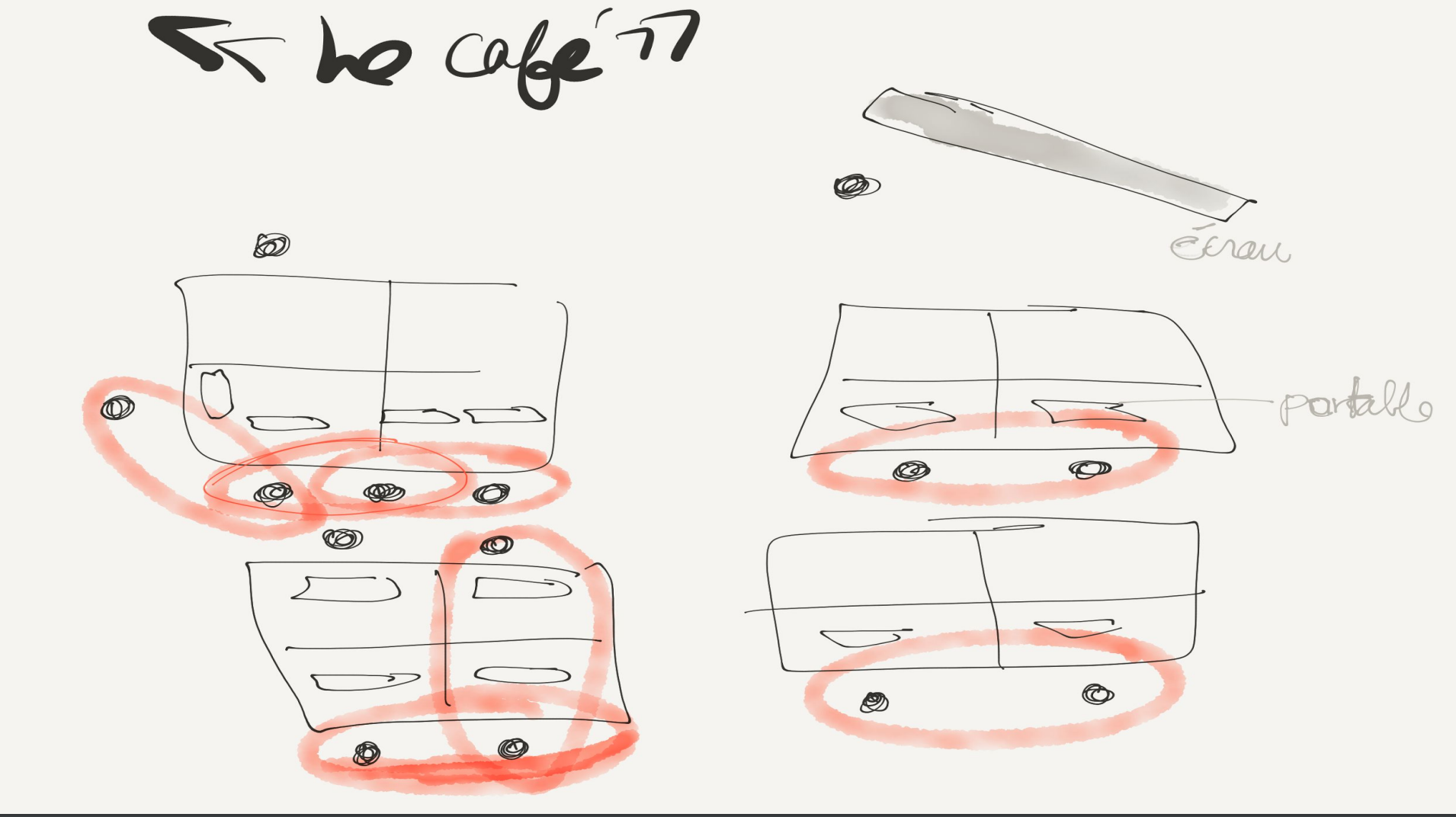

Prototype 3 : Le café ou le plan en îlot (voir schéma 3). Est-ce que l’on pourrait faire mieux « en commun » ? En faisant un retour sur les activités, en interrogeant les partenaires de Wikimédia Canada, OSM, des organismes locaux et des sociétés d’histoire, l’effort de conception suivant a porté sur les moyens d’accroître la sensibilisation aux savoirs communs, de rehausser les compétences, des participants comme celles des membres de CSL en matière d’édition. et de contribuer davantage aux données communautaires. En saisissant l’opportunité de l’invitation de la bibliothèque Mordecai-Richler de devenir des presque « wikipédien en résidence » dans le cadre de la programmation saisonnière, CSL a conçu un nouveau prototype d’atelier : le café. Cette nouvelle approche visait moins à créer et former une communauté, finalement extérieure aux formateurs-commoners que de reconnaître simplement que CSL faisait partie de la communauté en s’y identifiant ⎼ avec l’espoir que la bibliothèque ferait peut-être le même cheminement.

Figure 3 : Le café

Ce modèle met l’accent sur l’engagement de CSL lui-même dans les projets locaux tout en partageant les pratiques de commoners avec les personnes qui voudraient éventuellement se joindre : « La communauté numérique, c’est nous ». La salle est organisée en îlots de travail rapprochés qui favorise les échanges personnalisés, souvent en binôme. Il n’y a plus de cours, de formation, de conférence, seulement un mot de bienvenue avec un rappel des principes, de quelques faits, de la philosophie des savoirs libres, et la séance est consacrée à la contribution et à l’entraide qu’elle requiert presque inévitablement. C’est le design d’atelier dont les attributs s’apparentent le plus au tiers-lieu ou aux learning commons avec une approche basée sur la convivialité et les conversations qui soutiennent des apprentissages informels.

Après quelques séances dans une salle fermée, les participants réguliers de CSL ont jugé que les ateliers gagneraient à se dérouler dans un espace ouvert dans la bibliothèque, notamment parce que cette configuration pouvait favoriser différents degrés de participation. Les usagers de la bibliothèque qui y travaillaient étaient naturellement prévenus de la tenue d’un atelier dans les heures précédant celui-ci par l’entremise d’une signalisation appropriée, et ils avaient le loisir d’écouter (ou de se retrancher dans une zone plus silencieuse), éventuellement de se rapprocher, puis de se joindre aux activités. Ce qui s’est effectivement produit dans certains cas. Il n’y a pas eu plus d’usagers participants, mais pas moins. Dans un tel contexte, les participants du CSL n’étaient plus seulement présents pour donner une formation, mais pour contribuer aux pages et aux projets qui étaient à l’ordre du jour et de ce point de vue, les rencontres s’avéraient non seulement plus productives mais aussi plus satisfaisantes en termes de réalisation et d’apprentissage.

5. Discussion : La question des retombées et de l'évaluation de l'impact

Un modèle d’atelier et l’évaluation de l’impact. Les questions de départ étaient les suivantes: Comment pourrait-on créer une communauté créatrice de savoirs communs numériques en bibliothèque ? Comment évaluer et accroître l’impact des ateliers contributifs impliquant les bibliothèques et Wikipédia - ou plus généralement, les projets soutenus par la fondation Wikimédia ? La première question a guidé l’ensemble de cette démarche expérientielle, faites d’observations et d’analyse, et a conduit à la proposition d’une série de conditions pratiques décrivant un modèle d’atelier notamment en termes socio-spatiaux : un espace ouvert, des îlots de travail pour des petits groupes, un temps consacré à la théorie réduit au minimum versus un temps dédié à la pratique étendu au maximum; un programme thématique situé avec une résonance locale; une approche orientée sur les apprenants dans un cadre informel, où tout le monde peut servir de référent et d’aide et pas seulement les formateurs en titre. Notons que CSL a introduit une contrainte supplémentaire à ce sujet en proposant une rotation chez les formateurs : la responsabilité de la présentation est attribuée à un membre différent de CSL à chaque séance, ce qui concourt non seulement à stabiliser les connaissances, mais aussi à développer des compétences d’éditeur et de médiateur numérique, ainsi qu’une confiance, en tant que wikipédien. Les membres, bibliothécaires et libristes, si l’on veut pointer des comportements, ont adopté une pratique plus régulière en matière d’édition tout en consolidant, en tant que groupe, des habitudes de travail et en rehaussant, par itération, leur capacité de communauté éditrice dont profiteront d’autres projets par la suite.

Ces retombées au final n’ont pas été celles qui au départ avaient été anticipées par le collectif. Les objectifs qui visaient à rehausser les capacités en termes de production de savoirs communs ont été réalisés principalement du côté des bibliothécaires membres de CSL, mais sans équivalent du côté des personnels des bibliothèques ou des usagers rencontrés et à peu près sans effet sur la rétention et le nombre de contributions. On ne peut pas, pour autant, nier la sensibilisation aux savoirs communs numériques et à la contribution wikipédienne effectuée à travers ces dizaines de rencontres menées auprès des bibliothécaires-hôtes et des usagers ⎼ bien que l’on ne puisse pas rapporter des effets véritablement durables. Néanmoins, les bibliothèques de l’arrondissement du Plateau (dont la Bibliothèques Mordecai-Richler fait partie) ont initié de leur propre chef quelques ateliers wikipédiens à la suite de ce programme. On peut également penser que ces interventions auront concouru à promouvoir la bibliothèque comme actrice dans l’éducation au numérique et à changer la perception de celle-ci non plus seulement comme lieu de diffusion mais comme place de création, en adoptant un rôle en amont de la chaîne de la production des connaissances ⎼ alors qu’on la situe traditionnellement plutôt à la fin(23).

Ces retombées évoquées qui témoignent d’un succès mitigé donnent à penser que les bibliothèques publiques disposent d’un réel potentiel pour se poser comme actrices de la transition numérique et médiatrice des savoirs communs, mais que de nombreux obstacles gênent encore l’adoption d’un rôle plus significatif sur ce plan. Le problème ici résiderait dans la transition entre une culture de la prestation de services en bibliothèque qui peine à s’opérer en faveur d’une approche orientée «community-led» ou «critical librarianship», les deux étant souvent interconnectées, basées sur la triade «équité-diversité-inclusion» et structurées par le développement de capacités et la participation comme leviers d’une infrastructure de justice sociale. D’autres obstacles sont identifiés tels que des mécanismes préférentiels, ancrés dans le capitalisme, favorisant des savoirs ou des produits culturels issus du monde marchand, une compréhension stratégique approximative des enjeux numériques actuels, une maîtrise inégale des outils technologiques, le manque de personnel, etc.

À partir d’ici, cette réflexion sur l’impact se poursuivra en recourant aux catégories du modèle d’évaluation de l’impact issu de Project Outcome de Public Libraries Association (PLA) qui s’intéresse à la mesure de ce qui se fait par le biais des actions de bibliothèque, plutôt qu’à la mesure de la quantité ou de la performance (soit le nombre de participants, de contributions, etc.) reliées à celles-ci(24). Les critères d’évaluation dans le cadre de Project Outcome prennent en compte i. les apprentissages, les connaissances, ii. la confiance, iii. les transformations comportementales et iv. la perception du rôle de la bibliothèque et sa promotion. L’impact des ateliers contributifs impliquant les bibliothèques et Wikipédia ⎼ et en vue de compléter la réponse à la seconde question ⎼ pourrait être accru en tirant parti du modèle d’atelier présenté ainsi qu’en mesurant les retombées à l’aide d’évaluations inspirées de l’approche de PLA. La réflexion sur la démarche décrite a été guidée par cette approche de l’évaluation de l’impact a posteriori, mais de nouvelles initiatives gagneraient à procéder à une évaluation plus formelle en situation par le biais d’un moment réservé à la fin des ateliers, permettant aux participants de répondre aux questionnaires qui sont fournis à cet effet via la méthode de PLA.

La littératie numérique et l’évaluation de l’impact. Cette approche converge avec les constats et les suggestions que l’on trouve dans la littérature, à savoir que ce n’est pas une mesure de la performance qui importe, mais plutôt les bénéfices notamment sur le plan des apprentissages liés à l’amélioration des compétences informationnelles et numériques :

In my view, the most successful edit-a-thons are not just about producing the greatest number of citations, new articles, backlinks, and image uploads. The fact is, a significant impact on the encyclopedia itself will take time and dedication from repeat contributors, not just sporadic interjections by newbies. As wonderful and fulfilling as those first edits might be in terms of meeting educational or information literacy goals, they might only gain you a handful of quality paragraphs on Wikipedia.org. And while the Wikimedia community might be tempted to try and measure success by the number of new recruits that are converted into committed contributors and editors, I’m not sure this is the only measure of success either. Edit-a-thons can be about an unquantifiable opening of minds, and learning about where Wikipedia— and, crucially, the verifiable, factual sources it cites— fit into the modern information ecosystem. Edits happen, certainly, but the best events could just as reasonably be called “learn-a-thons.”(25)

Il faut noter que l’outil d’évaluation de l’impact dans Project Outcome comporte spécifiquement un questionnaire pour évaluer les activités de médiation numérique à court terme, à moyen terme et à long terme.

Soulignons par ailleurs, en revenant sur le sujet des politiques publiques encadrant des initiatives de cette nature, que celles-ci tendent à devenir toujours plus explicites et rendre plus prégnantes leurs raisons d’être. Depuis la tenue de ces activités, la publication d’un référentiel sur la compétence numérique(26) ainsi qu’une volonté de soutenir « l’éducation au numérique »(27) dans une perspective nationale ainsi que, incidemment, la promotion des ressources éducatives libres, offrent de nouveaux appuis qui interpellent directement les bibliothèques publiques.

L’agenda 2030 et l’évaluation de l’impact. Selon Lankes, comme nous avons vu ci-dessus, la mission de la bibliothèque consiste à faciliter la création de savoirs dans les communautés - un énoncé fortement aligné sur un projet de création de savoirs communs numériques - avec cette finalité qui l'accompagne et visant à «améliorer la société». Or, cette finalité gagne aujourd’hui à être mise en rapport et explicitée en se fondant sur le programme de l’agenda 2030 des Nations-Unis et les 17 objectifs de développement durable (ODDs) qui le composent.(28)

Déjà promoteur de la médiation wikipédienne, l’IFLA est aussi activement impliquée dans la réalisation des objectifs de cet agenda(29). Selon les initiatives, les ateliers wikipédiens sont susceptibles de figurer parmi les actions visant l’atteinte de ces ODD comme par exemple, l’objectif 2 pour une « éducation de qualité », et visant la réduction des barrières à l’accès ou l’objectif 16 touchant « la paix, la justice et les institutions efficaces » en lien avec la lutte contre les fausses nouvelles, ou encore l’objectif 17 en favorisant « les partenariats pour la réalisation des objectifs » et en soulignant les liens créées entre les communautés, et pour les communautés, par l’entremise de ces projets.

Les objectifs de développement durable de l’agenda 2030 comportent un ensemble de cibles auxquelles sont rattachés des indicateurs élaborés pour l’évaluation de l’impact et qui peuvent être mis à contribution à cette fin comme au service de la seconde question (accroissement de l'impact des bibliothèques).(30)

6. Conclusion : D’autres expériences et pistes d’action pour les savoirs communs

Nous avons exploré un modèle d’atelier numérique avec ses avantages, en termes de mise en capacité de création de savoirs communs par la contribution wikipédienne, et ses limites, quant à l’adhésion du personnel des bibliothèques-hôtes ou même de leurs usagers. Ses obstacles, avons-nous suggéré, pourraient être atténués en privilégiant certains aménagements socio-spatiaux, mais surtout un engagement communautaire intentionnellement participatif.

À la lumière de cette démarche expérientielle, d’autres pistes, dans cette mouvance, peuvent encore être pointées. D’abord, par l’entremise des associations et des écoles en sciences de l’information et des bibliothèques, il importe de continuer à discuter des opportunités de ces collaborations entre les bibliothèques et Wikipédia tout en encourageant les activités d’apprentissage et les ateliers contributifs avec des wikipédiens; de promouvoir activement les projets locaux visant à documenter et valoriser et relier les données culturelles, sociales, communautaires, historiques, territoriales; de conduire ce plaidoyer en l’insérant dans le cadre de l’agenda 2030 et d’une responsabilité socio-environnementale assumée de la part des bibliothèques. Un projet wikipédien peut, à ce titre, être abordé à la façon d’un projet-pilote permettant d’expérimenter les approches de type «community-led», où la relation et la participation avec les groupes locaux sont abordées comme des leviers critiques pour la planification, la programmation et aussi la transformation.

Dans cette perspective, et pour concrétiser cette proposition, que ce soit, par exemple, dans le cadre de la Journée du livre et du droit d’auteur ou d’autres événements, la création et l’enrichissement des contenus des pages des créateurs et créatrices, de leurs œuvres, des listes afférentes liées à la culture locale, montréalaise et québécoise offrent des avenues de collaboration qui sont étroitement en phase avec la mission séculaire des bibliothèques(31). Cette contribution aux communs de la connaissance doit s’étendre à Wikidata. Cette base de connaissances ouverte, qui centralise en données structurées, ouvertes et liées, les données créées à travers une diversité de langues et de cultures, permet, non seulement de maintenir l’information à jour à travers l’ensemble des versions linguistiques de Wikipédia, mais aussi d’assurer la présence des cultures et des savoirs locaux, voire leur existence et leur coexistence, au sein de l’environnement numérique. Et sans revenir à des questions de performance, ou de nombre de contributions ou de contributeurs, l’engagement collaboratif et la responsabilité partagée des bibliothèques publiques en réseau, de même que l’accompagnement à cette littératie des données auprès des créateurs et de leurs publics, pourraient faire une différence dans la découvrabilité de la culture locale et nationale en étendant l’accès de ces mondes à découvrir parmi les mondes connectés.

Un autre exemple de projet pourrait consister à créer une collaboration 1+1+1 en bibliothèque impliquant des wikipédiens et des groupes locaux ou des scientifiques qui sont actifs sur le plan de l’engagement écologique. Cette alliance visant à consolider la littératie à la fois numérique et environnementale, pourrait porter cette fois sur la création des articles ou l’enrichissement des contenus liés aux savoirs rattachés à ces enjeux et discutés par les climato-sceptiques. En tablant non pas sur les nuisances des innovations technologiques, mais sur le potentiel participatif de la culture numérique dans la production des contenus, leur mise en réseau et leur valorisation à grande échelle, de telles initiatives pourraient avoir des retombées politiques significatives à l’heure de la crise climatique(32). Dans cette convergence des transitions, si l’on retient ces discours, qui se jouent sur les savoirs communs, la capacité numérique des bibliothèques publiques dans une perspective autant locale, que nationale et internationale, pourrait avoir un impact non négligeable sur l’atterrissage des humains et des non-humains dans un monde durablement habitable(33).

Annexe 1

Tableau comparatif des caractéristiques des trois prototypes

Notes

(1)Dans la perspective des travaux de Donald Schön sur l’épistémologie professionnelle : The Reflective Practitioner: How professionals think in action. London: Temple Smith, 1983.

(2)Au moment de cette démarche expérientielle, j’étais bibliothécaire dans les bibliothèques de Montréal et membre du collectif du Café des savoirs libres (CSL), c’est à partir de ce double point de vue et sur la base des compte-rendus des ateliers wikipédiens de CSL que la narration est construite. Je remercie François Charbonnier, bibliothécaire et membre du CSL, avec qui le travail de synthèse relié à cette démarche expérientielle a été mené et dont certains résultats ont été présentés à l’occasion de la conférence Wikimania 2017 à Montréal :https://upload.wikimedia.org/wikipedia/commons/7/76/Pr%C3%A9sentation_wikimania_CSL_11092017fin.pdf. Je voudrais aussi remercier Pascale F. Chartier, Pierre Choffet, Marina Gallet, Danielle Noiseux, Josée Plamondon, membres réguliers du CSL, et Benoit Rochon, de Wikimédia Canada, qui ont participé et signficativement contribué à ce projet.

(3)Les premiers articles sur Wikipédia dans la littérature savante remonteraient à 2004.“The sum of all human knowledge”: A systematic review of scholarly research on the content of Wikipedia http://onlinelibrary.wiley.com/doi/10.1002/asi.23172/full /

(4)https://en.wikipedia.org/wiki/Wikipedia:GLAM/About

(5)https://fr.wikipedia.org/wiki/Jean_Talon

(6)https://commons.wikimedia.org/wiki/Category:Journ%C3%A9e_contributive_%C3%A0_l%27Universit%C3%A9_Laval,_Qu%C3%A9bec

(7)http://mile-end.qc.ca/2013/03/journee-contributive-le-mile-end-dans-wikipedia/ et https://fr.wikipedia.org/wiki/Projet:Quartier_Mile_End

(8)https://fr.wikipedia.org/wiki/Wikip%C3%A9dia:Mois_de_la_contribution/2013/Montr%C3%A9al et https://commons.wikimedia.org/wiki/Category:Journ%C3%A9e_contributive_Acfas_-_BAnQ

(9)http://www.banq.qc.ca/activites/wiki/wiki-mardi.html et https://fr.wikipedia.org/wiki/Wikip%C3%A9dia:BAnQ/Mardi,_c%27est_Wiki_!

(10)https://fr.wikipedia.org/wiki/Wikip%C3%A9dia:Caf%C3%A9_des_savoirs_libres. Toutes les activités ne sont pas documentées sur la page projet du CSL.

(11)Le projet Savoirs communs du cinéma de la Cinémathèque québécoise : https://scc.hypotheses.org/1351

(12)Une étude rapporte que 96% des instructeurs dans les milieux universitaires estiment que Wikipédia est plus utile pour enseigner la littératie de l’information que les exercices traditionnels. https://blog.wikimedia.org/2017/06/19/wikipedia-information-literacy-study/

(13) https://www.ifla.org/files/assets/hq/topics/info-society/iflawikipediaandpubliclibraries.pdf et https://www.ifla.org/node/11131

(14)Les événements #1lib1ref se déroulent même depuis quelques années à raison de deux fois par an.

(15)Lankes, R.D. (2016) Expect More.

(16)Dujol, Lionel (ed.). 2017. Communs du savoir et bibliothèques. Paris : Éditions du cercle de la librairie.

(17) http://bibliomontreal.com/abonnez-vous/wp-content/uploads/2018/03/plan_strategique_bibliotheques_mtl_20162019.pdf

(18)Les Voyageurs du code offrent des ateliers mobiles qui se constituent comme des communautés numériques. http://voyageursducode.fr/

(19)Leveraging Wikipedia : Connecting Communities of Knowledge, edited by Merrilee Proffitt, American Library Association, 2018, p.37

(20)Autrement, on peut le voir comme une occasion de créer ces liens dans l’esprit des bibliothèques dirigées par la communauté mais cette capacité communautaire est inégalement répartie dans l’approche et la culture des bibliothèques du réseau, ce qui est un enjeu.

(21)Selon l’approche de planification en collaboration avec la communauté que l’on retrouve dans la trousse d’outils également connue sous le nom de « Working Together » qui sert de référentiel pour la bibliothéconomie canadienne : https://www.vpl.ca/working-together-community-led-libraries-toolkit.

(22)Cette réflexion sur les prototypes a été amorcée dans le cadre d’une présentation réalisé avec François Charbonnier, bibliothécaire et membre du CSL, dans le cadre de la conférence Wikimania à Montréal en 2017 : https://upload.wikimedia.org/wikipedia/commons/7/76/Pr%C3%A9sentation_wikimania_CSL_11092017fin.pdf

(23)Voir à ce sujet : Berthiaume, G. (2020). “If You Want to Go Far, Go Together: The Collaboration among the GLAM Community in Canada (2016–2019).” Research Library Issues, no. 300 : 10. https://doi.org/10.29242/rli.300.2.

(24)Project Outcome : http://www.ala.org/pla/initiatives/performancemeasurement

(25)Merrilee Proffitt, ed. (2018). Leveraging Wikipedia : Connecting Communities of Knowledge, American Library Association.

(26)MEES. Cadre de référence sur la compétence numérique : http://www.education.gouv.qc.ca/references/tx-solrtyperecherchepublicationtx-solrpublicationnouveaute/resultats-de-la-recherche/detail/article/cadre-de-reference-de-la-competence-numerique/

(27)https://www.cse.gouv.qc.ca/wp-content/uploads/2020/11/50-0534-SO-eduquer-au-numerique.pdf

(28)Programme des Nations-Unies pour le développement. https://www.undp.org/content/undp/fr/home/sustainable-development-goals.html

(29)IFLA. Libraries, Development and the United Nations 2030 Agenda : https://www.ifla.org/libraries-development.

(30)Cadre mondial d’indicateurs relatifs aux objectifs et aux cibles du Programme de développement durable à l’horizon 2030. https://unstats.un.org/sdgs/indicators/Global%20Indicator%20Framework_A.RES.71.313%20Annex.French.pdf ou https://sdg.humanrights.dk/fr/goals-and-targets

(31)https://fr.wikipedia.org/wiki/Mile_End_(Montr%C3%A9al)#Livres et https://fr.wikipedia.org/wiki/Outremont#Fictions_dont_l.27action_se_situe_.C3.A0_Outremont_.28ou_qui_r.C3.A9f.C3.A8rent_.C3.A0_Outremont.29

(32)Monnoyer-Smith, L. (2017). Transition numerique et transition ecologique. Annales des Mines - Responsabilité et environnement, 87(3), 5-7. https://doi.org/10.3917/re1.087.0005

(33)Pour reprendre l’esprit du titre et le propos de Bruno Latour dans Où atterrir ? Comment s'orienter en politique. Éditions La Découverte.

Données médicales et dossiers patients comme actifs informationnels : la gouvernance de l’information dans les hôpitaux universitaires suisses

Anna Hug, Archiviste principale chez HUG

Données médicales et dossiers patients comme actifs informationnels : la gouvernance de l’information dans les hôpitaux universitaires suisses

1. Introduction

Dans cet article, nous examinons la thématique du dossier patient et des données médicales du point de vue de la gouvernance de l’information (GI), c’est-à-dire des règles qui sont mises en place pour assurer une gestion conforme des données, et ceci dans le contexte des hôpitaux universitaires suisses (HUS). Le choix du sujet découle de la réalité professionnelle de l’auteure, qui est l’archiviste principale des Hôpitaux universitaires de Genève.

Cet article est la version raccourcie d’un travail de master en sciences de l’information à la Haute école de gestion de Genève (Hug Buffo 2020). Nous invitons les personnes intéressées par le sujet à s’y référer, car les différentes thématiques y sont détaillées davantage. On y trouve notamment de nombreuses annexes (fiches descriptives des HUS, comparaison des lois cantonales, fil conducteur des entretiens, bibliographie complète, etc.).

Deux précisions terminologiques :

- Nous avons opté pour le terme « dossier patient », plutôt que « dossier médical » ou « dossier médico-soignant », pour souligner qu’il s’agit d’un outil partagé et que le patient est au centre, et non un groupe professionnel en particulier.

- Afin d’équilibrer la représentation des deux genres dans ce texte, nous utiliserons de préférence des tournures neutres et des termes épicènes. Dans les cas où cela s’avère impossible, nous alternerons entre le féminin et le masculin génériques.

Contexte de la recherche

La Suisse compte cinq hôpitaux universitaires (à Bâle, Berne, Genève, Lausanne et Zurich), qui, tout en entretenant des multiples collaborations entre eux, fonctionnent chacun selon un cadre juridique spécifique. Ils fournissent des soins de qualité à la fois dans des domaines de médecine de pointe, pour le grand public et dans le cadre de missions d’intérêt général. Ils mènent également des activités de formation, d’enseignement et de recherche. Toutes ces activités génèrent de grands volumes de données, le plus souvent sous forme numérique, qui constituent les dossiers patients.

Les multiples rôles du dossier patient

Le dossier patient est un outil indispensable dans nos institutions hospitalières. Il englobe des informations de divers corps de métiers (soignantes, médecins, professions médico-techniques…), sur différents supports (papier, microformes, radiographies, numérique…). Il permet de connaître les antécédents d’une patiente. Les informations qui s’y trouvent sont nécessaires pour la facturation des prestations et pour l’évaluation de la qualité. Pour l’individu, son dossier patient retrace une partie de sa vie – aujourd’hui, tout un chacun peut être acteur de sa santé grâce à la prise de connaissance, voire l’alimentation de son propre dossier. La science peut trouver des enseignements précieux dans les données de santé qui constituent le dossier, qu’il s’agisse de la médecine de précision (dite « personnalisée ») ou, ultérieurement, de recherches en sociologie ou en histoire de médecine.

Longtemps, le dossier patient était évidemment physique, sous forme de classeur, de fourre à rabats ou encore suspendu, et contenait des papiers divers ; certains types de documents particuliers, comme les radiographies, étaient classés à part. Puis, vers les années 1970, en raison du manque de place dans les grandes institutions hospitalières, le support a changé : le microfilmage a permis de comprimer considérablement le volume nécessaire au stockage de ces informations. Parallèlement, l’informatique se développait de plus en plus, d’abord pour les données administratives, puis progressivement pour la partie médico-soignante. Au tournant du siècle, la numérisation a pris la place du microfilmage, et de plus en plus de documents et données ont été générés directement sous forme digitale. Aujourd’hui, le dossier patient est le plus souvent « né-numérique ».

La gouvernance de l’information, pourquoi ?

La GI est une approche pour optimiser la gestion de l’information, la protéger et en tirer de la valeur, tout en minimisant les risques qui y sont associés. Cette démarche, qui doit se situer au niveau stratégique d’une institution, définit des politiques et processus transversaux, des rôles et des responsabilités. Elle pose un cadre de référence en tenant compte des obligations légales et réglementaires.

Plan de l’article

Après l’introduction (chapitre 1), nous détaillerons d’abord les objectifs et la méthodologie (2) de notre recherche, puis nous expliquerons les concepts utilisés et en donnerons les définitions (3), avant de décrire la GI avec ses tenants et aboutissants (4). Nous parlerons ensuite du contexte hospitalier suisse et des cinq institutions qui sont la cible de notre recherche (5). Nous nous intéresserons aux formes du dossier patient (6) et à son histoire (7). Nous évoquerons les diverses utilisations des données médicales (8) avant d’éclaircir quelques aspects du droit de la santé (9). Puis, nous relaterons et discuterons les résultats des entretiens menés avec des représentants des hôpitaux universitaires (10, 11). Nous démontrerons que les données médicales sont bel et bien des actifs informationnels (12), et nous proposerons une modélisation de la GI appliquée aux données médicales telle que nous l’avons perçue à travers notre recherche, et une ouverture vers des pistes de recherches futures (11). Nous conclurons par un résumé des points principaux (12).

2. Objectifs et méthodologie

Le travail de master visait à :

- décrire la typologie des données médicales dans les HUS, leur genèse et leur utilisation ;

- retracer l’évolution et les formes du dossier patient ;

- dresser le portrait des pratiques informationnelles (consignées ou implicites) en matière de gestion des données à travers leur cycle de vie ;

- décrire le contexte et les principaux enjeux de la GI, en regard des institutions examinées ;

- modéliser la GI appliquée aux données médicales, avec les compétences et fonctions nécessaires.

Pour ce faire, nous avons adopté une démarche exploratoire descriptive qualitative : nous cherchions à savoir ce qui est préconisé en matière de GI dans le domaine médical – et ce qui se fait réellement dans les HUS. Dans ce but, nous avons combiné plusieurs méthodes :

- étude de la littérature sur les sujets de la gouvernance informationnelle, de l’histoire du dossier patient et des différents enjeux liés aux données médicales ;

- étude de la documentation disponible sur les HUS et des cadres réglementaires (plus particulièrement les lois cantonales) ;

- enquête auprès des cinq HUS concernant leurs pratiques informationnelles à l’aide d’entretiens semi-dirigés.

Périmètre de l’étude et éléments de validité

Nous nous sommes concentrées sur les données médicales et n’avons pas traité les autres types de données (administratives) qui peuvent se trouver dans un hôpital : dossiers des ressources humaines, données financières, rapports de projets, brochures d’information…

Les détails opérationnels de la gestion de l’information, tels que les durées de conservation précises pour un certain type de documents, n’ont pas été étudiés. Par ailleurs, il ne s’agissait pas de comparer les HUS entre eux ni d’évaluer leur maturité en matière de GI, mais de dresser un portrait global des pratiques existantes.

Nous avons procédé à une triangulation des données récoltées, d’une part en confrontant les données récoltées lors des entretiens avec les enseignements tirés de la revue de littérature, d’autre part en comparant les réponses des HUS entre elles afin de cerner les points saillants.

Tout au long de la recherche, nous nous sommes efforcées de documenter notre méthodologie, afin de l’expliciter et de permettre une reproductibilité ultérieure.

3. Considérations terminologiques

Les données sont les plus petites unités, porteuses de sens, de l’information (InterPARES [s.d.]a). Elles sont « ce qui est connu et admis, et qui sert de base à un raisonnement, à un examen ou à une recherche » (Centre national de ressources textuelles et lexicales [s.d.]).

Lorsqu’elles sont assemblées, contextualisées, analysées, dans le but d’être communiquées, les données deviennent information (InterPARES [s.d.]b; Bennett 2017). Pour qu’elle soit de qualité, l’information doit être intègre, authentique, complète, à jour, exacte, fiable et crédible (Maurel 2013).

Un document est un ensemble constitué d'un support et de l'information qu'il porte (Direction des archives de France 2002). Il peut s’agir d’un texte imprimé sur du papier, de sons enregistrés sur CD… De nos jours, le « support » est souvent virtuel : les fichiers informatiques sont des enregistrements électroniques qui ne peuvent être lus que par l’intermédiaire d’une machine.

Un dossier est l’ensemble des documents (physiques ou numériques) réunis pour la conduite ou le traitement d'une affaire par une personne physique ou morale dans l'exercice de ses activités (Portail international archivistique francophone 2015). Le dossier patient quant à lui est « (…) une mémoire écrite de toutes les informations d’un malade, à la fois individuelle et collective constamment mise à jour » (Roger France 1982, cité dans Servais 1996) ; il doit servir à la fois aux soins, à la recherche, à la gestion de l’hôpital et à l’évaluation de la qualité des soins (Servais 1996). Les différentes législations sanitaires cantonales proposent également des définitions du dossier patient.

Terminologie hospitalière

Un hôpital est défini comme « élément d'une organisation de caractère médical et social dont la fonction consiste à assurer à la population des soins médicaux complets, curatifs et préventifs (...) c'est aussi un centre d'enseignement de la médecine et de recherche bio-sociale » (Organisation mondiale de la santé 1957).

Le système d’information clinique (SIC), aussi appelé système d’information hospitalière ou dossier patient informatisé, constitue le cœur du système d’information d’un hôpital. Il peut s’agir d’une solution globale intégrée ou d’un ensemble de systèmes indépendants. Par la dématérialisation du dossier patient, il permet une vision centrée sur les processus de soins. Les documents et données peuvent être mis à jour, consultés, interrogés et transférés instantanément, à l’interne ou à l’externe de l’institution ; les droits d’accès des utilisateurs peuvent être finement gérés afin de garantir la confidentialité des données. Le SIC peut améliorer la prise de décision clinique, p.ex. en produisant une alerte en cas d’interaction médicamenteuse dangereuse, et l’efficacité du fonctionnement de l’hôpital en centralisant les informations sur les rendez-vous ou les ordonnances (privatim 2015; Hôpital du Jura, Hôpital neuchâtelois, Hôpital du Jura bernois SA 2011; Batigne, Pozzebon, Rodriguez 2010).

4. La gouvernance de l’information

La GI cherche à optimiser la gestion de l’information, tout en respectant les obligations légales et réglementaires (compliance) et en minimisant les risques. Elle définit un cadre de référence, des politiques et processus transversaux, des rôles et des responsabilités.

Les spécialistes s’accordent à dire que la GI doit se situer au niveau stratégique d’une institution et être portée par un haut dirigeant (Smallwood 2019; Bennett 2017). La « gouvernance », ce n’est en effet pas la même chose que la « gestion » de l’information. Cette dernière s’occupe d’un aspect spécifique, opérationnel, quotidien, tandis que la GI a un caractère multidimensionnel, touchant l’ensemble du cycle de vie, en impliquant différents domaines d’activité. Anderfuhren et Romagnoli (2018) insistent sur les trois dimensions qui composent la GI : l’information vue comme ressource – l’optimisation globale et stratégique – la mitigation des risques.

Ce n’est pas la gouvernance des données, ni celle des systèmes d’information

Il y a parfois une confusion terminologique avec la gouvernance des données ou data governance. Cette dernière comporte des procédures et outils pour assurer la qualité des données (donc des éléments factuels, les unités de base de l’information) et est située à un niveau opérationnel. Il s’agit p.ex. d’assurer l’unicité d’une donnée (dédoublonnage), de gérer les données de référence (master data management) et les métadonnées. La gouvernance des données est une des parties d’une démarche GI (Butler 2017; Smallwood 2014; Perrein 2011).

La gouvernance des systèmes et technologies d’information (SI) ou IT governance, quant à elle, vise une utilisation efficace et efficiente des SI dans le but de permettre à l’institution d’atteindre ses objectifs (Gartner [s.d.]a). Il s’agit de la mise à disposition de moyens techniques en fonction de besoins exprimés par les autres métiers.

Les actifs informationnels

Les actifs informationnels ou information assets englobent tous les éléments d’information ayant de la valeur pour une institution, de manière très large et indépendamment du support : le savoir des parties prenantes (écrit ou tacite), les données structurées dans des bases, les documents non structurés numériques ou physiques, l’information publiée sur Internet ou achetée à des tiers, les systèmes d’information, etc. (Gartner [s.d.]b; Maurel 2013). Dans la démarche de GI, ils sont inventoriés et référencés pour en tirer de la valeur et les sécuriser (Smallwood 2014; Perrein 2011).

Cette valeur n’est que rarement chiffrée et ne figure pas dans le bilan d’une société (les brevets sont l'exception qui confirme la règle). Souvent, elle est créée par une utilisation novatrice des données, telles que les applications de big data. Mais l’on se rend surtout compte de cette valeur lorsqu’il y a un problème, que ce soit par un acte d’inadvertance ou criminel : la fuite d’informations confidentielles, la perte d’un document de preuve, le départ d’une personne très expérimentée. Dans le domaine médical, où les informations sont sensibles par nature, un tel problème peut être particulièrement délicat.

Un exemple récent : en septembre 2019 l’entreprise allemande Greenbone, spécialisée dans la sécurité des réseaux informatiques, a révélé que des millions de jeux de données médicales, dont de l’imagerie, étaient librement accessibles via Internet. Les serveurs de stockage et les systèmes de visualisation n’étaient en effet pas suffisamment protégés contre un accès en ligne. 52 pays étaient concernés, dont la Suisse. Greenbone estime que l’ensemble de ces données médicales a une valeur de 1,2 milliards de dollars (Greenbone Networks GmbH 2019; Meibert 2019; Chavanne, Jaun 2019).

Une approche interdisciplinaire

La GI englobe toute une série d’activités effectuées par différents acteurs (Smallwood 2019). Les spécialisations nécessaires pour mener un programme de GI vont du droit à la gouvernance des données, en passant par les systèmes d’information, le records management ou la cybersécurité.

Différentes associations professionnelles ont publié ces dernières années des standards et bonnes pratiques dans le contexte de la GI, par exemple des cadres de référence ou des modèles de maturité. Un exemple sont les Generally Accepted Recordkeeping Principles® (GARP), publiés en 2009 et mis à jour en 2017 (ARMA International [s.d.]a), complétés par le Information Governance Implementation Model qui liste les différentes briques nécessaires à une bonne GI (ARMA International [s.d.]b). L’American Health Information Management Association (AHIMA) a décliné ces standards en fonction des besoins spécifiques des institutions de santé sous les titres de Information Governance Principles for Healthcare (IGPHC) (AHIMA 2014) et Information Governance Adoption Model (Smallwood 2019).

5. Le monde hospitalier suisse et les hôpitaux universitaires

La typologie des établissements de soins en Suisse, élaboré par l’Office fédéral de la statistique, est basée à la fois sur le nombre de disciplines ou types de traitements proposés, sur les possibilités de formation médicale offertes dans l’institution et sur le nombre de cas d’hospitalisation. Elle tient donc compte non seulement de la taille de l’établissement, mais aussi de son infrastructure et du rôle qu’il joue dans une région, dans une optique de politique sanitaire (Office fédéral de la statistique 2006).

Sur les presque 300 hôpitaux qui existent actuellement en Suisse, cinq sont qualifiés d’ « universitaires » :

- Bâle : Universitätsspital Basel (USB)

- Berne : Hôpital de l’Île (Insel)

- Genève : Hôpitaux universitaires de Genève (HUG)

- Lausanne : Centre hospitalier universitaire vaudois (CHUV)

- Zurich : Universitätsspital Zürich (USZ)

Les cinq hôpitaux universitaires suisses (HUS) comptent entre 7229 et 11’945 employés et traitent annuellement entre 38'750 et 64'134 cas hospitaliers (chiffres 2019). Ils reçoivent une contribution financière de leur canton siège, notamment pour les missions d’intérêt général (dont l’enseignement), et génèrent également des revenus par leurs activités.

Certains HUS englobent la totalité des spécialités médicales ; dans d’autres cantons la pédiatrie, la psychiatrie ou encore la gériatrie relèvent d’institutions indépendantes. La gouvernance hospitalière comporte généralement un Conseil d’administration (nommé par le Conseil d’État du canton respectif) et un Conseil de direction, composé d’un directeur général et des responsables des directions transversales.

Toutes les institutions ont des systèmes d’information cliniques, achetés ou développés en interne, qui permettent de gérer les données médicales. Le dossier numérique est aujourd’hui la règle dans les cinq HUS. En analysant leurs publications, nous n’avons pas trouvé de document dédié à la GI en tant que telle, mais des éléments d’information se trouvent dans les rapports d’activité et de gestion : projets liés à l’informatique médicale, démarches d’urbanisation des systèmes d’information, mise en place du dossier électronique du patient (DEP), etc. Les sites web des institutions, à l’intention du public, ont généralement des rubriques dédiées au consentement à la recherche ou à la démarche nécessaire pour demander des copies de son propre dossier.

6. La notion de dossier patient

Comme nous l’avons déjà mentionné dans l’introduction, les raisons d’être du dossier patient sont multiples. Dans le cadre de la prise en charge, il sert à assurer la continuité de traitement et permet la transmission d’informations au sein d’une équipe pluri-professionnelle. La qualité des soins dépend directement de la qualité de l’information à disposition. La facturation des actes effectués n’est possible que si ces actes ont été documentés. Le dossier est également la base de référence pour une réserve ou un refus de prestations de la part d’une assurance, ou pour des mesures tutélaires ou de droit pénal. De même, des informations fiables et trouvables au moment opportun sont indispensables pour les autres utilisations qui en sont faites : audits, études épidémiologiques, recherches en tout genre, analyses statistiques et économiques, benchmarking entre institutions, veille sanitaire etc. (Donaldson, Walker 2004; PFPDT 2002; Servais 1996).

Pour toutes ces raisons, la documentation clinique fait donc naturellement partie du quotidien des professionnelles médico-soignantes. De nos jours l’écriture des actes peut être automatisée : des machines transmettent des données, des signaux, des images directement dans les systèmes d’information cliniques. Un cas particulier de contenus audio sont les enregistrements sur dictaphone, transcrits ultérieurement pour générer par exemple une lettre de sortie.

Comme de nombreux corps de métier interviennent à différents moments de la trajectoire du patient, et en fonction de la documentation des activités, le dossier est constitué de plusieurs parties : médicale – de soins – sociale – administrative. En cas de dossier physique, les parties peuvent être séparées par des intercalaires ou même se trouver dans différentes fourres, pour des raisons pratiques de gestion. Elles sont toutefois liées par un identifiant (p.ex. numéro de patient et numéro d’épisode de soins / de séjour hospitalier / de traitement ambulatoire). Un dossier informatique, s’il regroupe virtuellement les données en provenance de différentes sources, permet généralement d’afficher des vues par métier ; d’une part pour cibler l’information sur les besoins immédiats de la personne qui consulte, d’autre part pour respecter la protection des données.

La métaphysique du dossier

Les changements de support impliquent des changements dans la manipulation, l’organisation ou encore la perception de l’information qui y est consignée. Ces questions n’ont, à notre connaissance, pas encore été étudiées de manière approfondie, mais il paraît probable qu’il y ait une influence de la forme du dossier sur la façon de « penser » celui-ci. En effet, dans un premier temps la version numérique reproduisait simplement la structure du dossier papier. De nos jours, où les données ont pris le dessus sur les documents, il s’agit du résultat de la mise en réseau des différents modules du système d’information clinique, assemblé et affiché selon diverses manières, en fonction de l’interrogation du moment ; le numérique crée de nouveaux narratifs de « l’histoire patient ».

7. Histoire du dossier patient – exemple des HUG

L’évolution du dossier patient jusqu’au 20ème siècle est assez bien étudiée, du « Corpus Hippocraticum » de la Grèce antique jusqu’aux registres d’entrées et de sorties dans les premières cliniques modernes, en passant par les échanges épistolaires entre médecins médiévaux. En revanche, à notre connaissance, il n’existe que très peu de publications qui relatent (partiellement) l’histoire récente du dossier patient en lien avec l’évolution technologique des dernières décennies. Par conséquent et à titre d’exemple, nous expliquons ici brièvement ces mutations telles qu’elles se sont passées aux Hôpitaux universitaires de Genève (HUG).

Les microformes

Un premier changement de support intervint à partir des années 1970 : les activités de l’hôpital ayant augmenté exponentiellement, on manquait d’espace pour le stockage des dossiers. Certains services médicaux décidèrent alors de remplacer les dossiers papier par des microformes (microfilms ou microfiches). Cette technologie, qui existe depuis les années 1850 déjà, permet de reproduire les pages du dossier, en version réduite, sur un support en pellicule photographique. Plusieurs dizaines de pages A4 tiennent ainsi sur une microfiche de taille A6. Des appareils de lecture permettent de visionner les documents, voire de les réimprimer. Aux HUG, la centrale de microfilmage était active de 1975 à 2005 et traita jusqu’à 1,7 millions de pages par année.

Les premières applications d’informatique médicale

Dès 1972 l’application DIOGENE, développée en interne, était utilisée pour diverses tâches administratives aux HUG, telles que la gestion du personnel ou la facturation. À partir de 1978 elle gérait également les admissions et les identités, permettant ainsi de maîtriser la trajectoire du patient du point de vue administratif. Progressivement, d’autres applications étaient développées pour former un véritable écosystème d’informatique médicale : gestion des examens de laboratoire (dès 1988), production de documents à partir des données DIOGENE (dès 1993), etc. En 2000, les différents volets médicaux et infirmiers furent intégrés dans un seul dossier : c’était la naissance du DPI (cet acronyme signifiant « dossier patient intégré », pas « informatique » comme on pourrait le croire). En 2004, DPA, le « dossier patient administratif », fut déployé, intégrant DIOGENE avec les applications administratives utilisées en gériatrie et en psychiatrie.

Par la suite, le DPI fut constamment élargi par des modules supplémentaires, des nouvelles vues furent développés en fonction des besoins métiers, ainsi que des applications annexes telles que la prescription informatisée, la gestion des blocs opératoires, etc. Ces centaines de réalisations mineures ou majeures permirent de forger le DPI d’aujourd’hui, devenu indispensable aux professionnelles de santé des HUG.

La numérisation et les dossiers nés-numériques

Dès 2000, une obsolescence à moyen terme de la filière microfilm était reconnue. On proposa alors la mise en place d’un système de gestion électronique des dossiers patients, en remplaçant le microfilmage des pages par la numérisation. L’avantage était notamment un accès facilité aux informations, sans nécessité de transporter un dossier physique. En 2006 la centrale de numérisation (CN) entra en service.