N°11 décembre 2010

Sommaire - N°11, Décembre 2010

Etudes et recherches :

- De la recherche d’informations hautement spécialisées : le cas de la recherche d’informations dans les brevets de chimie - Patrick Ruch

- La homepage dans la communication des hôpitaux suisses francophones - Pablo Medina Aguerrebere

Comptes-rendus d'expériences :

- Le rôle de la BN au niveau international - Genevieve Clavel-Merrin

Evénements :

- Le stand des sciences de l’information et de la bibliothéconomie au salon du livre de Francfort - Rahel Birri Blezon, Laure Fallet, Lucile Grandjean, Chantal Pink, Nicolas Prongué

- 11. Inetbib-Tagung an der ETH Zürich - Rahel Birri Blezon

Ouvrage paru en science de l'information :

- Les archives dans l’université : Colloque international, Université de Lausanne, 30 et 31 octobre 2008 - Lorraine Filippozzi

Editorial n°11

Editorial n°11

Avec ce numéro 11 nous inaugurons un nouveau mode d’hébergement (basé sur le CMS Drupal), que nous devons à Marylène Goulet, Cédric Pella et Maurizio Velletri, trois étudiants du Département Information documentaire de la Haute école de gestion de Genève.

Dans notre dernier numéro, nous lancions un appel à communications à la communauté suisse des professionnels de l’information.

Nous interrogeant sur l’avenir de RESSI nous avons donc décidé d’impliquer plus fortement les jeunes professionnels de l’information en leur donnant une part plus active dans la gestion administrative de la revue. Le Comité de rédaction va travailler en plus étroite collaboration avec les étudiants du Département Information documentaire de la HEG.

Jacqueline Deschamps quitte le poste de rédactrice en chef mais reste dans le Comité de rédaction.

RESSI va garder son statut de revue scientifique, mais ne paraîtra qu’une seule fois par année. Elle fera partie d’une plateforme plus interactive, qui comprendra des lettres d’information spécialisées –comme Alpes et Snaf- et un accès à la liste Swiss-lib, ainsi que de nouvelles rubriques, où chacun pourra s’exprimer et donner ses réactions sur une contribution.

Cette nouvelle plateforme, qui sera opérationnelle en 2011, a pour objectif de devenir un site d’information sur la science de l’information en Suisse tout en devenant un outil pédagogique valorisant les meilleurs travaux des étudiants.

Dans ce 11e numéro, vous trouverez sous la rubrique « Études et recherches » deux contributions. Une étude de Patrick Ruch de la Haute école de gestion de Genève sur La recherche d’informations hautement spécialisées : le cas de la recherche d’informations dans les brevets de chimie. Malgré les divers outils de recherche à disposition, un certain nombre de contenus restent plus difficilement accessibles. Le corpus formé par les brevets de chimie constitue un terrain de recherche que l’auteur explore par les méthodes de recherches d’informations textuelles et le modèle proposé obtient des résultats hautement compétitifs.

La seconde étude est proposée par Pablo Medina Aguerrebere, de l’Université de Navarre, sur La homepage dans la communication des hôpitaux suisses francophones. Cet article relate une recherche dans laquelle l’auteur analyse plusieurs pages d’accueil d’hôpitaux suisses afin de voir comment les institutions organisent l’information destinée au public et si l’on pourrait l’améliorer.

Sous la rubrique « Expérience professionnelle », Geneviève Clavel-Merrin de la Bibliothèque nationale à Berne présente Le rôle de la Bibliothèque Nationale au niveau international. L’auteur nous présente les différentes collaborations de la BN, à l’échelon international, que ce soit dans les associations professionnelles ou dans la participation à des projets européens.

Sous la rubrique « Événements », Karine Pasquier de la Haute école de gestion de Genève nous livre un compte-rendu de la 7e journée franco-suisse en Intelligence économique et veille stratégique sur le thème « Intelligence économique et prospective : la veille permet-elle d’anticiper les ruptures ? Cette rencontre qui a eu lieu le 10 juin 2010 à Genève réunit annuellement des universitaires, des professionnels des entreprises et des étudiants sur des thèmes aussi bien théoriques que pratiques. Cette année, la journée a permis d’aborder des thèmes comme l’interprétation des signes d’alertes précoces, la veille concurrentielle et la veille sociétale et l’opposition monde réel et monde virtuel. Veille, rupture et anticipation étaient les maîtres mots de la journée avec en arrière-plan l’affirmation qu’une société stable ne veut pas changer mais le doit de toute façon.

Finalement, vous pourrez lire un compte-rendu sur la mise en place d'un stand des sciences de l'information et de la bilbiothéconomie qui a eu lieu au dernier salon du livre de Francfort ainsi qu'un article en allemand sur la 11e journée InetBib qui a eu lieu cette année à l'Ecole polytechnique fédérale de Zürich.

Sous la rubrique « Ouvrages parus en Science de l’information », Lorraine Filippozzi, de la Haute école de gestion de Genève, nous propose la recension d’un ouvrage sur le colloque : Les archives dans l’université : actes d’un Colloque international, Université de Lausanne, 30 et 31 octobre 2008. Ce colloque a fait date dans la communauté archivistique suisse en répondant à deux questions cruciales : comment l’environnement universitaire nourrit la pratique archivistique et comment le service des archives peut-il enrichir l’image de son université ?

Nous inaugurons avec cette plateforme plusieurs fonctionnalités que le précédent hébergement ne permettait pas. Vous pourrez, entre autres, commenter les articles publiés et vous abonner au flux RSS d'information.

Nous remercions tous les auteurs qui ont contribué à ce numéro. Nous remercions également les membres du Comité de lecture qui s’acquittent de leur tâche toujours consciencieusement. Nous invitons les lecteurs à nous proposer des articles et par avance nous les en remercions.

Le Comité de rédaction

De la recherche d’informations hautement spécialisées : le cas de la recherche d’informations dans les brevets de chimie

Patrick Ruch, Haute Ecole de Gestion, Genève

De la recherche d’informations hautement spécialisées : le cas de la recherche d’informations dans les brevets de chimie

1. Introduction

Pour la plupart d’entre nous, professionnels de l’information ou citoyens profanes de la société éponyme, la notion de recherche d’information évoque spontanément l’usage de moteurs de recherche portant sur des contenus du web, que nous utilisons quotidiennement pour de nombreuses tâches, dont certaines sont en effet assimilables à de la recherche d’information, la recherche d’information dans des données financières (Yahoo! Finance) ou dans une collection de messages électroniques.

S’il est difficile de caractériser précisément ces différents usages, tant il est désormais possible de mélanger d’une manière transparente pour l’utilisateur l’ensemble des flux de recherche, on peut toutefois observer qu’un certain nombre de contenus demeure plus difficilement accessible via ces outils. Parmi ces contenus, les scientifiques de nos Hautes Ecoles ont remarqué à quel point les bibliothèques scientifiques, dont certaines sont pourtant indexés par ces outils, sont mal représentées dans les résultats retournés par ces mêmes outils. C’est là un paradoxe qui mérite d’être remarqué et qui est bien documenté en tout cas pour le domaine biomédical. En effet, la charge d’un moteur de recherche comme PubMed et des autres moteurs et ressources mis à la disposition par l’institution hôte de PubMed, le NCBI, ne fait que croître avec plus d’un million d’accès quotidiens. Encore plus remarquable, l’arrivée de nombreuses alternatives à PubMed, telles que la GlobalHealthLibrary (http://www.globalhealthlibrary.net/php/index.php), supportée par l’OMS, SRS (Sequence Research System ; http://srs.ebi.ac.uk/), maintenu par l’EBI (European Bioinformatics Institute), ou EAGLi (Engine for Answering questions in Genomic Literature : http://eagl.unige.ch/EAGLi/), développé à Genève, avec des spécialisations toujours plus poussées (e.g. génomique), suggère que l’accès réel à MEDLINE via des moteurs très pointus est largement sous-estimé par les statistiques d’accès au seul moteur PubMed.

Le succès des moteurs dédiés à MEDLINE peut s’expliquer pour différentes raisons. D’abord, ces outils spécialisés fournissent au chercheur des méthodes de recherches adaptées spécifiquement à l’information disponible dans la bibliothèque médicale, ce qui permet d’optimiser la pertinence des recherches par rapport à un moteur généraliste, plutôt adapté à une topologie documentaire du type web et aux protocoles basés sur les hyperliens (Brin and Page 1998). Ensuite, ces outils spécialisés ont innové en mettant à la disposition du chercheur un ensemble de ressources de navigation spécifiques, accessibles via un treillis de liens croisés vers un certain nombre de bases de connaissances du domaine. C’est notamment le cas de PubMed, qui n’est qu’une source parmi des douzaines de bases de données, bibliothèques, et vocabulaires contrôlés, mis à disposition du public par le NCBI (National Center for Biotechnological Information : http://www.ncbi.nlm.nih.gov/), directement rattaché à la NLM (National Library of Medicine) du NIH (National Institute of Health). On retrouve ce modèle avec EBIMed et EAGLi qui peuvent renvoyer directement l’utilisateur vers des bases de connaissances telles qu’UniProt (Bairoch et al. 2005) en fonction du contenu informationel proposé par ces moteurs.

Enfin, le succès de ces moteurs hautement spécialisés s’appuie sur le dynamisme d’une communauté de chercheurs, qui a parfaitement suivi, et bien souvent conduit les développements les plus avancés des sciences de l’information, avec l’avènement d’un champ spécialisé appelée bioinformatique. La bioinformatique suit maintenant une voie qui lui est propre, avec une richesse conceptuelle et une productivité opératoire et scientifique proprement vertigineuse aboutissant à des « ruptures » épistémologiques d’une fréquence sans précédent dans l’histoire des sciences et des techniques. On peut citer l’avènement de « nouvelles » sciences telles que la génomique, qui porte sur les gènes ; de la protéomique, qui porte sur les protéines ; de la métabolomique, qui porte sur des molécules plus petites que les gènes et produits de gènes ; et enfin, de la bibliomique, qui utilise la littérature pour étudier les autres « omiques » (Grivell 2002) !

S'il est permis de douter que toutes ces spécialités et domaines de recherche pourront acquérir la stabilité nécessaire à leur transformation en sciences normales autonomes, force est de constater que le modèle historique du développement scientifique, basé sur la remise en cause radicale de paradigmes scientifiques, tels que définis par Kuhn (1962) semble remis en cause par la rapidité à laquelle biologie moléculaire et informatique synthétisent de nouveaux champs de recherche.

Dans ce contexte, la littérature scientifique joue clairement un rôle central avec une activité importante, comme en témoigne le million de requêtes quotidiennes reçues par PubMed. Relativement plus discrètes et comparativement moins visibles, bien que tout aussi importante, les bibliothèques de brevets et leurs moteurs de recherche (e.g. esp@cenet) ont reçu récemment une attention particulière. En effet, celles-ci ont la particularité d’être à la fois relativement universelles dans leurs couvertures et hautement spécialisées dans leurs contenus. Alors que la lecture d’un brevet en chimie ou en électronique demande des connaissances pointues, on observe que les grandes bases de données de brevets (e.g. EPO, European Patent Office : http://www.espacenet.com/access/index.en.htm ou USPTO, US Patent and Trademark Office : http://www.uspto.gov/patents/process/search/index.jsp) couvrent à peu près la totalité du spectre techno-scientifique, tel que représenté par la classification internationale des brevets, qui totalise environ 70'000 descripteurs. Cette spécialisation, tant au niveau des bibliothèques dans le domaine des sciences de la vie que des bases de données de brevets, constitue une singularité remarquable vis-à-vis de cette autre grande source d’information documentaire que constitue le web.

Nous pensons en particulier que dans le type de contenus que sont les brevets, la spécialisation requise est de nature à limiter l’hégémonie observée dans le monde des moteurs de recherche du web. Remarquons que l’expertise méthodologique à mettre en œuvre appartient au corpus classique de la science de l’information (Capurro & Hjorland 2002) autour de concepts théoriques liés à recherche d’information (indexation, méta-données, expansion de requête, jugements de pertinence…), à la bibliométrie (citations, facteurs d’impact...), et à l’usage des langages documentaires (descripteurs, ontologies…). Cette expertise, qui constitue l’un des piliers de la formation dans la filière information-documentaire, notamment dans sa spécialisation en systèmes d’informations, suffit au développement d’outils avancés susceptibles de rivaliser avec des outils commerciaux. Dans le cadre d’une procédure expérimentale très contrôlée et dédiée à une tâche particulière, à savoir une tâche de génération automatique de la bibliographie décrivant l’état de l’art d’une invention – aussi appelé recherche d’antériorité – nous verrons comment une combinaison holistique de ces différentes composantes (indexation, méta-données, citations…) permet de développer un moteur de recherche original et performant.

L’exposé se déclinera comme suit : tout d’abord, nous présentons brièvement les Text Retrieval Conferences, qui servent de cadre à l’étude que nous avons réalisée ; ensuite, nous décrivons les données utilisées pour nos expériences ; puis nous détaillons la méthodologie de développement du moteur de recherche ; enfin nous récapitulons les résultats obtenus dans le cadre de la campagne d’évaluation TREC que nous discutons avant de conclure notre article.

2. Text Retrieval Conferences

Partant du constat que ni les moteurs de recherche d’informations dans MEDLINE, ni les outils d’interrogation de bibliothèques de brevets n’avaient été affectés par l’avènement des moteurs de recherche du web, les organisateurs des TRECs (Text Retrieval Conferences) décidèrent dès 2002 de s’intéresser à cette question.

2.1 Un peu d’histoire

Chaque année depuis plus de vingt ans, les agences gouvernementales NIST (National Institute of Standards and Technology) et DARPA (Defense Advanced Research Projects Agency) organisent les Text Retrieval Conferences (TREC, http://trec.nist.gov/), une campagne d'évaluation pour mesurer les avancées dans le domaine de la recherche d'informations. Les laboratoires des universités les plus prestigieuses, ainsi que les centres de recherches des sociétés les plus actives du web (Microsoft, Google, Yahoo...) participent régulièrement à ces compétitions, que les agences nord-américaines de financement de la recherche suivent également avec attention.

Héritières du Cranfield paradigm (cf. Capurro et Hjorland 2002), les campagnes d’évaluations TREC reposent sur le développement d’une collection (benchmark) contenant trois composantes : un ensemble de requêtes ; un corpus de documents ; des jugements de pertinence associant chaque requête avec un ou plusieurs documents jugés « pertinents ».

2.2 Recherche documentaire spécialisée

Ainsi, entre 2002 et 2007, diverses tâches de recherche d’informations dans la bibliothèque numérique MEDLINE furent-elles proposées et évaluées dans le contexte de la « Genomics track ». Plus récemment, en 2009, une tâche de recherche d'information dans une base documentaire de brevets de chimie fut proposée (« Chemical patent retrieval track »). Dans ce dernier cas, il s'agissait de modéliser une tâche d'analyse de l'état de l'art (prior art search), telle que pratiquée communément par les déposants de brevets, ainsi que par les experts des bureaux de brevets, employés à l’EPO (European Patent Office), USPTO (United States Patent and Trademark Office), ou plus proche de nous à Berne à l’IFPI (Institut Fédéral de la Propriété Intellectuelle). Pour la première année, la tâche attirait une quinzaine d’institutions privées et publiques à la distribution géographique très variée dont Carnegie Mellon University, Dalian University of Technology, Erasmus University, Fondazione Ugo Bordoni, Fraunhofer Institute, Haute Ecole de Gestion, MerckSerono, Milwaukee School of Engineering, Purdue University, Salalah College of Technology, TGN Corporation, University of Alcala, University of Iowa, York University. Une présentation détaillée des procédures d’évaluations, des métriques, et des résultats officiels se trouve dans Lupu et al., 2010.

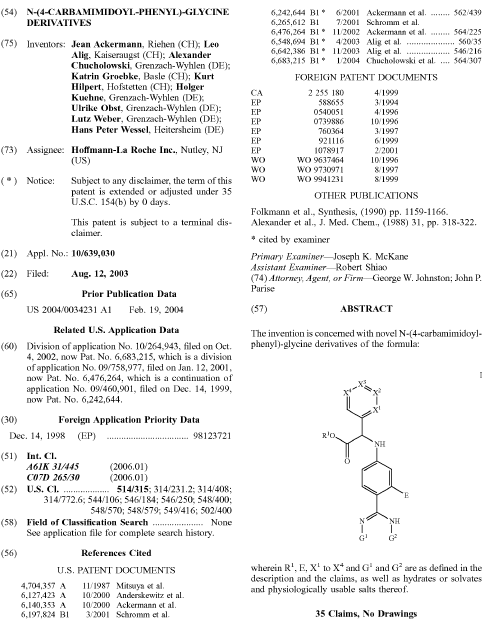

3. Données

Une collection de 1.2 million de brevets au format XML est fournie par les organisateurs. Le total représente un peu moins de 2 millions de documents, incluant les différentes versions d’un brevet (version initiale ou après examen) et les fichiers associés, dont des images (tableau, structures chimiques, images…) et des séquences de nucléotides. Avec ce montage expérimental, les jugements de pertinence, qui relient les requêtes aux documents de la collection, sont directement disponibles sans qu’il soit nécessaire de procéder à des évaluations par des experts, lesquelles sont coûteuses et difficiles à mettre en place. Un exemple de document contenant certains des champs les plus significatifs d’un brevet est fourni en Figure 1. Nos réglages préliminaires suggéraient que certains champs présentaient un intérêt particulier pour la recherche d’informations, notamment le Titre, la Description (le champ le plus long) ; le Résumé, les « Claims » (ou Revendications), les codes IPC (International Patent Classification). Un exemple de références bibliographiques, utilisées comme jugements de pertinence pour l’évaluation, se trouve également en Figure 1 (section 56 : « References Cited » ). Les champs Inventeur et Applicant ne furent arbitrairement pas retenus. Nous verrons dans la discussion que certains de ces choix méritent d’être questionnés a posteriori.

Figure 1 : Exemple de brevets avec certains des champs les plus significatifs.

En plus des requêtes utilisées pour l’évaluation officielle, pour lesquels les jugements de pertinence étaient finalement mis à disposition des compétiteurs après l’évaluation officielle, une collection de cinq cents requêtes avec jugements de pertinences était fournie pour le développement des moteurs de recherche.

4. Méthodes

Dans cette section, nous présentons les principaux éléments de notre stratégie de recherche. Une présentation plus détaillée est disponible dans Gobeill et al. 2009 et Gobeill et al. 2010. Afin de développer la stratégie de recherche et régler la combinaison des différents modules, nous cherchons à maximiser une fonction objective : la précision moyenne. Notre système de base utilise un moteur de recherche vectoriel (Ruch 2006). Avec un tel outil et après le calcul des paramètres traditionnels tels que le choix du schéma de pondération et son réglage, nous obtenons une Précision Moyenne (PM) de 0.051.

4.1 Représentation des requêtes et des documents

En ce qui concerne la base documentaire, la première étape consiste à la condenser. En effet, pour des raisons d’efficacité (réduction de volume des index, temps de réponses…), il est fréquent qu’une partie seulement d’un document soit indexée. En particulier, la Description du brevet devait être réduite. Après différentes tentatives de condensation plus ou moins fructueuses sur critères statistiques et positionnels, il apparaît rapidement qu’un retrait pur et simple de cette section amène un gain de 30% (PM de 0.067). Un « raciniseur » de type Porter légèrement modifié (van Reijsbergen et. al. 1980), et une liste de mots-outils d’environ 500 mots sont utilisés en complément pour réduire la taille de l’index (Dolamic and Savoy 2010).

Plus systématiquement, nous évaluons ensuite la contribution individuelle de chacun des champs du brevet à la recherche de l’état de l’art. Cette contribution est évaluée relativement au système combinant tous les champs d’un brevet, à l’exception de la description, que nous utilisons comme modèle de Référence. Dans le Tableau 1, nous voyons l’impact du retrait d’une section particulière du brevet section par section.

Tableau 1 : Precision moyenne selon les champs retenus.

|

Référence/Champs retirés |

MAP |

|

Référence |

0.067 |

|

Title |

0.066 |

|

Abstract |

0.063 |

|

Claims |

0.036 |

|

IPC 4-digits codes |

0.055 |

|

IPC complete codes |

0.058 |

On constate que le retrait de la section “Claims”, qui contient la liste des innovations apportées par l’invention, fait chuter la précision moyenne de près de 50%, de 0.067 à 0.036. Plus conforme à l’intuition (Tseng and Wu 2008), le retrait d’autres éléments du brevet comme le titre représente un impact clairement moindre. Le retrait du résumé constitue également une perte d’information relativement faible. En comparaison, le retrait des codes IPC affecte plus significativement les résultats. Symétriquement, au niveau des requêtes, la même sélection est appliquée et les mêmes champs sont utilisés, à l’exception notable de la description, qui est conservée pour les requêtes. En effet, nous observons que dans les requêtes, un gain de 3% est mesuré lorsque la description est présente sans que nous ne soyons en mesure pour l’instant d’expliquer une telle dissymétrie entre la requête et la collection.

4.2 Modèle de recherche

Les expériences sont effectuées avec un schéma de pondération probabiliste dont le réglage fin nous permet d’atteindre une PM de 0.073 ; cf. Gobeill et al. 2009 pour une présentation détaillée des réglages statistiques. En complément du résultat ordonné fourni par la recherche d’information probabiliste, nous explorons deux stratégies supplémentaires : le filtrage selon la classification internationale des brevets, et le reclassement selon le nombre de citations de chaque brevet.

En ce qui concerne l’utilisation des descripteurs IPC, certains spécialistes (Sternitzke, 2009) de l’analyse de l’état de l’art (recherche d’antériorité), prétendent qu’une recherche sur un code IPC à 4 valeurs permet de collecter la totalité de l’état de l’art. Plus modestement, d’autres (Criscuolo and Verspagen 2008), affirment qu’entre 65% et 72% de l’état de l’art est collecté avec une telle requête.

Nous décidons d’observer l’impact d’un algorithme prenant en compte directement l’information fournie par le codage IPC. Notre approche est simple, voire simpliste : nous évaluons une stratégie retirant les brevets ne possédant aucun code similaire au brevet utilisé en requête. Dans cette expérience, nous faisons l’hypothèse que le brevet-requête a reçu manuellement des codes IPC. Cette hypothèse est discutable, dans la mesure où l’inventeur déposant un nouveau brevet a rarement procédé à l’attribution des catégories IPC ; toutefois, cette hypothèse est acceptable dans le cas d’une recherche de l’état de l’art faite par un professionnel, employé d’un office national de brevets, dans la mesure où cette démarche est spontanée dans la profession et que de nombreuses formations et quelques outils informatiques sont disponibles pour aider à effectuer de telles tâches (Teodoro et al. 2010). La procédure est évaluée sur le codage partiel (classe et sous-classe), ainsi que sur le codage complet. Dans le Tableau 2, on observe que l’utilisation des descripteurs IPC semble dégrader significativement la capacité du système à générer automatiquement l’état de l’art. Ce résultat est d’autant plus surprenant qu’un gain de précision dépassant 10% (Gobeill et al. 2010) avait été observé avec cette même procédure de filtrage quand une collection de brevets non spécifiquement chimiques est utilisée ! Bien que des études plus fouillées seront probablement nécessaires pour expliciter un tel phénomène, on serait tenté de penser que les méta-données que représentent les classes IPC sont trop génériques pour un domaine scientifique aussi vaste – et donc spécifique – que la chimie. Il conviendrait également d’analyser la distribution des brevets dans la collection que nous utilisons pour ces expériences et celles utilisées par Gobeill et al. 2010, et en particulier les proportions respectives de brevets USPTO vs. EPO dans ces deux collections.

Tableau 2 : Précision moyenne (MAP) selon différentes stratégies de filtrage utilisant les codes IPC.

|

MAP |

IPC filtering strategy |

|

Baseline |

0.073 |

|

4-digits IPC codes |

0.074 (-3%) |

|

complete IPC codes |

0.071 (-8%) |

Une hypothèse alternative serait que la qualité et la consistance du codage IPC pour la chimie serait moindre que dans d’autres domaines technologiques. Des expériences sont menées actuellement à la HEG afin de vérifier la qualité relative des modèles de codage IPC dans différents domaines technologiques (Teodoro et al. 2010).

4.3 Réseau bibliographique et expansion automatique

Les derniers contenus informationnels utilisés pour améliorer notre stratégie de génération automatique de bibliographie d’un brevet consistent en substance à privilégier les brevets les plus cités dans l’ensemble de la collection d’une part, et à utiliser des procédures de reconnaissance et d’expansion de termes décrivant des entités chimiques, d’autre part.

Le classement des brevets selon le critère des citations est trivial d’un point de vue computationnel. Il s’agit de classer chaque brevet selon le nombre de citations qu’il obtient dans la collection. Ensuite on combine ce classement statique et indépendant du contenu de la requête avec le classement déjà obtenu à partir du résultat retourné par le moteur de recherche. Cette combinaison linéaire ne doit pas donner trop d’importance aux citations sans quoi chaque requête serait plus ou moins associée au même ensemble de brevets, celui des brevets les plus cités. Empiriquement, nous observons qu’une pondération 10/90 – qui ne donne qu’un dixième d’importance aux citations – fournit les meilleurs résultats. Les performances ainsi obtenues sont impressionnantes avec un gain de + 168%, pour une précision moyenne atteignant 0.179. Ici encore le cas de la chimie est particulier puisque dans une collection de brevets couvrant l’ensemble des technologies, le gain escompté via une telle approche est seulement de +3% (Gobeill et al 2009).

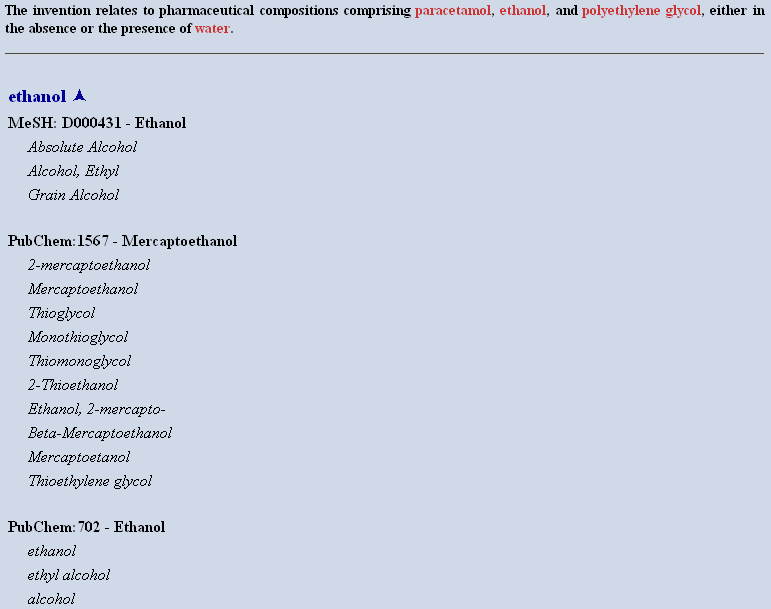

En ce qui concerne l’expansion des noms de composés chimiques, la méthode utilise trois étapes : la reconnaissance (ou étiquetage) des frontières d’entités ; la normalisation de ces entités ; et enfin, l’expansion des entités chimiques reconnues via des synonymes. Cette dernière étape utilise des ressources ontologiques et terminologies gratuites telles que PubChem, DrugBank, OBO, UMLS ou chEBI. Un exemple de la procédure de reconnaissance-normalisation est fourni dans la Figure 2. Cette chaîne de traitement modulaire, appelée ChemTagger, indépendante du moteur lui-même, constitue un puissant outil d’expansion de requête, dont une version simplifiée est disponible publiquement pour démonstration via une interface web (http://eagl.unige.ch/ChemTagger/).

Figure 2 : Exemple de procédure de reconnaissance (partie supérieure : texte annoté par des balises XML faisant apparaître chaque composé chimique en rouge) et normalisation (partie inférieure proposant un identifiant unique dans une base de connaissance telle que le MeSH ou PubChem) pour un court passage extrait du brevet # USPTO 6423749. [« A » et « B »]

L’utilisation du ChemTagger lors des évaluations officielles permet une amélioration d’environ 3% pour une précision moyenne de 0.182. Une telle amélioration est certes statistiquement significative mais somme toute assez modeste en regard de la complexité de la procédure d’expansion et de la richesse des ressources terminologiques mobilisées. L’un des problèmes relevé concerne la liste des synonymes fournis par les différentes bases de connaissances utilisées. En effet, afin de ne pas dégrader les performances globales du moteur, seul un nombre restreint de synonymes, si possible les plus communément utilisés, est ajouté automatiquement. Or, pour utiliser pleinement le ChemTagger, il conviendrait plutôt de privilégier un usage interactif, permettant à l’expert de valider et ainsi de contrôler l’expansion. Alternativement, on pourrait essayer de générer un enrichissement automatique de la liste de synonymes avec des informations permettant d’estimer la qualité d’un synonyme particulier, comme proposé récemment par Yepes 2009.

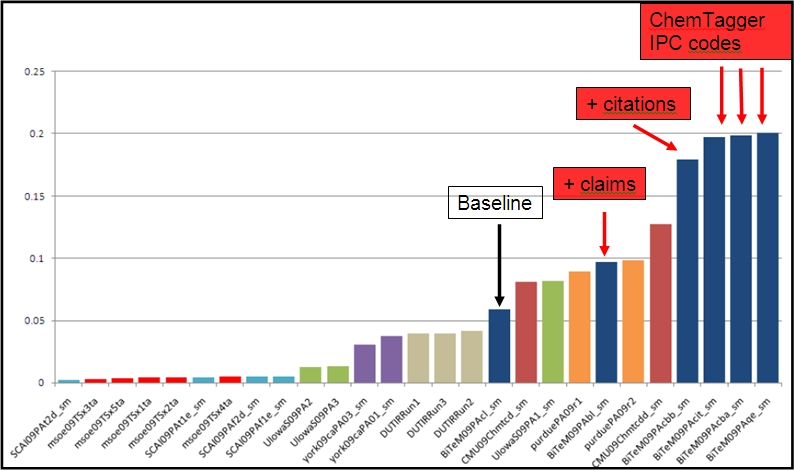

5. Discussion

En termes de comparaison internationale, notre modèle de recherche d’informations obtient des résultats plus que satisfaisants, comme l’illustre la Figure 3, où l’on voit quatre de nos modèles se placer en tête des compétitions officielles TREC 2009. Ces résultats, bien que réjouissants, doivent toutefois être relativisés si l’on considère que nos précédentes participations tendent à montrer que la première année d’une tâche présente souvent les résultats les plus contrastés. Ensuite, les rapports techniques publiés par les participants tendent à faire converger les meilleures approches après quelques itérations autour d’un plafond de précision qui représente l’optimal de la technologie à un moment donné.

Figure 3 : résultats officiels de la compétition TREC 2009 mesuré par la précision des trente premiers brevets retournés (precision@30), extrait de Lupu et. al., 2009).

Notre second constat porte sur l’idée reçue que l’avancée technologique des différents moteurs de RI du web et notamment du plus populaire d’entre eux, va peu à peu remplacer les tâches traditionnellement confiées aux professionnels de la recherche d’informations dans plus ou moins toutes les composantes de leurs activités, dont l’indexation matière, et qu’il est temps de former les futurs professionnel à des tâches alternatives, telles que la médiation (Galaup 2010) ou la redocumentarisation (Salaün 2008) dont la traduction en terme d’activités pratiques nous semble relativement peu claire. Si l’utilité de tâches telles que l’indexation-matière, et la maintenance de ressources terminologiques qu’elle nécessite, est questionnable, il est important que le questionnement ait lieu sur la base d’observations solides. A ce jour, l’importance du rôle des descripteurs assignés manuellement pour effectuer des recherches d’information est variable. Ainsi, dans les bibliothèques de brevets généralistes (Gobeill et al. 2009b) et les bibliothèques digitales médicales (cf. Ruch et al. 2005 ; Abdou et al. 2006), l’importance des descripteurs semble confirmée avec des gains de précision significatifs supérieurs à 5% (p<0.01). Inversement, le rôle de tels descripteurs dans le cas des brevets de chimie utilisés dans nos expériences n’est pas confirmé. En d’autres termes, la question n’est pas pour ou contre l’indexation-matière et les thésaurus mais bien de se donner les moyens méthodologiques de mesurer quantitativement l’apport d’un thésaurus particulier, utilisé pour indexer une collection particulière, permettant de répondre à un type de question particulier.

Devant les tentatives plus ou moins abouties de redéfinition des tâches du professionnel de l’information documentaire, il est impératif de discuter – résultats à l’appui – de l’apport informationnel que représentent les descripteurs attribués manuellement par les professionnels de l’information documentaire. Dans tous les cas, l’utilité d’une tâche (e.g. indexation matière) ou d’une ressource (e.g. thésaurus, descripteurs…) doit être évaluée selon des méthodes scientifiques dans un environnement contrôlé (requêtes, collections…) ; sans quoi on risque le bavardage ou bien le triomphe de la doxa.

Par contraste, l’importance des réseaux de citations, tel que proposés originellement par Eugene Garfield (e.g. Garfield 2006), semble particulièrement critique pour les brevets de chimie. On trouve, en effet, dans la collection TREC des brevets partageants des dizaines, voire des centaines de citations, notamment lorsque les inventeurs sont similaires. En terme d’impact sur l’analyse d’antériorité, cette dimension semble donc fondamentale dans le cas de la chimie, sans qu’il soit, à notre connaissance, possible d’expliquer cette spécificité. Au final, on observe que les thésaurus et autres ontologies propres à la chimie, alliées à des outils de traitement automatique de la langue, peuvent constituer un vivier d’améliorations riches mais relativement complexe à exploiter.

Ces résultats sont donc intéressants à bien des égards, notamment scientifiques, toutefois on peut se demander ce que de telles études amènent à la communauté des recherchistes et autres scientifiques de l’information travaillant dans le domaine de la propriété intellectuelle pour les hautes technologies. Cette question aussi légitime que délicate peut trouver bien des réponses selon que l’on considère le court terme ou le long terme. En ce qui concerne le court terme, certains des résultats présentés ici ne font que quantifier des intuitions déjà connues par les professionnels. Ainsi, le fait que le titre du brevet n’apporte que de l’information marginale pour une recherche en antériorité n’est ni nouveau ni surprenant, ce qui l’est c’est le fait que cette intuition est désormais estimée précisément : chercher dans les titres n’améliore la recherche que de 1% ! A moyen terme, les résultats de ces études seront – et sont probablement déjà pour certaines – reprises par les fournisseurs commerciaux de moteurs de recherche pour les brevets. Mais c’est l’impact à long terme qui est le plus fondamental. En effet, si l’on fait fi des considérations commerciales (marketing, force de vente…), et en reconnaissant que la mise à disposition d’un moteur de recherche dans les brevets nécessite la disponibilité d’une collection de brevets de grande qualité, ce qui nécessite souvent de traiter les sources fournies par les offices de brevets, il demeure rassurant de constater qu’une poignée de chercheurs est capable de développer en 2010 ce qui est apparemment un très bon moteur de recherche spécialisés pour la chimie !

6. Conclusion

Nous avons présenté l’état de la recherche dans le domaine des méthodes de recherche d’informations textuelles appliquées aux corpus de brevets et aux brevets de chimie en particulier. Notre rapport expérimental s’appuie sur la campagne d’évaluation TREC 2009 et à la méthodologie Cranfield dont elle hérite. La tâche présentée consistait à générer automatiquement la bibliographie d’un brevet, dont le contenu était utilisé comme requête. Le système présenté utilise une combinaison de méthodes, dont un moteur de recherche vectoriel pondérant différentiellement les champs composant le brevet, un réseau de citation indépendant de la requête, et des procédures de normalisation lexicale utilisant des modules d’extraction de composés chimiques se basant sur des ressources terminologiques publiques telles que PubChem. Le modèle de recherche proposé a obtenu des résultats hautement compétitifs lors des évaluations officielles TREC.

L’autre conclusion rassurante est qu’à l’ère de l’ « open source », il est facile de proposer des moteurs de recherches performants et originaux dans des domaines spécialisés – des niches diront certains – dont le nombre est à l’heure actuel indéfini sinon infini. Cette dernière observation est plus radicale qu’elle ne semble. En effet, elle est de nature à remettre en cause l’idée reçue d’une omnipotence d’un ou deux acteurs du web sur la recherche d’informations en faisant apparaître au grand jour la pluralité des besoins spécifiques de chaque contenu informationnel, voire de chaque corpus. Plus fondamentalement, en affranchissant partiellement les professionnels de leur dépendance vis-à-vis de l’instrument informatique le plus avancé, désormais gratuit et ouvert, il est possible de se détourner de l’arbre cachant la forêt, afin de contempler cette vaste forêt de Contenu ! C’est le contenu lui-même, auquel il faut désormais absolument avoir accès, qui conditionne l’accès à l’information. C’est encore ce contenu qui conditionne la valeur ajoutée d’un moteur, dont le développement ne représente qu’un coût marginal(1). On pourrait d’ailleurs suggérer aux grands offices de brevets (EPO, WIPO, USPTO…) la mise en place de services de diffusion des collections de brevets de plus grande qualité. Ainsi la concurrence entre les acteurs commerciaux ne se ferait-elle plus sur leur capacité à uniformiser – parfois manuellement – des sources de faible qualité mais bien à développer de bons moteurs de recherche. Les offices pourrait notamment définir des standards de rédaction plus exigeants, voire fournir des modèles documentaires (MS-Word, Latex), comme le font par exemple les grands éditeurs de journaux.

Enfin, il convient de concéder que notre étude portait exclusivement sur la recherche d’informations textuelles, alors que d’autres modalités pourraient opportunément être étudiées dont la recherche par structure, très utile dans le monde des chimistes. De même, d’autres tâches de recherche d’information sont actuellement à l’étude dans notre laboratoire, dont l’assignement automatiques de codes IPC (Teodoro et al. 2010), la recherche multilingue (Gobeill et al. 2010) ou les tâches de questions-réponses (Pasche et al. 2009). Un tel ensemble de tâches de recherche, apparemment hétérogènes, constituerait pourtant une fois intégrée au sein d’une même interface un outil original et puissant permettant d’interconnecter des fonctionnalités et des sources de connaissances éparses et distribuées : en chimie (e.g. Structures Markush, PubChem), pharmacologie (DrugBank), biologie moléculaire (e.g. Gene Ontologie, Swiss-Prot) ou clinique (e.g. Medical Subject Headings, OMIM).

7. Remerciements

Je tiens à remercier les membres de mon équipe pour l’excellence de leur engagement et la créativité de leurs développements : Arnaud Gaudinat, Julien Gobeill, Emilie Pasche, Douglas Teodoro, Dina Vishnyakova.

8. Disponibilités

Pour les « PatOlympics », organisés ce printemps par l’IRF (Information Retrieval Facility) à Vienne, le groupe a obtenu une première place dans la catégorie recherche dans les brevets de chimie (ChemAthlon) et le prix du jury pour l’interface utilisateur, cf. http://www.ir-facility.org/events/irf-symposium/2010/patolympics pour un compte-rendu et des résultats (http://patolympics.ir-facility.org/PatOlympics/scoreboard.html) officiels. Une version du moteur développé pour la compétition TREC, modifiée pour notre participation aux « PatOlympics » (ainsi appellé TWINC pour « To WIN ChemAthlon »), est disponible en ligne : http://casimir.hesge.ch/ChemAthlon/index.html. Une version simplifiée du ChemTagger et de notre catégoriseur automatique de codes IPC (IPCCat) peuvent être respectivement testés en suivant les liens correspondants sur la page « Resources » du groupe : http://eagl.unige.ch/bitem/.

Notes

(1) Environ trois chercheurs équivalent plein temps ont travaillé durant six semaines pour développer les stratégies de recherche utilisées pour TREC 2009.

Bibliographie

Abdou S, Savoy J. (2006): Searching in Medline: Query expansion and manual indexing evaluation. Information Processing & Management. Volume 44, Issue 2, March 2008, Pages 781-789

Bairoch A, Apweiler R, Wu CH, Barker WC, Boeckmann B, Ferro S, Gasteiger E, Huang H, Lopez R, Magrane M, Martin MJ, Natale DA, O'Donovan C, Redaschi N, Yeh LS. The Universal Protein Resource (UniProt). Nucleic Acids Res. 2005 Jan 1;33.

Brin S, Page L (1998). The Anatomy of a Large-Scale Hypertextual Web Search Engine. WWW 1998.

Capurro, R, Hjørland, B (2003): The Concept of Information. In: Annual Review of Information Science and Technology Ed. B. Cronin, Vol. 37 (2003) Chapter 8, pp. 343-411.

Criscuolo P and Verspagen B, “Does it matter where pa-tent citations come from? Inventor versus examiner cita-tions in European patents”, Research Policy, vol.37, pp 1892-1908, 2008.

Dolamic D, Savoy J (2010): When stopword lists make the difference. JASIST 61(1): 200-203 (2010)

Galaup X, Plaçons la médiation et non les collections au coeur de notre métier in Archimag, 1er Mars 2010.

Gobeill J, Teodoro D, Pasche E, Ruch P (2010) Exploring a Wide Range of Simple Pre and Post Processing Strategies for Patent Searching in CLEF IP 2009. CLEF 2009

Gobeill J, Teodoro D, Pasche E, Ruch P (2010) Report on the TREC 2009 Experiments: Chemical IR Track. TREC 2009.

Garfield E (2006): "The history and meaning of the journal impact factor". JAMA 295 (1): 90–3

Grivell, L. "Mining the bibliome: searching for a needle in a haystack?". EMBO Reports (3): 200–203.

Kuhn, TS. The Structure of Scientific Revolutions. Chicago: University of Chicago Press, 1962.

Lupu M, Huang J, Piroi F, Zhu J, Tait J. Overview of the TREC 2009 Chemical IR Track. TREC 2009.

van Rijsbergen CJ, Robertson SE and Porter MF, 1980. New models in probabilistic information retrieval. London: British Library. (British Library Research and Development Report, no. 5587).

Ruch P (2006): Automatic Assignment of Biomedical Categories: Toward a Generic Approach. Bioinformatics, 22(6):658-64, 2006.

Salaün JM : Web, texte, conversation et redocumentarisation, JADT 2008.

Sternitzke C, “Reducing uncertainty in the patent applica-tion procedure – insights from malicious prior art in Euro-pean patent applications”, World patent Information, vol.31, pp 48-53, 2009.

Teodoro D, Pasche E, Vishnyakova D, Gobeill J, Ruch P, Lovis C (2010) Automatic IPC Encoding and Novelty Tracking for Effective Patent Mining. NTCIR 2010.

Tseng YH, Wu YJ (2008): A study of search tactics for patentability search: a case study on patent engineers. PaIR 2008: 33-36

Yepes A (2009): Ontology Refinement for Improved Information Retrieval in the Biomedical Domain, PhD Thesis, University Jaume I, Castellon, Spain.

La homepage dans la communication des hôpitaux suisses francophones

Pablo Medina Aguerrebere, Université de Navarre, Faculté de Communication

La homepage dans la communication des hôpitaux suisses francophones

Introduction

Aujourd’hui, l’internet est l’un des outils de communication les plus importants dans le milieu hospitalier. La page d’accueil (homepage) constitue la partie la plus visible du site internet, et se base sur le concept de la précision informative, laquelle permet de satisfaire, d’une part, les patients, lesquels ont accès aux informations d’une manière plus simple, ce qui les mène à s’intéresser aux sujets de la santé; et, d’une autre part, l’organisation hospitalière, laquelle peut utiliser la homepage pour garder le contact direct avec les patients à travers les blogs ou l’email ainsi que pour simplifier les processus de recrutement des professionnels de la santé. Afin de comprendre l’enjeu stratégique de la homepage des institutions hospitalières, cet article analyse, tout d’abord, l’impact de la structure de la homepage sur l’hôpital, le médecin et le patient; ensuite, le contexte sanitaire en Suisse; et, finalement, avant de conclure le document, la structure de la homepage de neuf hôpitaux suisses francophones.

L’impact de la homepage dans la communication hospitalière

Même si les applications de Google permettent de trouver des informations sans passer par la homepage des sites internet, le patient est toujours influencé par ses expériences médicales préalables dans son centre hospitalier, ce qui permet de souligner le fait que le patient priorise le site internet de son hôpital quand il a besoin d’informations sanitaires. Cette réalité justifie l’importance des homepages des hôpitaux. Les sites internet de santé considérés comme effectifs transmettent une image de qualité fiable, de confiance, d’intelligence, et, finalement, de simplicité en ce qui concerne leur utilisation (Fisher et al., 2008 : p. 477). Cette simplicité détermine l’accessibilité aux informations, laquelle, selon Jones (2003 : p. 337), exige, avant tout, la diffusion d’informations précises permettant aux patients de ne pas « être submergés » par des informations inutiles. La précision dans l’information médicale mène les institutions hospitalières à faire très attention au langage utilisé sur leur site internet. Afin de minimiser le problème de la complexité du langage médical, il est intéressant de mettre sur les sites internet de santé les définitions de certains mots (Lorence & Spink, 2004). Soit, le développement d’un dictionnaire médical online peut apporter des bénéfices aux patients; mais, malgré tout, il faut que les professionnels de la santé sachent aussi adapter leur discours et leur langage aux besoins du patient. Dans le cadre d’une consultation online, si l’usager d’internet utilise un langage technique au moment de poser une question aux professionnels de la santé, ces derniers préfèrent continuer d’utiliser le langage technique; par contre, si l’usager utilise un langage plus familier, les professionnels de la santé savent adapter leur discours à ce langage moins précis (Bromme et al., 2005). En plus de l’attention faite au langage, les hôpitaux développent des outils visuels permettant de rendre leur homepage plus effective. Les organisations utilisant sur leurs sites internet des photographies et « des images abstraites » provoquent chez leurs utilisateurs une réaction positive (Vilnai-Yavetz & Tifferet, 2009 : p. 161). Ces réactions positives sont stratégiques puisque, selon Robins et al. (2010 : p. 27), les sites internet de santé qui suscitent des « préférences positives » grâce à leur design visuel génèrent aussi des jugements positifs concernant leur crédibilité.

Les sites internet transmettant des informations sanitaires doivent évoluer de la diffusion d’informations générales à la satisfaction des besoins informatifs précis des usagers (Huntington et al., 2003). Les institutions hospitalières essayent de satisfaire les besoins communicatifs de leurs groupes d’intérêt (employés, patients, journalistes, etc.) et, pour cela, il est convenable de créer sur le site internet des profils d’usager. La création de ces profils rend plus effective la diffusion d’informations médicales, ce qui est très important puisque, d’une part, selon Wasson et al. (2007), les patients utilisent l’internet pour faire part de leurs perceptions sur leurs expériences de santé négatives; et, d’une autre part, parce que l’usage d’internet comme source d’information sanitaire renforce la capacité des gens à mettre en doute les professionnels de la santé, et mène la population à avoir besoin de rester en contact avec ces professionnels afin de bien utiliser l’information trouvée sur internet (Lee, 2008 : p. 461). La création de profils d’usager aide les hôpitaux à mieux satisfaire les patients d’un point de vue de la communication, et ainsi à éviter la diffusion de rumeurs négatives et à garantir l’autorité professionnelle du personnel médical de l’institution.

L’internet a fait changer la manière dont les patients parlent avec les médecins sur les sujets de santé (Bylund et al., 2007). Néanmoins, « l’un des effets les plus spectaculaires d’internet et du world wide web est sa capacité à engager les patients et les consommateurs d’une manière active dans les sujets de santé » (Nguyen et al., 2004 : p. 95). D’ailleurs, l’utilisation de wikis et de blogs dans le milieu de la santé aide à impliquer les usagers d’une manière active dans leur propre construction de connaissances (Boulos et al., 2006). Donc, la diffusion d’informations médicales pousse les patients à devenir plus actifs et à mieux connaître le milieu de la santé. En plus, l’information e-Health qui est interactive, interoperable, personnelle, adaptée au contexte et qui peut être diffusée aux audiences massives peut vraiment aider à améliorer la qualité des soins de santé et les efforts de promotion de la santé (Kreps & Neuhauser, 2010 : p. 334). Par ailleurs, l’usage d’internet et de l’email influence les résultats de santé du patient à travers plusieurs moyens, comme par exemple, l’amélioration de la diffusion d’informations, ce qui peut apporter «des bénéfices intangibles comme rendre les patients plus confortables ou confiants sur leur état de santé» (Baker et al., 2003 : p. 2405). L’impact sanitaire de la diffusion d’informations médicales à travers le site internet des hôpitaux justifie le besoin de bien réfléchir à la structure de la homepage. Dans ce cadre de l’éducation thérapeutique du patient dans les sujets de la santé, la creátion d’un site internet consacré à la bibliothèque existante dans l’hôpital constitue un «outil extrêmement important» (Kammerer, 2009 : p. 40), puisque le patient peut aussi s’instruire grâce aux livres dont dispose l’hôpital.

Quant aux professionnels de la santé, eux aussi, ils peuvent profiter d’internet pour mieux connaître le milieu sanitaire. Afin de promouvoir d’une manière efficace l’éducation thérapeutique constante dans le milieu sanitaire, il est important que les éducateurs comprennent l’impact éducatif de l’internet comme support (media) pouvant être utilisé par les professionnels de la santé (Copley Cobb, 2004). Dans ce cadre, il est intéressant d’organiser des cours de formation online, lesquels, selon Carroll et al. (2009), permettent d’améliorer l’expérience d’autoapprentissage des professionnels de la santé. Par ailleurs, internet s’avère comme un moyen très utile dans le recrutement des professionnels de la santé. L’usage d’internet comme moyen de recrutement « semble aller au-delà de la seule opération de recrutement pour s’étendre à la prospection plus générale du marché, et ceci vaut aussi bien pour le positionnement des entreprises que pour celui des candidats” (Bessy & Marchal, 2006 : p. 38). Dans le but d’optimiser le pouvoir d’internet comme source de recrutement, d’une part, selon, Williamson et al. (2003), le site internet doit avoir un haut niveau de contenus utiles afin de devenir attractif auprès des employés potentiels; et, d’une autre part, selon Van Hoye & Lievens (2007 : p. 380), il doit être à la base du word-of-mouse (l’application online du bouche-à-oreille), lequel « peut être une source de recrutement crédible et influente ».

La homepage, ainsi que le site internet de l’hôpital dans son ensemble, doit assurer la qualité des informations transmises. Les fournisseurs d’information « doivent développer des systèmes permettant de garantir sa qualité, et ainsi de protéger les usagers de la désinformation » (Ayantunde et al., 2007 : p. 461). L’usage du web pour se procurer des informations médicales est influencé par les perceptions du consommateur sur les sources traditionnelles d’information (Rains, 2007), d’où l’intérêt que les sites internet développent, à l’instar de ces sources d’information traditionnelles, des systèmes permettant d’accréditer la qualité des informations diffusées. L’accréditation de la qualité est importante puisque, selon Wang et al. (2008), il existe un rapport direct entre l’évaluation de la qualité du message online de santé et la décision d’agir. Soit, les messages crédibles qui transmettent une image de qualité mènent les usagers à agir. Une évaluation complète des sites d’internet diffusant des informations sanitaires comporte des études des usagers, des méthodes d’inspection pour mieux évaluer l’usability et les indicateurs de qualité, des enquêtes sur le contexte pour comprendre l’importance et l’utilité du site pour les groupes d’usagers actuels et potentiels, ainsi qu’une analyse des archives log permettant d’examiner l’utilisation du site (Williams et al., 2002 : p. 106-107). Dans ce cadre, plusieurs institutions sanitaires essayent d’obtenir la certification de la Health On the Net Foundation, une organisation qui octroie un label de qualité (Honcode) une fois qu’elle a vérifié que l’institution diffusant des informations sanitaires sur internet respecte les huit principes fondamentaux établis par ce label: a) indiquer la qualification des rédacteurs, b) compléter la relation patient-médecin, c) préserver la confidentialité des informations personnelles, d) citer les sources des informations, e) justifier les affirmations sur les traitements ou sur les produits, f) rendre l’information la plus accessible possible, g) présenter les sources de financement et h) séparer la politique publicitaire de la politique éditoriale(1).

Contexte sanitaire suisse

Le système sanitaire suisse a l’une des densités médicales les plus importantes au niveau international puisque, en 2007, cette densité était de 3,9 médecins par 1.000 habitants (Organisation pour la Coopération et le Développement Economique, 2010). En 2007, en Suisse on comptait 29.052 médecins, ce qui représente une augmentation de 0,8% par rapport à 2006 (Fédération des Médecins Suisses, 2008). En 2007, la dépense sanitaire totale en Suisse représentait le 10,8% du PIB de la même année (Organisation pour la Coopération et le Développement Economique, 2010). Quant au nombre de lits d’hospitalisation pour soins aigus, en 2007 la Suisse avait 3,5 lits par milliers d’habitants (OCDE, 2010). En 2007, le système sanitaire suisse comptait 321 hôpitaux – dont 130 hôpitaux privés-, lesquels employaient 130.990 personnes – dont 96.604 dans les hôpitaux de soins généraux- (Office Fédérale de la Santé Publique, 2010a : p. 21-22). En 2007, le 86,8% des personnes âgées de 15 ans et plus se sentait en bonne ou très bonne santé; ce qui peut être expliqué par le fait que seulement le 19,6% des hommes et le 9% des femmes consommaient quotidiennement de l’alcool, et que le pourcentage de fumeurs était de 32,3% chez les hommes et de 23% chez les femmes (Office Fédérale de la Statistique, 2010b).

La structure de la homepage dans les hôpitaux suisses francophones

Le choix des hôpitaux suisses francophones analysés dans cette recherche se base sur le « Ranking Web d’Hôpitaux du Monde », élaboré par le Département de Cybermétrie du Conseil National de Recherches Scientifiques d’Espagne(2). Selon le classement de ce ranking au mois de janvier 2010, les neuf premiers hôpitaux suisses ayant leur site internet en français étaient dans cet ordre: 1) Centre Hospitalier Universitare Vaudois Lausanne, 2) Hôpitaux Universitaires de Genève, 3) Hôpital de la Chaux de Fonds, 4) Kurzentrum Rheinfelden, 5) Clinique Générale Beaulieu, 6) Hôpital du Valais, 7) Uniklinik Balgrist Spital und Chirurgie, 8) Hôpital Riviera et 9) Clinique Pyramide(3).

L’objectif de cette recherche est de comprendre comment ces institutions hospitalières organisent la structure de leur homepage(4). Afin d’étudier cette structure, dans cette recherche on utilise neuf indicateurs différents: 1) l’image a-t-elle plus d’espace que le texte?; 2) les images du patient ont-elles plus d’espace que les images des professionnels de la santé?; 3) le langage scientifique est-il plus présent que le langage familier?: 4) y a-t-il un lien vers les services de santé (départements médicaux) de l’hôpital?; 5) peut-on observer des traitements médicaux mis en avant dans un autre format que celui du communiqué de presse?; 6) y a-t-il un lien vers une rubrique consacrée à l’éducation thérapeutique du patient dans les sujets concernant la santé ?; 7) y a-t-il des logos des organisation externes qui accréditent l’hôpital?; 8) existe-t-il un accès personnalisé pour les patients et pour les professionnels de la santé?; et 9) y a-t-il un lien vers la rubrique consacrée aux activités de recrutement de l’hôpital ? Ces neufs indicateurs essayent d’évaluer le niveau de navigabilité des sites internet en tenant compte du contexte hospitalier et des besoins du patient (recherche de traitements médicaux, langage familier, éducation thérapeutique du patient dans les sujets concernant la santé…). Mais, malgré tout, il s’agit de critères limités qui pourraient être complétés par d’autres indicateurs.

Par rapport à l’image et au texte, sept hôpitaux sur neuf accordent plus d’importance au texte qu’à l’image (Hôpitaux Universitaires de Genève, Hôpital de la Chaux de Fonds, Kurzentrum Rheinfelden, Clinique Générale Beaulieu, Hôpital du Valais, Uniklinik Balgrist Spital und Chirurgie et Clinique Pyramide), ce qui représente le 77,80% des hôpitaux analysés. En ce qui concerne les images du patient et du professionnel de la santé, deux hôpitaux sur neuf (Hôpitaux Universitaires de Genève et Kurzentrum Rheinfelden) priorisent les images du patient sur celles du professionnel de la santé, ce qui représente le 22,22% des hôpitaux étudiés. Quant au langage scientifique et au langage familier, tous les hôpitaux utilisent un langage familier permettant de diffuser d’une manière claire les informations concernant l’institution hospitalière. Par rapport à la présence de liens vers les services de santé proposés (départements médicaux), tous les hôpitaux analysés disposent de ces liens. En ce qui concerne la mise en avant de certains traitements médicaux sans utiliser un format de communiqué de presse, on dénombre quatre organisations (Hôpitaux Universitaires de Genève, Uniklinik Balgrist Spital und Chirurgie, Hôpital Riviera et Clinique Pyramide) qui utilisent cette technique informative, ce qui représente le 44,44% des hôpitaux analysés.

Quant à l’existence de liens vers une rubrique sur l’éducation thérapeutique du patient, il y a deux organisations (Hôpitaux Universitaires de Genève et Hôpital Riviera) qui ont sur leur homepage un lien direct vers la page consacrée à l’éducation thérapeutique du patient. Par rapport à l’existence de logos des organisations externes accréditant l’hôpital, il y a trois institutions disposant de ces informations (Hôpitaux Universitaires de Genève, Clinique Générale Beaulieu et Clinique Pyramide), ce qui représente le 33,33% des hôpitaux étudiés - la première institution citée utilise le logo du Hon Code; et la deuxième et la troisième, celui du groupe hospitalier The Swiss Leading Hospitals-. En ce qui concerne la division de l’information selon le profil patient ou professionnel de la santé, il y a trois hôpitaux (Hôpital du Valais, Uniklinik Balgrist Spital und Chirurgie et Hôpital Riviera) qui appliquent d’une manière claire cette division. Finalement, quant à l’existence d’un lien vers la rubrique de recrutement, six hôpitaux sur neuf disposent de ce lien (Centre Hospitalier Universitare Vaudois Lausanne, Hôpitaux Universitaires de Genève, Clinique Générale Beaulieu, Hôpital du Valais, Hôpital Riviera et Clinique Pyramide), ce qui représente le 66,70% des hôpitaux analysés.

Afin de mieux comprendre la réalité des hôpitaux suisses, on a mené la même recherche auprès des hôpitaux français. Selon le classement du « Ranking Web d’Hôpitaux du Monde » au mois de janvier 2010, les quinze premiers hôpitaux français étaient dans cet ordre: 1) Centre Hospitalier Universitaire (CHU) de Lyon, 2) CHU de Rouen, 3) Assistance Publique Hôpitaux de Marseille, 4) Assistance Publique Hôpitaux de Paris, 5) Institut Curie, 6) CHU de Toulouse, 7) CHU de Saint-Étienne, 8) CHU de Clermont-Ferrand, 9) CHU de Nantes, 10) Centre Hospitalier Régional Universitaire (CHRU) de Montpellier, 11) CHU de Nice, 12) CHU de Besançon, 13) CHU de Poitiers, 14) CHU de Brest et 15) CHU de Grenoble(5). Dans le but de faire une comparaison entre la situation des hôpitaux suisses et celle des hôpitaux français, on présente un tableau permettant d’apprécier les différences existantes :

Tableau 1. Indicateurs hôpitaux Suisse et hôpitaux France.

|

Indicateurs |

Hôpitaux Suisse |

Hôpitaux France |

|

1. Le texte a plus d’espace que l’image. |

77,80% |

80% |

|

2. L’image du patient a plus d’espace que celle du médecin. |

22,22% |

6,70% |

|

3. Le langage familier est plus présent que le langage scientifique. |

100% |

93,3% |

|

4. Existence d’un lien vers les services de santé de l’hôpital. |

100% |

86,70% |

|

5. Présence de traitements médicaux mis en avant sans avoir le format du communiqué de presse. |

44,44% |

26,70% |

|

6. Existence d’un lien vers la rubrique d’éducation thérapeutique du patient dans les sujets concernant la santé. |

22,22% |

26,70% |

|

7. Présence de logos des organisations externes qui accréditent l’hôpital. |

33,33% |

26,70% |

|

8. Existence d’un accès personnalisé patient et professionnel de la santé. |

33,33% |

80% |

|

9. Présence d’un lien vers les activités de recrutement de l’hôpital. |

66,70% |

80% |

Discussion

Les hôpitaux suisses ayant leur site en français ont bien compris l’importance d’avoir une homepage performante, ce qui représente aujourd’hui un outil de communication très important. La priorité du texte sur l’image (77,80% des hôpitaux suisses analysés), l’utilisation d’un langage familier (100%) et l’existence d’un lien vers les services de santé proposés par l’hôpital (100%) mettent en évidence le souci des hôpitaux de vouloir informer le patient d’une manière précise et de l’aider ainsi dans ses démarches online. Pourtant, ces hôpitaux peuvent encore s’améliorer à travers plusieurs initiatives, comme par exemple, la création d’un profil d’usager pour les patients et d’un autre profil d’usager pour les professionnels de la santé, ce qui, aujourd’hui, existe dans le 33,30% des hôpitaux suisses analysés et dans le 80% des hôpitaux français étudiés. La principale différence existant entre les hôpitaux suisses et les hôpitaux français analysés réside dans le fait que les hôpitaux suisses consacrent plus d’importance au rôle du patient qu’a celui de l’institution hospitalière: l’image du patient a plus d’espace que celle du médecin (22,22% en Suisse ; 6,70% en France), mise en avant de certains traitements médicaux sans utiliser le format du communiqué de presse (44,44% en Suisse ; 26,70% en France) et présence d’un lien vers les activités de recrutement - ce qui n’intéresse pas le patient- (66,70% en Suisse ; 80% en France).

La création d’une homepage performante représente un enjeu stratégique important parce que, souvent, cette homepage constitue le contact principal entre le patient et l’institution hospitalière. Il est difficile d’établir des consignes générales permettant les hôpitaux de créer des homepage performantes puisque le contexte de chaque hôpital, de chaque pays et de chaque système de santé détermine les choix stratégiques à suivre. Pourtant, on peut signaler trois idées qui peuvent s’appliquer à tous les hôpitaux. En premier lieu, l’hôpital doit disposer d’un département de communication capable de comprendre la logique communicative du milieu sanitaire et de satisfaire aux besoins organisationnels de l’hôpital. En deuxième lieu, l’approche utilisée dans le design de la homepage doit être basée, tout d’abord, sur les besoins communicatifs et médicaux du patient et, ensuite, sur les besoins communicatifs de l’organisation hospitalière. En troisième lieu, la homepage constitue un point de contact entre le patient et l’hôpital, mais ce contact ne peut pas se limiter à un rapport online, d’où l’importance que les hôpitaux conçoivent la homepage comme un outil qui peut rendre plus simple la consultation du patient quand il se rend à l’hôpital. Le développement de la télémédecine rend de plus en plus intéressantes les applications du web 2.0 dans le milieu sanitaire. Pourtant, l’internet suppose une vraie menace de perte de confiance du patient dans la relation thérapeutique établie avec le médecin (Fostier, 2005). Les hôpitaux doivent concevoir des homepages performantes, mais ils ne doivent pas négliger que la communication, qu’elle soit online ou pas, est toujours au service du médecin, lequel est le vrai responsable de l’amélioration de l’état de santé du patient.

Conclusion

Les institutions hospitalières sont de plus en plus présentes dans la vie du patient, d’où la nécessité de voir dans la structure de la homepage, non pas uniquement une opportunité de présenter d’une manière formelle l’hôpital, mais plutôt la possibilité de créer et de mettre à jour une carte de présentation online dont le but est d’établir des relations stables et satisfaisantes avec le patient à travers la diffusion d’informations institutionnelles et l’éducation thérapeutique du patient sur les sujets de santé. Par rapport aux hôpitaux suisses francophones analysés, on peut affirmer qu’ils tiennent compte de cette réalité, puisqu’ils priorisent le texte sur l’image (donc, la diffusion d’informations) ainsi que le langage familier sur le langage scientifique; mais, ils doivent donner une importance plus grande à la rubrique consacrée à l’éducation thérapeutique du patient, ce qui se traduit par la création dans la homepage d’un lien visible et direct menant l’usager à une rubrique performante et interactive sur ce sujet.

Notes

(1) Site internet officiel consulté le 10 mai 2010: <http://www.hon.ch/HONcode/Guidelines/guidelines.html>.

(2) Cet organisme (Consejo Superior de Investigaciones Científicas) est l’une des organisations de recherche les plus importantes d’Europe, et dépend du Ministère de Science et de Technologie du Gouvernement Espagnol. L’élaboration du ranking des hôpitaux se base sur des indicateurs web qui mesurent l’activité professionnelle et de recherche de l’institution hospitalière. Le ranking tient compte uniquement des hôpitaux ayant un domaine web indépendant. Afin de mesurer le « facteur d’impact web », on utilise quatre indicateurs différents: taille du site web, visibilité, fichiers riches et caractère académique. Site internet officiel consulté le 12 mai 2010: <http://hospitals.webometrics.info/about_rank.html>.

(3) Le ranking complet peut être consulté sur le site officiel du Conseil National de Recherches Scientifiques d’Espagne: http://hospitals.webometrics.info/top100_europe.asp?country=ch&submit=go.

(4) L’analyse des pages web a été réalisé entre le 3 mai et le 20 mai 2010. Dans le cas de l’Hôpital de la Chaux de Fonds et du Kurzentrum Rheinfelden, la homepage analysée est celle des groupes hospitaliers auxquels appartiennent ces hôpitaux.

(5) Le ranking complet peut être consulté sur le site officiel du Conseil National de Recherches Scientifiques d’Espagne: http://hospitals.webometrics.info/top100_europe.asp?country=fr&submit=go.

L’analyse des pages web a été réalisé entre le 25 et le 30 juin 2010.

Bibliographie

AYANTUNDE, A.; WELCH, N. & PARSONS, S. (2007). A survey of patient satisfaction and use of the internet for health information. International Journal of Clinical Practice, vol. 61, nº 3, p. 458-462

BAKER, Laurence; WAGNER, Todd; SINGER, Sara & BUNDORF, Kate (2003). Use of the internet and e-mail for health care information. Results from a national survey. Journal of the American Medical Association, vol. 289, nº 18, p. 2400-2406

BESSY, Christian & MARCHAL, Emmanuelle (2006). La mobilisation d’internet pour recruter: aux limites de la sélection à distance. Revue de l'Ires, vol. 52, nº 3, p. 11-39

BOULOS, Maged Kamel; MARAMBA, Inocencio & WHEELER, Steve (2006). Wikis, blogs and podcasts: a new generation of web-based tools for virtual collaborative clinical practice and education. BMC Medical Education, vol. 6:41

BROMME, Rainer; JUCKS, Regina & WAGNER, Thomas (2005). How to refer to ‘diabetes’? Language in online health advice. Applied Cognitive Psychology, vol. 19, nº 5, p. 569-586

BYLUND, Carma; GUEGUEN, Jennifer; SABEE, Christina; IMES, Rebecca; LI, Yuelin & SANDFORD, Amy (2007). Provider–patient dialogue about internet health information: an exploration of strategies to improve the provider–patient relationship. Patient Education and Counseling, vol. 66, nº 3, p. 346–352

CARROLL, Christopher; BOOTH, Andrew; PAPAIOANNOU, Diana; SUTTON, Anthea & WONG, Ruth (2009). UK health-care professionals’ experience of on-line learning techniques: a systematic review of qualitative data. Journal of Continuing Education in the Health Professions, vol. 29, nº 4, p. 235-241

COPLEY COBB, Susan (2004). Internet continuing education for health care professionals: an integrative review. The Journal of Continuing Education in the Health Professions, vol. 24, nº 3, p. 171-180

FÉDÉRATION DES MÉDECINS SUISSES (2008). [Consulté le 23 avril 2010]. http://www.fmh.ch/files/pdf4/stt011.pdf.

FISHER, Julie; BURSTEIN, Frada; LYNCH, Kathy & LAZARENKO, Kate (2008). “Usability + usefulness = trust”: an exploratory study of Australian health web sites. Internet Research, vol. 18, nº 5, p. 477-498

FOSTIER, Pierrik. (2005). La communication professionnelle en santé. Québec, Éditions du Renouveau Pédagogique Inc. Chap. 27, L’influence de l’internet sur la communication médecin-patient, p. 693-714.

HUNTINGTON, Paul; NICHOLAS, David & WILLIAMS, Peter (2003). Characterising and profiling health web user and site types: going beyond “hits”. Aslib Proceedings, vol. 55, nº 5/6, p. 277-289

JONES, Ray (2003). Making health information accessible to patients. Aslib Proceedings, vol. 55, nº 5/6, p. 334-338

KAMMERER, Judith (2009). Migrating a hospital library web site to sharepoint and expanding its usefulness. Journal of Hospital Librarianship, vol. 9, nº 4, p. 408-418

KREPS, Gary & NEUHAUSER, Linda (2010). New directions in eHealth communication: opportunities and challenges. Patient Education and Counseling, vol. 78, nº 3, p. 329-336

LEE, Chul-Joo (2008). Does the internet displace health professionals? Journal of Health Communication, vol. 13, nº 5, p. 450-464

LORENCE, Daniel & SPINK, Amanda (2004). Semantics and the medical web: a review of barriers and breakthroughs in effective healthcare query. Health Information and Libraries Journal, vol. 21, nº 2, p. 109-116

NGUYEN, Huong; CARRIERI-KOHLMAN, Virginia; RANKIN, Sally; SLAUGHTER, Robert & STULBARG, Michael (2004). Internet-based patient education and support interventions: a review of evaluation studies and directions for future research. Computers in Biology and Medicine, vol. 34, nº 2, p. 95-112

ORGANISATION POUR LA COOPERATION ET LE DEVELOPPEMENT ECONOMIQUE (2010). Eco-santé OCDE 2009. Statistiques et indicateurs pour 30 pays. Paris, Organisation pour la Coopération et le Développement Economique. ISBN 97892-64-06050-0

OFFICE FÉDÉRALE DE LA SANTÉ PUBLIQUE (2010a). Chiffres-clés des hôpitaux suisses 2007. Berne, Office Fédérale de la Santé Publique. ISBN 3-905235-68-4

OFFICE FÉDÉRALE DE LA STATISTIQUE (2010b). [Consulté le 23 avril 2010]. http://www.bfs.admin.ch/bfs/portal/fr/index/themen/14/01/new.html.

RAINS, Stephen (2007). Perceptions of traditional information sources and use of the world wide web to seek health information: findings from the health information national trends survey. Journal of Health Communication, vol. 12, nº 7, p. 667-680

ROBINS, David; HOLMES, Jason & STANSBURY, Mary (2010). Consumer health information on the web: the relationship of visual design and perceptions of credibility. Journal of the American Society for Information Science and Technology, vol. 61, nº 1, p. 13-29

VAN HOYE, Greet & LIEVENS, Filip (2007). Investigating web-based recruitment sources: employee testimonials Vs. word-of-mouse. International Journal of Selection and Assessment, vol. 15, nº 4, p. 372-382

VILNAI-YAVETZ, Iris & TIFFERET, Sigal (2009). Images in academic web pages as marketing tools: meeting the challenge of service intangibility. Journal of Relationship Marketing, vol. 8, nº 2, p. 148-164

WANG, Zuoming; WALTHER, Joseph; PINGREE, Suzanne & HAWKINS, Robert (2008). Health information, credibility, homophily, and influence via the internet: web sites versus discussion groups. Health Communication, vol. 23, nº 4, p. 358-368

WASSON, John; MACKENZIE, Todd & HALL, Michael (2007). Patients use an internet technology to report when things go wrong. Quality and Safety in Health Care, vol. 16, nº 3, p. 213-215

WILLIAMS, Peter; NICHOLAS, David; HUNTINGTON, Paul & MCLEAN, Fiona (2002). Surfing for health: user evaluation of a health information website. Part one: background and literature review. Health Information and Libraries Journal, vol. 19, nº 2, p. 98-108

WILLIAMSON, Ian; LEPAK, David & KING, James (2003). The effect of company recruitment web site orientation on individuals’ perceptions of organizational attractiveness. Journal of Vocational Behavior, vol. 63, nº 2, p. 242-263

Le rôle de la BN au niveau international

Genevieve Clavel-Merrin, bibliothèque nationale suisse

Introduction

Fondée en 1895, la Bibliothèque nationale suisse (BN <http://www.nb.admin.ch>) a pour mission de collectionner, répertorier, conserver et mettre à la disposition du public les informations, imprimées ou numériques, ayant un lien avec la Suisse.

La Loi sur la Bibliothèque nationale suisse (LBNS) constitue sa base légale, et c’est là, ainsi que dans l’ordonnance, que l’on trouve les premiers éléments concernant son rôle au niveau international :

LBNS, du 18 décembre 1992 (état 1er août 2008)

Art. 10 collaboration et coordination

1 Dans l’accomplissement de ses tâches, la Bibliothèque nationale travaille en collaboration avec d’autres institutions, suisses ou étrangères, qui exercent une activité similaire; ce faisant, elle tient tout particulièrement compte des institutions qui sont actives dans les domaines de l’audiovisuel et des autres nouveaux supports d’information.

2 Elle s’efforce d’instaurer une répartition des tâches.

3 En étroite collaboration avec d’autres grandes bibliothèques publiques, elle assure des tâches de coordination, en particulier dans le domaine de l’automatisation des bibliothèques.

OBNS du 14.1.1998 (état 8 février 2000)

Art. 21 Coopération internationale

1 Des accords selon l'article 10 LBNS sont conclus par l'Office fédéral de la culture (Office).

2 La Bibliothèque nationale développe les relations avec des institutions étrangères ayant un mandat comparable au sien, en particulier avec les bibliothèques nationales européennes

Dans sa stratégie 2007-2011, la BN précise :

Dans l’exécution de ses tâches, la Bibliothèque nationale suisse s’appuie sur la collaboration avec d’autres institutions nationales et internationales : la Bibliothèque nationale suisse participe activement à différents organismes et projets qui sont en rapport avec l’avenir de la société de l’information.

Concrètement, cela signifie que la BN poursuit des activités dans divers domaines couvrant l’acquisition et l’échange de documents, le partage du travail sur les normes, l’échange d’expériences par des partenariats bilatéraux à long terme et des accords, ainsi que la participation active à des associations professionnelles comme l’IFLA (International Federation of Library Associations and Institutions, <www.ifla.org>), la CENL (Conference of European National Librarians, <www.cenl.org>) et LIBER (Ligue des Bibliothèques européennes de recherche, <www.kb.dk/liber/>). Depuis plus de dix ans, elle participe également à des projets européens. Tous les secteurs de la BN peuvent être appelés à travailler au niveau international de façon ponctuelle ou à plus long terme y compris par des contacts avec les ambassades et consulats, avec les auteurs suisses à travers le monde ou dans le cadre de foires internationales du livre pour compléter ses collections. Les collaborateurs et collaboratrices participent à des conférences, y présentant la BN et certains de ses projets, ou à des activités internationales (par exemple International Internet Preservation Consortium IIPC <http://www.netpreserve.org>, ou le centre ISSN dont elle est membre depuis 1978). Mais plutôt d’en faire la liste exhaustive on se concentrera sur les activités liées à la CENL et aux projets européens qui illustrent la variété des domaines concernés. Tout d’abord cependant, nous allons présenter brièvement quelques activités entreprises avec les pays voisins, où nous profitons de la proximité linguistique et culturelle, ce qui a un effet sur l’intensité de notre collaboration, et évoquer également les domaines où il nous faudrait renforcer nos activités.

Collaboration avec pays voisins

L’intensité de la collaboration avec les pays voisins reflète de près la composition linguistique de la Suisse : des liens très étroits existent entre la BN, la Deutsche Nationalbibliothek et la Österreichische Nationalbibliothek concrétisés par des accords de coopération permettant une collaboration à plusieurs niveaux. La BN travaille avec ces institutions sur les questions de formats de données, normes de catalogage, autorités et matières, mais aussi dans le cadre des publications électroniques et la gestion des URNs (Universal Resource Name, format employé pour l’identification et la gestion des ressources électroniques). La BN participe à la Deutsche Internetbibliothek <http://dib1.bsz-bw.de/dib1/> ; seule partenaire de ce dernier en Suisse, elle permet de faire un lien de coordination avec tous les partenaires suisses de SwissInfo Desk, permettant ainsi à tous d’en profiter. Dans le même état d’esprit, la BN participe à Si@de (Services d'information à la demande <http://www.bnf.fr/pages/zNavigat/frame/accedocu.htm?ancre=siade.htm>), le réseau francophone de services de questions-réponses lancé par la Bibliothèque nationale de France. En tant que membre fondateur du Réseau francophone numérique <http://www.rfnum.org/>, la BN travaille avec la France, la Belgique et le Luxembourg (mais aussi avec les pays francophones du monde entier) sur la mise à disposition des données numérisées francophones, offrant par ce biais un autre accès à ses journaux numérisés.

En revanche, il n’y a pas de coopération formelle avec l’Italie, sauf dans le cadre du groupe d’utilisateurs Dewey (EDUG < http://www.slainte.org.uk/edug/index.htm >) dont la BN est membre fondatrice et principale instigatrice. Cette lacune dans nos contacts est sans soute un reflet des compétences linguistiques, mais aussi de traditions de collaboration et mérite d’être revue.

Conference of European National Librarians CENL

C’est au sein de la Conference of European National Librarians (CENL) que se passe la plus grande partie de la collaboration de la BN au niveau européen. Créée en 1987, la CENL est depuis 2000 une fondation selon la loi néerlandaise. Ce statut lui permet de dialoguer avec les instances européennes et de participer à des projets financés par la Commission européenne. Cependant, sa composition dépasse les 27 pays membres de l'Union européenne. En fait, ce sont les directeurs et directrices des bibliothèques nationales des pays membres du Conseil de l'Europe qui en sont membres, plus le Vatican, au total 47 pays. La CENL a pour objectif de soutenir les bibliothèques nationales dans leurs rôles de :