N°20 décembre 2019

Sommaire - N° 20, Décembre 2019

Études et recherche :

-

Faciliter et soutenir le travail des chercheurs : état des lieux, perspectives et réflexions sur l’exemple de la Haute école de travail social de Genève - Claire Wuillemin

- Interroge : le service de référence en ligne des bibliothèques de la Ville de Genève - Susana Cameàn, Florent Dufaux et Jürgen Haepers

- Enquête 2018 sur les besoins non documentaires du public du site Riponne de la BCUL : méthodologie et principales conclusions - Christophe Bezençon et Françoise Simonet

- Alignement et enrichissement des données de l’inventaire d’un fonds d’archives en Linked Open Data: le cas du Montreux Jazz Digital Project - Alain Chardonnens

- Le Projet de Loi 12146 : Infrastructures et services numériques pour la recherche - Pierre-Yves Burgi

- Un plan de gestion de sinistres au sein des Archives de Montreux : de la conception à la mise à jour - Ludovic Ramalho

Comptes-rendus d'événements :

- Retours sur le congrès IFLA 2019 - Florence Bugy, Matthieu Cevey, Benoît Epron, Michel Gorin et Anouk Santos

- Première journée Open Science de la HES-SO - Cynthia A. Germond

- Forum annuel des bibliothèques HES-SO, 22 août 2019 : les données de la recherche « un marché à occuper » - Elise Pelletier

- De la veille classique au social listening : compte rendu de la 16ème journée franco-suisse sur la veille stratégique et l’intelligence économique, 20 juin 2019, Genève - Hélène Madinier

Recensions :

- Ce que le numérique fait aux livres - Benoît Epron

- La médiation : un concept pour les sciences de l’information et de la communication – Jacqueline Deschamps, 2018 - Elise Pelletier

- New Top Technologies Every Librarian needs to know (2019) - Claire Wuillemin

- Anleitungen und Vorschläge für Makerspaces in Bibliotheken: Sammelrezension, Teil II (2017-2019) - Karsten Schuldt

Editorial

Editorial n°20

Après le numéro spécial pour les 100 ans de la filière Information documentaire de la Haute Ecole de Gestion de Genève, paraît cette année le vingtième numéro de RESSI.

Lorsqu'en janvier 2005 paraissait le premier numéro, nous avions bien conscience de lancer un défi car la création d’une revue scientifique en est un à plusieurs niveaux. En premier lieu, un défi éditorial, étant donné les multiples difficultés auxquelles se heurte généralement ce genre d’entreprise. Ensuite, un défi académique, compte tenu de la concurrence régnant dans ce domaine, entre les instances institutionnelles de production et de diffusion de la connaissance scientifique (universités ou sociétés scientifiques) dont les revues constituent l’une des expressions les plus importantes. Mais avant tout, la publication d’une nouvelle revue scientifique constituait une gageure. En effet, en dehors de la contribution d’un nouvel espace de publication aux progrès de la recherche et du travail théorique de la discipline concernée, une telle revue doit, par l’originalité des approches, des analyses et des traitements de son objet d’étude, se distinguer des autres revues avec lesquelles elle entre en compétition.

Bien sûr, nous n’avions pas alors la naïveté de croire que la naissance d’une nouvelle revue scientifique en Suisse suffirait par elle-même à susciter une révolution épistémologique inaugurant une nouvelle façon de penser la discipline. Nous avions bien plus modestement le désir de créer un forum pour favoriser le dialogue entre les divers acteurs, pour exprimer des sensibilités diverses, susciter des interrogations, des réflexions, des doutes ; et cela, quelle que soit l’insertion professionnelle des auteurs, au-delà de la traditionnelle distinction entre bibliothèques, archives ou services de documentation, mais sous la bannière de la science de l’information. RESSI complète le paysage informationnel suisse, en offrant une tribune aux jeunes qui représentent la relève.

RESSI ouvre ses pages à toutes les tendances et domaines de la science de l’information, en accueillant dans chacun de ses numéros des articles reflétant des méthodologies diverses.

Ce vingtième numéro ne déroge pas à cette ligne éditoriale et vous propose des contributions variées et nombreuses, puisqu’il y en a quatorze.

Dans la rubrique « Etudes et Recherches », vous trouverez un article intitulé Faciliter et soutenir le travail des chercheurs : état des lieux, perspectives et réflexions sur l’exemple de la Haute école de travail social de Genève. Signée par Claire Wuillemin, assistante d’enseignement à la HEG-Genève, cette recherche, synthèse d’un travail de Master, explore la notion de soutien à la recherche, appliquée à la HETS-Genève, et fait des propositions de développement de ces services, applicables à tout type d’institution d’enseignement supérieur amenée à faire de la recherche.

Dans la rubrique « Compte rendus d’expérience », nous vous proposons six contributions.

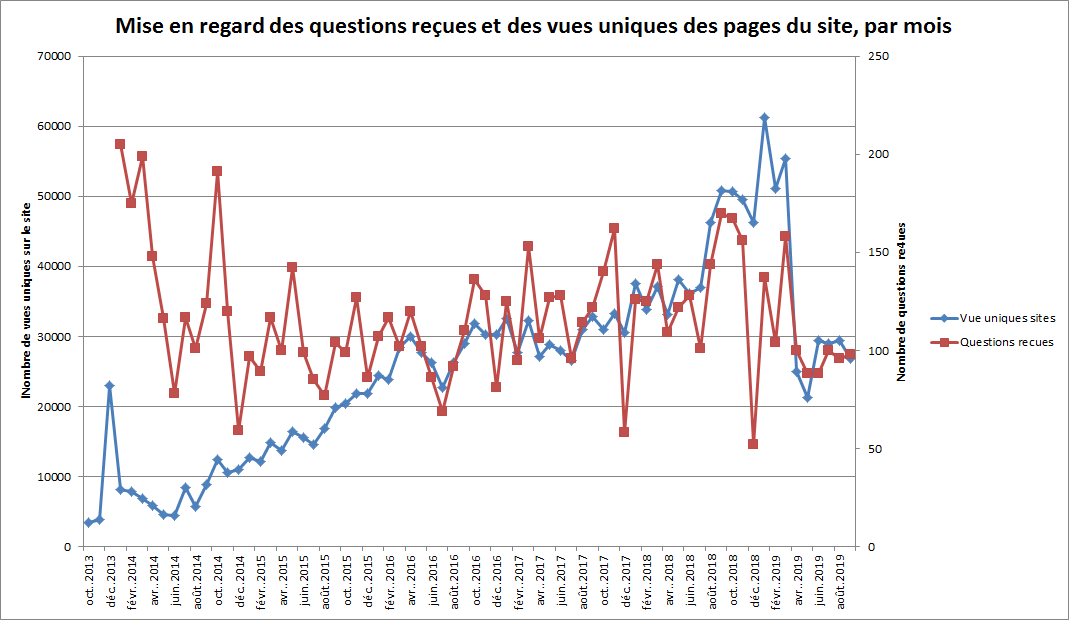

La première est signée de plusieurs mains : Susana Cameàn, bibliothécaire chargée de secteur, coordinatrice InterroGE, Jürgen Haepers, bibliothécaire chargé de secteur, coordinateur InterroGE et Florent Dufaux, adjoint de direction, responsable d'Interroge, tous les trois travaillant aux Bibliothèques municipales de la Ville de Genève, et fait le bilan de six années de fonctionnement d’InterroGE, dans un article intitulé InterroGE : le service de référence en ligne des bibliothèques de la Ville de Genève.

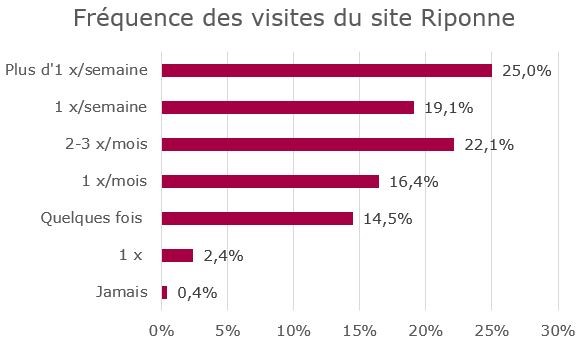

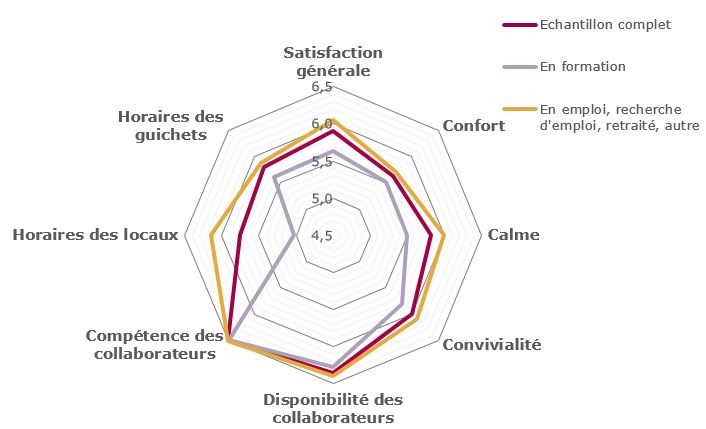

La contribution suivante émane de Françoise Simonet, responsable des renseignements et formation des usagers, et de Christophe Bezençon, responsable du développement des collections, à la Bibliothèque cantonale et universitaire de Lausanne, site Riponne. Elle détaille la méthodologie, les conclusions et les enseignements d’une enquête de satisfaction menée auprès du public du site Riponne, site grand public et patrimonial situé au centre-ville de Lausanne, dans un article intitulé Enquête 2018 sur les besoins non documentaires du public du site Riponne de la BCUL : méthodologie et principales conclusions.

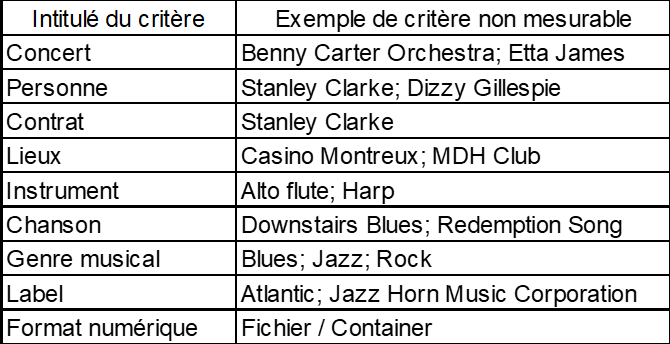

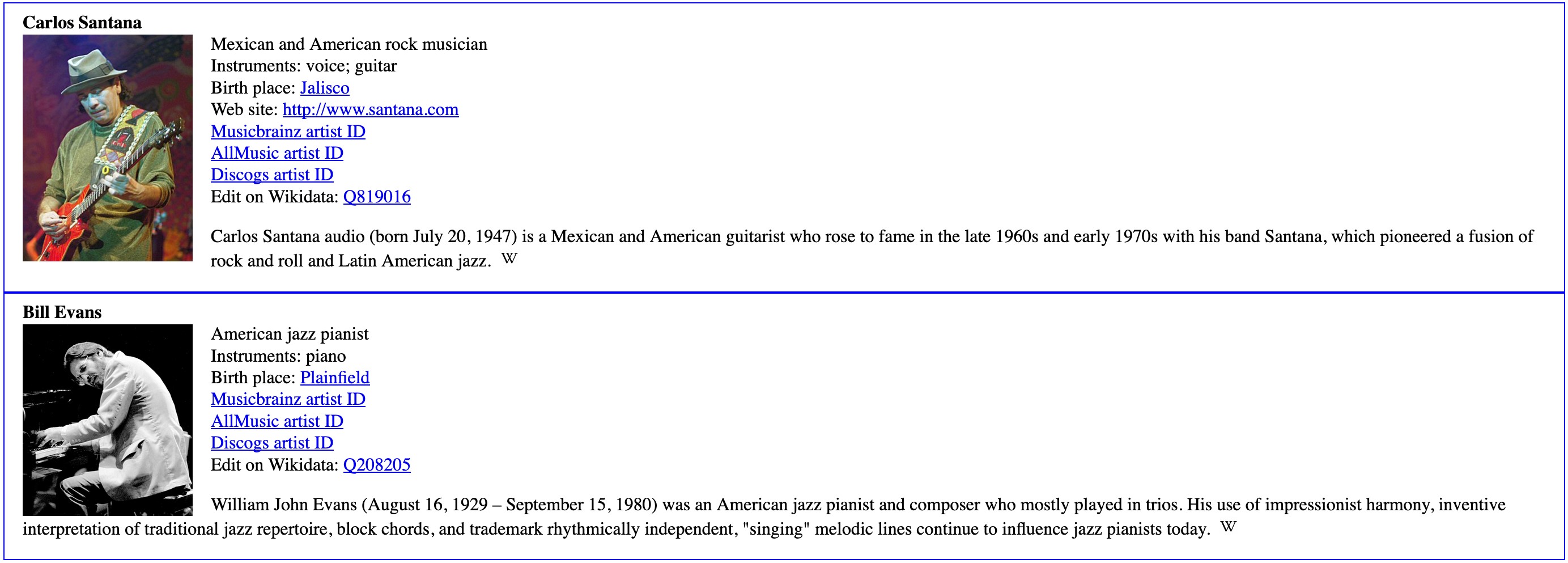

La troisième contribution de cette rubrique, intitulée Alignement et enrichissement des données de l’inventaire d’un fonds d’archives en Linked Open Data : le cas du Montreux Jazz Digital Project,

est due à Alain Chardonnens, spécialiste en information documentaire, et décrit le travail qui a consisté en l’établissement et l’utilisation de critères permettant le transfert d’un jeu de données (émanant du fonds des archives audiovisuelles du Montreux Jazz Digital Project) vers une plateforme de crowdsourcing ou « collaborative knowledge graph ».

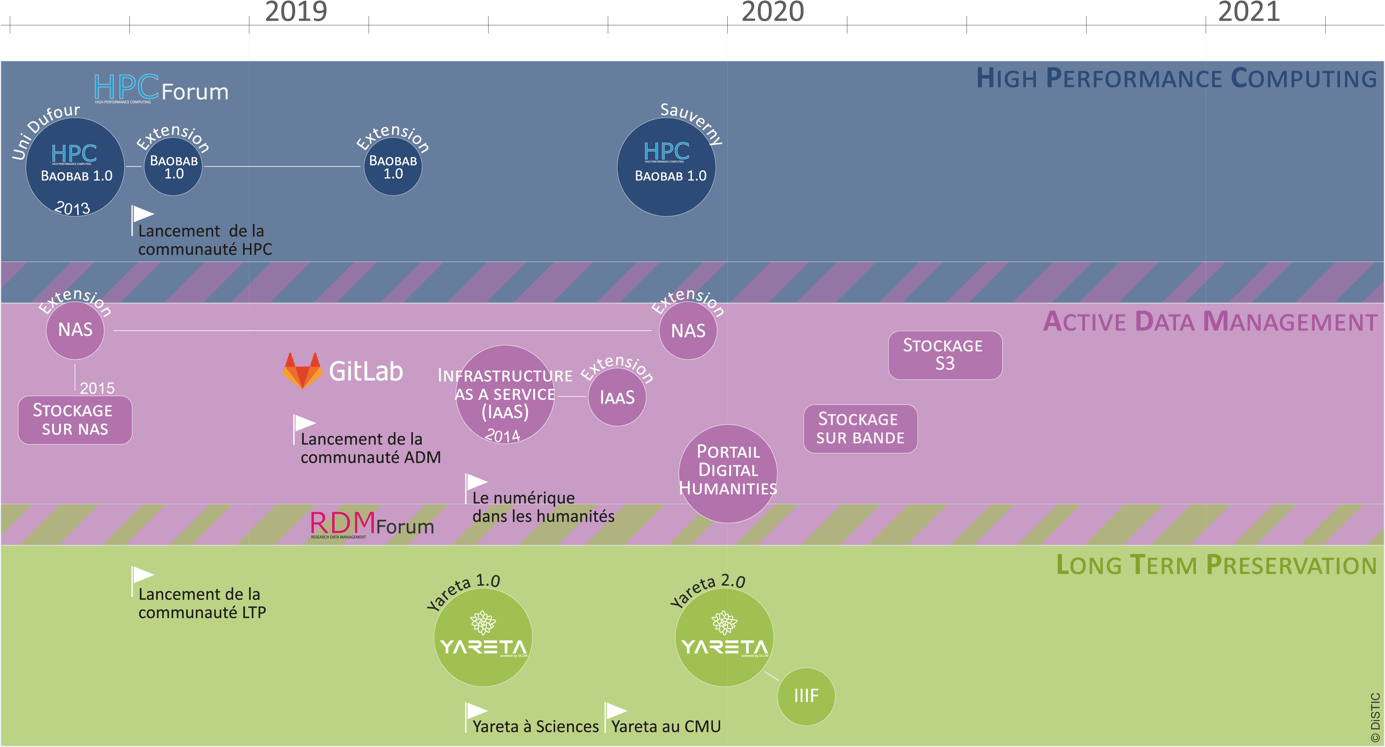

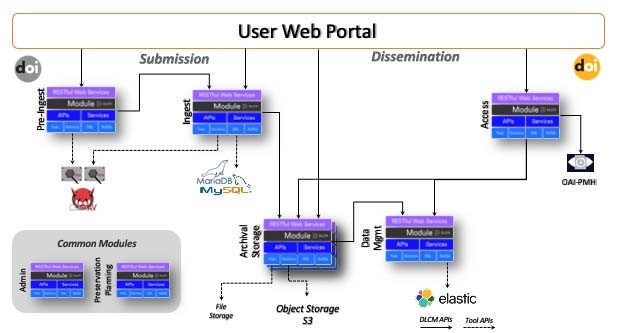

La quatrième contribution, signée Pierre-Yves Burgi, Directeur adjoint des systèmes d’information de l’Université de Genève, relate la genèse et les justifications du projet de loi genevois PL 12146 dans un article intitulé PL 12146 : Infrastructures et services numériques pour la recherche.

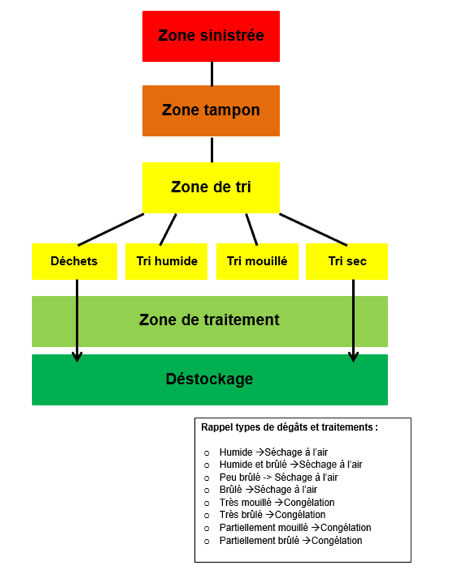

Enfin la dernière contribution de cette rubrique, due à Ludovic Ramalho, assistant de recherche à la HEG-Genève, constitue la synthèse de son travail de bachelor et s’intitule Un plan de sinistres pour la Ville de Montreux : de la conception à la mise en œuvre, et décrit la méthodologie adoptée pour ce travail d’analyse des risques dans un bâtiment d’archives, et donne des recommandations pour la mise à jour d’un plan de gestion de sinistres adapté.

Dans la rubrique Compte rendus d’événements, on trouvera quatre recensions.

La première, une recension à plusieurs voix, émanant de Florence Burgy, Matthieu Cevey, Anouk Santos, Michel Gorin et Benoît Epron, respectivement assistants d’enseignement, maître d’enseignement et professeur associé à la HEG-Genève, rend compte de différentes conférences du congrès IFLA qui a eu lieu du 24 au 30 août 2019 à Athènes (Grèce). Sont notamment recensées des exposés sur la stratégie de l’IFLA, des expériences de réalité augmentée et de réalité virtuelle, le marketing des bibliothèques sur les réseaux sociaux, l’advocacy, l’évaluation de l’impact des bibliothèques, la numérisation de livres…

La deuxième contribution, signée Cynthia A. Germond, étudiante en Master IS à la HEG-Genève, relate les différentes interventions de la journée dédiée à l’Open Science à la HES-SO, qui ont concerné à la fois l’open science (ou la science en libre accès) et les open data (ou données ouvertes) et qui s’est tenue à Lausanne le 18 mars 2019, intitulée Première journée Open Science de la HES-SO.

La suivante, intitulée Forum annuel des bibliothèques HES-SO, 22 août 2019 : les données de la recherche, « un marché à occuper », et signée par Elise Pelletier, collaboratrice scientifique à la HEG-Genève, fait état des différentes interventions, qui montrent cependant que cette prise en main des données de la recherche par les bibliothécaires doit s’accompagner d’une formation de ceux-ci et d’une information accrue auprès des chercheurs.

Le dernier compte rendu de conférence est consacré à la Journée franco-suisse sur la veille et l’intelligence économique, dont la seizième édition a eu lieu le 20 juin dernier à Genève et a porté sur le social listening ou l’écoute des réseaux sociaux. Intitulée De la veille classique au social listening : expérimenter et comparer les outils et les méthodes, cette journée comportait non seulement des témoignages, résumés par l’auteure de ces lignes, rédactrice en chef de RESSI, mais aussi des démonstrations d’outils.

Finalement, la rubrique « Recensions » comporte quatre articles.

Le premier rend compte de l’ouvrage Ce que le numérique fait aux livres de Bertrand Legendre et est signé par Benoît Epron (déjà cité).

Le deuxième article, signé par Elise Pelletier (déjà citée), résume l’ouvrage La médiation : un concept pour les sciences de l’information et de la communication, ouvrage de Jacqueline Deschamps, co-signataire de cet éditorial, paru en 2018.

On trouvera également une recension du livre publié par l’ALA New Top Technologies Every Librarian needs to know (2019) sous la plume de Claire Wuillemin (déjà citée) et qui contient 24 contributions sur des technologies liées aux données, aux services, aux dépôts, à l’accessibilité et à l’interopérabilité.

Finalement, on trouvera, signée par Karsten Schuldt, adjoint scientifique à l'Institut des sciences de l'information de la Fachhochschule Graubünden (Coire), une recension groupée de plusieurs ouvrages parus depuis 2016 sur les fablabs en bibliothèque. Cet article constitue la suite d’une première recension parue dans RESSI en 2016. Ecrit en allemand et intitulé Einleitungen und Vorschläge für Makerspaces in Bibliotheken: Sammelrezension, Teil II (2017-2019) [Introductions et propositions pour des fablabs en bibliothèque : recension groupée, 2ème partie], il montre que l’engouement des bibliothèques pour les fablabs est passé, mais appelle à une recherche empirique sur le sujet. La conclusion est aussi disponible en français.

Nous vous souhaitons une excellente lecture et rappelons que nous sommes ouverts à toute proposition de contribution.

Pour le comité de rédaction:

Jacqueline Deschamps, co-fondatrice de la revue RESSI, Hélène Madinier, rédactrice en chef

Faciliter et soutenir le travail des chercheurs : état des lieux, perspectives et réflexions sur l’exemple de la Haute école de travail social de Genève

Claire Wuillemin, Haute Ecole de Gestion, Genève

Faciliter et soutenir le travail des chercheurs : état des lieux, perspectives et réflexions sur l’exemple de la Haute école de travail social de Genève

Introduction

La recherche scientifique connaît actuellement une grande période de bouleversements : déluge de données, numérisation des méthodes et outils de travail, diversité des produits de la recherche et des nouveaux canaux pour leur diffusion… Voilà autant de thématiques appelant la mise à niveau des compétences et le développement de nouveaux savoirs. Les contextes économiques et réglementaires ne sont pas en reste et possèdent également une force de pression non négligeable, en particulier au travers des institutions de financement de la recherche qui développent leurs exigences au diapason de ces évolutions. Les chercheurs, qui souffrent déjà d’une démultiplication de leurs tâches tout au long du processus de recherche, sont amenés à devoir satisfaire de plus en plus d’exigences.

Ces transformations touchent bien évidemment les chercheurs, mais aussi toutes les parties prenantes qui participent, soutiennent et facilitent l’épanouissement de leurs projets. Comment s’attaquer à une entreprise si grande et hétéroclite alors que l’on est soi-même en plein apprentissage face à la nouveauté de ces enjeux ? Que faire en particulier lorsque l’on est une institution possédant des ressources humaines et financières plus modestes que les universités ?

Portée par ces questionnements, la Haute école de travail social de Genève (HETS-GE), sous l’impulsion de la responsable de son Infothèque, a confié à un mandat de travail de master en Sciences de l’information le soin de prendre la mesure de la situation institutionnelle actuelle ainsi que celle dans les autres écoles du domaine et de proposer des pistes de réflexion voire des solutions implémentables. Les résultats de cette recherche sont synthétisés dans le présent article.

Le soutien et la facilitation de la recherche dans la littérature

Cette partie propose un condensé des principaux éléments retenus dans la littérature : en premier lieu la définition du concept de soutien à la recherche, des types de prestations résultantes, mais aussi des bonnes pratiques de design de services, suivies de la présentation des principaux éléments de contexte à considérer pour obtenir une compréhension globale du sujet et, pour finir, une brève revue des parties prenantes généralement engagées dans les activités de soutien.

Définitions

La littérature spécialisée traite rarement du soutien à la recherche de manière holistique ; on trouve plutôt des ressources se concentrant sur quelques activités contenues au sein de ce processus. C’est pourquoi il est important d’en proposer avant tout une définition.

Dans sa compréhension la plus globale, le soutien à la recherche ou research support en anglais peut se définir comme :

« L’ensemble des activités, des personnes, des compétences et des ressources permettant de rendre possible ou de faciliter le travail entrepris par les diverses parties prenantes de la recherche scientifique – en particulier les chercheurs – lors de l’élaboration, du financement, de la conduite et de la valorisation de leurs projets de recherche » (Wuillemin 2018, p.18)

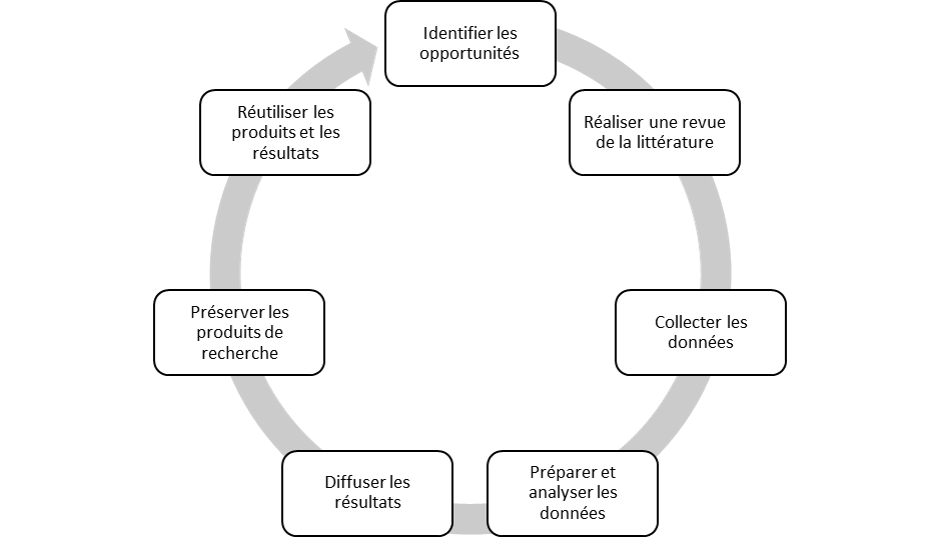

La recherche étant un cycle, le soutien et la facilitation prennent plusieurs formes selon la ou les étape(s) où ils interviennent. Des aides pourront par exemple être apportées lors de l’élaboration de dossiers de demande de subsides, ou pour la recherche d’information dans le but d’alimenter une revue de littérature ; une main-forte pourra aussi être prêtée pour mettre en place des infrastructures pour collecter ou pérenniser les données.

Figure 1: Cycle de la recherche

(Adapté de Nicholas, Rowlands et Wamae 2012; School of Clinical Sciences at Monash Health 2019 et Queen’s university Library 2019)

Quelle que soit l’étape à laquelle ils apparaissent, les services de soutien à la recherche sont le plus souvent séparés en deux catégories majeures : les services techniques et les services d’expert-conseil (Cox et al. 2017 ; Koltay, Spiranec, Karvalics 2015 ; Latham 2017 ; Tenopir et al. 2017 ; Yu 2017). On entend par la première appellation des services prodigués grâce à des compétences ou des connaissances spécialisées et opérationnelles, par exemple la mise en place d’une archive ouverte à l’échelle institutionnelle comme ce fût le cas pour ArODES (Archive ouverte des domaines de la HES-SO) en 2015 – pour stocker de manière pérenne les travaux des chercheurs – ou encore d’un dépôt pour les données de recherche. Les services expert-conseil se focalisent principalement sur la mise à disposition ou la dispense d’information, par exemple les Foires aux Questions (FAQ), les guides d’utilisation ou tout autre support permettant de rediriger les intéressés vers des ressources pertinentes. Cette catégorie de service inclut également les formations et les ateliers qui promeuvent une approche plus pédagogique et plus chaleureuse. Les participants bénéficient d’un contact humain dans la transmission des connaissances et peuvent poser directement leurs questions à l’animateur de la séance. Finalement, le dernier type de service d’expert-conseil le plus répandu sont les séances de coaching personnalisé. Celles-ci ont l’avantage de prodiguer des informations sur mesure aux chercheurs qu’ils peuvent donc inclure directement à leur projet.

Il va de soi que cette typologie dichotomique appelle naturellement le rassemblement de savoir-faire pluriels et hétéroclites. Soutenir et faciliter la recherche mobilise ainsi un éventail d’acteurs hétéroclites (Coomb et al. 2017) – aussi bien du fait de leurs compétences que de leur appartenance aux divers services institutionnels, voire à des entités externes, transversales ou nationales. Ces parties prenantes aidantes peuvent intervenir ponctuellement durant certaines étapes du cycle de recherche, concentrer leurs efforts sur une étape particulière ou, plus rarement, superviser l’intégralité de ce processus. Ces interventions sont fortement différenciées et font appel à des compétences qui ne peuvent être détenues par un individu, un métier ou un service singulier. La raison principale de cet état de fait est que la recherche scientifique a été influencée par plusieurs enjeux distincts qui ont à leur tour soulevé des problèmes pour la communauté de recherche et donc créé des besoins de soutien.

Un phénomène au diapason des transformations et des évolutions

Le soutien à la recherche est de toute évidence façonné par les différents courants qui agitent son environnement. Les aspects présentés ci-après ne sont pas exhaustifs. Il s’agit des enjeux les plus marquants dans le contexte HES et majeurs pour la problématique de la présente recherche, à savoir : le phénomène du publish or perish, la gestion des données de recherche et l’évolution des exigences de bailleurs de fonds.

Payer et publier ou publier et payer : telle est la question

Les enjeux – et surtout les difficultés – autour de la publication des productions scientifiques ne sont pas récents, car la conduite de la recherche scientifique a toujours été intimement liée à la publication de ses résultats. Un problème particulier a fait couler beaucoup d’encre durant ces dernières décennies : le publish or perish. L’injonction est simple à comprendre : les chercheurs doivent publier au risque de voir leur carrière s’étioler irrémédiablement. En effet, la publication scientifique est le moyen principal pour gagner la reconnaissance de leurs pairs et de leur discipline ainsi qu’obtenir des fonds pour poursuivre leurs recherches (Bertaud et Magron 2013). Ce phénomène est bien connu des disciplines scientifiques, techniques et médicales, mais touche également les sciences humaines et sociales. Dans le cas des HES, la contrainte des indicateurs bibliométriques est peut-être plus légère, mais la publication reste un facteur limitant pour la nomination et la conservation des postes appartenant au corps enseignant.

Par ailleurs, il ne suffit pas de publier occasionnellement pour survivre. Le publish or perish encourage une publication régulière, surtout dans des revues bien cotées par divers indicateurs bibliométriques. Puisque les revues deviennent des objets prisés et de convoitise, leur pouvoir de pression est considérable. En plus de devoir déjà se battre pour être publiés, les chercheurs peinent à accéder aux articles nécessaires pour rester informés des tendances et des dernières avancées de leur domaine. En effet, les institutions se retrouvent à devoir payer des frais d’abonnement astronomiques pour accéder aux revues et aux bases de données. Comme si cela ne suffisait pas, ces coûts augmentent chaque année de l’ordre d’environ 8% (Minet 2017).

Cette pression constante a contraint certaines institutions à chercher des alternatives. Ainsi est notamment née l’édition en libre-accès ou en open access, qui se décline en deux alternatives : la voix verte, qui consiste à publier (ou archiver) ses travaux sur une plateforme ouverte (ou institutionnelle) et la voix dorée, qui consiste à publier – parfois contre rémunération pour la prise en charge des frais de publication – dans des revues open access, c’est-à-dire accessibles gratuitement aux lecteurs. Bien évidemment, les grands éditeurs de revues sont conscients du potentiel latent du virage vers la publication en libre accès. C’est pourquoi ils proposent désormais leurs propres revues au format open access. Toutefois cette manière de publier est encore relativement récente et donc encore mal implantée dans les habitudes des chercheurs, qui la citent souvent dans leurs préoccupations (Muller 2014 & Bent 2016). En outre, l’open access s’inscrit dans le plus grand mouvement de l’open science qui cherche à proposer une nouvelle approche de la conduite des projets scientifiques placée sous le signe de la collaboration et la transparence.

Des données et des recherches

La gestion des données de recherche est un sujet très représenté dans la littérature spécialisée, ce qui reflète son actualité. Jusqu’à récemment, seules les publications scientifiques étaient valorisées et protégées comme produits de la recherche scientifique. Cependant, avec la numérisation de la science et le déluge des données, celles-ci commencent maintenant à être considérées comme des éléments angulaires faisant figure de preuves que les chercheurs doivent pouvoir présenter pour appuyer la véracité de leurs résultats. En effet, le mouvement de l’open science a souligné qu’une part non négligeable des projets de recherche étaient financés par des fonds publics. Dans cette même veine, il estime que les contribuables sont en droit de savoir comment est investi leur argent. D’autres prises de position de ce mouvement dénoncent la conduite de projets de recherche de nature similaire qui coûtent du temps et de l’argent aux contribuables, mais aussi aux équipes de recherche. Il est argumenté qu’une gestion plus adéquate et plus transparente ainsi qu’une ouverture des données de la recherche permettraient à des projets de pouvoir s’appuyer sur des résultats et des données antérieures pour éviter de refaire les manipulations nécessaires à la reproduction des données pour une autre application ou une autre recherche. Ainsi, une part de ce mouvement demande que les chercheurs subventionnés par des fonds publics mettent à disposition leurs données en libre-accès.

Ces revendications de transparence sur la gestion et la circulation des données se sont également reflétées dans les évolutions des exigences des institutions de recherche (voir chapitre suivant). Cependant, les chercheurs peinent à embrasser la gestion des données de recherche tout d’abord en raison du manque de temps et de moyens. En effet, pour les chercheurs affiliés aux universités, il est souvent complexe de combiner les activités d’enseignement et celles de recherche, qui sont intrinsèquement déjà complexes et chronophages entre le dépôt de dossiers pour les subventions, la conduite de la recherche proprement dite, la rédaction d’articles, la diffusion et la valorisation des résultats, etc. Malheureusement, plusieurs exemples de la littérature (Corrall 2012 & Delaney et Bates 2015) mettent en avant que les professionnels de l’information ne se sentent pas armés pour prendre en charge la gestion de cette thématique. Pour Sheila Corrall (2012), la source de ce manque de confiance se trouve dans les cursus des enseignements en bibliothéconomie et en sciences de l’information. En effet, bien que les programmes aient pris conscience de l’importance de la gestion des données de recherche, peu d’entre eux forment les professionnels aux compétences techniques requises pour gérer les données. Les formations sont aussi appelées à évoluer et inclure les transformations du monde de la science, qui sont des enjeux tout à fait neufs pour elles aussi. On se trouve donc encore dans une période d’ajustement avant que le personnel ne puisse aider plus efficacement les chercheurs, voire les délester d’une part importante de ce travail.

Des institutions de financement toujours plus exigeantes

À l’extérieur des établissements, plusieurs acteurs sont mobilisés par le soutien à la recherche, mais les plus puissantes sont les institutions de financement de la recherche, appelées aussi bailleurs de fonds. En Suisse, les deux plus connues sont le Fonds National Suisse (FNS) et Innosuisse (anciennement CTI). Ces institutions détiennent un pouvoir de pression non négligeable en ce qu’elles tiennent « les cordons de la bourse » ; sans elles, le financement de nombreux projets de recherche serait compromis, car bien que les institutions mettent à disposition de leurs chercheurs des fonds, ceux-ci sont souvent insuffisants. Les chercheurs les complètent ainsi à l’aide des subventions accordées par ces institutions. Leur caractère irremplaçable leur permet de modifier ou d’introduire unilatéralement de nouvelles exigences pour l’attribution de fonds que les chercheurs peuvent difficilement refuser ou contourner (voir plus bas).

L’émergence de la publication numérique en libre accès et de la gestion des données a agité le milieu scientifique, et les institutions subventionnant la recherche ont également pris position en conséquence, encourageant ainsi le changement. De plus en plus d’institutions, comme le FNS par exemple, exigent désormais qu’un plan de gestion des données de recherche ou Data Management Plan (DMP) soit systématiquement joint aux demandes de subvention. D’autre part, le FNS ne délivre plus de subside pour la publication autre qu’en open access. Les chercheurs sont donc astreints à publier dans des revues ou des bases de données en libre-accès (1). L’objectif est que tous les travaux soient publiés en open access d’ici à 2020. Ces mesures visent à augmenter la validité des résultats des projets scientifiques ainsi que leur reproductibilité (Latham 2017).

Déploiement de services : mode d’emploi et acteurs mobilisés

À la lumière de la diversité des thèmes susmentionnés, on pourra comprendre la nécessité de mobiliser un large éventail d’acteurs – qui constituent par ailleurs la raison d’être de la pluridisciplinarité de ce processus – et de les présenter ci-après. Mais avant tout, il est important de mettre en exergue quelques éléments de bonnes pratiques pour l’implémentation de services au sein des établissements d’enseignement de niveau tertiaire et tout particulièrement l’inclusion de ceux-ci au sein de leur stratégie.

Étant donné que ces différents services sont composés de différentes professions et manières de faire ainsi que de collaborateurs appartenant à un vaste éventail de départements, la littérature souligne que les universités souffrent souvent de la présence de structures en silos (Bent 2016). Les parties prenantes évoluent en groupements étanches et spécialisés sur des thèmes et compétences précis. Il n’y a pas de communication proactive hors de cet écosystème ni d’alliance. Cela constitue un frein à l’effort de soutenir et faciliter la recherche, car cet effort se doit d’être fondamentalement collectif et pluridisciplinaire. La coopération et la collaboration entre les services sont donc cruciales. D’autre part, et cela est intimement lié à la problématique susmentionnée, le soutien à la recherche souffre souvent d’un manque de leadership (Soehner et al. 2010, Cox et Pinfield 2014, Pryor 2014 & Yu 2017). La littérature propose plusieurs raisons à cette lacune, mais Moira Bent (2016) met en exergue l’importance lexicale propre à l’expression de soutien à la recherche, research support en anglais : le terme de support est intrinsèquement passif. Pourtant, la recherche ne pourrait s’accomplir sans l’implication des différents acteurs présentés. Moira Bent propose donc de préférer le terme « faciliter » pour y remettre un rôle plus actif et ainsi renvoyer une image plus fidèle de cette cohorte d’activités et de l’implication réelle et angulaire des unités facilitatrices. L’introduction de nouveaux services doit en outre suivre une approche bottom-up ; c’est-à-dire partir de l’identification des besoins de la communauté de recherche et les confronter ensuite aux ressources humaines et financières disponibles (Schöpfel et al. 2017). En outre, il faut que ceux-ci soient alignés sur la stratégie institutionnelle afin d’en pouvoir justifier la création et de bénéficier du soutien des instances décisionnelles. Il est finalement primordial de s’appuyer sur les expertises disponibles à l’interne et bien souvent disséminées au sein des divers départements mobilisés par le soutien à la recherche.

Un autre aspect à prendre en compte mis en avant par Moira Bent (2016) est que les chercheurs ne forment pas une communauté homogène. Effectivement, tous ne travaillent pas sur des thématiques identiques, ni même voisines, et possèdent des niveaux d’expérience variés. De plus, contrairement à ce que sous-entend la généralité de l’appellation “communauté”, on a plutôt affaire à plusieurs communautés. En effet, les chercheurs tendent à former des groupements hétérogènes dépendants de leurs centres d’intérêt et de leurs expertises de recherche, plutôt qu’un ensemble soudé. Il est donc important de prendre en compte les différents profils et intérêts de chercheurs avant de développer des services. Par exemple, tous les chercheurs ne bénéficient pas de subsides de fonds de tiers.

« It takes a village » : parties prenantes mobilisées

Au sein des institutions, plusieurs acteurs détiennent les compétences nécessaires pour faciliter et soutenir la recherche. Leur ordre d’apparition ci-après est aléatoire ; il ne reflète en aucun cas un ordonnancement par ordre de valeur ou d’importance.

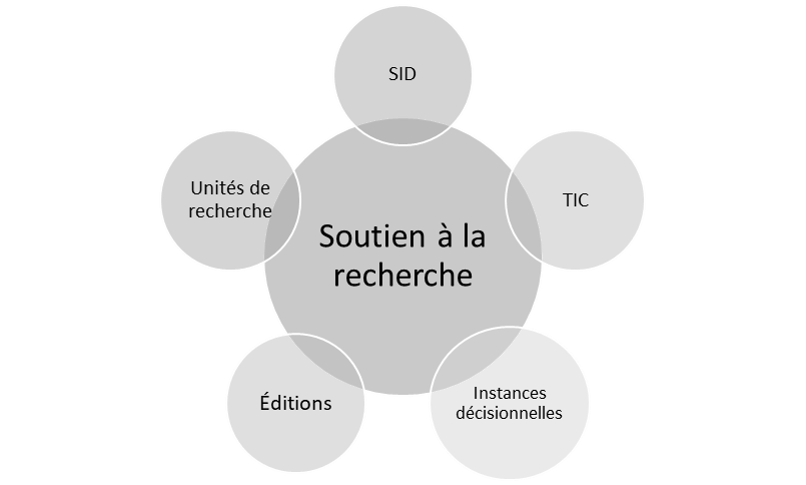

Figure 2: Parties prenantes mobilisées par le soutien à la recherche

- Maison d’édition/presses universitaires

Certaines institutions tertiaires ont la chance de posséder des maisons d’édition au sein même de leurs murs. Les chercheurs peuvent donc choisir de publier directement par leur biais ou de se tourner vers des éditeurs externes. En raison de ses compétences éditoriales, ce genre de département a un rôle prééminent à jouer dans la relecture de manuscrits ou l’encouragement, l’information et l’accompagnement pour la publication en open access.

- Services institutionnels centraux de soutien à la recherche

Au sein des institutions d’enseignement tertiaire actives dans la recherche, il existe dans la plupart des cas un comité de pilotage formé de représentants des diverses sous-communautés de recherche ou de chercheurs confirmés, ainsi que des services de soutien à la recherche. Le rôle principal de cette entité est de coordonner les activités de recherche et d’accompagner les autres chercheurs durant les différentes étapes du cycle de la recherche. Il lui revient également la responsabilité d’appliquer les directives institutionnelles liées à la recherche.

- Services informatiques et des technologies de l’information

Les services dédiés à l’informatique et aux technologies de l’information assurent la mise en place et l’intégrité des infrastructures nécessaires au travail et au bon fonctionnement des autres services institutionnels. Dans le cadre des efforts pour soutenir et faciliter la recherche, ce type de service peut mettre en place des solutions sur mesure et/ou à la demande des chercheurs, ou collaborer avec d’autres services pour la mise en place de projets comme une archive ouverte institutionnelle par exemple.

- Instances décisionnelles

Sous l’appellation « instances décisionnelles » sont compris tous les organes d’une institution qui fédèrent et décident des orientations stratégiques à l’instar des comités de direction ou du rectorat. En leur qualité de tête de file, ce sont à elles que revient le devoir de mettre en place des objectifs et des politiques qui tissent les canevas sur lesquels doivent évoluer les chercheurs. Elles ont donc la responsabilité de prendre position sur les thématiques d’actualité pour donner une direction à leur stratégie et leur culture de recherche. Ce sont ces entités qui produiront des politiques et des directives afin d’entraîner ce changement, ou qui alloueront des ressources nécessaires aux services compétents.

- Les bibliothèques et centres de documentation

Les bibliothèques sont parfois mises à l’écart du reste de la communauté de recherche, tout d’abord, spatialement ; les bibliothèques n’étant souvent pas dans le même bâtiment ou zone du campus universitaire en raison de leur double-usage étudiants et chercheurs, mais également vis-à-vis du rôle que celles-ci ont joué dans le processus de recherche. En effet, les bibliothèques sont encore bien trop souvent perçues comme des lieux où l’on va chercher des livres ou où l’on peut travailler en silence. Pourtant, leur place traditionnelle et centrale dans l’accès et la diffusion du savoir – qui fait par ailleurs partie de leur êthos – s’inscrit tout à fait dans les enjeux actuels de publication en open access et de gestion des données de recherche (Corrall 2012 & Tenopir et al. 2017). Toutefois, elles souffrent de leur manque de visibilité, de la méconnaissance par les publics des services et des compétences qu’elles mettent à leur disposition, et de l’effritement de leur budget engendré par les tensions du tissu économique. En outre, certains bibliothécaires peinent à être convaincus que leur métier doit évoluer pour s’ouvrir vers le nouveau paradigme de l’e-science et ainsi inclure de nouveaux objets et thématiques tels que la gestion des données de recherche ou la publication et la diffusion des produits scientifiques en open access.

Perspectives pour les bibliothèques et autres services d’information documentaire

Pour clore cette première section, il semblait à propos de s’arrêter un instant sur les bibliothèques et autres services d’information pour une mise en perspective bien méritée. À l’heure où les bibliothèques doivent de plus en plus prouver leur valeur et leur utilité pour la collectivité, les professionnels prennent conscience qu’un changement de direction est nécessaire. De nouveaux modèles pour guider le métier sont à identifier. La littérature mentionne depuis quelques années l’idée des professionnels de l’information comme partenaires de recherche. Toutefois, certains peinent à croire à la viabilité de cette solution et les preuves empiriques de celle-ci sont rares, voire inexistantes. Assurément, un équilibre est à trouver entre partenaires et simples colocataires de locaux auxquels on fait vaguement et ponctuellement appel comme ultime recours. La bibliothèque ne doit pas être qu’une solution alternative pour les chercheurs, mais bien un acteur incontournable.

La bibliothèque ne peut plus se permettre de n’être qu’un lieu où l’on va consulter des livres et les bibliothécaires de n'être que les gardiens de contenus papier, ainsi que le laissent penser les clichés et la vision étriquée qu’on porte sur eux. Il est vital que les professionnels saisissent l’opportunité du tournant de la numérisation des savoirs, faute de quoi le changement se fera sans eux et les nouvelles thématiques, notamment la publication numérique en open access et la gestion des données de recherche, seront portées par d’autres peut-être historiquement moins équipés, mais qui auront été au bon endroit ou au bon moment. Du reste, cela devrait devenir l’adage des professionnels de l’information : la bonne information, au bon endroit au bon moment.

Finalement, il faut apprendre à jouer en équipe et chercher activement à tisser des relations avec les autres services impliqués dans le soutien. Il s’agit de changer de perspective et d’aller dans le sens du nouveau paradigme collaboratif de la recherche : une partie des efforts de facilitation peut être réorganisée ou faite en collaboration avec des collègues d’autres services dans l’idée de mise en commun des expertises. Pour reprendre un argument de Starr Hoffman (2016) – sur les bibliothèques académiques, mais qui peut tout à faire être étendu aux autres services de soutien – avec d’un côté la pression actuelle sur les ressources budgétaires et humaines, et de l’autre, la création de nouveaux besoins par les évolutions de l’environnement de recherche, les acteurs se sentent coincés et pensent devoir « faire plus avec moins ». Néanmoins, il s’agit plutôt de “do less, but deeper”, c’est-à-dire qu’il faut trouver les forces et les spécificités de chaque service et identifier ce dont la communauté de recherche a réellement besoin.

Méthodologie de la recherche

Partant des constats énumérés ci-dessus, l’institution mandante genevoise cherchait à déterminer comment soutenir et faciliter le travail de ses chercheurs tout en se positionnant en adéquation avec les exigences et les tendances de la recherche scientifique. Cette entreprise venait avec la difficulté supplémentaire de prendre en compte le contexte et l’organisation particuliers et typiquement suisses des hautes écoles spécialisées (HES). La Haute école spécialisée de Suisse occidentale (HES-SO) est une institution de niveau tertiaire – soit le même que les universités – constituée d’un réseau de plusieurs écoles réparties dans sept cantons romands. Dans le cas du Travail social, il existe quatre écoles dispensant des enseignements dans cette matière à Genève, Fribourg, Sierre et Lausanne. Ces quatre écoles forment le domaine Travail social de la HES-SO. Néanmoins, elles sont également et avant tout rattachées à des regroupements régionaux. En conséquence, les écoles conservent une certaine indépendance les unes des autres et tendent à ne pas mutualiser leurs services de soutien. Il est à noter que certains services sont proposés de manière transversale par la HES-SO et donc accessibles à tous les collaborateurs, quel que soit leur établissement d’attache.

Pour répondre aux attentes du mandant tout en prenant en considération le contexte susmentionné, le travail s’est articulé en trois axes : tout d’abord la conduite d’un état de l’art pour mettre en exergue le contexte de la recherche scientifique ainsi que les tendances actuelles du soutien à la recherche, en particulier dans les services d’information et de bibliothèques. Cette étape visait à obtenir des informations qui ont servi de base comparative avec les données qui ont été recueillies lors de la deuxième étape du travail. Cette dernière a consisté en la conduite d’entretiens à différents niveaux de la HETS : d’une part de manière individuelle avec les responsables des différents services actuellement impliqués dans la recherche et son soutien, et d’autre part au moyen de groupes de discussion focalisée avec différents chercheurs de l’institution. À la suite des collectes, des synthèses des entretiens ont été rédigées et soumises aux répondants pour validation. Ce moyen a été préféré à la rédaction de verbatim pour des considérations de gain de temps, mais aussi en raison du fait que certains répondants souhaitaient rester anonymes dans le rapport écrit. Avec une transcription mot à mot, cet anonymat n’aurait pas pu être garanti, car certaines informations ou le recoupement de groupes informations auraient permis l’identification du répondant. L’analyse des données contenues dans ces synthèses et leur comparaison avec les données compilées depuis l’état de l’art ont permis de réaliser l’ultime étape du travail : un diagnostic de l’écosystème du soutien à la recherche scientifique à la HETS-GE et la formulation de recommandations ainsi que de pistes d’optimisation et de développement de celui-ci.

Afin de pouvoir dresser le bilan de la situation actuelle du soutien à la recherche HES-SO en Travail social, il avait été prévu de rencontrer deux populations phares de cette thématique : les prestataires, soit les divers services impliqués, et les bénéficiaires, soit les chercheurs.

Au début de la recherche, il avait été planifié de rencontrer des membres des deux populations au sein des quatre écoles susmentionnées dans le but de mener une étude comparative de la situation actuelle et de la maturité du soutien à la recherche entre les quatre sites. Un autre objectif était d’évaluer s’il existait des recoupements dans les besoins et les volontés de développement afin de déterminer la faisabilité de la mise en place d’un centre ou de toute autre structure de soutien à la recherche commune à l’échelle du domaine Travail social. Néanmoins, en dehors de l’institution mandante genevoise, les personnes et les entités interrogées n’ont pas répondu par la positive à nos sollicitations. La recherche a donc été réorientée sur un état des lieux institutionnel tout en gardant dans les investigations la question d’un intérêt pour un centre ou des services mutualisés de soutien à la recherche.

Au total, cinq prestataires de services ont été rencontrés : la direction de l’école, de la bibliothèque et des éditions institutionnelles, ainsi qu’un responsable de l’unité de soutien de la recherche HES-SO. Pour la communauté de recherche, deux groupes de discussion focalisée ont pu être organisés et ont permis de rencontrer un quart des chercheurs actifs à la HETS-GE : l’un avec les membres du comité du centre de recherches sociales (CERES) – comité en charge de la coordination de la recherche à la HETS-GE formé de chercheurs expérimentés – et un second avec des chercheurs moins expérimentés ou appartenant au corps intermédiaire.

Résultats et discussion

Les données obtenues lors des différentes rencontres avec les responsables et membres des services impliqués dans la dispense de prestations ont mis en lumière que des efforts étaient déjà entrepris en termes de soutien et de facilitation de la recherche. En revanche ceux-ci ne sont ni formalisés, ni coordonnés. Ce chapitre s’arrête sur les points saillants mis en valeur par la collecte de données sur le terrain, puis propose un bilan global du soutien à la recherche au sein de la HETS-GE.

Éléments préexistants et facteurs limitants institutionnels

Avant de passer aux éléments tangibles, il est nécessaire de souligner quelques éléments de contexte qui permettront d’apporter une dimension supplémentaire aux résultats présentés ci-dessous.

Tout d’abord, les représentants des services institutionnels sont unanimes sur le fait que les ressources financières sont un facteur limitant majeur. Cela s’explique par le climat économique commun à la plupart des institutions d’enseignement supérieur, mais également par le fait que la position de directrice adjointe en charge des finances est restée longtemps vacante – jusqu’à septembre 2018, date à laquelle ce poste a été pourvu – ; ajoutant ainsi une difficulté supplémentaire à ce climat inconfortable. Du côté des responsables des éditions et de l’Infothèque, il est rapporté que le budget et les ressources humaines sont tout juste satisfaisants en l’état pour remplir leurs missions. Un investissement dans ces deux pans serait nécessaire pour améliorer le confort de travail et surtout pour accueillir plus de demandes et développer de nouvelles prestations. Il est logique que ce facteur rende considérablement incompatibles les stratégies rapides et spontanées d’accroissement du soutien à la recherche ; en particulier si elles nécessitent l’investissement de temps de travail et engendrent des coûts non négligeables – ce qui est invariablement le cas pour en assurer la qualité.

Un deuxième point à mettre en exergue est que, préalablement à la présente recherche, le CERES s’est engagé dans un projet pilote initié par le Dicastère Qualité d’évaluation de la recherche institutionnelle de la HES-SO. Celui consistait à mener une auto-évaluation sur les activités et les prestations existantes de recherche à la HETS-GE ; tâche qui a été menée par le responsable de la recherche et complétée par les membres du comité du CERES. Bien que la présente étude se soit déployée indépendamment de cet effort, elle a pu bénéficier des réponses et des réflexions mobilisées par l’auto-évaluation, laquelle possédait des similarités dans ses objectifs et questions de recherche, notamment sur les aspects de besoins des chercheurs et de l’évolution des exigences des bailleurs de fonds et de l’environnement de recherche.

Impacts de la tendance de la publication en open access

Les nouvelles exigences des bailleurs de fonds ont d’ores et déjà eu des retombées en particulier pour la publication en open access. En effet, lors des entretiens individuels, les représentants de la plupart des services rencontrés ont dit avoir mis en place de nouvelles infrastructures pour répondre à cet enjeu. Les éditions IES – maison d’édition institutionnelle de la HETS-GE – ont souscrit à OpenEdition Books, une plateforme de publication en libre-accès où elles publient désormais la majorité de leurs nouveaux ouvrages au format numérique. À noter que la publication papier est pour le moment maintenue, car les éditions sont d’avis que ce medium a encore une raison d’être dans le domaine. Néanmoins, les responsables sont conscientes que le dédoublement des coûts de publication n’est pas une solution viable sur le long terme. Elles s’inquiètent également de la place de la rémunération du travail d’édition au sein d’un modèle de publication en open access, ainsi que des enjeux liés à la visibilité des productions engendrées par ce modèle à l’heure où les plateformes de diffusion se multiplient et que leur interopérabilité n’est pas encore monnaie courante.

À l’échelle de l’institution, une politique sur la publication en open access a été adoptée. En revanche, il n’existe pas encore de service ou de comité formalisé chargé d’endosser la responsabilité de cette thématique au sein de la HETS-GE ou même au niveau régional ou de la HES-SO.

En ce qui concerne les chercheurs rencontrés, bien que la vaste majorité ait été informée de l’évolution de ces exigences – soit car ils en dépendent directement, soit parce qu’ils en ont eu vent à travers leurs lectures ou d’autres contacts avec l’environnement de recherche – il est néanmoins apparu que la compréhension de ces enjeux est inégale et imparfaite. Cette tendance a été observée dans les deux focus groups menés auprès des chercheurs seniors et des chercheurs plus novices. Les deux groupes de répondants ont fait part d’un désir qu’un accompagnement et des moyens de formation soient mis en place pour les armer et les aider à se conformer aux attentes qui pèsent ou vont peser sur eux.

(Bonnes) pratiques de la gestion des données de recherche

La gestion des données de recherche n’est pas encore une préoccupation majeure de la communauté de recherche HETS-GE. Les chercheurs seniors du premier focus group ont relaté qu’en dehors du devoir de fournir un plan de gestion des données (DMP), le reste de la gestion des données est laissé à leur discrétion. Les bailleurs de fonds auxquels ces chercheurs font appel, notamment des fondations privées et d’autres organismes actifs en travail social, n’ont pas encore établi d’exigences sur la gestion ou l’archivage des données issues de leur parrainage, contrairement aux publications découlant des recherches. Ainsi, les chercheurs ont chacun des méthodes et des outils ad hoc pour gérer leurs données : qu’il s’agisse de les stocker sur une mémoire externe ou dans le cloud à l’aide de SwitchDrive ou de Dropbox. De plus, il a été mentionné par le groupe composé principalement de membres du corps intermédiaire, que la plupart d’entre eux ne bénéficiaient pas de fonds de tiers et donc d’aucune obligation de rendre des comptes sur la gestion de leurs données de recherche.

C’est pourquoi une des premières conclusions de la présente étude est que la mise en place d’un centre institutionnel de soutien à la recherche n’est pas une proposition plausible en l’état. Cela reviendrait à sauter une étape dans le développement du processus. Le soutien à la recherche institutionnel doit auparavant bétonner un certain nombre de fondations critiques afin de s’inscrire dans la stratégie globale de l’institution. Il faut également qu’il s’enracine davantage au sein des différents services mobilisés. Le développement inter-institutionnel ne pourra être envisagé qu’une fois que ce processus se sera parfaitement intégré au sein de l’institution.

Expression des besoins et propositions de développement de services

Lors des entretiens semi-dirigés et des deux focus groups, les participants ont eu l’occasion d’exprimer des propositions d’amélioration des services existants ou de développement de nouvelles prestations en réponse à des besoins encore insatisfaits. Sont présentés ici les éléments jugés majeurs et entrant en résonance avec ceux identifiés dans la revue de littérature.

Pour commencer, les responsables du CERES, de la direction et de l’Infothèque tombent tous d’accord sur le fait que la visibilité via les sites internet, peu satisfaisante, et leur ergonomie, sont des éléments à revoir. En effet, pour les premiers, il s’agit d’un frein conséquent à la visibilité des activités de recherche, et pour l’Infothèque cela limite la visibilité de ses prestations et de ses compétences. Par ailleurs, il existe une volonté de développer un lien plus fort entre l’Infothèque et le CERES en raison de la sous-utilisation des ressources et savoir-faire de cette première, volonté appuyée par la direction.

Du côté des chercheurs, plusieurs besoins ont été mis en lumière ; parfois uniquement lors d’un des deux focus groups et d’autres fois faisant consensus auprès de tous les profils rencontrés. D’abord, il est nécessaire que les chercheurs restent informés des dernières nouveautés liées à leurs objets de recherche. C’est pourquoi, certains répondants appartenant au premier focus group faisaient part de l’intérêt de pouvoir confier leur veille à un service interne – notamment à l’Infothèque. Toujours à ce sujet, la veille média actuellement assurée par l’Infothèque, et dont les résultats sont envoyés régulièrement sous forme de PDF par courriel, a été mentionnée. En effet, les participants ont salué l’utilité de cette démarche, mais soulignent le côté inadéquat du support PDF, qui engendre un délaissement regrettable de leur part. Ils souhaiteraient donc voir modifiés les résultats de cette veille vers une forme de livrable plus aisément et rapidement consultable.

Les membres du premier focus group ont mentionné devoir réaliser dans le cadre de dépôt de dossier des revues de littérature exhaustives, qui sont par conséquent exigeantes et chronophages. C’est pourquoi il leur serait utile de pouvoir déléguer en partie, voire entièrement, ce travail. À l’heure actuelle, certains répondants confient déjà cette tâche à des personnes externes à leurs frais. Étant donné le consensus autour de ce besoin, les répondants soulignaient donc que la mise en place d’une telle prestation sponsorisée par l’institution, ou mutualisée à l’échelle du domaine Travail social serait appréciable. Dans cette même veine, certains chercheurs exprimaient aussi leur intérêt pour une prestation de relecture de manuscrits avant publication, tout particulièrement pour les aspects de conformité des bibliographies et des citations – et mentionnent l’adéquation de cette requête avec les compétences naturelles de l’Infothèque.

Pour leur part, les membres du second focus group – principalement affiliés au corps intermédiaire – ont expressément demandé l’accroissement de la visibilité des ressources et des aides actuellement proposées par les différents services institutionnels pour les activités de recherche. Bien qu’ils imaginent qu’une offre non-négligeable existe, elle leur est totalement méconnue. Un vœu est donc exprimé pour accroître la visibilité et l’accessibilité de cette offre qui rejoint la faiblesse précédemment identifiée par les services institutionnels.

Finalement, un besoin unanime des deux focus groups est celui d’être informé et soutenu vis-à-vis des nouvelles exigences (open access et gestion des données de recherche, mais pas uniquement) de l’environnement de recherche. Directement concerné ou non à travers leurs activités de recherche actuelles, l’ensemble des répondants sait que ces évolutions doivent être embrassées et comprises, car elles sont des éléments angulaires de l’environnement dans lequel ils évoluent. Leur souhait est d’être munis du savoir adéquat pour faire des choix éclairés et de posséder des connaissances suffisantes pour choisir des outils fiables et efficaces.

Bilan du soutien à la recherche à la HETS

L’ensemble des éléments précédemment mis en exergue permettent de dresser un bilan général du soutien à la recherche actuellement proposé au sein de la HETS-GE.

Le premier constat du présent mandat a été que, bien que des services de soutien existent déjà au sein de la HETS-GE, ceux-ci souffrent d’un manque de visibilité qui entraîne souvent leur non-utilisation. Par ailleurs, le personnel des divers services rencontrés s’est montré très conscient de son rôle à jouer, mais s’étonnait que les chercheurs ne fassent pas davantage appel à ses compétences et ses expertises sur des sujets pointus (open access, veille, gestion des données de recherche). De leur côté, les chercheurs ignoraient effectivement l’existence de certaines prestations internes, mais aussi proposées par la HES-SO (notamment le Research Data Coordination Desk et l’unité d’appui Ra&D) ainsi que les compétences détenues par le personnel encadrant la recherche.

Cette méconnaissance est imputable à plusieurs facteurs :

Tout d’abord, l'absence d’une structure claire et formalisée destinée à soutenir et faciliter la recherche qui permettrait aux différents acteurs de se rassembler ainsi que de coordonner leurs efforts et de créer un groupement de compétences transversales prêt à répondre aux multiples enjeux du soutien à la communauté scientifique. À l’heure actuelle, chaque acteur agit de manière indépendante et propose des solutions sur mesure, ad hoc pour donner suite aux sollicitations. Cette situation entache la visibilité des compétences, mais également des services, tout en entraînant le risque d’une redondance dans les efforts de deux services différents s’attaquant à une thématique. De plus, cette carence d’organisation entraîne une certaine informalité et une absence totale de stratégie – dont le rôle devrait être de motiver et de donner une raison d’être à ces services.

Dans un deuxième temps, une caractéristique unique à la HETS-GE, et dont résultent les constats susmentionnés, est son organisation. En effet, les services et les chercheurs sont dispersés dans divers bâtiments localisés à plusieurs endroits. Tout naturellement, cela limite considérablement les rencontres fortuites. Il s’agit donc d’occasions manquées pour les chercheurs d’exprimer leurs besoins, et pour les membres d’un service d’affirmer leurs compétences et de mentionner l’existence de services ou d’une ressource. Cette structure en silo est donc un frein à la communication entre les acteurs qui poursuivent parfois des buts communs chacun de leur côté – démultipliant ressources et temps investis.

Conséquence directe de la remarque précédente, il n’y a actuellement que peu de communication entre les services et les chercheurs, et également inter-services. Le travail de promotion des services et des compétences reste souvent timide, voire presque absent. Les pages web des services ne mentionnent par exemple pas quelles prestations sont ou peuvent être proposées aux chercheurs.

Les répondants n’étaient pas au courant de l’existence de services de soutien à l’échelle de la HES-SO, notamment la présence d’une archive ouverte (ArODES) ou les diverses unités de soutien à leur disposition : l’unité d’appui Ra&D, spécialiste des questions d’acquisition de fonds de tiers, et le Data coordination Desk. Il semble que leur non-utilisation soit également imputable à un manque de communication. Cependant, ces services s’adressent à l’ensemble de la HES-SO. Par conséquent, leur promotion n’est pas du ressort direct de la HETS-GE, même si on peut s’attendre à ce qu’elle diffuse et promeuve un peu ces prestations.

Pour conclure, lors des rencontres, une question était posée sur l’intérêt des répondants vis-à-vis de la mutualisation de certains services de soutien, voire de la mise en place d’un centre dédié au soutien à la recherche, mutualisé à l’échelle du domaine Travail social de la HES-SO. À la lumière du bilan institutionnel et des facteurs limitants liés aux ressources, mutualiser à l’échelle du domaine s’impose comme une solution intelligente et efficiente puisqu’elle permet d’en faire plus sans devoir investir toutes les ressources nécessaires individuellement. L’ensemble des répondants des focus groups et des entretiens abondait dans ce sens. Toutefois en l’absence de réponses des trois autres écoles, il a été impossible d’en juger la faisabilité. Nonobstant ce manque et les limitations existantes, des dispositions ont déjà été mises en place et des améliorations demandant un investissement maigre en ressources peuvent être envisagées, comme proposé ci-après.

Propositions et recommandations

En prenant en compte le contexte HES – en particulier celui de la HETS de Genève – ainsi que les résultats de la collecte de données, une proposition théorique ainsi que cinq recommandations ont été formulées. Bien que ces recommandations soient avant tout des pistes de solutions aux difficultés constatées à la HETS-GE, leur pertinence peut s’étendre à toutes les institutions faisant face aux mêmes enjeux environnementaux ou souhaitant simplement mettre en place un soutien à la recherche efficient et adéquat.

Les trois piliers du soutien et de la facilitation de la recherche

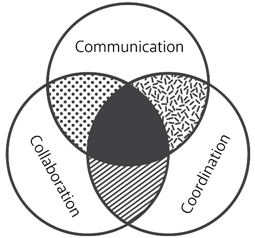

Les résultats des investigations sur le terrain, croisés avec les informations recueillies dans la littérature, ont permis de déterminer que la facilitation de la recherche dépendait étroitement de l’équilibre de trois piliers :

- La communication ; on entend par là autant les échanges entre les prestataires de soutien entre eux qu’avec les bénéficiaires de leurs efforts. Ces derniers doivent également transmettre leurs suggestions et leurs besoins de manière proactive et itérative.

- La coordination ; c’est-à-dire l’organisation formelle de tous les efforts, services et activités de facilitation mis à l’œuvre dans le but de réduire la redondance et d’augmenter l’efficience et l’adéquation avec les besoins de la communauté de recherche.

- La collaboration ; cela implique que le soutien et la facilitation ne peuvent être dispensés par un service ou un profil de compétences unique. Étant donné l’hétérogénéité des enjeux mobilisés par ce processus, une pluralité d’acteurs est nécessaire pour y répondre et trouver des solutions efficaces.

Figure 3: Les trois piliers du soutien à la recherche

(Wuillemin 2018, p.53)

Ces trois points devront donc être utilisés comme leviers lors du déploiement d’un effort de facilitation de la recherche transversal et commun à l’ensemble de l’institution afin de permettre d’ancrer celui-ci dans la culture institutionnelle et stratégique de l’institution.

Unifier pour régner : création d’un organe de coordination

La présence d’une entité réunissant l’ensemble des parties prenantes mobilisées par le soutien à la recherche – à savoir : l’Infothèque, les éditions IES, le centre de recherche sociale (CERES) et un représentant des chercheurs et de la direction des établissements – est cruciale. Cette entité pourrait par exemple prendre la forme d’un comité.

Les missions de cet organe devraient inclure les points suivants :

- Observer et coordonner les activités institutionnelles de soutien et de facilitation de la recherche.

- Mettre en place des objectifs stratégiques pour développer le soutien à la recherche qui soient cohérents et en continuité avec les objectifs de l’institution et de la HES-SO.

- Rédiger et diffuser des politiques, des guides ou des règlements pour orienter, encadrer et uniformiser les divers aspects de la facilitation de la recherche notamment autour des questions de publication des résultats de recherche et de gestion des données de recherche.

- Créer un espace permettant l’échange entre les représentants des services et les chercheurs, afin que les besoins de ces derniers soient entendus et que les services puissent mettre en avant leurs compétences, et le partage autour des thématiques/enjeux/nouveautés de la recherche scientifique et de son environnement.

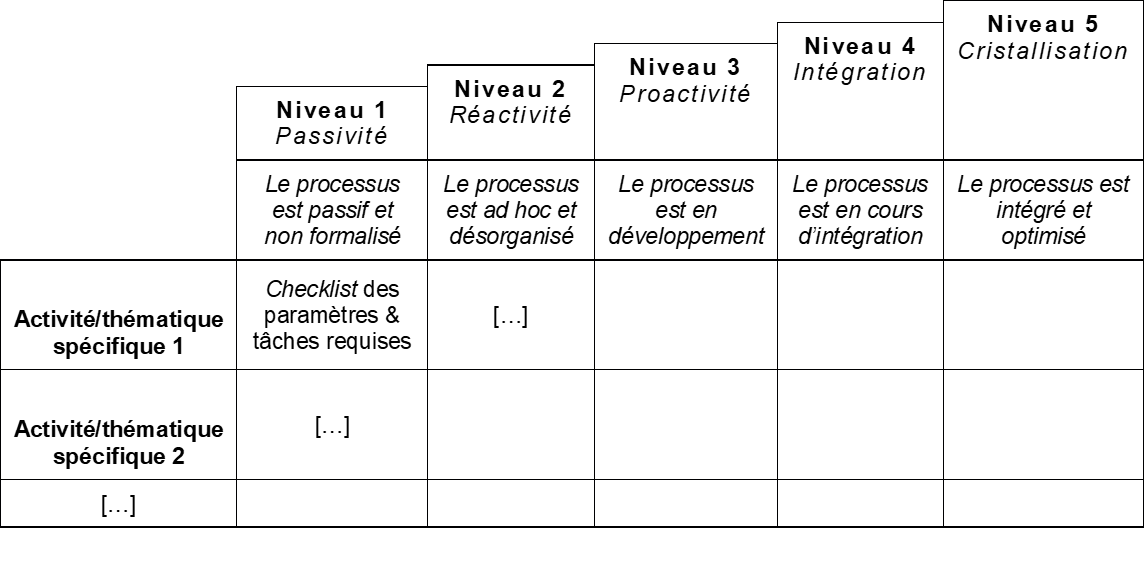

Mise en place d’un modèle de maturité du processus et d’un tableau de bord

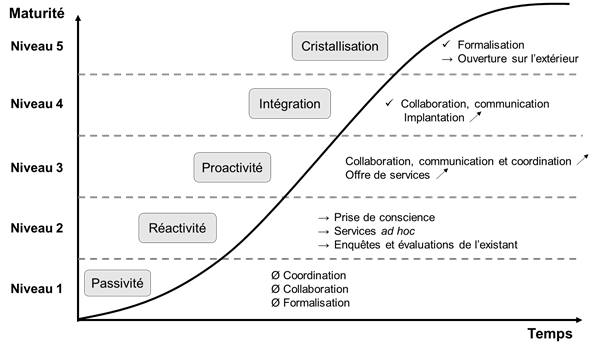

En matière de gestion des données de recherche, la littérature propose à plusieurs reprises d’aborder cette thématique sous l’angle d’un modèle de maturité. L’avantage d’un tel dispositif est qu’il permet de détailler la qualité et l’avancée du processus de manière visuelle. Chaque niveau peut donc être exprimé en objectifs stratégiques à atteindre.

Le but de la recherche n’était pas la création d’un tel dispositif. Toutefois, les résultats ont mis en lumière une maturité encore insuffisante au sein de la HETS-GE pour la mise en place d’un centre de soutien à la recherche institutionnel ou commun au domaine Travail social. L’utilisation d’un modèle de maturité semblait ainsi toute indiquée, car elle permettrait à l’institution de se développer et d’atteindre la maturité nécessaire à une telle entreprise. Une brève revue de la littérature a été menée afin de s’inspirer et de développer le prototype ci-dessous. Celui-ci a suivi le style graphique d’une figure proposée par Cox et al. dans un article de 2017 et a été alimenté par 2 modèles centrés sur la gestion des données de recherche, celui de Cox et al. (2017) et du Australian national data service (2018), ainsi que par le constat précédemment formulé sur les trois piliers de la recherche.

Figure 4: Modèle de maturité pour le soutien à la recherche

(Wuillemin 2018, p.59)

Niveau 1

Ce niveau de maturité est le plus bas et il se caractérise par une certaine passivité institutionnelle en ce qui concerne le processus de soutien à la recherche dans sa globalité. Pour en revenir aux trois piliers, la collaboration et la coordination sont pour ainsi dire inexistantes. Les chercheurs trouvent des solutions par leurs propres moyens.

Niveau 2

À ce palier, les divers acteurs commencent à prendre conscience de leurs compétences et les besoins de leurs bénéficiaires ainsi que de l’importance du processus de soutien et des activités qu’il implique. Ces changements sont une réaction aux évolutions de l’environnement (comme la gestion des données de recherche, l’open access etc.), mais sont aussi motivés par la lecture d’articles ou de retours d’expériences. Les activités sont principalement ad hoc et peu ordonnées. La qualification de ce niveau est celle de phase réactive : l’institution ne prend pas encore des décisions par elle-même, mais met en place des services à usage unique sur la demande des chercheurs. Cette phase coïncide également avec la conduite d’enquêtes et d’évaluation de l’existant afin de dresser un portrait des compétences et des ressources exploitables.

Niveau 3

Arrivés à cette étape, les efforts de soutien deviennent proactifs. Le processus fait désormais partie intégrante du plan stratégique de l’établissement. Les efforts deviennent plus systématiques : les prestations ne sont plus ad-hoc mais s’adressent à des profils divers et le rôle de chacun des prestataires est défini précisément. Les parties prenantes communiquent plus efficacement sur leurs prestations et entre elles. L’offre de services commence donc à s’étoffer. Des politiques, des marches à suivre et des règlements sont en production afin de formaliser les activités et d’unifier les pratiques.

Niveau 4

Ce niveau est placé sous le signe de l’intégration. Les politiques susmentionnées sont disséminées et s’intègrent progressivement à l’ADN de l’institution. L'offre de service est conséquente et s’optimise. Du côté des trois piliers, la collaboration est satisfaisante et la coordination et la communication sont optimales.

Niveau 5

Le point culminant du modèle est atteint lorsque l’ensemble des activités associées au processus sont implantées et formalisées de sorte qu’elles fassent pleinement partie de la culture institutionnelle et stratégique de l’entité concernée. Tout le monde travaille de concert et les efforts sont ajustés aux besoins et rationalisés. L’institution peut maintenant s’ouvrir vers l’extérieur et chercher à créer des partenariats ou des services mutualisés avec d’autres institutions. Dans le contexte HES-SO, ces alliances peuvent se faire avec d’autres écoles de travail social ou avec un ou des services à l’échelle de la HES-SO.

La faiblesse du présent modèle de maturité est qu’il représente le processus comme une activité unique. Or, la revue de la littérature couplée aux rencontres sur le terrain a montré qu’une pléthore d’activités est concernée par la facilitation de la recherche et que chacune d’entre elles peut se décomposer en sous-activités.

Ainsi le modèle de maturité devrait surtout jouer le rôle d’un “pense-bête” ou d’une feuille de route pour orienter globalement les efforts stratégiques.

En revanche, il est nécessaire pour les aspects opérationnels de compléter le prototype par un tableau de bord. Celui-ci devrait directement découler des différentes phases du modèle de maturité (ici cinq), et détailler les différentes activités par étape. On peut éventuellement décliner et séparer le tableau de bord par domaines d’activité (par exemple gestion des données de la recherche, publication des articles scientifiques, stimulation de la communauté de recherche, etc.). Pour chacune de ces activités il est nécessaire de lister les prérequis du palier et les tâches et les paramètres qui doivent être mis en place pour valider l’obtention du niveau de maturité.

Figure 5: Exemple de tableau de bord de suivi de la maturité du soutien à la recherche

(Wuillemin 2018, p.60 – adapté du Australian Data Service 2018, p.3-4)

Cet outil conserve non seulement la force visuelle du modèle de maturité, mais possède aussi une réelle plus-value opérationnelle. Ces deux outils de pilotage, il va sans dire, doivent impérativement être développés par toutes les parties prenantes mobilisées. C‘est pourquoi l’une des recommandations émises lors de ce travail est de charger l’organe de coordination du soutien institutionnel à la recherche de cette responsabilité.

Développer la compréhension des exigences de l’environnement de recherche

La revue de littérature ainsi que les actualités récentes ont mis en exergue l’importance et le poids des nouvelles exigences de l’environnement de la recherche. À l’ère numérique, dans un contexte où la production de données croît de manière exponentielle, et à la lumière de célèbres cas de falsification de résultats de recherche (voir notes (2) et (3)) qui ont parfois des retombées négatives mais surtout durables dans l’esprit collectif, il est crucial pour toutes les parties prenantes de prendre les nouvelles exigences à bras le corps et de se les approprier en les intégrant à terme dans leurs propres politiques et règlements internes. En effet, même si les changements réglementaires ont principalement été ressentis par les bénéficiaires des institutions de financement de la science, ces changements sont les symptômes d’une transformation générale et profonde dans la manière de mener la recherche scientifique. Le contrôle et la transparence autour de la recherche sont donc des enjeux phares et les exigences vont dans ce sens.

Dès lors, les services de soutien à la recherche ont la responsabilité de répandre les connaissances autour de ce nouveau paradigme au sein de la communauté de recherche afin de l’accompagner activement dans cette période de transformation. L’enjeu est de lui donner les ressources ainsi que le soutien nécessaires pour que cette transition se fasse en douceur et non sous la contrainte ou la peur d’une perte de financement de tiers.

Dans le contexte des institutions d’enseignement tertiaire, il existe généralement des unités et des services institutionnels spécialisés sur les différentes thématiques touchées par ces changements. Au sein de la HES-SO, on citera notamment l’unité Ra&D, et le Research Data Coordination Desk. En l’absence de telles unités ou à titre complémentaire, on peut également faire appel à des experts extérieurs comme ceux du projet DLCM, groupe spécialisé sur le cycle de vie des données de la recherche.

Visibilité des services et de leurs prestations

Travailler sur la visibilité des services et de leurs prestations est également un point crucial pour l’accroissement des trois piliers du soutien à la recherche. La littérature soulignait la présence de silos institutionnels qui pouvaient freiner la mise en place de services, et l’accroissement de la maturité du processus, mais parfois les services déjà existants sont eux-mêmes méconnus, voire inutilisés. Les chercheurs rencontrés dans le cadre de l’étude avaient des besoins auxquels des prestations préexistantes auraient pu répondre, mais dont ils ignoraient l’existence. Cette non-utilisation implique que les besoins des chercheurs ne sont pas satisfaits et que les services dédient des ressources à entretenir des prestations qui ne sont pas utilisées. Tout le monde est ainsi perdant.

Il est donc nécessaire, avant d’accroître l’offre, de mettre en place des solutions pour renforcer la visibilité de l’existant. Pour cela, il n’est pas forcément nécessaire de réinvestir des ressources particulières ; on peut bien développer des choses que l’on a déjà sans avoir à faire appel à des compétences nouvelles. Une chose aisée à mettre en place est une page dédiée au support à la recherche sur le site institutionnel. Celle-ci devrait regrouper les règlements et politiques institutionnels, mais aussi la liste des prestations dispensées par chaque service, ainsi que des liens renvoyant vers leurs pages. Les pages web des services devraient aussi mettre en exergue leurs offres de prestations. Des renvois vers des ressources externes comme le fameux Research Data Coordination Desk et l’unité Ra&D seraient également judicieux.

Cette centralisation de toutes les ressources à disposition faciliterait la vie aux chercheurs et augmenterait leur connaissance des prestations offertes et, on peut l’espérer, l’utilisation de celles-ci.

Encourager l’entraide et participer à l’épanouissement de la communauté de recherche

Bien que la communauté de recherche soit au centre de toutes les préoccupations, il peut arriver que les parties prenantes oublient que des actions peuvent également être entreprises pour la stimuler. C’est pourquoi, il est important de connaître son « état de santé » et la façon dont les relations interpersonnelles s’y cartographient. L’hétérogénéité de la communauté de recherche, soulevée dans la revue de littérature, a par ailleurs été vérifiée par les données recueillies sur le terrain. Les niveaux d’expérience et les domaines d’intérêt sont variés et un manque de cohésion a malheureusement été rapporté. Certains des chercheurs nouvellement engagés et qui n’ont pas une grande expérience de recherche se sentent parfois isolés, ou du moins pas très intégrés. La principale raison est que les informations ont de la peine à circuler, notamment concernant les projets sur lesquels les chercheurs travaillent. La diffusion ou la mise en place d’une base de données des projets en cours et passés accessible aux chercheurs, mais aussi au personnel administratif et technique (PAT), permettrait la propagation de ces informations cruciales pour créer des liens entre les chercheurs. Par exemple, un nouveau chercheur pourrait prendre contact avec un chercheur expérimenté travaillant sur une thématique voisine afin de discuter de sa méthodologie ou de demander des contacts. Cette proposition serait également bénéfique pour les relations entre les chercheurs et les membres du soutien à la recherche. En effet, les services de soutien seront ainsi au courant du quotidien des chercheurs et des nouveautés liées à leurs recherches et pourront effectuer des tâches comme de la veille informationnelle, technologique et réglementaire sur les sujets étudiés.

Conclusion

Cet article a fait état de l’écosystème de la recherche et des difficultés rencontrées par les services institutionnels pour soutenir les activités des chercheurs. Le milieu de la recherche a subi des évolutions majeures telles qu’un changement de paradigme – toujours en cours –vers un fonctionnement placé sous le signe de la collaboration, de la promotion de l’open access, du durcissement des exigences des bailleurs de fonds, mais aussi d’une réduction significative des budgets. On a rappelé ensuite l’importance de s’appuyer sur les services institutionnels et sur leur capacité à épauler les chercheurs dans leur travail grâce à des outils et compétences adaptés. Les données présentées dans cet article convergent vers une demande croissante de création et d’utilisation de ce genre de services.

En effet, du fait du foisonnement des activités de recherche, de l’hyper compétitivité et des activités d’enseignement, les chercheurs sont débordés. Les nouveaux aspects de la recherche scientifique, comme la gestion des données de recherche et la diffusion en open access des résultats, sont des soucis supplémentaires qu’il leur revient de gérer alors que le temps et les compétences leur manquent. Or, la littérature et les résultats de la recherche démontrent que les services institutionnels cherchent à prêter main-forte aux chercheurs pour les soulager là où il est possible de le faire. Néanmoins la communication peine bien souvent à aboutir. Cette volonté reste ainsi votive et les chercheurs se démènent en silence.

Les données montrent que la HETS-GE traverse les changements identifiés dans la littérature : les chercheurs HETS sont aussi en contact avec les transformations de l’environnement. Même s’ils ne subissent pas tous les contraintes des bailleurs de fonds, ils reconnaissent les enjeux portés par ces thématiques et la responsabilité de les endosser. Du côté des services, une volonté existe d’être plus proactif dans le soutien et de s’aligner sur les tendances. Mais la bonne volonté ne suffit pas ; il manque encore un maillon pour connecter les prestataires et les bénéficiaires. Il est donc primordial de le créer afin de suivre le paradigme de la recherche et donc de travailler ensemble. Le soutien et la facilitation de la recherche devraient se développer autour de deux pôles : les évolutions des exigences de l’environnement de recherche et les besoins de la communauté de recherche – qui du reste sont intimement liées aux premières.

Suivant ce constat, des pistes de réflexion et des recommandations ont pu être formulées pour surmonter les difficultés constatées et encourager l’épanouissement du soutien institutionnel à la recherche au sein de la HETS de Genève. Un premier constat général est que le soutien à la recherche doit s’efforcer de trouver un équilibre entre trois piliers : la communication, la collaboration et la coordination entre toutes les parties prenantes concernées et mobilisées. Ainsi, la première recommandation pour l’institution mandante est de mettre en place un organe de coordination institutionnel du soutien à la recherche composé d’au moins un représentant de toutes les parties prenantes concernées. Cet organe est incité à se charger d’élaborer un modèle de maturité du processus ainsi qu’un tableau de bord pour en suivre les évolutions et mesurer les progrès. L’avantage de ces deux outils est d’aider à la fois à la planification stratégique de la maturation des activités ainsi qu’à la mise en place des aspects opérationnels et des tâches nécessaires pour y parvenir – le tout en tirant parti de leur force intrinsèquement visuelle.

En parallèlement à ces efforts, il est aussi important de développer la compréhension des chercheurs et des entités qui les soutiennent au sujet des exigences de l’environnement de la recherche. Il s’agit là de comprendre autant les thématiques émergentes que les nouvelles exigences des bailleurs de fonds. La visibilité des services institutionnels et leurs prestations est également un point qui mérite un investissement particulier. Finalement, il est crucial de favoriser un environnement fécond et encourageant l’entraide mutuelle pour que la communauté de recherche puisse s’épanouir au mieux.

L’étude dont le présent article fait la synthèse se voulait être comparative. Or, faute de répondants, elle s’apparente davantage à une étude de cas. C’est pourquoi il serait intéressant d’explorer les divers éléments soulevés par sa méthodologie au sein des trois autres écoles du domaine. Cela permettrait de déterminer si la situation à Genève est un cas isolé ou si elle est commune au reste des institutions de formation et de recherche en travail social, et tout particulièrement de détecter un intérêt potentiel pour la mutualisation de services de soutien.

Plus globalement encore, il est intéressant de constater que les enjeux de soutien à la recherche – pourtant objet des réflexions de la littérature spécialisée depuis plusieurs années déjà – continuent à animer les débats entre professionnels et à faire couler de l’encre, sans pour autant qu’une solution ou une réponse finale ne s’impose. Plus qu’un tournant appuyé par l’évolution du paradigme de la science ou par les pressions financières, les interrogations mises en lumière par le soutien à la recherche dénotent un profond et irrémédiable changement de société vis-à-vis de l’utilisation des médias, de la relation aux données et à la vie privée, ainsi que des exigences de transparence, notamment à propos des investissements de l’argent du contribuable dans le financement de la recherche. Tous ces enjeux n’épargnent pas les métiers de l’information documentaire, qui vont devoir tôt ou tard se positionner sur la nécessité de s’approprier des compétences traditionnellement rattachées à d’autres corps de métiers, avec le risque de remettre en question des savoir-faire historiques ou leur identité même.

Notes

[*] Veuillez noter que cet article reflète uniquement l’opinion de son autrice et n’engage nullement la Haute école de travail social de Genève ou toute autre entité mentionnée.

[**] L’italique dans le texte ne sert qu’à signaler les mots issus de langues étrangères.

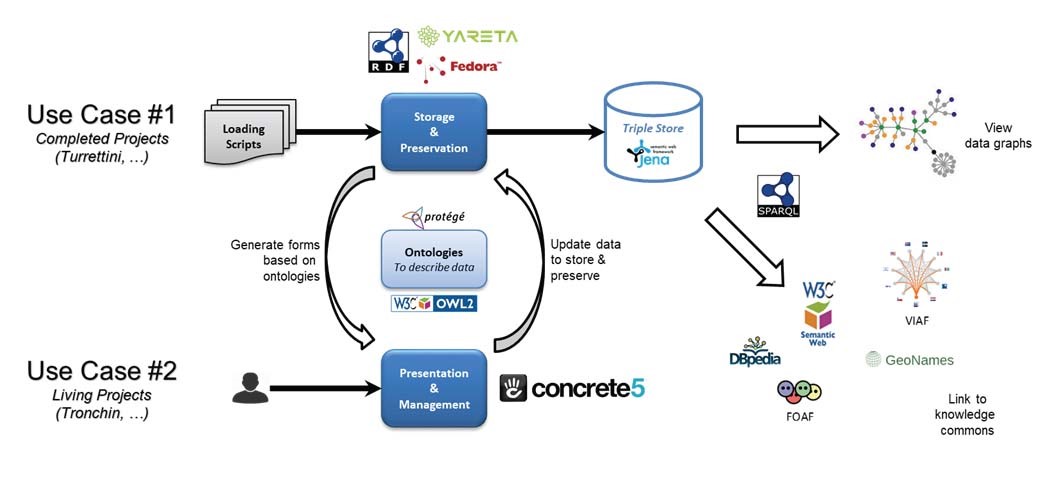

(1) Davantage d’informations sur la politique d’open access du FNS sont disponibles à l’adresse:http://www.snf.ch/fr/leFNS/points-de-vue-politique-de-recherche/open-access/Pages/default.aspx