N°18 décembre 2017

Sommaire - N° 18, Décembre 2017

Comptes-rendus d'expériences :

-

eLectures : la lecture numérique grand public à la BCUL - Laurent Albenque, Charlotte de Beffort, Christophe Bezençon et Françoise Simonet

-

Livres et presse numériques en bibliothèque de lecture publique : état de lieux de l’expérience menée par les bibliothèques de Carouge - Yves Martina

-

Le Montreux Jazz digital project - Alain Dufaux et Thierry Amsallem

-

Service de gestion des données de recherche à la Bibliothèque de l’EPFL : historique, services et perspectives - Eliane Blumer et Jan Krause

-

Les archives démocratiques - Andreas Kellerhals

-

Un container mobile pour le sauvetage de collections sinistrées : la BERCE PBC Ville de Genève - Nelly Cauliez

-

Interopérabilité des images : de la nécessité des tests d’utilisabilité - Julien Raemy

Comptes-rendus d'événements :

-

Retour sur la conférence IIIF (International Image Interoperability Framework), 7-9 juin 2017 au Vatican - Julien Raemy

-

Les fondements de Bibliosuisse : état des discussions - Halo Locher et Katia Röthlin

-

« Marketing et public » ou comment repenser l’approche des bibliothèques sur l’accueil de leur public - Elise Pelletier

Recensions :

-

Du bon usage des Lumières : le livre numérique libre - Alain Jacquesson

Editorial

Comité RESSI

Editorial n°18

Nous avons le plaisir de vous proposer le 18ème numéro de RESSI, revue électronique suisse en science de l’information qui paraît une fois par an.

Lecture numérique, valorisation innovante d’archives audiovisuelles, gestion des données de la recherche, utilisabilité, démocratisation des archives, protection des biens culturels : ce sont quelques-uns des thèmes abordés dans ce numéro, riche en retours d’expériences, dus autant à des jeunes chercheurs qu’à des praticiens, juniors et seniors.

Sous la rubrique « Compte rendu d’expérience », sept contributions.

La première, intitulée eLectures : la lecture numérique grand public à la BCUL, est signée par quatre collaborateurs du site de la Riponne de la Bibliothèque cantonale et universitaire de Lausanne, à savoir Laurent Albenque, directeur adjoint, Charlotte de Beffort, responsable du prêt, Christophe Bezençon, responsable des collections, et Françoise Simonet, responsable des renseignements et de l’accueil. Il s’agit d’un retour d’expérience approfondi sur l’exploitation de la plateforme eLecture à la BCUL depuis 2 ans. Il décrit l’origine du projet, la mise en œuvre, les solutions choisies, l’offre et sa communication, et propose un bilan de son utilisation ainsi que des développements possibles.

Toujours sur la lecture numérique, la deuxième contribution, Livres et presse numériques en bibliothèque de lecture publique : état des lieux de l’expérience menée par les bibliothèques de Carouge, sous la plume d’Yves Martina, directeur des bibliothèques de Carouge, décrit également le contexte et le bilan intermédiaire d’une offre en presse et livres numériques dans un contexte de bibliothèques municipales.

La troisième contribution émane conjointement d’Alain Dufaux, directeur des opérations et du développement au centre Metamedia, à l’EPFL et de Thierry Amsallem, président de la Fondation Claude Nobs. Intitulée Le Montreux Jazz Digital Project : la sauvegarde des archives audiovisuelles du Montreux Jazz Festival, un patrimoine pour l’innovation et la recherche, l’article décrit les différentes activités du projet de sauvegarde, à savoir la numérisation des archives, la gestion de l’archivage et surtout, l’identification et le suivi de -nombreux- projets de recherche et d’innovation associés aux archives du festival de jazz, puis donne quelques perspectives pour l’avenir.

La quatrième contribution est aussi signée par des collaborateurs de l’EPFL, mais de la bibliothèque, cette fois. Rédigée par Eliane Blumer, coordinatrice des données de recherche, bibliothécaire de liaison pour les sciences de la vie, et par Jan Krause, data librarian, l’article Le service de gestion des données de la recherche à la bibliothèque de l’EPFL : historique, services proposés, perspectives décrit l’origine du service, son fonctionnement, son mode d’organisation et donne des exemples précis de ses services de soutien et de formation.

La cinquième contribution, intitulée Archives démocratiques et signée Andreas Kellerhals, directeur des Archives fédérales suisses, est une réflexion originale sur les conditions d’une plus grande participation des citoyens à la constitution des archives (sélection, sauvegarde et description) et à leur accessibilité.

La sixième contribution est due à Nelly Cauliez, conservatrice responsable de l’Unité Régie de la Bibliothèque de Genève. Intitulée Un container mobile pour la sauvegarde des collections sinistrées : la BERCE PBC Ville de Genève, elle décrit le contexte d’acquisition, les caractéristiques et le fonctionnement de ce dispositif essentiel à la protection des biens culturels que constitue la BERCE.

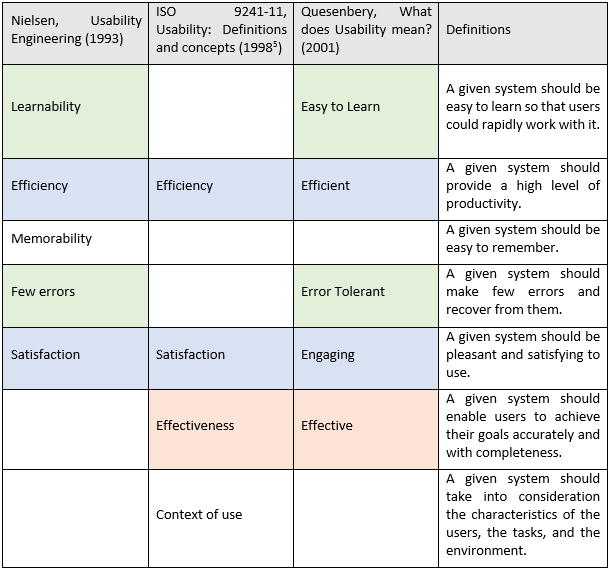

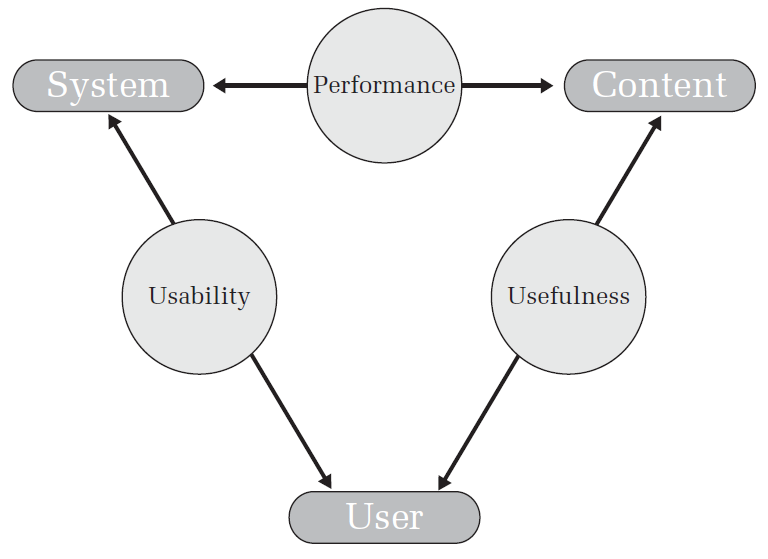

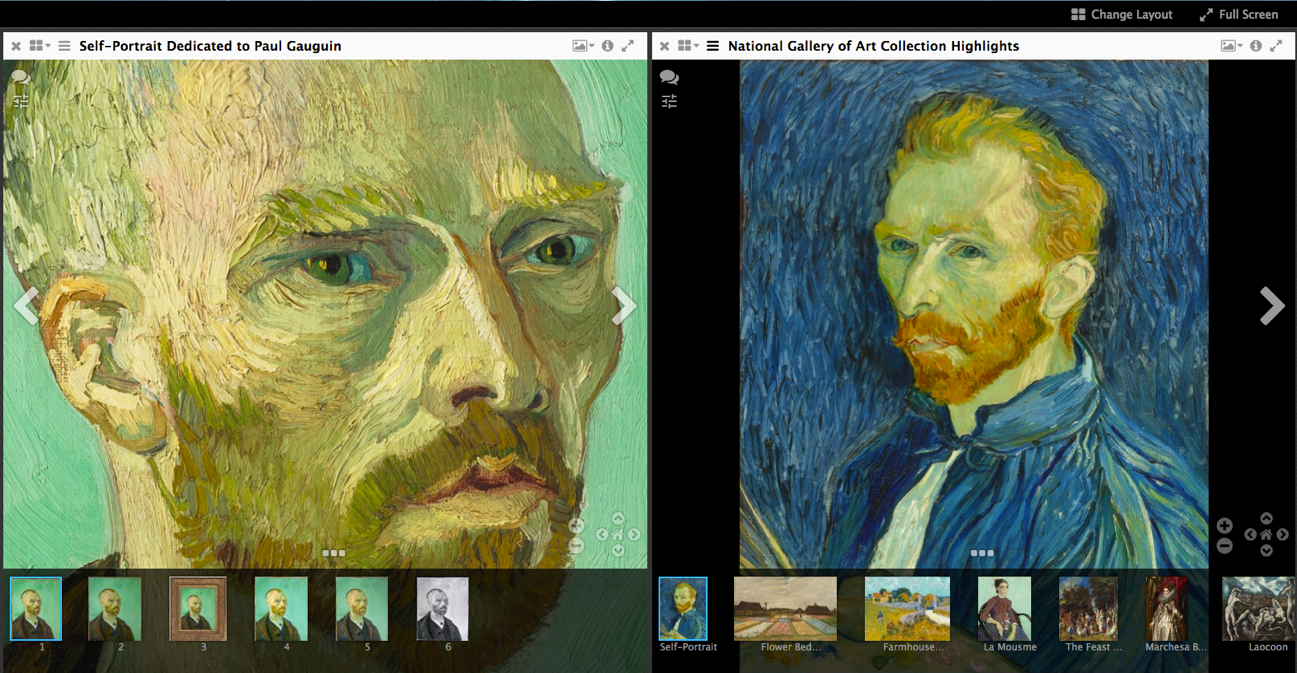

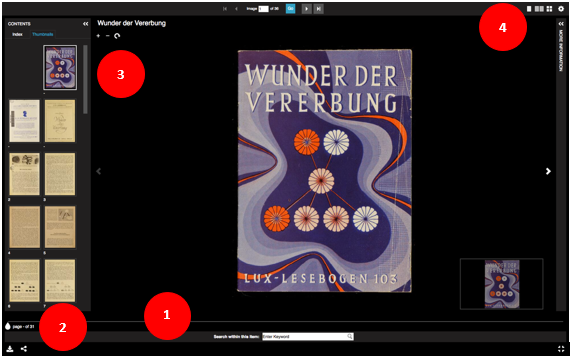

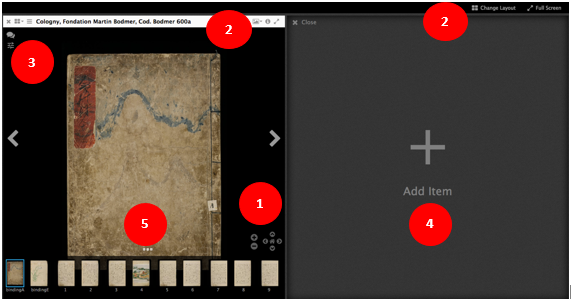

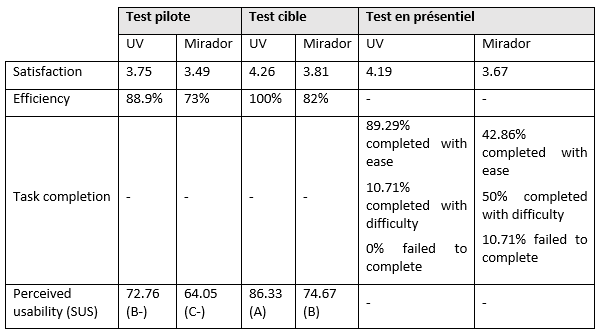

La septième compte rendu d’expérience constitue la synthèse d’un travail de bachelor. Signé Julien Raemy, assistant HES à la HEG-Genève, intitulé Interopérabilité des images : de la nécessité des tests d’utilisabilité, l’article présente les initiatives existantes en termes d’interopérabilité des systèmes de diffusion d’images,-la communauté IIIF et le projet NIE-INE- et détaille les résultats de tests d’utilisabilité de deux systèmes de visionnement d’images, Universal Viewer et Mirador.

Pour la rubrique Compte rendu d’événement, on trouvera trois contributions.

La première, dans la lignée du dernier retour d’expérience, toujours signée par Julien Raemy, intitulée Retour sur la conférence IIIF (International Image Interoperability Framework), 7-9 juin 2017 au Vatican décrit le déroulement de la conférence IIIF, qui a été l’occasion d’échanges entre participants sur la visualisation, la comparaison, la manipulation et l'annotation d'images.

La deuxième est un compte rendu de la conférence Bibliosuisse qui s’est tenue à Bienne le 3 novembre 2017, et qui a réuni plus de 100 personnes membres des associations CLP et BIS, visant à réfléchir aux conditions d’une fusion des deux associations représentatives de la bibliothéconomie et de la documentation en Suisse. Si cette fusion aboutit à une seule association, en 2018, la nouvelle association ainsi créée, Bibliosuisse, deviendra un porte-parole majeur de la fonction documentaire en Suisse. Signée Halo Locher, secrétaire général BIS et CLP, et Katia Röthlin, secrétaire générale adjointe BIS et CLP, intitulée Les fondements de Bibliosuisse : état des discussions elle explicite les grands principes qui devraient gouverner la future association.

La troisième est un retour sur la 4ème école d’été internationale francophone en sciences de l’information et des bibliothèques qui s’est tenue à Montréal en juillet 2017. Intitulée Marketing et public, ou comment repenser l’approche bibliothèques sur l’accueil de leur public et signée par Elise Pelletier, assistante du Master IS (Sciences de l’information) de la HEG-Genève, l’article détaille, aussi bien sur le fond que sur la forme, les différentes interventions sur le nécessaire marketing en bibliothèque, qui ont eu lieu durant la première semaine de cours de l’école d’été.

Finalement, on trouvera le compte rendu de l’ouvrage de Jean-David Sandoz, intitulé Du bon usage des Lumières : le livre numérique libre, sous la plume d’Alain Jacquesson, ancien directeur de la Bibliothèque de Genève, qui résume cet ouvrage, lequel recense les différents outils et formats existants pour la publication de livres électroniques libres.

Nous vous souhaitons une très bonne lecture et remercions vivement les auteurs de cette édition, ainsi que les fidèles réviseurs et ceux et celles qui ont contribué à la mise en ligne de RESSI. Nous vous encourageons à nous soumettre des propositions d’article à tout moment, et à contribuer à faire connaître RESSI à toute personne intéressée.

Le Comité de rédaction

eLectures : la lecture numérique grand public à la BCUL

Laurent Albenque, directeur adjoint

Charlotte de Beffort, responsable du service du prêt

Christophe Bezençon, responsable du service des collections

Françoise Simonet, responsable des renseignements et formation des usagers

Bibliothèque cantonale et universitaire de Lausanne, site Riponne, Pl. de la Riponne 6, 1014 Lausanne

eLectures : la lecture numérique grand public à la BCUL

Introduction : l’offre numérique à la BCUL

C’est tomber dans les poncifs que de dire que le numérique occupe de plus en plus de place dans l’offre documentaire d’une bibliothèque telle que la Bibliothèque cantonale et universitaire de Lausanne (BCU Lausanne ou BCUL pour la suite de cet article). Les ressources numériques représentaient, en 2016, 60% de ses dépenses d’acquisitions.

Mais c’est aussi un peu simplificateur de s’arrêter à ce chiffre-là. En effet, l’offre numérique est très majoritairement destinée à la communauté universitaire : 98% des dépenses pour ce type de collections ont été faites pour ce public particulier. Cette disproportion est le résultat de deux phénomènes dont on ne sait pas vraiment s’ils sont, ou non, dépendants l’un de l’autre : l’offre et les conditions d’accès à cette offre d’une part, la manière de « consommer » l’information de l’autre.

Concernant l’offre, la documentation numérique vulgarisée ou grand public francophone reste relativement anecdotique et essentiellement destinée à une vente directe auprès des particuliers [1]. L’offre numérique pour les usagers de bibliothèques est non seulement limitée mais souvent restreinte au territoire français. Cela ne nous empêche pas de fournir l’accès à plus d’une vingtaine de ressources numériques conçues pour le grand public. Le second barrage entre les usagers et ces collections sont les conditions d’accès. Souvent liées à une adresse IP, elles ne peuvent être consultées que sur site physique par le wifi ou par les postes fixes mis à disposition. A ce stade, tous les avantages liés à la mobilité et à la légèreté du numérique s’effondrent. En effet, malgré leur dématérialisation, les documents numériques nécessitent une présence sur place… comme pour les « bons vieux ouvrages de référence poussiéreux ». A ce jour, pour le grand public, nous ne pouvons offrir d’accès à distance que pour notre offre eLectures, objet de cet article, et à Vodeclic, plateforme d’auto-formation informatique. A noter que, grâce au VPN ou aux divers systèmes d’identification qui lui sont destinés, la communauté académique peut accéder à toutes les ressources numériques depuis n’importe quelle connexion internet.

Si on parle de la manière de consommer l’information, il est évident que les pratiques académiques se tournent vers le numérique pour échanger des informations, des données de recherche et leurs résultats, c’est une consommation dans un cadre professionnel qui se veut aussi efficace que possible. Pour la documentation ou la littérature « de loisirs », on remarque que même si les usagers en Suisse semblent largement équipés en terminaux mobiles [2], l’usage de ces derniers ne prend pas le dessus sur les livres papiers (c’est évidemment différent pour la musique, les films et, dans une certaine mesure, pour la presse). Ce n’est en tout cas pas une attente forte de la part de nos usagers. Il y a donc un travail important à réaliser pour faire connaître une offre et donner la possibilité d’un accès facile et intuitif. En clair, le lecteur « grand public » ne va pas se ruer sur cette offre, il va falloir la lui apporter et lui en démontrer les avantages.

Etude sur l’utilisation actuelle et les attentes vis-à-vis de l’offre numérique de la BCUL

Constatant la richesse de l’offre numérique universitaire, la BCUL a fait le choix de proposer de la lecture numérique à distance à l’intention du grand public vaudois. Ce choix s’inscrit dans la suite d’une enquête que le site Riponne de la BCUL avait menée en 2012 auprès de ses usagers et les attentes de ceux-ci relativement à l’offre numérique en bibliothèque.

Deux approches méthodologiques complémentaires avaient alors été mises en place : une enquête en ligne auprès des usagers actifs du site de la Riponne, lancée début septembre 2012, qui a reçu de très bons échos, le taux de participation s’étant élevé à 24%, suivie de 16 entretiens individuels en face-à-face organisés en octobre et novembre.

Les résultats de l’enquête ont montré que :

- 85% des usagers possédaient un ordinateur portable, 57% un ordinateur de bureau, 47% un Smartphone, 17% une tablette et 7% une liseuse. En cela, ils rejoignaient le taux d’équipement constaté en Suisse (voir plus haut).

- La plupart des usagers étaient curieux et ouverts à l'idée du numérique tout en restant encore très attachés à la version papier. L'offre numérique était vue comme importante avant tout en tant que complément de l'offre papier.

- Les ressources numériques étaient perçues comme difficiles à repérer dans l'offre de la BCUL et leur utilisation difficile. Le souhait des répondants était de pouvoir accéder à des personnes de référence pour les renseigner et les aider.

- L'accès à distance et le téléchargement étaient des conditions indispensables pour une utilisation fréquente et régulière d’une future offre numérique BCUL.

Mise en œuvre du projet

Exploration des solutions existantes

Suite à l’enquête de 2012 sur les ressources numériques grand public, un groupe de travail interne a établi un catalogue de propositions de suites à donner, avec une vingtaine d’actions réparties selon quatre axes : communiquer et accroître la visibilité, accompagner les usagers et les former, améliorer l’accès et réfléchir au développement de l’offre numérique.

C’est ce dernier point qui nous a conduit à étudier l’offre numérique consacrée à l’actualité littéraire.

Le choix – nous étions en 2013, rappelons-le – s’est porté assez rapidement sur la société française Numilog, un des seuls acteurs sur le marché francophone à l’époque proposant une collection numérique ET accessible à distance dans le segment principal qui nous intéressait.

Considérant l’expérience concluante de la Médiathèque Valais avec Numilog, nous avons fait part de notre intérêt à cette société du groupe Hachette. Suite au test de la ressource organisé durant le mois d’octobre 2013, nous avons conclu qu’il serait intéressant de travailler avec Numilog, au moins à titre transitoire. En effet, bien que le catalogue proposé n’ait pas été à la hauteur de nos attentes (principalement en termes d’étendue de l’offre), ni la plateforme suffisamment intuitive à notre appréciation, l’absence d’alternative francophone faisait alors de Numilog un fournisseur quasi-incontournable. Le dossier n’a finalement pas abouti, Numilog nous ayant annoncé début 2014 que, pour des raisons de « géoterritorialité », les éditeurs ne seraient plus en capacité de desservir la Suisse.

Nous avons ensuite cherché à identifier un partenaire commercial suisse romand. Lors d’une rencontre en janvier 2014, nos interlocuteurs de la librairie Payot se sont dits sensibles à notre souhait de travailler avec eux dans le domaine du livre électronique, sans toutefois être en mesure de nous faire une proposition.

Les recherches se sont alors tournées vers une plate-forme québécoise lancée en mars 2012, « pretnumerique.ca ». Une phase de test avait débuté dans plusieurs établissements de lecture publique en France avec le projet français Prêt Numérique en Bibliothèque (PNB). Ce projet apportait le double avantage d’un catalogue plus large avec une importante marge d’accroissement, particulièrement en langue étrangère ; et d’un accès public via une plateforme éprouvée (identique à pretnumerique.ca).

Nous avons donc finalement approché la société Feedbooks, Hadrien Gardeur, son directeur, nous ayant annoncé fin avril 2014 l’ouverture à la Suisse des catalogues d’éditeurs impliqués dans PNB, et un test a été lancé le 23 juillet 2014.

Choix et description de la solution Cantook-PNB-Feedbooks

Avant d’aborder la période de tests et d’implémentation à la BCU Lausanne, revenons quelques instants sur la formule choisie : PNB [3].

Le projet français PNB repose sur le hub de la société Dilicom, par lequel éditeurs, distributeurs, libraires et clients finaux (comme les bibliothèques) sont mis en relation. Ce projet, lancé en 2014, est coordonné par le ministère de la culture français. Pour ce projet, trois acteurs ont été choisis (au niveau national) :

- Libraire (Feedbooks dans notre cas). Feedbooks possède deux offres distinctes en fonction du public (une offre plus fournie pour les particuliers que pour les bibliothèques)

- Interface usager (Cantook de la société De Marque dans notre cas). Mise à disposition de l’interface usager permettant :

- Le prêt de livres numériques par les lecteurs eux-mêmes,

- La gestion des prêts et la mise en valeur des collections par les professionnels de la BCU Lausanne.

- Tiers de confiance (Dilicom). Il constitue une garantie pour tous les acteurs : les bibliothèques et les distributeurs doivent avoir un correspondant qui atteste de la situation de leurs achats et de leurs prêts. C’est chez Dilicom que les libraires passent leurs achats, leurs lignes comptables avec les distributeurs et toutes les écritures nécessaires à la bonne fin d’une transaction. Au travers de Dilicom ne circule donc que de l’information. Dilicom comptabilise les achats de livres électroniques et les demandes de prêts.

Le processus est donc le suivant : Feedbooks transmet ses fichiers, les métadonnées associées, à Cantook. Cantook les met à disposition sur sa plateforme pour les rendre accessibles au public et permet le prêt. Les demandes de prêt sont ensuite transmises à Dilicom.

A ce stade, il est important de noter que la bibliothèque n’est jamais dépositaire des fichiers. Ceux-ci transitent directement du distributeur au lecteur. La bibliothèque ne possède pas, même temporairement les livres électroniques, elle ne possède que les métadonnées des titres et des licences qui sont constituées par des droits de prêt.

Implémentation à la BCUL

Les tests ont eu lieu durant l’été 2014, tests beaucoup plus concluants que ceux effectués quelques mois auparavant sur la solution Numilog.

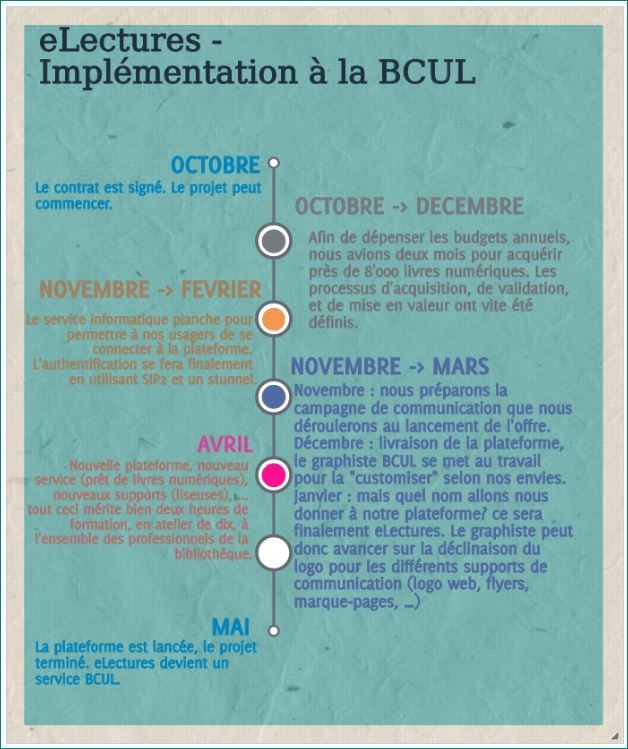

Le contrat avec Feedbooks est alors signé au mois d’octobre, pour un lancement de la plateforme en mai 2015. Ce projet a nécessité la coordination et le travail de plusieurs entités au sein de la bibliothèque : le service des finances, celui des ressources électroniques, les responsables de collections, les services informatique, communication et les services publics. En voici les principales étapes :

Graphique 1 : Calendrier d’implémentation d’eLectures à la BCU Lausanne (2014 - 2015)

L’offre documentaire

Politique des éditeurs français

Ayant forcément constaté, à partir de la fin des années 1990, les ravages d’un passage au numérique non maîtrisé par rapport au chiffre d’affaires de l’industrie musicale mondiale, les éditeurs français sont aujourd’hui moins enthousiastes que leurs homologues anglo-saxons sur le sujet. Si leur prudence peut se comprendre, elle ne fait pas toujours l’affaire des bibliothèques.

Outre la question du piratage, la crainte principale des éditeurs est toujours la même, que le prêt numérique en bibliothèque cannibalise les ventes des livres physiques qui restent au cœur de leur modèle d’affaires. Cette volonté se retrouve dans les conditions d’achat et de prêt faites aux bibliothèques.

Avant tout, il est faux de penser qu’une bibliothèque (ou un particulier) « achète » un livre numérique. Ce que nous achetons, c’est le droit d’accéder à un texte et non pas le texte lui-même. Pour un particulier, ce droit d’accès est censé être sans limite une fois l’ouvrage acheté. Mais il ne peut ni le prêter ni le donner, au contraire de ce qui se fait avec un ouvrage papier. Pour une bibliothèque, les licences sont limitées dans le temps et comportent un nombre total de prêts autorisés par ouvrage acheté : la licence expire lorsque tous les prêts ont été consommés ou, si ce n’est pas le cas, lorsqu’elle arrive au terme de la durée fixée par l’éditeur. L’autre paramètre à prendre en compte dans une décision d’achat est le prix. Contrairement au modèle anglo-saxon, où le prix du livre numérique est significativement plus bas que celui de l’édition papier, les éditeurs français maintiennent un prix du numérique plus élevé que celui de la version papier (+ 30 ou 50%).

Enfin, le gros avantage du livre numérique est la possibilité de prêter simultanément à plusieurs lecteurs le même ouvrage. Techniquement, le nombre de prêts simultanés possibles est bien entendu illimité. Dans les faits, chaque éditeur intègre une limite dans la licence. C’est un avantage proposé par les groupes français comme Madrigall, Editis, La Martinière ou encore Actes Sud. Le prêt simultané n’existe par contre pas chez les éditeurs anglo-saxons.

Outre ces deux conditions de base, de nombreuses licences sont hybrides, Les éditeurs combinent ainsi des conditions différentes en fonction des titres. Par exemple, ils proposent des licences mono-utilisateur pour les nouveautés, multi-utilisateurs pour les titres plus anciens, voire illimitées pour les titres tombés dans le domaine public.

Pour résumer, ces licences sont relativement coûteuses pour les bibliothèques et les laissent face à un double verrou : un nombre limité de prêts sur une durée elle aussi limitée. Heureusement, sous la pression des bibliothèques, certains éditeurs ont fait évoluer leurs conditions dans un sens plus favorable aux besoins. Sans entrer dans les détails, la durée de licence a souvent été allongée pour les titres de fond et le nombre de prêts totaux possibles augmenté pour les nouveautés. Par contre, en parallèle, ces améliorations se sont aussi accompagnées d’une hausse du prix de la licence ou d’une baisse du nombre de prêts simultanés possibles.

Aujourd’hui, les licences proposées ont généralement une durée de 5 à 10 ans, avec un nombre de prêts totaux entre 25 et 60. Le nombre d’emprunts simultanés varie de 5 à 15 avec des exceptions : aucun chez Albin Michel, 50 chez Izneo (groupe Dargaud). Le groupe Hachette se singularise par des conditions plus proches de celles des grands groupes mondiaux dont il fait partie : une licence et un nombre de prêts illimités qui s’accompagnent d’un prix d’achat des nouveautés équivalent à trois fois le prix de la version papier et de l’impossibilité de faire des emprunts simultanés.

Les marges de négociation des bibliothèques sont limitées, hormis le boycott d’éditeurs dont les conditions sembleraient par trop extravagantes. Mais le système fonctionne et répond à un besoin naissant du public. Se posera néanmoins, à terme, la question du poids financier à donner à ces ressources au sein des budgets d’acquisitions et de la pérennité de l’offre. Ce sont là des questions que connaissent déjà les bibliothèques universitaires.

L’offre proposée par la BCUL.

La constitution de notre catalogue a été tributaire de l’offre de notre fournisseur qui, pour les bibliothèques suisses, se limitait à moins de 20'000 titres à la fin 2014, dont plus du quart en anglais. Depuis, l’offre pour la Suisse a rejoint celle de la France et de la Belgique avec plus de 128'000 références disponibles à l’été 2017.

Plusieurs choix guident la constitution de notre catalogue. Un équilibre entre une offre francophone de fiction (53% de nos titres) et une offre documentaire (31%) qui nous permet de répondre à notre vocation de bibliothèque grand public tout autant qu’universitaire. L’inscription à la BCUL étant limitée aux plus de 14 ans, nous avons naturellement exclu les livres jeunesse de nos achats. Enfin, souhaitant nous adresser au public allophone, bien présent dans le canton de Vaud, nous avons constitué un fonds de livres en anglais (fictions et documentaires) qui représente 16% de notre catalogue.

Après une première phase où notre catalogue s’est nourri principalement de l’achat de titres de fond pour constituer la base de notre catalogue, nous avons ensuite mis l’accent sur l’achat régulier de nouveautés. Cet équilibre permet à la fois de répondre à l’appétence bien connue du public pour les nouvelles publications (tout particulièrement pour la rentrée littéraire), tout autant qu’aux demandes plus pointues de certains de nos lecteurs.

Il est évident que la constitution récente de ce catalogue numérique (avec près de 11'000 titres pour eLectures à la BCUL) ne lui permet pas, et de loin, d’atteindre la richesse d’un fonds physique anciennement constitué qui compte plusieurs millions de documents. Plusieurs enseignements peuvent néanmoins être tirés de l’usage qu’en font nos lecteurs.

Les nouveautés de littérature et les policiers s’arrogent la plupart du temps la totalité du hit-parade des prêts. Il est rare qu’un essai s’y glisse. En cela, la lecture numérique suit la même tendance que les prêts physiques. La possibilité d’emprunts simultanés accentue d’ailleurs le poids des titres les plus prêtés dans le total des transactions. A l’opposé, une analyse plus fine montre que beaucoup d’ouvrages de fond sont aussi empruntés, même si ce n’est qu’une seule fois sur deux années d’exploitation d’eLectures. C’est moins visible, à première vue, que pour un titre emprunté plusieurs dizaines de fois sur la même période mais cela contribue tout autant au succès de l’offre.

Les outils statistiques mis à disposition ne nous permettent pas d’aller plus loin sur ce point. Ils restent pour l’instant assez généralistes : nombres de prêts, d’usagers et de connexions, livres les plus empruntés, répartitions des prêts par grandes thématiques. Il nous appartiendra de travailler avec Cantook pour en améliorer la souplesse d’utilisation et surtout les adapter à nos besoins. Une lecture plus fine des usages nous permettra ainsi de mieux adapter nos achats. C’est une volonté qui est d’ailleurs partagée par tous les acteurs, utilisateurs comme fournisseurs.

La fiction représente 70% des prêts, dont 15% de romans policiers et de science-fiction. Les documentaires constituent les 30% restants. Pour ces derniers, les domaines les plus représentés sont les sciences humaines (incluant l’Histoire), les biographies et le tourisme (guides de voyage). Ces chiffres incluent les ouvrages en anglais qui s’élèvent à environ 8% des prêts. On voit donc ici l’importance des collections dans les choix de nos lecteurs, même si les nouveautés et les titres les plus prêtés sortent du lot.

Quelle place pour les éditeurs suisses ?

Dans l’absolu, en tant que bibliothèque cantonale, nous souhaiterions pouvoir proposer à nos usagers du contenu d’auteurs ou d’éditeurs suisses, romands et vaudois afin de les mettre en valeur. En réalité, nous ne pouvons qu’offrir des auteurs suisses publiés en France et dont l’éditeur offre une version numérique. Les éditeurs romands, même les plus importants, semblent encore plus frileux que les Français vis-à-vis de l’édition numérique [4] et donc, si ce pas-là n’est pas encore franchi, celui de le proposer à des bibliothèques pour le prêt n’est pas non plus en ligne de mire.

Nous avons donc pris l’option de proposer ce qui était disponible auprès de notre fournisseur et des éditeurs français avec l’espoir que notre offre prenne de l’ampleur et fasse mieux connaître la lecture numérique dans nos contrées auprès de nos éditeurs. Le temps faisant, l’espoir de voir la littérature suisse mieux représentée sur ces plateformes se réalisera peut-être. Nous aurions alors avec nous l’expérience d’avoir déjà monté ce genre d’offres et un public réceptif et adepte de ces technologies.

Nécessité de faire connaître eLectures pour la faire vivre

Formation des professionnels : un nouveau dynamisme

Lancer une telle offre, pour un public généraliste, sans accompagnement, nous semblait téméraire. Or, pour accompagner, il fallait que les professionnels, et en particulier ceux travaillant dans les services au public, soient au point sur les différentes facettes de la prestation (contenu, fonctionnement de la plateforme et du prêt numérique, connaissance des supports, etc.)

Nous avons donc organisé, dans les mois précédant le lancement de la plateforme, une formation des collaborateurs, basée principalement sur l’expérimentation personnelle.

En 2014, l’offre de livres numériques de loisirs en français était peu développée. En revanche la BCUL a été pionnière dans le test de tablettes et de liseuses, en mettant à disposition des collaborateurs du matériel pour expérimenter. Les collègues étaient donc pour la plupart en possession d’une tablette et à l’aise avec son utilisation. Notre objectif principal était que tous se créent une pratique de lecture numérique, des compétences d’utilisation courante de la plateforme et du téléchargement sur des supports mobiles. Différents ateliers ont été proposés, touchant tous les collaborateurs du site Riponne ainsi que des personnes relais des autres sites de la BCUL. Des présentations ont également été organisées et ont concerné une part importante des collaborateurs des différents sites de la BCUL.

Ces actions ont été l’occasion de mettre en avant de nouvelles compétences, et ont servi de mise à niveau pour l’ensemble du personnel.

Enjeux et constat

Les formations ont permis à tous de se familiariser avec la plateforme et les outils nécessaires à l’emprunt de livres numériques, ce qui a facilité le transfert et donné une plus grande aisance aux collègues des guichets pour renseigner les usagers sur la prestation.

Un petit groupe de bibliothécaires, volontaires, a participé dès le départ aux ateliers et au support en ligne. L’expérience de résolution des problèmes des usagers a permis un approfondissement des connaissances au sein du groupe, et créé un appui à deux niveaux : les questions simples sont gérées par tous et, pour les plus compliquées, les usagers sont redirigés d’abord en interne, puis vers le support de la plateforme en cas de besoin.

Pour être efficace, il est néanmoins indispensable de rester au courant de l’évolution des technologies, en l’occurrence les différentes applications de lecture, les modèles de liseuses, les changements à venir au niveau des DRM. Le rythme n’est pas forcément facile à suivre, surtout si l’on souhaite assurer l’assimilation des informations par tous.

Du côté des bibliothécaires, c’est un constat très majoritairement positif. Ils ont été impliqués dès le départ, et le fait d’être « au front » au guichet a encouragé les uns et les autres à s’approprier la plateforme. Plusieurs se sont pris au jeu et se sont acheté des liseuses.

Plan de communication au lancement

Le lancement de l’offre nous semblait un moment crucial. Notre souhait était de marquer le coup et de créer le « buzz ».

Il fallait bien sûr informer nos usagers de cette nouvelle prestation, mais, offre numérique oblige, et la BCUL étant une bibliothèque cantonale ouverte à tous, il semblait important d’élargir la démarche à la population vaudoise a minima. Forts de ce constat, allait-on viser un lancement « classique », avec une présentation physique dans divers lieux du canton, ou une communication plus digitale ?

En partant du principe que la promotion devait être numérique, nous avons lancé une communication hybride, avec une part digitale importante, grâce au service de communication de la BCUL et d’une agence externe. Le budget de cette campagne n’a pas dépassé les quelques milliers de francs.

De petites vidéos ont ainsi été réalisées avec le message récurrent suivant :

« Jusqu’à l’été, suivez et partagez les aventures de l’homme-bulle eLectures à travers 6 vidéos de 30’’ décalées où les circonstances sont autant d’occasions de profiter de l’offre eLectures », avec pour chacune un slogan en lien avec une spécificité de la prestation:

- eLectures - en toute légèreté ! à Le stockage important sur un support de 100 et quelques grammes

- eLectures vous suit partout à La lecture où que l’on se trouve

- eLectures, à portée de clic ! à Le téléchargement à distance

- eLectures – avec vous tout le temps ! à L’accès 24/24, 7/7

- eLectures - des livres toujours à la page ! à De nouveaux achats réguliers

- eLectures - Nouvelle offre, toujours gratuite ! à La gratuité

Les vidéos ont été diffusées à une semaine d’intervalle sur la chaîne YouTube de la BCUL[5], le site web, Twitter et Facebook.

Pour la part classique de la promotion, un logo a été créé, des signets réalisés, et des affiches placardées dans plusieurs villes du canton. Un « homme sandwich » a distribué des signets au centre-ville et à la gare de Lausanne. Plus traditionnel aussi, un stand pour les cafés numériques a été installé à l’entrée du site Riponne, afin de pouvoir présenter l’offre aux lecteurs.

Formation des lecteurs, accompagnement, renseignements

La mise en place d’une offre numérique va de pair avec un accompagnement des utilisateurs, sur place et à distance, nous en étions convaincus dès le départ.

Un dispositif de formation a donc été mis en place, comprenant :

- L’animation d’ateliers en présentiel,

- Le support en ligne, par e-mail ou téléphone,

- La mise à disposition de tutoriels et de FAQ.

Les ateliers de découverte et de prise en main :

Pendant les 6 premiers mois, une plage a été réservée tous les lundis, sur le site Riponne de la BCUL. Les ateliers sont allés de la présentation générale de la plateforme eLectures à un accompagnement pas à pas dans l'emprunt du premier livre numérique (création d'un adobe ID, réactualisation du mot de passe BCUL, installation des logiciels nécessaires…). Ces ateliers étaient également importants pour nous, à ce stade du projet, car ils nous ont permis de cibler quels étaient les points particulièrement problématiques. A partir de 2016, les ateliers ont été maintenus sur une base mensuelle.

Quelques personnes sont venues plusieurs fois, ayant entre-temps acheté une liseuse, ou amenant avec elles leur ordinateur portable pour débloquer un problème. De façon générale, les ateliers sont également l’occasion d’échanges, tant au niveau technique que du contenu de l’offre ou du plaisir de lire.

Un accompagnement sur place complète le support par e-mail ou par téléphone

Parallèlement à l'accompagnement sur place le support se fait également à distance, par e-mail et par téléphone. Les demandes sont parfois standards mais souvent dépendantes de la configuration des équipements personnels des usagers. Les problèmes ne sont pas toujours faciles à déceler mais, avec le temps, l’équipe qui répond aux questions en ligne a pu établir une sorte de catalogue des problèmes les plus fréquents et de leurs solutions.

Dans l’ensemble, nous avons eu très peu de cas pour lesquels nous n'avons pas trouvé de solution, et ceux-ci ont été transmis au support informatique de la plateforme.

L’aide en ligne et les FAQ

Nous n’avons pas créé de documentation propre, car la plateforme propose une aide en ligne [6]et une FAQ, en français et en anglais. Les guides de démarrage, très bien faits, permettent une entrée en matière pas à pas, et sont d’une grande utilité pour ceux qui se lancent. C’est aussi un bon outil vers lequel sont renvoyés les usagers qui prennent contact avec nous.

Constat

La majorité des usagers empruntent le numérique de manière autonome. Et si un obstacle est rencontré, c’est souvent relativement trivial, par exemple un mot de passe expiré, qui peut être réglé par e-mail.

Le support eLectures, que ce soit en présentiel ou à distance touche majoritairement des usagers très attirés par l'idée de lire sur liseuse ou tablette, mais pas (du tout) par les aspects techniques de la chose. Plusieurs nous interpellent régulièrement afin d'obtenir de l'aide. Pour certains, il suffit parfois d'une mise à jour du système d’exploitation ou du logiciel Adobe Digital Edition, ou d'un changement de paramètres de téléchargement des fichiers pour que le moteur se grippe… et que le lecteur se perde.

De nouveaux eLecteurs s’inscrivent chaque mois sur la plateforme. Il faut dès lors s'attendre à poursuivre cette médiation numérique dans le futur. Les solutions ne sont pas toujours évidentes, mais il est gratifiant de voir un lecteur repartir heureux d’avoir réussi à télécharger son livre, ou qui nous signale lors d'un passage à quel point sa tablette ou sa liseuse lui convient.

A noter que nous avons aussi eu une poignée d’usagers qui ont baissé les bras, et déclaré qu’ils préféraient passer du temps à lire un livre plutôt qu’à résoudre des problèmes informatiques.

Au niveau quantitatif

La part des personnes touchées par les ateliers est très minoritaire. Une septantaine d’ateliers ont été organisés depuis le lancement de l’offre, dont la moitié dans les 6 premiers mois.

Elle est en revanche beaucoup plus importante par e-mail. En deux ans, l’équipe qui gère les questions a répondu à plus de 570 messages. Pour l’année 2016, cela correspondait par exemple à 25% des questions d’usagers par e-mail sur l’adresse d’information du site Riponne.

Prêt de liseuses

Le prêt de matériel a tout de suite fait sens afin d’aider à la promotion de la lecture numérique. Le prêt de liseuses a plusieurs atouts. Tout d’abord, il offre une visibilité (non négligeable) à l’offre virtuelle de prêt numérique. De plus, cela valorise les compétences du personnel qui devient référence dans l’utilisation des différents outils.

La mise en place du prêt de liseuses a nécessité en amont :

- L’achat du matériel (choix des liseuses, définition des conditions de prêt, commande, équipement, …),

- L’ajout d’information sur le site web et sur eLectures directement pour en faire la promotion,

- La formation des collaborateurs à l’utilisation de ce matériel (transfert de livres numériques mais aussi réinitialisation de l’appareil au retour de prêt).

Le prêt de liseuses a tout de suite été un succès, l’ensemble du parc a été prêté dès le premier jour et tous les appareils étaient réservés à leur retour.

Face à ce succès, nous avons essayé, 4 mois après le lancement de la plateforme eLectures, le prêt de liseuses pré-chargées. Cette offre était proposée dans une optique de faciliter le prêt de livres numériques, dont la création d’un identifiant Adobe nous paraissait être un frein. Cependant, cette offre n’a pas rencontré son public et n’a pas été reconduite.

Enfin, après deux ans de mise en service et sur les 13 liseuses mises en circulation, une seule liseuse a rencontré un problème et la garantie a couvert les frais de réparation. Aucune autre liseuse, malgré plus d’une trentaine de prêts chacune, n’a subi de dommage.

Investissement des professionnels dans l’animation d’eLectures

Passée la période de lancement d’eLectures et en plus de la promotion régulière qui en est faite auprès du public, il est crucial de faire vivre notre catalogue et de donner envie à nos eLecteurs de revenir sur notre plateforme. La spécificité de l’offre numérique, aussi bien en bibliothèque que pour les libraires en ligne, est le manque de visibilité de l’offre, au-delà des références présentées sur la page d’accueil.

Deux outils assez classiques, bien connus des bibliothécaires, sont ici à notre disposition pour nous aider à mettre en valeur le catalogue. Ainsi, on peut créer des sélections thématiques en s’appuyant sur l’actualité littéraire, l’actualité générale ou simplement nos envies, ou encore écrire des avis, « Bouche à oreille » à la BCUL, sur les titres au catalogue. Les sélections nous permettent ainsi de valoriser notre fonds. Les avis ont un effet plus ponctuel mais plus fort sur les prêts du titre concerné. Dans les deux cas, la recherche par auteur permet de redonner de la visibilité à toute une œuvre. Par la magie du clic, c’est un moyen immédiat de « faire » du prêt, mais aussi de mettre en valeur les compétences des bibliothécaires.

Dans le cadre d’une offre numérique, il est important de renouveler régulièrement ces sélections et ces coups de cœur afin de ne pas lasser l’utilisateur fréquent. Le succès de ce type de promotion est renforcé par une utilisation des médias sociaux. La newsletter BCUL fait ainsi systématiquement mention dans ses rubriques de titres eLectures. La promotion croisée avec les ressources documentaires physiques in situ est évidemment un plus. Enfin, une sélection ou un avis sur des titres eLectures sont réutilisés, quand cela est possible, pour faire la promotion de leur contrepartie physique.

Quel lectorat pour eLectures ?

Le public ciblé

Nos deux objectifs principaux, lorsque nous avons décidé de nous lancer dans une offre numérique, étaient qu’elle soit « grand public » et accessible à distance.

En tant que bibliothèque publique, nous souhaitions développer une offre « pour tous ». Cela n’excluait bien évidemment pas le public de l’université mais il s’agissait d’inclure nos « autres » usagers, principalement actifs sur le site du centre-ville, avec une offre d’actualité et de loisirs, pendant numérique de l’offre physique de la bibliothèque.

A partir de là, on ouvrait la possibilité d’élargir la population actuelle de nos lecteurs, en touchant :

- Les plus distants, donnant ainsi à la BCUL l’occasion de jouer pleinement sa carte cantonale, en atteignant également les régions plus éloignées de Lausanne,

- Ceux qui ne peuvent se déplacer physiquement à la BCUL, que ce soit pour des motifs professionnels, de santé ou de disponibilité.

On savait par ailleurs qu’une offre numérique intéresserait potentiellement d’autres types d’usagers, comme par exemple les grands lecteurs ou les pendulaires, qui allaient ainsi alléger leur sac.

Enfin, l’idée était à la fois d’attirer de nouvelles personnes, mais aussi de fidéliser nos lecteurs actuels avec une offre numérique accessible à distance et donc aussi disponible pour ceux qui ont quitté l’université ou disposent de moins de temps ou d’occasion de se déplacer dans une bibliothèque.

Analyse du lectorat deux ans après le lancement de l’offre

En l’état, nous pouvons nous baser uniquement sur les statistiques proposées par la plateforme (nombre de prêts, nombre d’usagers, liste des usagers) et sur quelques données observées soit au niveau des emprunts, soit dans les interactions que nous avons avec certains eLecteurs. Seule une enquête permettrait de fournir des données plus précises, notamment qualitatives, sur ce lectorat d’un service numérique.

Le profil d’usage

Dans son enquête dans les médiathèques en Auvergne-Rhône-Alpes, Mabel Verdi Rachemacher (Verdi Rachemacher, 2017) distingue trois types d’usagers : les convaincus, qui ont eu une expérience de lecture numérique satisfaisante et dont la pratique est stabilisée ; les dubitatifs, qui ont eu une expérience satisfaisante mais préfèrent lire en version imprimée ; et enfin les désenchantés, qui font un bilan négatif de leur expérience.

Dans l’utilisation d’eLectures, nous observons les deux postures extrêmes : des personnes qui s’inscrivent à la prestation, empruntent un ou deux livres et ne reviennent pas. Nous avons également un nombre assez important de grands lecteurs, qui empruntent par lot de 10 livres numériques chaque mois, et ceci depuis leur inscription numérique. Un de nos lecteurs emprunte un nouveau livre chaque jour, et nous a dit le lire dans ses déplacements durant la journée. Dans les usages cycliques, on remarque des lecteurs qui n’empruntent pas de manière régulière, mais intensivement à des périodes données, vraisemblablement avant un départ en vacances.

Sur le plan quantitatif ensuite.

Dans son article du Livres Hebdo paru en février 2017, Véronique Heurtematte (Heurtematte, 2017) donne les informations suivantes : à Montpellier Méditerranée Metropole, l’offre touche 1’000 lecteurs sur les 54’000 que compte le réseau (1,9%). A Grenoble, les prêts concernent 1’300 des 35’000 usagers (3.7%). La BCUL compte elle environ 29'000 lecteurs actifs, dont 1'800 sont inscrits à eLectures. Le ratio (6,2 %) est comparativement bon.

Le profil des usagers eLectures

Il faut mentionner que ces données de profil ne sont pas stockées dans la plateforme, qui n’enregistre que les données nécessaires à la gestion du compte : numéro de carte, mot de passe, adresse e-mail. Comme il faut être inscrit dans le réseau Renouvaud pour emprunter dans eLectures, les données ci-dessous proviennent du SIGB.

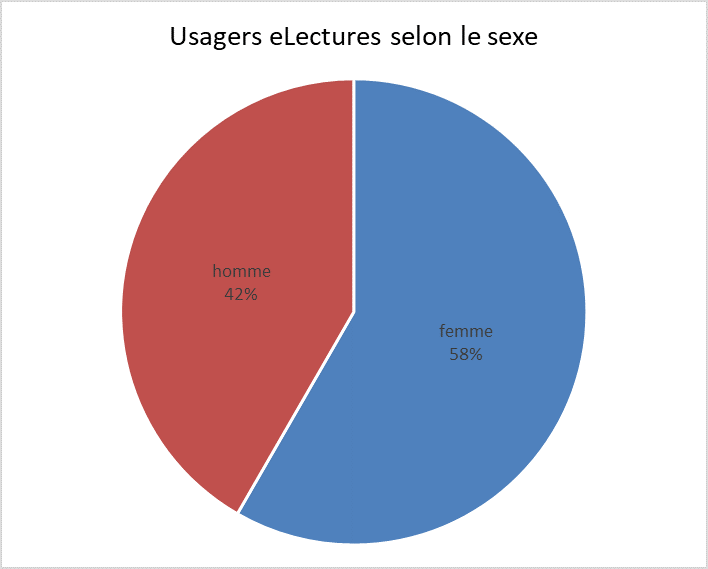

Selon le sexe : les inscrits sur la plateforme sont à 58% des femmes. Pour la lecture en général, l’enquête OFS 2014 sur les pratiques culturelles en Suisse (OFS, 2017) et la brochure présentant les premiers résultats de l’enquête (OFS, 2016) notent que les femmes sont plus nombreuses à lire des livres que les hommes, et particulièrement si on parle de la lecture pour les loisirs. En revanche, il semblerait que la parité se retrouve, au niveau Suisse, pour la lecture d’e-books pour les loisirs.

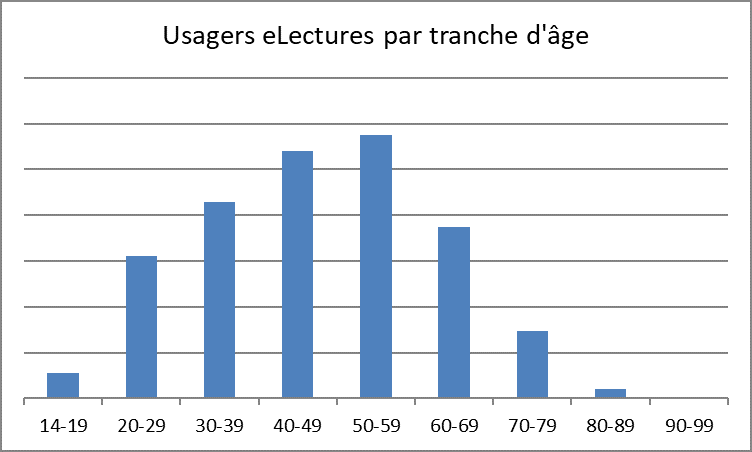

Selon l’âge : comme le montre le graphique ci-dessous, toutes les tranches d’âge sont représentées, avec une prédominance des quadragénaires et quinquagénaires. Assez réjouissante, la présence des trentenaires en troisième position, soit un public moins présent physiquement dans les bibliothèques. A titre de comparaison, les données de l’OFS (2017) montrent que les 30-44 ans sont de plus grands amateurs d’e-books. Pour l’anecdote, le lecteur « jeune depuis le plus longtemps » est né en 1925.

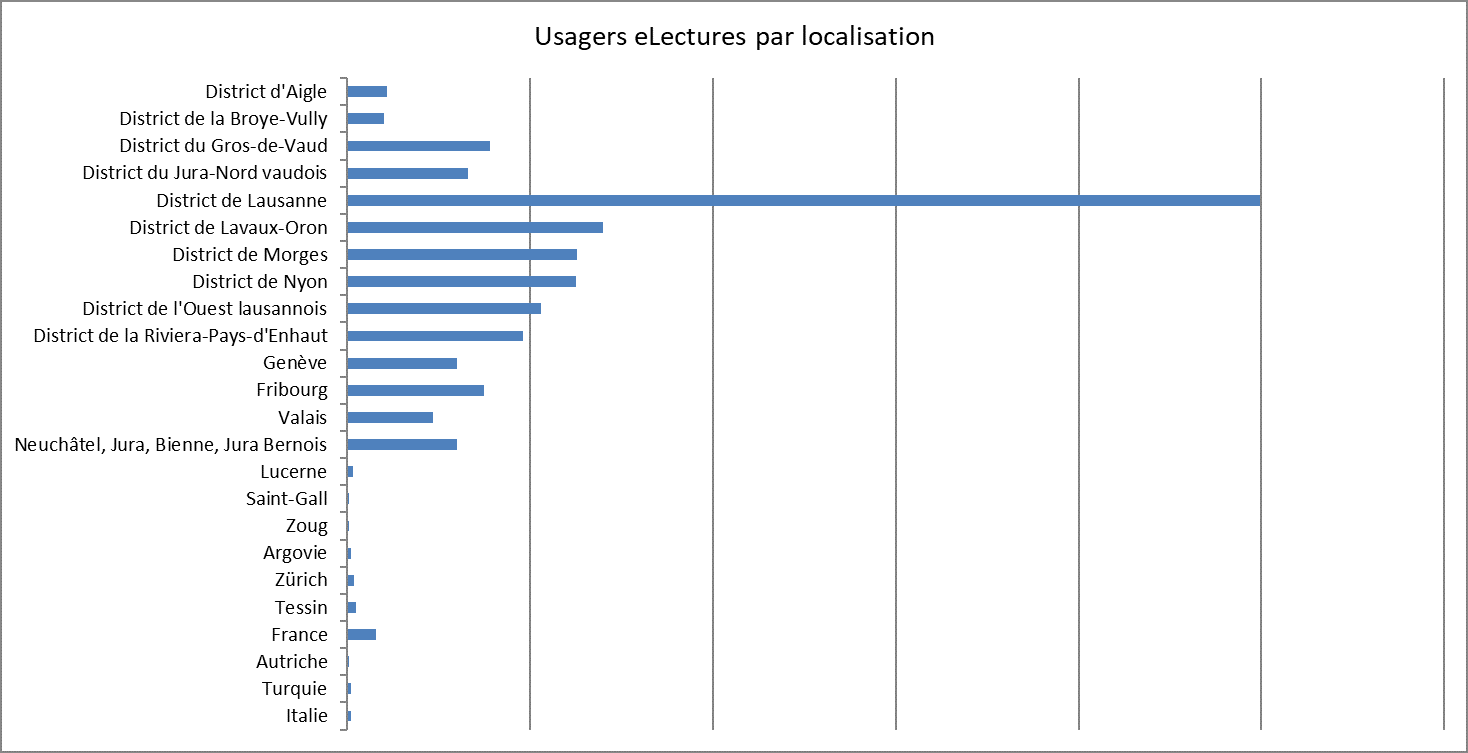

Selon le lieu : Un objectif initial était de toucher tout le canton. Force est de constater que l’utilisation pour l’instant reste bien concentrée sur les agglomérations vaudoises. Cela va dans le sens de l’enquête de l’OFS 2014 citée plus haut qui souligne que la plupart des activités culturelles sont pratiquées plutôt par des citadins et les habitants d’une agglomération.

Comme on peut le lire dans le graphique, la grande majorité des utilisateurs de la plateforme habite dans le district de Lausanne (46% des usagers « vaudois »). Les habitants du canton de Vaud représentent à eux seuls 82% des usagers de eLectures, les 18% restants étant composés d’autres cantons romands (16%), des cantons alémaniques et du Tessin (1%) et de l’étranger.

eLectures, produit de substitution ou gain de nouveaux lecteurs ?

Proposer une offre numérique apparaît pour de nombreuses bibliothèques comme un choix stratégique. La bibliothèque évolue, ses services aussi. Si l’on souhaite rester en phase, les bibliothèques doivent s’adapter. On est également dans une démarche de diversification des prestations offertes et des publics.

Il reste néanmoins très difficile de définir de manière précise si une telle offre est, au niveau du lectorat, plutôt un produit de substitution ou une opportunité d’attirer un nouveau lectorat et de renouveler les publics. C’est sans aucun doute un peu des deux.

Dans une bibliothèque comme la nôtre, le nombre de lecteurs actifs (c’est-à-dire qui emprunte physiquement au moins un document dans le cours d’une année civile) est stable. Cela signifie un équilibre entre ceux qui cessent d’emprunter, et les nouveaux lecteurs qui s’inscrivent. C’est un processus normal, surtout dans le cadre d’une bibliothèque qui touche des apprenants (gymnasiens, étudiants à l’UNIL) qui sont mobiles une fois leur formation terminée.

Même si le nombre de prêts effectués sur la plateforme eLectures est tout à fait satisfaisant, on ne peut pas dire qu’il y ait une percée au niveau des statistiques d’emprunts. On ne peut pas non plus lire dans les statistiques de prêts de documents physiques s’il y a substitution ou non. Il y a de toute façon une limite à ce que qu’un individu peut lire en un mois, même en étant un grand lecteur. Ce que l’on peut constater, c’est qu’une partie du public d’eLectures emprunte également des documents physiques sur nos sites. Certains se sont mis au numérique quand ils ont vu par exemple que le Prix Goncourt 2016 était disponible tout de suite en numérique et sans file d’attente...

A-t-on gagné des nouveaux lecteurs grâce à eLectures ? Oui clairement. Ce n’est pas chiffrable car certains sont venus s’inscrire sur place sans mentionner qu’ils s’intéressaient à eLectures. Cependant de nombreuses personnes nous ont contactés, parfois de loin, en nous disant s’inscrire pour le numérique uniquement.

Relations avec les fournisseurs

Fonctionnement quotidien de la plateforme et réponses du support technique

Les relations avec notre fournisseur se limitent surtout au support qu’il offre en cas de problèmes. Les acquisitions et les renouvellements d’abonnement (à la plateforme) sont des processus bien rodés qui se déroulent efficacement. En revanche, le support technique (c’est-à-dire, en cas de problème avec un appareil ou à l’ouverture d’un fichier), constitue le principal point faible de notre fournisseur et ce pour trois raisons principales.

La première, et la plus importante, est l’absence d’un interlocuteur clair et identifié. Dès lors, en cas de problème, nous envoyons, telle une bouteille à la mer, un e-mail à une adresse générique qui fait preuve de bien peu de réactivité. Le fournisseur répond à ce problème que la messagerie est bien relevée, qu’ils traitent la question, sans nécessairement répondre à l’interlocuteur qui l’a soulevé. La solution consiste donc à tester régulièrement pour savoir si oui ou non le problème est résolu.

La seconde raison est le manque de communication de notre fournisseur envers ses clients. Par exemple, lorsqu’un éditeur décide, pour les nouveaux titres, de réduire le nombre de prêts simultanés de ses documents nous n’en sommes pas informés. Cette problématique est réelle pour les acquéreurs qui découvrent alors qu’il faut acheter davantage d’« exemplaires » pour pallier le changement de pratique de l’éditeur mais rendre cela transparent pour l’usager ; la volonté étant de conserver un niveau de service équivalent.

La troisième raison est que les problématiques remontées ne concernent en général pas directement l’offre ou sa mise à disposition sur la plateforme. Pour preuve, les deux problèmes principaux rencontrés en 2017 ne relevaient pas de Cantook Station. Le premier problème est apparu avec la mise à jour 10.3.1 du système d’exploitation iOS d’Apple. En effet, le code comportait une erreur qui empêchait l’ouverture des fichiers avec les applications de lecture Bluefire Reader et Aldiko sur iOS (iPhone et iPad). Le second qui consistait en un message d’erreur incompréhensible à l’ouverture des livres résultait du fait que certains distributeurs de livres numériques transmettaient des fichiers qui contenaient des erreurs de validité au niveau du verrou numérique.

A la décharge de notre fournisseur, la qualité du support est aussi en lien avec sa position. En effet, celui-ci est toujours « entre deux feux » : il distribue des documents qu’il n’a pas générés (donc il n’a pas la main sur leur qualité) et les met à disposition sur des appareils qu’il ne développe pas (iPad, liseuses…). Là encore, il est tributaire des développements de ces sociétés.

Avantages et inconvénients de l’externalisation pour la BCUL

Le choix d’un service hébergé en local ou dans le cloud est d’ordre institutionnel. Il y a des avantages et des inconvénients aux deux solutions mais ce n’est pas le propos de l’article. Ainsi, nous vous proposons de détailler ici les avantages et inconvénients de la solution choisie, c’est-à-dire celle de l’hébergement à distance.

Tout d’abord, nous avons accès à un catalogue déjà constitué, dont l’ensemble des négociations avait été effectué par le diffuseur. Cette offre initiale évolue constamment, que ce soit avec l’intégration de nouveaux éditeurs ou par l’enrichissement d’une collection déjà existante. Ce dernier est le fruit du travail direct de notre distributeur, travail de négociation et de médiation pour lequel nous ne sommes pas qualifiés. La délégation de la négociation trouve toutefois ses limites et notamment pour de petits éditeurs locaux, peu représentatifs du besoin de l’ensemble des clients et pourtant tellement précieux pour les usagers des bibliothèques locales.

La souscription à une plateforme externe permet aussi de bénéficier du travail de tous les clients précédents et notamment des demandes d’amélioration qu’ils ont effectuées. Un des gros points forts de l’offre mise à disposition est l’aide, extrêmement complète et très bien structurée qui nous permet de minimiser les explications par e-mail avec nos lecteurs en renvoyant vers celle-ci.

Les autres clients sont donc un atout pour faire évoluer ce type d’offre car les besoins sont sensiblement les mêmes (contrairement à un SIGB par exemple où chaque bibliothèque a ses exigences particulières). En revanche, dès que l’on souhaite des développements spécifiques (ex. ajout de statistiques), le fait d’avoir un besoin « hors norme » par rapport aux autres clients est une réelle faiblesse et les chances de voir le développement aboutir sont minces.

Enfin, la BCUL aurait aimé pouvoir mettre à disposition ses livres numériques dans son catalogue de « livres papiers » et permettre ainsi aux lecteurs de découvrir cette offre. Malheureusement, et malgré l’utilisation de protocoles standards par les deux outils, cela reste, pour l’instant, une volonté non aboutie. Nous allons travailler avec nos fournisseurs, ExLibris et Cantook, afin de pouvoir offrir cette amélioration à nos lecteurs.

Perspectives d’avenir

Pérenniser notre fonction de médiation

La médiation autour de l’offre de livres numériques est indispensable, d’une part parce que ceux-ci sont peu, voire pas visibles dans l’espace physique de la bibliothèque (et difficiles à rendre visibles) et, d’autre part, parce que l’aspect technique peut rebuter certains usagers peu à l’aise avec ces questions, mais pour qui le numérique apporte des avantages certains (ex. grossissement des caractères, pour ne citer qu’un aspect).

La plupart des bibliothèques le remarquent : le numérique ne fonctionne pas tout seul. Florent Dufaux fait le même constat (Dufaux, 2016) pour l’expérience de Labo-Cités à Genève.

En présentiel, aux guichets du site Riponne, on observe déjà un déplacement du type de questions posées par les usagers : de plus en plus sont en lien avec les équipements techniques (wifi, impression, internet, bureautique). Ainsi, si on propose une offre comprenant une part technique importante on doit l’accompagner et avoir des bibliothécaires prêts à y répondre et cela même si la foire aux questions (FAQ) est bien construite. Une partie du lectorat numérique est autonome ou le devient, mais, on l’a vu, ce n’est pas le cas de tous. Chaque mois de nouveaux lecteurs découvrent eLectures. Nous continuerons donc de proposer cette fonction de médiation sur la durée.

S’adresser à toute la population vaudoise

Une telle offre numérique est une formidable opportunité pour notre institution de se rapprocher de son public principal : l’ensemble de la population vaudoise. Alors que les institutions culturelles vaudoises sont encore concentrées dans l’agglomération lausannoise, eLectures est un médium qui permet de faire connaître la BCU Lausanne dans tout le Canton en proposant un offre accessible à l’ensemble de ses habitants. Le bouche-à-oreille prenant le relais, dans un second temps, de la promotion institutionnelle.

Pour l’équipe en charge de ce projet, on peut avancer qu’eLectures sera une vraie réussite lorsque, en plus d’une utilisation importante et régulière, les proportions d’usagers provenant des différents districts du Canton seront équilibrées.

Continuer à promouvoir eLectures

Un service de ce type-là doit rester vivant. La réalité des licences des livres numériques implique une vie active de cette « collection ». Alors que les collections physiques de la BCU Lausanne ont un taux de rotation annuel de 7% [7], il est évidemment ni intéressant ni rentable financièrement qu’un tel taux se retrouve sur une plateforme de prêt de livres numériques. Actuellement, le fonds eLectures est à plus de 100% de taux de rotation (chiffres de juillet 2016 à juin 2017).

Mais cela n’est possible que si la promotion d’eLectures se fait de manière continuelle à travers la communication institutionnelle ou une mise en valeur par l’intégration de ces documents dans notre outil de découverte public. Actuellement, cette solution n’a pas pu être mise en place à la BCU Lausanne mais ce travail de moissonnage de nos livres électroniques est en cours avec De Marque (via le protocole OPDS). La mise à disposition de l’offre eLectures via l’interface publique procure une visibilité sans égale et augmentera le public touché par celle-ci.

La promotion passe également par l’animation de la plateforme avec des sélections régulières liées à l’actualité de la BCU Lausanne ou du monde ou par la rédaction de nos « Bouche-à-oreille », coups de cœur des bibliothécaires imprimés traditionnellement sur des signets, qui se voient ici offrir une nouvelle vie numérique.

Bref, la promotion d’eLectures doit être envisagée comme un continuum, année après année, et surtout, budget après budget.

Utilisation des réseaux sociaux

Qui dit numérique, dit réseaux sociaux, la BCUL est présente sur différentes plateformes mais principalement Twitter et Facebook [8]. Etant donné que la charge de faire vivre ces comptes est répartie sur une multitude de collaborateurs, nous avons facilement la possibilité de promouvoir une sélection de documents, un titre en particulier faisant écho à l’actualité ou de donner des informations pratiques sur le service. Il est cependant difficile d’évaluer l’impact de ce mode de communication sur les emprunts de e-books. Cela dit nous partons du principe que plus le nom du service circule, plus il y a de chance que l’effet « bouche à oreille » atteigne son public.

Nous savons par contre que des pics d’emprunts suivent de quelques heures l’envoi de la newsletter institutionnelle à tous nos usagers actifs. Cette dernière contient systématiquement au moins deux « avis du bibliothécaire » sur des documents de nos collections avec un lien, via notre blog, vers eLectures si nous en proposons une version numérique. Si on considère qu’entre juin 2015 et mai 2017, nous mesurions en moyenne 37 prêts par jour, cet indicateur pouvait monter à 60 ou 70 dans les jours qui suivaient l’envoi d’une newsletter.

Comme on l’a déjà souligné lorsque nous traitions de la médiation, un service numérique de ce type ne peut pas vivre tout seul et il est difficile de le rendre visible aux usagers. Les tentatives de promotion dans nos locaux par différents moyens aident à faire connaître l’offre mais il y a toujours une étape difficile à franchir : celle de convertir un usager potentiel se trouvant dans la bibliothèque en usager actif sur le net. La présence sur les réseaux sociaux est donc importante pour créer des liens vers la plateforme, la faire connaître et continuer d’attirer un public distant.

Conclusion

Après 27 mois d’exploitation, le bilan de l’expérience eLectures est plus que positif pour la BCUL, ses lecteurs et ses collaborateurs. En premier lieu, cette offre a trouvé son public avec 1'800 inscrits sur les 29’000 usagers actifs de la BCUL. Notre premier défi est, bien entendu, de continuer à la faire connaître auprès de notre public mais aussi d’en faire un outil permettant à la BCUL d’attirer de nouveaux lecteurs.

En second lieu, eLectures a été l’occasion, pour une partie des collaborateurs de l’institution, de se confronter aux nouvelles technologies de l’information à travers un projet concret au service de nos lecteurs. Des collaborateurs toujours plus compétents, capables de répondre aux questions variées et pointues des usagers, contribuent à changer l’image encore trop traditionnelle des bibliothèques auprès du grand public. C’est aussi un moyen, en répondant à ses nouveaux comportements, de garder ce public en bibliothèque. Enfin, le lancement de ce type d’offre numérique est aussi l’occasion d’attirer l’attention des médias, presse écrite et radio, et, là encore, de démontrer le dynamisme de nos institutions et de faire connaître la richesse d’une offre documentaire et de services qui est encore loin d’être connue de tous.

Bibliographie

CHARTIER, Mathieu (2017). Les ventes de livres numériques en baisse. Les Numériques, 02.05.2017, http://www.lesnumeriques.com/liseuse/ventes-livres-numeriques-en-baisse-n62603.html (consulté le 22.06.2017)

DUFAUX, Florent (2016). Labo-Cité : pourquoi une bibliothèque sans livres ?. Ressi. 2016.

http://www.ressi.ch/num17/article_124 (consulté le 14.08.2017)

GLAUS, Christoph (2016). Trois Suisses sur quatre ont adopté le smartphone. Comparis.ch. 2016. https://fr.comparis.ch/comparis/press/medienmitteilungen/artikel/2016/telecom/smartphone-studie-2016/smartphone-verbreitungsstudie-2016.aspx (consulté le 22.06.2017)

HEURTEMATTE, Véronique (2016). Prêt numérique, épisode 2, le réveil de la force. Livres Hebdo no 1071, 05.02.2016.

http://www.livreshebdo.fr/article/pret-numerique-episode-2-le-reveil-de-la-force (consulté le 10.08.2017)

OFFICE FÉDÉRAL DE LA STATISTIQUE (2017). Equipement TIC. 2017. https://www.bfs.admin.ch/bfs/fr/home/statistiques/culture-medias-societe-information-sport/societe-information/indicateurs-generaux/menages-population/equipement-tic.html (consulté le 22.06.2017)

OFFICE FÉDÉRAL DE LA STATISTIQUE (2016). Pratiques culturelles et de loisirs en Suisse : premiers résultats de l’enquête 2014. 2016. https://www.bfs.admin.ch/bfsstatic/dam/assets/349945/master (consulté le 04.09.2017)

OFFICE FÉDÉRAL DE LA STATISTIQUE (2017). Pratiques culturelles en Suisse 2014: livres, ebooks, bandes dessinées et bibliothèques. 2017. https://www.bfs.admin.ch/bfsstatic/dam/assets/3243673/master (consulté le 11.09.2017)

RESEAU CAREL. Le PNB tel qu’on le parle. https://www.reseaucarel.org/page/le-pnb-tel-qu-le-parle-0 (consulté le 04.09.2017)

ROSSELET ; Marion (2017). Edition vaudoise : arrêt sur image, panorama général et enquête statistique sur l’activité éditoriale dans le canton de Vaud en 2015-2016. Ville de Lausanne et Etat de Vaud, août 2017. http://www.vd.ch/fileadmin/user_upload/themes/culture/aides_creation/fichiers_pdf/EtudeVD_MRosseletDEF_-_v.pit.pdf (consulté le 07.09.2017)

VERDI RADEMACHER, Mabel (2017). Le numérique et le lecteur, retour du nomade : une enquête dans les médiathèques en Auvergne-Rhône-Alpes. 2017.

http://www.enssib.fr/presses/catalogue/le-numerique-et-le-lecteur-retour-du-nomade (consulté le 10.08.2017)

Notes

[1] 2,5% du chiffre d’affaire global de l’industrie du livre en France. A un niveau plus global, les ventes de e-books semblent baisser y compris dans le monde anglophone. (Chartier, 2017)

[2] En 2014, presque 80% des ménages suisses possèdent au moins un ordinateur portable et 78% des 15-74 ans (2016) un smartphone. (OFS, 2017 et Glaus, 2016)

[3] Pour plus de détails sur le projet PNB, vous pouvez consulter le document rédigé par le réseau Carel (RESEAU CAREL, non daté)

[4] Le rapport de Marion Rosselet (Rosselet 2017) l’indique en tout cas pour les éditeurs vaudois en ne recensant que 12% de leurs catalogues en version numérique.

[5] https://www.youtube.com/playlist?list=PLRvUETy0qVh5SNtO-5RLr2T0gP12q0dcv

[6] http://bcu-lausanne.cantookstation.eu/aide

[7] Ce chiffre inclut également les ouvrages du dépôt légal et des collections précieuses qui ne s’empruntent pas.

[8] https://twitter.com/BCULausanne et https://www.facebook.com/BCULausanne

Livres et presse numériques en bibliothèque de lecture publique : état de lieux de l’expérience menée par les bibliothèques de Carouge

Yves Martina, directeur des bibliothèques de Carouge

Livres et presse numériques en bibliothèque de lecture publique : état de lieux de l’expérience menée par les bibliothèques de Carouge

Avec Lancy, Meyrin, Onex et Vernier, la Ville de Carouge (22'000 habitants) est l’une des cinq grandes communes suburbaines du canton, en périphérie de la Ville de Genève. Hormis Onex, ces communes possèdent toutes une ou plusieurs bibliothèques, indépendantes du réseau des Bibliothèques municipales de la Ville de Genève.

Ouverte en 1857, la Bibliothèque de Carouge s’est développée au fil des ans et des déménagements. Elle s’est informatisée en 1998 et fonctionne en réseau depuis 2009, date de l’ouverture de sa première « bibliothèque-relais ».

Les bibliothèques de Carouge [1] dépendent du SACC (Service des affaires culturelles et de la communication) et comptent 14,75 postes à plein temps pour 20 collaborateurs, dont 12 bibliothécaires et agents en information documentaire. Elles proposent à leurs usagers quelque 70'000 documents et génèrent plus de 215'000 prêts annuels.

Préambule

Les bibliothèques de Carouge ont introduit le multimédia dans leurs collections en 2009 et le numérique en 2012.

L’offre multimédia étant « tardive » (seul un petit fonds de CD musique existait avant 2009 et l’ère des cassettes VHS a été totalement ignorée), l’objectif était de ne pas manquer le virage du numérique. Au niveau politique, il a été plus facile de convaincre certains décideurs d’enrichir les collections des bibliothèques par des documents numériques que par des supports multimédias, soupçonnés de véhiculer des contenus trop axés sur le divertissement.

En 2012, l’offre numérique à l’intention des bibliothèques publiques est réduite. En Suisse romande, le Valais, qui fait ici office de pionnier, dispose d’un fonds alimenté par le fournisseur français Numilog [2]. Dans sa mise à disposition des documents, celui-ci présente l’inconvénient de demander un accès à l’intégralité du fichier des usagers de la bibliothèque et pas seulement à ceux intéressés par l’emprunt de livres numériques. La protection des données individuelles étant un problème sensible, les autorités politiques carougeoises ont renoncé à travailler avec Numilog (sans avoir préalablement testé la solution proposée par ce fournisseur) et ont souhaité la recherche d’une alternative. Une gageure sachant, qu’en 2012, Numilog est le seul fournisseur du marché francophone.

Les premiers pas

Pour sa première approche numérique, les bibliothèques de Carouge font l’acquisition de cinq liseuses (Sony et Kindle) et deux tablettes (iPad et Asus) dans lesquelles sont proposés des contenus différents, articulés autour d’un choix de documentaires et de romans (5 à 8 documentaires et 10 à 20 romans par support) à l’intention d’un public adulte.

Le choix a donc préalablement été fait par des bibliothécaires, sur la base d’ouvrages libres de droits proposés par des éditeurs qui, eux-mêmes, testaient une mise à disposition de titres issus de leur catalogue au format numérique. Les liseuses et les tablettes ont été mises gratuitement à disposition des usagers, mais une caution leur était demandée et restituée au retour du support. Ce qui était à la fois contraignant et inconfortable, tant du point administratif que pour l’usager.

Cette expérience a été suivie par une cinquantaine d’usagers, entre juin 2012 et septembre 2013 :

- 97% des usagers l’ont fait dans le but de découvrir le fonctionnement du support.

- 3% des usagers possédaient déjà une liseuse et se sont intéressés aux contenus proposés.

Après chaque emprunt, les usagers ont été sondés et invités à faire part de leurs remarques et suggestions pour façonner l’avenir du numérique dans leurs bibliothèques. Il en est ressorti que :

- 93% des usagers ont été séduit par le support et ont relevé les avantages suivants : capacité de stockage, faible encombrement et confort de lecture, notamment dans les transports publics.

- 100% des usagers indiquent que la liseuse est pour eux une alternative (selon les opportunités de lecture) et non un remplacement du livre traditionnel.

- 100% des usagers souhaitent avoir accès aux téléchargements de leur choix : ils ne reconduiraient pas l’expérience au travers de liseuses avec des contenus préétablis.

- 98% des usagers préfèrent disposer de leur propre liseuse et ne jugent pas pertinent d’en emprunter une en bibliothèque.

En conséquence de qui précède, dès novembre 2013, les bibliothèques de Carouge retirent les liseuses de leur offre et les projets en lien avec le numérique sont gelés, faute de trouver une alternative au fournisseur Numilog.

Le projet PNB : les éditeurs français font (enfin !) un effort envers les bibliothèques

En France, une offre numérique destinée aux bibliothèques publiques s’élabore et le projet PNB (Prêt numérique en bibliothèque) est présenté lors du congrès de l’IFLA 2014 à Lyon. Il s’agit d’une avancée significative qui fait intervenir l’ensemble des acteurs concernés : éditeurs, libraires, auteurs et bibliothèques. En 2015, le fournisseur Dilicom [3] est en mesure de proposer un premier catalogue de titres, accessible bien sûr en France, mais aussi aux bibliothèques suisses. La plateforme d’achat est assurée par la librairie de livres numériques Feedbooks[4].

Certes, ce catalogue à l’intention des bibliothèques est nettement moins riche que celui destiné au volet commercial, donc à l’achat de titres par des particuliers. Néanmoins, les bibliothèques y trouvent un intérêt : les prêts peuvent être simultanés (généralement entre 5 et 10 prêts) et la durée de vie d’un livre numérique se situe en moyenne à 5 ans et/ou à 50 prêts. La durée de l’emprunt est, quant à elle, de 4 semaines.

Cette opportunité va permettre aux bibliothèques de Carouge de rouvrir leur dossier numérique et de lancer deux offres à l’automne 2015. Elles sont rendues possibles par les améliorations de leur portail documentaire[5], qui donne désormais accès à des ressources externes :

- Livres numériques, via le fournisseur Dilicom : 1’020 titres sont proposés au catalogue [6] par téléchargement (750 romans « adultes », 150 documentaires « adultes » et 120 romans « jeunes »). Nombre d’emprunts sur l’année (3 mois) : 375.

- Presse numérique, via le fournisseur LeKiosk [7] : 750 titres sont proposés à la consultation en ligne [8] (720 titres « adultes » et 30 titres « jeunes »). Nombre de consultations sur l’année (3 mois) : 300.

En 2016, l’offre est enrichie et les fonds numériques portés à :

- 1’595 livres numériques (1’165 romans « adultes », 265 documentaires « adultes » et 165 romans « jeunes »). Nombre d’emprunts sur l’année : 375.

- 900 revues numériques (865 titres « adultes » et 35 titres « jeunes »). Nombre de consultations en ligne sur l’année : 390.

Il faut noter que, durant l’exercice 2016, de nombreux éditeurs modifient leurs conditions de prêt et abandonnent la simultanéité des emprunts : un seul prêt à la fois est moins intéressant et se rapproche trop du système en vigueur pour les livres traditionnels alors que le format numérique est justement intéressant s’il permet plus de souplesse à ce niveau.

En 2017, les bibliothèques de Carouge continuent à développer leur catalogue et la tendance suivante se dessine :

- 1'850 à 1’900 livres numériques au catalogue (75% fiction « adultes », 12% documentaires « adultes », 9% fiction « jeunes » et 4% bandes dessinées « adultes ».

Le nombre d’emprunts devrait approcher les 500 unités.

- 1’000 revues numériques proposées à la consultation (94% de titres « adultes » et 6% de titres « jeunes »).

Le nombre de consultations ne sera connu qu’en fin d’année (ce nombre est calculé directement par le fournisseur au terme de l’exercice et il n’y a pas, à ce stade, de données intermédiaires).

S’agissant des livres numériques, ce sont quelque 150 usagers distincts qui profitent de l’offre mise en place par les bibliothèques de Carouge, ce qui représente à peine plus de 3% des usagers actifs. Force est donc de constater qu’on se situe très nettement dans la marge, s’agissant du succès de la prestation.

Du côté des adultes, c’est vers la fiction que se portent sans surprise 95% des emprunts. Du côté des jeunes, seule la fiction est proposée au téléchargement.

S’agissant des revues numériques, les données récapitulatives se limitent pour l’instant au nombre de magazines consultés. Quelques sondages ont toutefois permis de dégager des préférences : actualité, féminin, bien-être et développement personnel, décoration d’intérieur sont les sujets qui génèrent le plus de consultations.

Quelles perspectives pour les deux années à venir ?

S’agissant des livres numériques :

- Disposer d’un fonds de 2'500 à 2’800 titres d’ici à 2020 (le fonds numérique représenterait alors 3% des collections).

- Améliorer l’outil de recherche et de présentation des ouvrages en 2019. En effet, dans sa prestation, le fournisseur Dilicom propose une notice bibliographique et des critères de recherche qui sont limités. Par importation de données fournies par d’autres fournisseurs, il sera possible de disposer de descriptifs et d’éléments de recherche plus proche de ce qui se fait pour les livres traditionnels (par exemple : indexation matière plus riche et plus rigoureuse s’agissant des genres littéraires, rebonds vers des ouvrages et des thématiques apparentés).

- En 2019, lancer une campagne de promotion des livres numériques et assurer leur visibilité en parallèle aux livres traditionnels, c’est-à-dire aussi dans le corps même des bibliothèques.

S’agissant des revues numériques :

- Maintenir la prestation en 2019 et 2020 au niveau des années précédentes, sachant que la marge de manœuvre sur le choix des magazines proposés est réduite puisqu’elle appartient à 95% au fournisseur.

- En 2019, adapter aux magazines numériques tout ou partie de la campagne de promotion qui sera mise en place pour les livres numériques.

Conclusion

Au moment d’adopter le projet PNB et de se lancer dans la mise en place d’une offre de livres numériques, les bibliothèques de Carouge disposaient de deux options :

- Rejoindre la plateforme suisse proposée par Bibliomedia [9] et bénéficier de la prestation et de la collection élaborée par cette institution, à savoir le partage des titres entre plusieurs bibliothèques.

- Disposer de son propre fonds et le gérer en propre, comme il est fait pour les livres traditionnels et le multimédia.

C’est cette deuxième option qui a été retenue parce qu’au moment du choix, l’offre e-Bibliomedia [10] n’était pas encore en place, bien que les deux organismes aient avancé en parallèle dès que Dilicom a ouvert son catalogue à la Suisse. D’autres critères sont certainement intervenus dans le choix du « cavalier seul », mais ils ne correspondaient pas une critique de la démarche proposée par Bibliomedia.

La « confidentialité » qui entoure la prestation numérique proposée par les bibliothèques de Carouge est-elle un point négatif ? On se permettra ici une réponse nuancée :

- Oui, parce que l’effort d’acquisition, notamment sur le plan financier, devrait se traduire par un succès plus probant.

- Non, parce qu’il faut se donner le temps nécessaire avant d’évaluer cette nouvelle prestation. Dès le début, il a été fixé un délai de 5 ans avant de tirer un bilan significatif. L’offre doit se faire connaître et les usagers l’apprivoiser, ce d’autant que la lecture sur un support électronique ne fait pas encore partie des mœurs usuelles des usagers des bibliothèques, notamment en Suisse. À noter aussi qu’aucune promotion du livre numérique n’a encore été faite de manière significative et que les usagers sont généralement amenés à découvrir par eux-mêmes (et parfois même par hasard) l’existence des documents numériques.

Le numérique n’est donc pas remis en cause et, à ce stade, l’objectif de base demeure : offrir aux usagers des bibliothèques de Carouge, par le biais du numérique, un complément et une alternative attractive aux supports traditionnels (livres et presse papier) ! Et, s’agissant des livres numériques, disposer d’un catalogue de 5'000 titres d’ici à 2025.

Notes

[1] bibliotheques-carouge.ch

[2] numilog.com

[3]dillicom.net

[4] fr.feedbooks.com (le volet dédié aux bibliothèques est accessible à l’adresse collectivites.feedbooks.com)

[5] Il s’agit de la solution nommée Syracuse, proposée par le fournisseur français Archimed (archimed.fr)

[6] Il s’agit bien ici du nombre des titres proposés par les bibliothèques de Carouge à leurs usagers et non de l’offre globale du fournisseur

[7]lekiosk.com ; le nombre de titres proposés par LeKiosk est variable (il dépend de l’offre éditoriale et des contrats passés avec les éditeurs) ; l’acheteur-bibliothèque peut façonner l’offre qu’il propose à ses usagers en biffant certains titres ou certains bouquets de titres

[8] Il s’agit bien ici du nombre des titres proposés par les bibliothèques de Carouge à leurs usagers et non de l’offre globale du fournisseur

[9] Fondation active dans le développement des bibliothèques de lecture publique et de la promotion de la lecture (bibliomedia.ch)

[10] e-Bibliomedia est une plateforme qui permet aux bibliothèques de lecture publique d’emprunter des ouvrages numériques, sans avoir elles-mêmes à en faire directement l’acquisition

Le Montreux Jazz digital project

Alain Dufaux, Directeur des opérations et du développement, Centre Metamedia, EPFL

Thierry Amsallem Président de la Fondation Claude Nobs

Le Montreux Jazz Digital Project

La sauvegarde des archives audiovisuelles du Montreux Jazz Festival, un patrimoine pour l’innovation et la recherche

Introduction

Ella Fitzgerald, Nina Simone, B.B. King, Miles Davis, James Brown, Marvin Gaye, Joe Cocker ou encore Gary Moore, Phil Collins, David Bowie et Prince, tous ont joué au Montreux Jazz Festival, chaleureusement accueillis par son créateur Claude Nobs, un montreusien visionnaire, passionné de musique et de technologie. Enregistrés dès les débuts en 1967, en audio et vidéo et toujours avec les technologies de pointe du monde broadcast, les artistes de passage au festival ont participé à la création de l’une des plus importantes collections de musique du 20e siècle, inscrite en 2013 au registre de la « Mémoire du Monde » de l’UNESCO.