N°14 décembre 2013

Sommaire - N°14, Décembre 2013

Etudes et recherches :

- Projektbericht: Connecting Open Library Systems and Sugar - Brigitte Lutz, Karsten Schuldt

Comptes-rendus d'expériences :

- La gouvernance des documents électroniques dans l’administration cantonale genevoise : genèse et mise en œuvre - Anouk Dunant Gonzenbach

Evénements :

- Veille et marketing de l’innovation : outils et méthodes pour explorer les marchés de demain : compte-rendu de la 10ème journée franco-suisse sur la veille stratégique et l’intelligence économique, 6 juin 2013, Haute Ecole de Gestion. Genève - Hélène Madinier, Maurizio Velletri

- Les humanités numériques et les spécialistes en information documentaire : compte-rendu de la 1re Digital Humanities Summer School, 26-29 juin 2013, Berne - Mathilde Panes, Igor Milhit

- Journée d'étude « Les données en bibliothèques, les enjeux des linked open data », Lausanne 1er octobre 2013 - Pierre Boillat

Ouvrages parus en science de l'information :

- Barrelet, Jean-Marc (éd.). Entre lecture, culture et patrimoine. La Bibliothèque de la Ville de la Chaux-de-Fonds 1838-2013 - Alain Jacquesson

Editorial no 14

Editorial no 14

Nous avons le plaisir de vous proposer le 14ème numéro de RESSI, seule revue électronique suisse en science de l’information.

Le Comité de rédaction de RESSI a été en partie renouvelé cette année : Michel Gorin et René Schneider ont quitté le Comité, alors qu’Alain Jacquesson, Basma Makhlouf Shabou, Stéphanie Pouchot, et Igor Milhit l’ont rejoint. Nous remercions les deux partants pour le travail effectué et souhaitons la bienvenue aux nouveaux.

Dans ce 14ème numéro, sous la rubrique Etudes et Recherches, vous trouverez un article en allemand de Karsten Schuldt et Brigitte Lutz, tous deux adjoint scientifiques à l'Institut des sciences de l'information de la HTW de Coire. Ils décrivent le projet COLISu, «Connecting Open Library System and Sugar », s’inscrivant lui-même dans le projet OLPC (One laptop per child/un PC portable par enfant) qui vise à offrir des ordinateurs, appelés XO, coûtant moins de 100 dollars et fonctionnant avec des logiciels libres et une interface graphique simple, « Sugar ». COLISu décrit les connexions possibles entre Sugar et des logiciels libres de gestion de bibliothèques, notamment Koha et ABCD.

Sous la rubrique « Compte rendu d’expérience », vous trouverez deux articles, émanant tous les deux de services d’archives cantonaux.

Le premier émane d’Anouk Gonzenbach, archiviste aux Archives d’Etat de Genève. Intitulé La gouvernance des documents électroniques dans l’administration cantonale genevoise : genèse et mise en œuvre, il relate le projet d’élaboration d’une politique de gouvernance des documents électroniques au sein de l’administration genevoise, projet mené en collaboration avec les services informatiques et les différents métiers de l’administration.

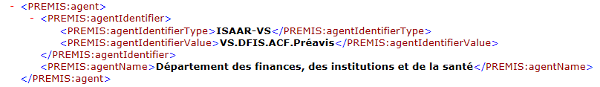

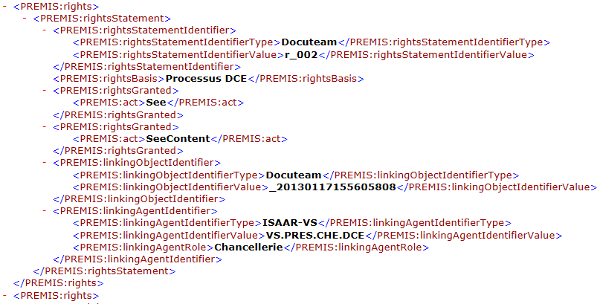

L’article d’Alain Dubois, archiviste-paléographe aux Archives cantonales du Valais, intitulé quelle qualité pour les archives électroniques ? Réflexions et retour d’expérience autour du processus décisionnel du Conseil d’Etat valaisan, détaille la méthodologie, les outils et techniques mis en œuvre pour optimiser la gestion des documents relevant du processus décisionnel du Conseil d’Etat valaisan (tous les documents produits ou reçus à l’occasion de ce processus). Cette approche fidèle à la norme OAIS-ISO 14721 met l’accent sur la nécessité de développer plusieurs types de métadonnées pour mieux contextualiser l’activité administrative.

Dans la rubrique Evénements, on trouvera tout d'abord le compte-rendu de la dernière Journée franco-suisse sur la veille stratégique et l'intelligence économique (la 10ème) qui a eu lieu le 6 juin 2013 à Genève, sur le thème: Veille et marketing de l’innovation : outils et méthodes pour explorer les marchés de demain. Signé par Maurizio Velletri, assistant à la HEG-Genève, et par Hélène Madinier, professeure à la HEG-Genève, il rend compte des interventions relatant les différentes méthodes d’exploration des marchés, parmi lesquelles la prise en compte des idées de clients/partenaires possibles, la rapidité d’action et l’écoute permanente de son environnement.

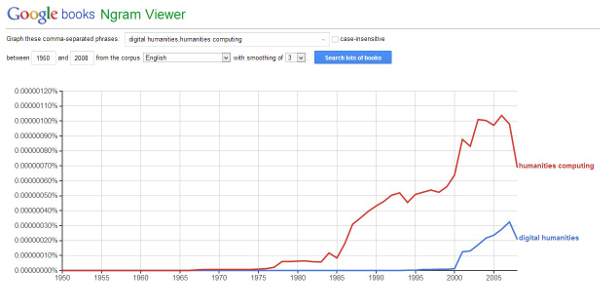

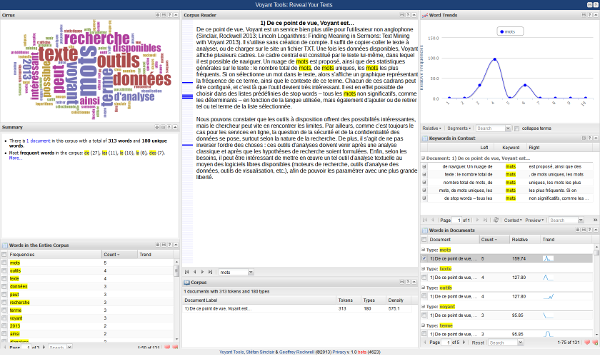

On trouvera ensuite un article signé Igor Milhit et Mathilde Panes, assistants à la HEG- Genève, intitulé Les humanités numériques et les spécialistes en information documentaire : compte rendu de la 1ère Digital Humanities Summer School, 26-29 juin 2013, Berne et synthétisant par thématique les diverses interventions, cours, ateliers et « non-conférences » (unconferences) ayant eu lieu à cette première école d’été suisse sur le sujet. L’article développe aussi les liens entre les humanités digitales et le métier de spécialiste en information documentaire.

On trouvera finalement un dernier compte rendu, intitulé Journée d'étude 2013 : les données en bibliothèques, les enjeux des linked open data. Signé par Pierre Boillat, bibliothécaire principal aux Conservatoire et Jardin botaniques de la Ville de Genève, il présente les différents projets exposés le 1er octobre 2013 à Lausanne sur le web des données libres (traduction de « linked open data ») et leurs implications sur le métier de professionnel de l’information.

Enfin, sous la rubrique Compte-rendu d'ouvrage, on trouvera deux recensions : la première, écrite par Alain Jacquesson, ancien directeur de la Bibliothèque de Genève – et nouveau membre du comité de rédaction de RESSI- rend compte de l’ouvrage Entre lecture, culture et patrimoine. La Bibliothèque de la Ville de la Chaux-de-Fonds 1838-2013 édité par Jean-Marc Barrelet. Cet ouvrage illustré, paru à l’occasion du 175ème anniversaire de la bibliothèque contient dix-sept contributions retraçant l’histoire de la bibliothèque de la Chaux-de-Fonds et la plaçant dans un contexte suisse et international.

La deuxième recension est signée Eric Thivant, docteur ingénieur en sciences de l’information à l’IAE de Lyon et enseignant à l’Université de Lyon 3, et résume l’ouvrage dirigé par Tom D. Wilson Theory in Information Behaviour Research. Cet ouvrage collectif paru en 2013, disponible en format électronique, contient huit essais sur des approches théoriques utilisées pour l’analyse des pratiques informationnelles en contexte.

Nous remercions les auteurs des articles et les réviseurs qui ont contribué à ce numéro et nous invitons les lecteurs à proposer des articles pour les prochains numéros.

Le Comité de rédaction

Projektbericht: Connecting Open Library Systems and Sugar

Brigitte Lutz, Schweizerisches Institut für Informationswissenschaft, HTW Chur

Karsten Schuldt, Schweizerisches Institut für Informationswissenschaft, HTW Chur

Projektbericht: Connecting Open Library Systems and Sugar

1. Projektbeschreibung

Das Projekt COLiSu besteht grundsätzlich aus zwei Teilbereichen: erstens den technischen Fragestellungen und zweitens den Nicht-Softwarebezogenen Fragestellungen, die sich aus der vorgeschlagenen Verbindung ergeben. In Kapitel 1 wird Sugar eingeführt (1.1), anschliessend Freie Bibliothekssysteme besprochen (1.2) sowie die Forschungsfrage des Projektes formuliert (1.3).

1.1 Sugar

Eine der beiden technischen Komponenten des COLiSu-Projektes stellt die Lernoberfläche Sugar dar, welche im Folgenden vorgestellt wird. Sie wurde in der ersten Version für den One Laptop Per Child (OLPC) Computer entwickelt, kann aber auch ohne diesen Rechner verwendet werden. Der von der OLPC-Stiftung - gegründet als Ausgliederung aus einem Forschungsprojekt des Massachusetts Institute of Technology - entwickelte Rechner soll grundsätzlich die Bildungschancen in Ländern des globalen Südens verbessern. (Bashi (2011), Ashling (2010), Riem (2010), Pal (2010), One Laptop per Child (Ohne Jahr)) Dazu wurden an diesen Rechner mehrere Anforderungen gestellt:

- Er soll gleichzeitig möglichst kostengünstig und robust sein. Angestrebt – wenn auch bislang nicht ganz erreicht – wurden Endkosten von 100 US-Dollar. Weiterhin soll der Rechner unter klimatisch und gesellschaftlich schwierigen Bedingungen eingesetzt werden können. So kam der Rechner seit 2007, dem ersten Jahr seines Masseneinsatzes, unter anderem in ländlichen Gegenden Nigerias, der Mongolei, Brasilien und Haitis zur Verwendung.

- Der Rechner soll alle Möglichkeiten moderner Hard- und Softwartechnologie bieten, gleichzeitig möglichst umweltfreundlich hergestellt werden. Dies bedeutet unter anderem, dass explizit Materialien verwendet wurden, die keine geplante Obsoleszenz (Verfall) beinhalteten.

- Grundsätzlich sollen die Rechner ohne weitere Infrastruktur betrieben werden können: Sie können ohne einen Anschluss an das Internet autonom benutzt werden, gleichzeitig wurden Möglichkeiten entwickelt, sie unabhängig vom Stromnetz, beispielsweise mit kleinen Solarzellen oder handbetriebenen Generatoren mit Energie zu versorgen.

Die Entwickler stellten sich vor, dass diese Rechner in einem weit von urbanen Zentren entfernten Gebiet im globalen Süden - zum Beispiel über einem Dorf im brasilianischen Urwald - abgeworfen und dort direkt von den Kindern und Jugendlichen eingesetzt werden können. Ein solches Gedankenexperiment bringt zahlreiche Aufgabenstellungen für die Konstruktion des Rechners, die gelöst werden müssen. OLPC nimmt für sich in Anspruch, diese Probleme grundsätzlich mit dem ersten Modell des Rechners (XO-1) gelöst zu haben, arbeitet allerdings intensiv weiter an der Hardware. Angekündigt ist eine vierte Version (XO-4), erhältlich ist ausserdem ein Tablet. Da die OLPC-Rechner als Teil einer Bildungsinitiative genutzt werden, sind diese weniger im normalen Handel erhältlich, sondern werden überwiegend durch Regierungen verschiedener Staaten in grösseren Stückzahlen abgenommen und im Rahmen von Bildungsprogrammen eingesetzt. Ziel dieser Programme ist es, dass alle beteiligten Schülerinnen und Schüler einen solchen Rechner zur freien Verfügung erhalten und dieser in Schul- und andere Veranstaltungen eingebunden wird. Nur eine kleine Zahl dieser Rechner ist in Ländern des globalen Nordens verbreitet. (Beuermann et al. (2012), Cristia et al. (2012), Barack (2008), Hettich (2008)) Dennoch kann auf der Software dieser Rechner aufgebaut werden.

Die Software des OLPC-Rechners ist den Ansprüchen des Rechners gemäss gestaltet:

- Die Software geht nicht davon aus, dass die Nutzerinnen und Nutzer mit den grundlegenden Konzepten von Betriebssystemen (beispielsweise dem Unterschied zwischen Software und Datei, dem Konzept des Speicherns u.a.) vertraut sind. Gleichzeitig setzt die Software keine vorgängige Alphabetisierung voraus.

- Die Software ist eine Lernsoftware, die auf konstruktivistischer Pädagogik aufbaut. Der Konstruktivismus geht davon aus, dass das Wissen im Lernprozess von den Lernenden selber hergestellt wird und dieser Prozess durch Lehrende und Infrastruktur nur unterstützt, nicht aber vollständig gesteuert werden kann. Die Lernenden selber generieren Wissen, schliessen an schon vorhandenes Wissen an, übersetzen gegebene Informationen und Übungen in ihr eigenes Wissen. Diese Pädagogik stellt die Lernenden und ihre Arbeitsprozesse in den Mittelpunkt. Der Unterricht besteht deshalb vor allem in aktiver Kommunikation, dem eigenständigen Durcharbeiten von Themen und Problemen, zudem gilt die Motivation der Lernenden als Voraussetzung für jeden Lernerfolg.

- Die Software des OLPC-Rechners ist vollständig Open Source. Dies bedeutet auch, dass der Quellcode frei zugänglich ist, sodass es grundsätzlich möglich ist, die Software beliebig fortzuschreiben und anzupassen.

- Die Software funktioniert vereinfacht gesprochen als Oberfläche, die auf einem Betriebssystem aufgesetzt werden kann. Sie ist kein eigenständiges Betriebssystem. In der ersten Version wurde die Oberfläche Sugar auf Basis des Linux-OS geschrieben, welches weiterhin zumeist als Grundlage verwendet wird. Gleichzeitig lässt sich Sugar auch auf Windows, Mac-OS und Android installieren. Die Software ist nicht an die OLPC-Rechner gebunden, sondern kann auf jedem Rechner, auch älteren Datums, laufen. Dies ermöglicht auch, dass sie in Ländern des globalen Nordens mit anderen Rechnern als dem XO in mehreren Projekten in Schulen eingesetzt wurde.

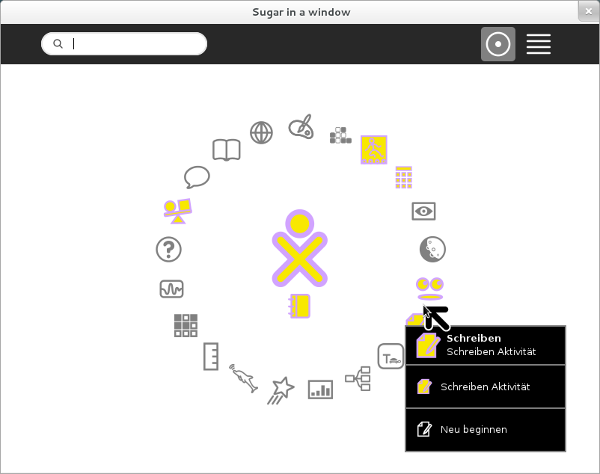

Sugar bietet einige unkonventionelle Lösungen, die aus der Aufgabenstellung heraus leicht verständlich sind.

- Sugar bietet keine spezifischen Programme, sondern Aufgaben. So existiert beispielsweise keine Office-Suite, sondern die Aufgabe “Schreiben”, die bei jedem Aufruf ein Textdokument öffnet, welches direkt bearbeitet werden kann. Analog gibt es Aufgaben wie “Lesen”, “Browsen”, “Malen”, “Aufnehmen” etc. Ebenso kennt Sugar nicht die Funktion des Speicherns. Vielmehr werden alle einmal geöffneten Dokumente im letzten Zustand aufgehoben und können über ein Journal aufgerufen werden. Dieses Vorgehen soll im Vergleich zu konventionellen PC-Programmen dem Denken von Lernenden eher entsprechen – es kann damit verglichen werden, dass ein Text, den man zu schreiben begonnen hat, temporär auf dem Schreibtisch liegen bleibt, um ihn zu einem späteren Zeitpunkt weiter zu schreiben.

- Sugar kann ohne einen Internetanschluss betrieben werden und setzt – obgleich ein Browser vorhanden ist – auf lokale, ad hoc hergestellte Netzwerke aller in Reichweite befindlichen Rechner (MeshNetzwerke). Diese bieten unter anderem den Vorteil, dass sie „selbstheilend“ sind. Das bedeutet, dass die Rechner so vernetzt sind, dass Daten um eine blockierte Verbindung umgeleitet werden, sodass das Netzwerk nach wie vor betriebsfähig bleibt. So ist zum Beispiel die Chatfunktion darauf ausgerichtet, dass sich die Schülerinnen und Schüler in einem Klassenraum vernetzen, wobei die einzelnen Rechner ein eigenes Netzwerk aufbauen. Dies ist in Regionen ohne oder mit schlechter Internetanbindung äusserst sinnvoll, bietet aber auch in anderen Regionen pädagogische Vorteile. So kann eine Schulklasse ohne jede weitere Software kollaborativ arbeiten.

- Die gesamten Funktionen von Sugar sind in einfachen Symbolen dargestellt und bedürfen keiner Schriftkenntnis. Sie sollen sofort von allen Menschen verstanden werden, so dass im Idealfall die Lernenden sich den Umgang mit dem Rechner eigenständig erarbeiten können.

- Obwohl Sugar explizit als Software designt wurde, welche im pädagogischen Kontext benutzt werden soll, gibt es keine Trennung zwischen expliziter Lern- und anderer Software. Vielmehr wird in einer Anzahl von Aufgaben versucht, Spiel und Lerneffekte zu verbinden.

Die Verbreitung von OLPC-Rechnern sowie der Sugar-Plattform ist beachtlich. Das Projekt selber spricht von über 2.4 Millionen verteilten Rechnern. Es existieren in zahlreichen Staaten Communities, die sich mit OLPC und Sugar befassen. (One Laptop per Child (ohne Jahr))

Abbildung 1: Screenshot Sugar, mit der hervorgehobenen Aktivität "Schreiben". Das Journal kann unter der Figur (welche einen Nutzer / eine Nutzerin repräsentiert) aufgerufen werden.

Die Ergebnisse einiger Studien zum Einsatz der Rechner sind hingegen durchwachsen. (Favivar (2012), Kornberger (2010), Meneweger (2010), Luyt (2008), Kenney (2006)) Grundsätzlich kommen sie alle zum Ergebnis, dass der Einsatz von Sugar und OPLC-Rechnern möglich ist und keine negativen Folgen hat. Die grossen Hoffnungen, welche das OLPC-Projekt an den Rechner und seine Wirkungen stellte, scheinen sich allerdings bislang nicht zu erfüllen. Dies hat indes auch damit zu tun, dass mehrere ähnliche Projekte gestartet wurden. (Vergleiche für eine Übersicht über ähnliche Projekte Trucano (2013).) Dennoch sind OLPC-Rechner und Sugar die verbreitetste Hard- und Software, was nicht zuletzt darauf zurückzuführen ist, dass sich dieOLPC-Stiftung äusserst aktiv in der Verbreitung des Rechners zeigt. Da zudem die Entwicklung von Sugar durch die Community vorangetrieben wird (Sugarlabs (ohne Jahr)), ist nicht auszuschliessend, dass es in Zukunft zu einer gesteigerten Nutzung kommen kann.

1.2 Freie Bibliothekssysteme

Innerhalb der letzten Jahre ist eine Anzahl von freien Bibliothekssystemen, also Open Source Lösungen, entstanden. Diese Systeme bieten, wie proprietäre Bibliothekssysteme auch, integrierte Lösungen für alle bibliothekarischen Aufgaben - angefangen vom Bestandsmanagement über die Katalogisierung bis hin zur Ausleihverwaltung, Gestaltung des Internetauftritts und Management von elektronischen Medien. (Macan, Fernández, Stojanovski (2013), Taylor et al. (2013), Vimal, Jasimudeen (2012), Kamble, Raj, Sangeeta (2012) Singh, Sanaman (2012))

Anders als zum Beispiel in der Schweiz sind diese Systeme in vielen Ländern des globalen Südens weit verbreitet. Ebenso findet sich eine Anzahl von Staaten im globalen Norden, in denen diese freien Bibliothekssysteme in den meisten Bibliotheken genutzt werden, insbesondere Koha, welches direkt aus dem neuseeländischen Bibliothekssystem stammt. (Koha (ohne Jahr), Koha Community (ohne Jahr)) Freie Bibliothekssysteme werden dabei nicht nur als billige Lösung von Etat-schwachen Bibliotheken eingesetzt. Eine Reihe von grösseren Bibliothekssystemen, sowohl im öffentlichen als auch wissenschaftlichen Bereich sowie eine Anzahl von Nationalbibliotheken, hat sich für solche Systeme entschieden. Zu nennen sind vor allem die beiden erfolgreichen Systeme Koha, NewGenlib und das von der UNESCO finanzierte ABCD. (Koha (ohne Jahr), Koha Community (ohne Jahr), NewGenLib (ohne Jahr), NewGenLib Forum (ohne Jahr), Dhamdhere (2011))

Die Vorteile dieser Systeme sind neben den geringen Kosten, die sich vor allem auf die technische Infrastruktur beziehen, ihre allgemeine Flexibilität, die Offenheit der Software und die klare Dokumentation ihrer Schnittstellen. Gleichzeitig haben sich um diese Systeme, vor allem um NewGenlib und Koha, Communities gebildet, die wie bei anderer Open Source Software schnelle Beratungen untereinander ermöglichen. (Koha Community (ohne Jahr), NewGenLib Forum (ohne Jahr))

Gleichzeitig bietet solche Software die Möglichkeit, relativ professionell und mit verhältnismäßig wenig Arbeit eigene kleine Bibliotheken zu betreiben. Die Systeme können auf einfachen Servern installiert und betrieben werden, sie führen durch die unterschiedlichen bibliothekarischen Aufgaben und übernehmen Verwaltungsarbeiten, die ansonsten zum Beispiel in Bibliotheken in abgelegenen Schulen von einem nicht-bibliothekarisch ausgebildeten Personal improvisiert durchgeführt würden.

1.3 Projektfrage

Das Projekt COLiSu schlägt vor, diese beiden Softwarekomponenten – Sugar und freie Bibliothekssysteme – miteinander zu verbinden. Dies soll ermöglichen, die Vorteile beider Lösungen produktiv nutzbar zu machen. Über eine technische Verbindung soll aus Sugar direkt auf freie Bibliothekssysteme in verschiedenen Varianten zugegriffen werden können. Dies könnte ein neues Zusammenspiel von Schulen und Bibliotheken bedingen. Im folgenden Abschnitt (2.) werden kurz die zu lösenden technischen Fragen einer solchen Kombination besprochen, anschliessend (Abschnitt 3.) Anwendungsszenarien und inhaltliche Implikationen dieser Kombination vorgestellt.

2. Technische und inhaltliche Fragen

Im Projekt COLiSu stellen sich voneinander zu differenzierende Fragen. Dieser Unterteilung folgt der Abschnitt 2., indem der zuerst die technischen Aspekte (2.1) und anschliessend die inhaltlichen Aspekte (2.2) des Projektes bespricht.

2.1 Technische Aspekte

Die grundlegenden technischen Aspekte des Projektes sind – verglichen mit anderen technisch ausgelegten Projekten – relativ gering. Beide zu verbindende Komponenten sind als Open Source gestaltet, die Schnittstellen sind allgemein gut dokumentiert. So liegen zum Beispiel für Sugar explizit Vorgaben dazu vor, wie Aktivitäten programmtechnisch gestaltet werden sollen. (Anonym (2008)) Ähnliches lässt sich für die freien Bibliothekssysteme sagen. Das dies so einfach erscheint, ist im Konzept von Open Source Software angelegt. Diese Software soll anderen aktiv ermöglichen, in den Code des jeweiligen Projektes direkt Einblick zu nehmen, diesen zu verbessern oder anzupassen. Gleichzeitig soll die Kollaboration zwischen unterschiedlichen Communities gefördert werden. COLiSu schlägt diesbezüglich nur vor, diese Verbindung zwischen bestimmten Communities explizit zu fördern.

Hinzu tritt, dass der Austausch bibliographischer Daten, der eine der wichtigsten Funktionen der vorgeschlagenen Sugar-Aktivitäten darstellen soll, über das standardisierte Austauschformat Machine-Readable Cataloging (MARC) beziehungsweise seine Dialekte funktioniert. Dieser Standard ist in Bibliotheken etabliert und wird von allen freien Bibliothekssystemen genutzt. (Seikela, Steeleb (2011))

Der konkrete Programmierungsaufwand für die einzelnen Komponenten ergibt sich aus den unterschiedlichen Anwendungsszenarien. Deshalb wird im Abschnitt 3. jeweils auf diesen Aufwand der einzelnen Szenarien eingegangen. Festzuhalten ist jedoch, dass sich die Lösungen in allen Fälle grösstenteils auf schon vorhandene Komponenten stützen werden.

Eine interessante Einschränkung, die sich in allen Szenarien stellt, ist der Fakt, dass nicht von einer kontinuierlichen Internetverbindung ausgegangen werden kann. Wie unter 1.1 erwähnt ist Sugar für Rechner gedacht, die keine andauernde Verbindung mit dem Internet voraussetzen. Softwareprojekte in Ländern des globalen Nordens gehen hingegen zumeist davon aus, dass eine solche Verbindung existiert, indem zum Beispiel bei Kataloganfragen auf eine funktionierende Server-Client-Verbindung gesetzt wird.

2.2 Inhaltliche Aspekte und Fragen

Interessant sind beim COLiSu-Projekt die inhaltlichen Fragen: Was passiert, wenn den Schülerinnen und Schülern Zugriff über Sugar auf bibliothekarische Daten und Angebote gegeben wird? Dabei lässt sich nicht nur an Zugriff auf Kataloge, sondern zum Beispiel auch auf Sondersammlungen – zuerst von Lernmaterialien – denken. Wird der Unterricht dadurch für die Lernenden aktiver, da sie neben dem Input der Lehrpersonen weitere Quellen zur Information nutzen und dies direkt im Unterricht einbringen können? Was passiert, wenn freie Bibliothekssysteme und Sugar verbunden werden? Hier drängt sich die Vorstellung auf, dass die technischen Möglichkeiten auch in kleinen, abgelegenen Schulen genutzt werden können, um Schulbibliotheken vergleichsweise professionell zu führen und zu nutzen.

Es sei daran erinnert, dass Sugar vor allem für den Einsatz im globalen Süden entwickelt wurde; dort stellen sich auch weiterreichende Fragen: Schliesst man mit einer solcher Verbindung von Sugar und Bibliothekssystemen Schülerinnen und Schüler, die bislang nicht von Bibliotheken erreicht wurden, an diese Bibliotheken an? Müssen Bibliotheken beginnen, sich Gedanken über die Ausleihe in abgelegene Gebiete zu machen? Wird es Aufgabe von Bibliotheken, besondere Sammlungen von elektronischen Lernmaterialien bereitzustellen und zu pflegen? Motiviert der Einsatz von freien Bibliothekssystemen ein Wachstum von Schulbibliotheken in kleinem Rahmen, die aber relativ hohe bibliothekstechnische Standards haben? Wenn ja, welche Auswirkungen hat dies?

Gleichwohl wird Sugar auch in Schulen des globalen Nordens eingesetzt. (Kornberger (2010), Meneweger (2010)) Zudem kann aus den Ergebnissen anderer Staaten auch für reiche Länder wie die Schweiz gelernt werden. Grundsätzlich eröffnet das Projekt COLiSu zahlreiche Anschlussfragen und potentielle Folgeprojekte. So wäre es zum Beispiel sinnvoll, die Implementation der vorgeschlagenen Verbindung von Sugar und freien Bibliothekssystemen in unterschiedlichen Gebieten aktiv zu begleiten, um die tatsächlichen Konsequenzen zu eruieren. Auch stellen sich pädagogische Fragen, die nur in Zusammenarbeit mit den Erziehungswissenschaften bearbeitet werden können.

3. Anwendungsszenarien und Implikationen

Im Folgenden werden vier Anwendungsszenarien beschrieben, welche auf den im COLiSu-Projekt vorgeschlagenen Verbindungen von Sugar und freien Bibliothekssystemen basieren.

3.1 Szenario: Zugriff auf eine Schulbibliothek

Das erste, einfachste Szenario geht davon aus, dass Schülerinnen und Schüler auf die Bestände einer lokalen Schulbibliothek zugreifen können, die mit freier Bibliothekssoftware betrieben wird. Hierfür notwendig ist neben den Rechnern, welche Sugar nutzen, ein schuleigener Server, auf welchem ein freies Bibliothekssystem betrieben wird. Dies ist allerdings relativ billig und einfach zu bewerkstelligen. Alle dieser Systeme sind daraufhin angelegt, auf einfacher Software zu laufen. Für alle existieren zum Beispiel Anleitungen, wie sie durch ein unkompliziertes Verfahren installiert werden können.

In einem einfachen Anwendungsfall ist dieser Zugriff nur dann ermöglicht, wenn die Schülerinnen und Schüler sich auch in der Schule befinden. Hier wird der Zugriff auf die Daten des Servers in der Schulbibliothek durch das lokale Mesh-Netzwerk hergestellt. Im erweiterten Anwendungsfall wird den Schülerinnen und Schülern ermöglicht, auf den Katalog auch ausserhalb der Schulen zuzugreifen. Dabei ist es nicht möglich, auf eine funktionierende Internetverbindung zu vertrauen. Vielmehr wird ein System entwickelt werden müssen, welches bei Verbindung mit dem Server die notwendigen Daten auf den einzelnen Sugar-Rechner lädt, dort vorhält und zum Beispiel durchsuchbar macht, gleichzeitig Such- und Bestellvorgänge ermöglicht und zu einem späteren Zeitpunkt, wenn wieder eine Verbindung mit dem Bibliotheksserver hergestellt wird – zum Beispiel weil die Schülerin oder der Schüler wieder die Schule besucht – ausführt.

Neben dieser zu lösenden technischen Aufgabe stellt sich die Herausforderung, eine Such-Oberfläche für den Bibliothekskatalog zu gestalten, welche den anderen Aktivitäten von Sugar entspricht und dennoch möglichst komplexe Zugriffe auf die Mediendaten im Katalog ermöglicht. Denkbar ist auch, mehrere Aktivitäten zu gestalten, die mehr oder weniger komplexe Suchmöglichkeiten bieten.

Im Alltag bietet dieses Szenario den Schülerinnen und Schülern die Möglichkeit direkt auf die Medien ihrer Schulbibliothek zuzugreifen, Katalogrecherchen durchzuführen und Leihbestellungen aufzugeben. Sugar ist als zentrales Lern- und Arbeitswerkzeug gestaltet, insoweit bedeutet eine Einbindung des Katalogs einer Schulbibliothek als, neben den anderen Aktivitäten, gleichberechtigtes Element, auch eine direkte Einbindung der Bibliotheken in den Schulalltag. Lehrerinnen und Lehrer können somit Unterrichtsaufgaben auf diese Möglichkeit hin ausrichten.

Zu lösen sind für dieses Szenario folgende technische Probleme:

- Gestaltung einer Aktivität, die den Zugriff auf die Katalog- und Ausleihfunktionen der freien Bibliothekssysteme ermöglicht und sich gleichzeitig in Sugar integriert.

- Diese Aktivität sollte die Speicherung der Rechercheergebnisse ermöglichen.

- Unter Umständen eine Zusammenstellung mehrerer Aktivitäten, welche dies erfüllen, mit unterschiedlichen Komplexitäten (einfache Suche, Expertensuche, starke Facettierung etc.).

- Lokale Speicherung von Katalogdaten, Rechercheergebnissen und Leihanfragen. Aktualisierung dieser Daten und Push – d.h. der automatisch vom Systeme ausgelösten Übertragung – von Leihanfragen, wenn der Rechner sich wieder mit dem Server in einem gemeinsamen Netzwerk befindet.

- Zudem muss eine Möglichkeit der Identifikation der einzelnen Schülerinnen und Schüler im Bibliothekssystem geschaffen werden. Denkbar ist zwar der Zugang über Passwörter, andere Möglichkeiten – beispielsweise die automatisch Identifikation – würden die Nutzungsbarrieren abbauen und die Aktivitäten stärker in die normale Arbeit mit Sugar einbinden.

3.2 Szenario: Betrieb einer Schulbibliothek

Während das erste Szenario davon ausgeht, dass die betreffende Schulbibliothek getrennt von Sugar mit der jeweiligen freien Bibliothekssoftware betrieben wird, lässt sich auch ein Szenario entwerfen, in dem die Schülerinnen und Schüler in die Verwaltung der jeweiligen Bibliothek einbezogen sind.

Grundsätzlich ist bei allen Bibliothekssystemen die Möglichkeit gegeben, Rollen zu definieren. Diese Rollen ermöglichen es, für unterschiedliche Nutzerinnen und Nutzer bestimmte Rechte zu verteilen. So kann festgelegt werden, dass einige Personen nur die Ausleihverwaltung betreiben dürfen, während andere nur die Verwaltung der Medien erledigen können. Hierbei unterscheiden sich die freien Bibliothekssysteme nicht von anderen Bibliothekssystemen. In diesem Szenario sollen eine oder mehrere Aktivitäten entworfen werden, die auf diesen Rollenzuweisungen aufbauen und es zum Beispiel ermöglichen, Schülerinnen und Schülern zu ermöglichen, mit ihren Sugar-Rechnern Aufgaben in der Bibliothek zu übernehmen. Diese Mitarbeit von Lernenden in Schulbibliotheken ist an sich verbreitet; Aufgabe wäre es, diese auch technisch zu ermöglichen.

Grundsätzlich baut dieses Szenario technisch auf dem ersten Szenario auf. Zudem sind folgende Probleme zu lösen:

- Aktivitäten erstellen und gestalten, die auf unterschiedliche Funktionen der freien Bibliothekssysteme zugreifen und es ermöglichen, zum Beispiel die Ausleihe oder die grundlegende Katalogisierung von Sugar aus zu übernehmen.

- Der Zugriff auf die Funktionen der Bibliothekssysteme ist, im Gegensatz zu Katalogdaten, nicht standardisiert. Insoweit werden die Aktivitäten auf den Schnittstellen der unterschiedlichen Systeme aufbauen müssen. Aus diesem Grund lässt sich, zumindest für die erste Programmierung, die Konzentration auf die beiden verbreiteten freien Bibliothekssysteme Koha und NewGenLib begründen. (ABCD ist zwar von seiner Trägerinstitution her interessant, aber wenig in realen Bibliotheken verbreitet.)

3.3 Szenario: Verbindung zu Öffentlicher Bibliothek

Im dritten Szenario wird eine Verbindung von Sugar-Rechnern zu Angeboten einer Öffentlichen Bibliothek vorgeschlagen. Denkbar ist dies nur, wenn zumindest zeitweise eine Verbindung zu dieser Bibliothek – entweder über Internetverbindungen oder die Einspeisung der Bibliotheksdaten in lokale Netzwerke, zum Beispiel über einen Server innerhalb der Schule – hergestellt werden kann. Zudem soll in diesem Stadium davon ausgegangen werden, dass die Öffentliche Bibliothek ein freies Bibliothekssystem verwendet, was allerdings im globalen Süden oft der Fall ist. Da Katalogdaten per MARC ausgetauscht werden lässt sich aber auch daran denken, dass perspektivisch andere Bibliothekssysteme verwendet werden können.

Grundsätzlich ist das dritte Szenario eine Erweiterung des ersten Szenarios. Allerdings integriert es die Öffentliche Bibliothek in das pädagogische Netzwerk der Schule selber. Dadurch würde es zur Aufgabe der Öffentlichen Bibliotheken, Leihbedingungen für Fernleihen in entlegene Schulen zu installieren, Sondersammlungen für die Nutzung in Schulen oder von Schülerinnen und Schülern in deren Freizeit aufzubauen. Grundsätzlich kann man sich vorstellen, dass Öffentliche Bibliotheken, wenn Sugar-Rechner in einer Region verstärkt eingesetzt werden, die Verantwortung übernehmen, die Schulen dieser Region durch eine aktive Bestandspflege zu unterstützen. Eine sinnvolle Erweiterung wird die Pflege von Sammlungen digitaler Lehrmaterialien darstellen.

Zusätzlich zu den im ersten Szenario genannten sind folgende technische Probleme zu klären:

- Die Aktivität sollte, wenn elektronische Medien angeboten werden, die direkte Nutzung dieser Medien ermöglichen. Hierfür stehen andere Aktivitäten – zum Beispiel “Read” für E-Books – zur Verfügung. Zu schaffen wäre eine direkte Verbindung zwischen diesen Aktivitäten.

- Die Aktivität muss die automatische, gleichwohl platzsparende Speicherung dieser elektronischen Medien ermöglichen.

3.4. Szenario: schulinterne Digitale Bibliothek

An das erste und dritte Szenario anschliessend wäre auch eine schulinterne digitale Bibliothek, die von Sugar aus benutzt, ergänzt und gepflegt würde, denkbar. So kann die Schulbibliothek mit elektronischen Medien ergänzt werden, wobei vor allem die Nutzung von Open Educational Ressources sinnvoll erscheint. Eine solche digitale Bibliothek kann sich auch aus anderen Quellen speisen und beispielsweise bei seltener und nie vorhandener Internetverbindung den Schülerinnen und Schülern eine Auswahl elektronischer Medien zur Verfügung stellen. Gleichzeitig kann eine solche Sammlung das Einspeisen von selbst erstellten elektronischen Medien durch die Schülerinnen und Schüler aber auch durch Lehrpersonen oder Bibliotheksverantwortliche motivieren. Angesichts dessen, dass Sugar auf konstruktivistischen pädagogischen Annahmen aufbaut und das eigenständige, spielerische Tun der Lernenden in den Mittelpunkt stellt, wäre eine solche Möglichkeit eine sinnvolle Ergänzung. Möglich wird dieses Szenario nur durch den Betrieb eines eigenen Servers für elektronische Medien in der Schule selber. Allerdings ist auch dies relativ einfach und mit einem geringen finanziellen Aufwand umzusetzen.

Das Szenario vereinigt technisch gesehen das erste und zweite Szenario. Hinzu tritt folgendes zu lösendes Problem:

- In Sugar-Aktivitäten erstellte elektronische Medien müssen schnell und einfach in die schulinterne Digitale Bibliothek integriert werden können.

4. Fazit und zukünftige Entwicklungsmöglichkeiten

Im COLiSu-Projekt wird vorgeschlagen, die Lernplattplattform Sugar technisch mit freien Bibliothekssystemen zu verbinden und die Möglichkeiten dieser Verbindungen zu untersuchen. Grundsätzlich scheint diese Verbindung technisch relativ einfach herzustellen. Interessant sind die sich daraus ergebenden praktischen Fragen für den Einsatz von Sugar und freien Bibliothekssystemen.

Problematisch ist, wie bei vielen anderen Projekten, die finanzielle Frage des Projektes. Während der mögliche Einfluss leicht sichtbar ist, gibt es wenige Töpfe für eine solche Programmarbeit. So sind die meisten Stiftungen in der Schweiz, die sich mit Bildungsfragen oder der Entwicklungshilfe beschäftigen zumeist auf direkt helfende Projekte beschränkt. Dies ist sinnvoll, da die wenigen Mittel zweckmäßig eingesetzt werden sollen, zeigt aber eine gewisse Schwachstelle der Finanzierungsmöglichkeiten. Offenbar ist es nicht vorstellbar, dass mit einer relativ geringen Programmierarbeit, dem Anschluss an schon vorhandene Projekte und einer Unterstützung bei Implementation der Neuerungen, eine grosse Palette von Möglichkeiten zur Verbesserung von Bildungsaktivitäten für zahlreiche Schülerinnen und Schüler weltweit zur Verfügung stehen könnte.

Sollte die Finanzierungshürde genommen werden können, ergeben sich für die Zukunft zahlreiche Anschlussfragen, die in weiteren Projekten bearbeitet werden könnten.

- Die Begleitung der Implementation der Aktivitäten und der damit möglichen Veränderungen in unterschiedlichen Gebieten und für die unterschiedlichen Szenarien.

- Die Untersuchung der tatsächlichen Effekte dieser Implementationen in Schulen, Schulbibliotheken, Bibliotheken und Communities.

- Die Begleitung des Aufbaus von Programmen von Bibliotheken zur Unterstützung von abgelegenen Schulen. Dabei ginge es weniger darum, die Bibliotheken zu verändern, sondern eher die Stellung der Bibliotheken in den Communities zu untersuchen und sie dabei zu unterstützen, diese Stellung zu verändern.

- Die Begleitung des Aufbaus und des Betriebs von Schulbibliotheken oder digitalen Sammlungen.

- Die Frage, wie diese Möglichkeiten im globalen Norden genutzt werden können.

- Die Ausweitung auf andere Bibliothekssysteme oder Lernplattformen.

Literatur

[Letzter Aufruf der URLs: 08.10.2013]

Anonym (2008) / Activity Handbook: How to get started with software development for the OLPC XO. (Ohne Ort): OLPC Austria, http://wiki.sugarlabs.org/images/5/51/Activity_Handbook_200805_online.pdf

Ashling, Jim (2010) / Laptops Bridge Gap in Structured Learning. In: InformationToday 27 (2010) 8, 22-23

Barack, Lauren (2008) / My Daughter Meets the XO. In: School Library Journal, http://www.schoollibraryjournal.com/slj/printissuecurrentissue/859515-42...

Bashi, Pantea (2011) / Digitale Ungleichheit? : One Laptop Per Child: Anspruch und Wirklichkeit. München : AVM, 2011

Beuermann, Diether W. ; Cristia, Julián P. ; Cruz-Aguayo, Yyannu ; Cueto, Santiago ; Malamud, Ofer (2012) / Home Computers and Child Outcomes : Short-Term Impacts from a Randomized Experiment in Peru (IDB Working Paper Series, 382). (Ohne Ort) : Inter-American Development Bank, 2012

Cristia, Julián P. ; Ibarrarán, Pablo ; Cueto, Santiago ; Santiago, Ana ; Severín, Eugenio (2012) / Technology and Child Development : Evidence form the One Laptop per Child Program (IDB Working Paper Series, 304). (Ohne Ort) : Inter-American Development Bank, 2012

Dhamdhere, Sangeeta Namdev (2011) / ABCD, an open source software for modern libraries. In: Chinese Librarianship: an International Electronic Journal, (2011) 32, http://www.iclc.us/cliej/cl32dhamdhere.pdf

Dent, Valeda Frances (2006) / Modeling the rural community library : Characteristics of the Kitengesa Library in rural Uganda. In: New Library World 107 (2006) 1220/1221, 16-30

Farivar, Cyrus (2012) / Step 1: give every kid a laptop. Step 2: learning begins?. In: arstechnica.com, 09.02.2012, http://arstechnica.com/business/the-networked-society/2012/02/step-one-g...

Hettich, Nils (2008) / Internetzugang für Schulen in Entwicklungsländern : In Verbindung mit der Initiative „One Laptop Per Child“. Saarbrücken : VDM Verlag, 2008

Kamble, V.T: ; Raj, Hans ; Sangeeta, Sangeeta (2012) / Open Source Library Management and Digital Library Software. In: DESIDOC Journal of Library & Information Technology 32 (2012) 5, 388-392

Kenney, Brian (2006) / One Child, One Laptop : Is this our chance to help change the world?. In: School Library Journal 52 (2006) 8, 11

Koha (ohne Jahr) / http://www.koha.org/

Koha Community (ohne Jahr) / http://koha-community.org/

Kornberger, Angelika (2010) / Das OLPC-Projekt (‘One Laptop per Child‘) unter dem besonderen Aspekt des Mathematikunterrichts (Eingereicht an der Pädagogischen Hochschule Steiermark zur Erlangung des akademischen Grades Bachelor of Education (Bed)). Graz : Pädagogische Hochschule Steiermark, 2010

Luyt, Brendan (2008) / The One Laptop Per Child project and the negotiation of technological meaning. In: First Monday 13 (2009) 6, http://firstmonday.org/htbin/cgiwrap/bin/ojs/index.php/fm/article/viewAr...

Macan, Bojan ; Fernández, Gladys Vanesa ; Stojanovski, Jadranka (2013) / Open source solutions for libraries: ABCD vs Koha. In: Program: electronic library and information systems, 47 (2013) 2, 136 – 154

Meneweger, Magdalena (2010) / Das OLPC-Projekt (‘One Laptop per Child‘) unter dem besonderen Aspekt des Deutschunterrichts (Eingereicht an der Pädagogischen Hochschule Steiermark zur Erlangung des akademischen Grades Bachelor of Education (Bed)). Graz : Pädagogische Hochschule Steiermark, 2010

NewGenLib (ohne Jahr) / http://www.verussolutions.biz/web/

NewGenLib Forum (ohne Jahr) / http://forums.newgenlib.org/

One Laptop per Child (ohne Jahr) / http://one.laptop.org/

Pal, Joyojeet (2012) / The machine to aspire to: The computer in rural south India. In: First Monday 17 (2012) 2, http://www.firstmonday.org/htbin/cgiwrap/bin/ojs/index.php/fm/article/vi...

Riem, Ulrich (2010) / One Laptop per Child: Überlegungen zum entwicklungspolitischen Anspruch einer technischen Innovation und ihrer Governance. In: Aichholzer, Georg ; Bora, Alfons ; Bröchler, Stephan ; Decker, Michael ; Lattzer, Michael (Hrsg.) / Technology Governance : Der Beitrag der Technikfolgenabschätzung (Gesellschaft – Technik – Umwelt, Neue Folge, 13). Berlin : edition sigma, 2010, 129-141

Seikela, Michele ; Steeleb, Thomas (2011) / How MARC Has Changed: The History of the Format and Its Forthcoming Relationship to RDA. In: Technical Services Quarterly Volume 28 (2011) 3, 322-334

Singh, Manisha ; Sanaman, Gareema (2012) / Open source integrated library management systems: Comparative analysis of Koha and NewGenLib. In: The Electronic Library 30 (2012) 6, 809 - 832

Stranger-Johannessen, Espen (2009) / Student Learning through a Rural Community Library : A case study from Uganda (Master of Philosophy in Comparative and International Education). Oslo : University of Oslo, 2009. http://eprints.rclis.org/bitstream/10760/13127/1/Espen%27s_thesis_finish...

Sugarlabs (ohne Jahr) / http://sugarlabs.org/

Taylor, Sally; Jacobi, Kristin; Knight, Elizabeth; Foster, Dale (2013) / Cataloging in a Remote Location: A Case Study of International Collaboration in the Galapagos Islands. In: Cataloging & Classification Quarterly51 (2013) 1-3, 168-178

Trucano, Michael (2013) / Big educational laptop and tablet projects -- Ten countries to learn from. In: EduTech, http://blogs.worldbank.org/edutech/big-educational-laptop-and-tablet-pro...

Vimal, Kumar V. ; Jasimudeen, S. (2012) / Adoption and user perceptions of Koha library management system in India. In: Annals of Library and Information Studies (ALIS), 59 (2012) 4, http://eprints.rclis.org/18198/

La gouvernance des documents électroniques dans l’administration cantonale genevoise : genèse et mise en œuvre

Anouk Dunant Gonzenbach, Archives d'État de Genève

La gouvernance des documents électroniques dans l’administration cantonale genevoise : genèse et mise en œuvre

Le patrimoine informationnel d'une institution confirme les droits des personnes physiques ou morales, répond aux obligations légales, renseigne sur des questions essentielles, permet la prise de décision et appuie la réflexion et l'analyse. En bref, il permet une bonne gouvernance de l'Etat. Dans l’administration genevoise, les documents sous forme papier sont adéquatement traités, classés et conservés grâce aux outils de gestion de l'information mis en place par les archivistes de département et les Archives d'Etat.

Mais aujourd'hui, les processus de travail ont changé: les documents papier deviennent électroniques et ne sont plus systématiquement imprimés. Ils sont classés dans des systèmes de gestion électronique de documents (GED), des arborescences ou des systèmes d’information métier et conservés sur les serveurs de l'Etat. Néanmoins, l'administration doit pouvoir retrouver facilement ces documents et les traiter tout en garantissant leur authenticité pendant tout leur cycle de vie. La protection des données personnelles et la sécurité de l'information doivent également être assurées. Comment répondre à ces nouveaux défis? C'est le sujet de cet article, qui est une première synthèse de ce projet que nous continuons de poursuivre. Il présentera tout d'abord les Archives d'Etat de Genève, leur implication dans le projet de gestion des documents électroniques et enfin la politique de gouvernance des documents électroniques de l'administration cantonale.

1. Les Archives d'Etat de Genève

Les Archives d'Etat de Genève, institution d'archives cantonales, ont pour mission de veiller à la constitution, à la gestion et à la conservation des archives publiques dans leur ensemble et plus particulièrement à celles des archives historiques, et de les mettre à la disposition du public (chercheurs, généalogistes, journalistes, historiens, étudiants, politiques, etc.).

Au sein de leurs trois dépôts principaux, dont le principal est l'Ancien Arsenal, en face de l'hôtel de Ville, les Archives d'Etat conservent, du plus ancien au plus récent: les archives du Moyen Age provenant de l'époque précédant la Réforme, où les seigneuries exerçaient le pouvoir aussi bien temporel que spirituel dans la ville et dans ses possessions de la campagne, les mandements; les archives de l'ancienne République de Genève, depuis 1536 jusqu'en 1798; les archives de l'époque du Département du Léman, de 1798 à 1813 et enfin les archives du canton de Genève, dès 1814, issues des trois pouvoirs, législatif, exécutif et judiciaire. A cela s'ajoutent les documents de provenance privée, soit des archives de familles, de sociétés, d'associations ou d'entreprises.

Ces documents représentent un volume d'environ 29 km linéaires, depuis le plus ancien, daté de 913 jusqu'à aujourd'hui. Les Archives sont ouvertes gratuitement au public.

Une bibliothèque consultative abondamment fournie en ouvrages sur l’histoire de Genève et l'histoire régionale permet de faciliter les recherches et complète l’offre documentaire, avec comme autre point fort l'histoire de la Réforme.

2. La problématique des archives nées numériques

La transition vers le numérique est désormais effectuée. Aujourd'hui, l'information est créée, enregistrée et transmise électroniquement; les formats numériques remplacent les supports traditionnels tels que le papier. Or la conservation de l'information sous forme numérique est beaucoup plus complexe que la conservation sous forme papier ou microfilm. Les documents électroniques ont une grande vulnérabilité au temps et ont pour caractéristique les formats et supports les moins durables de l'histoire. Un cd par exemple a une durée de vie d’une dizaine d’années. On peut affirmer aujourd’hui qu'un objet numérique créé sans précautions particulières ne pourra plus être lu d'ici une quinzaine d'années.

La mission des Archives d'Etat, elle, n'a pas changé: les documents électroniques qui ont une valeur juridique, patrimoniale, économique ou historique doivent être conservés sur le très long terme. C’est un défi que doivent relever les Archives d’Etat, à l’instar de toutes les institutions d’archives. C’est ainsi qu’est né le projet Gal@tae.

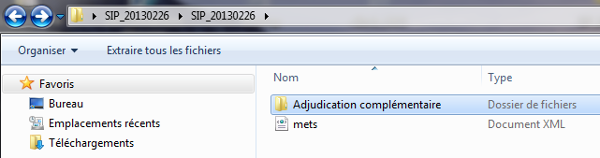

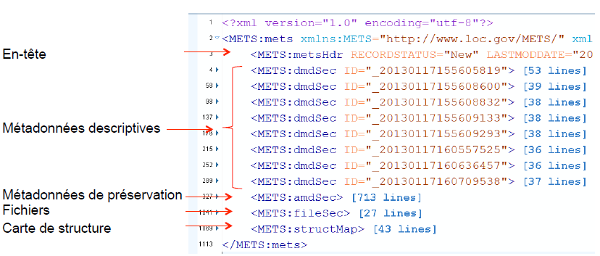

3. Le projet Gal@atae d'archivage à long terme des documents électroniques

Les Archives d'Etat ont mené entre 2011 et 2013 un projet pilote d'archivage électronique à très long terme, nommé Gal@tae (Genève : archivage à long terme d’archives électroniques). L'objectif de ce projet était de mettre en place tous les éléments permettant un archivage électronique pérenne des documents, de la création dans un système d’information métier de paquets de données électroniques à archiver au dépôt sur la plate-forme de pérennisation des Archives fédérales suisses, en passant par les étapes de transfert et de contrôle de qualité aux Archives d’Etat. Ce projet pilote a permis de développer les compétences en matière d'archivage électronique pour les Archives d'Etat et les informaticiens, de mettre en place les procédures et processus permettant d'assurer cet archivage pérenne et de tester la solution technique. Il s'est conclu avec succès et la prochaine étape est la mise en production de la solution(1).

4. De l'archivage électronique à long terme à la gouvernance des documents

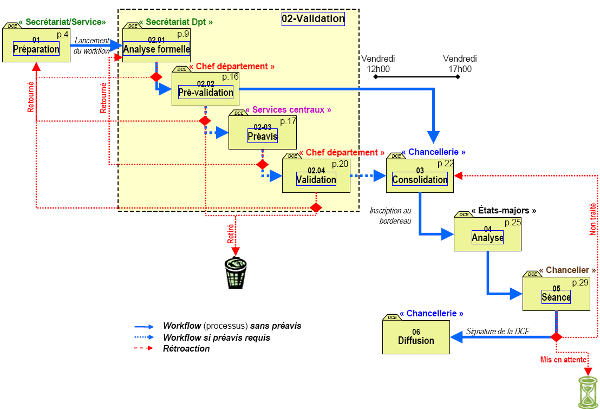

L'objectif de l'archivage à long terme des documents électroniques a été défini par l'ensemble des institutions d'archives suisses faisant partie du Centre de coordination pour l'archivage à long terme des documents électroniques (CECO): il s’agit de "[…] faire en sorte que les documents électroniques restent durablement compréhensibles et que leur authenticité, leur intégrité et leur accessibilité soient garanties"(2). Pour recevoir de la part de l'administration des documents et données électroniques archivables, c’est-à-dire intègres, authentiques, fiables et exploitables, intervenir en amont de la production documentaire est indispensable. En effet, il est important de s’assurer que les éléments nécessaires à la prise en charge du cycle de vie du document lors des étapes postérieures (de sa création à son archivage définitif en passant par sa modification et sa validation) sont pris en compte et complétés à chacune de ces interventions. Le rattrapage a posteriori s’avère lourd, parfois impossible. Le suivi de ces exigences tout au long du cycle de vie du document en facilitera grandement l’archivage définitif. Ce projet a donc mis en évidence l'importance de gérer correctement les documents et données électroniques dès leur création et de réfléchir au cycle de vie des documents dès la mise en place d’un nouveau système d'information.

Ainsi le projet d’archivage à très long terme des Archives d'Etat, prévu dans un but patrimonial et de recherche avec le souci d'assurer la conservation des sources électroniques pour l'avenir, a fait aborder l'angle du gestionnaire : comment l'Etat doit-il traiter ses données électroniques? Le document électronique, qu'il soit archivé ou non à la fin de son cycle de vie, doit être géré et conservé correctement pendant sa durée de vie dans l'administration. Les problématiques se recoupent en effet pour le moyen et le long terme: l'intégrité, l'authenticité, la gestion des droits d'accès, etc.

Les Archives d'Etat de Genève ont ainsi fait le choix de s'impliquer tout au long du cycle de vie du document, de la création des systèmes d'information à l'archivage des documents électroniques.

Genèse du projet

Pour mener à bien le projet d'archivage électronique Gal@tae, les Archives d'Etat ont décidé de travailler avec des groupes ayant des compétences et des responsabilités en matière de systèmes d'information. Elles ont ainsi fait valider chacune des étapes de leur projet par le Collège spécialisé des systèmes d'information, un organe de haut niveau réunissant les directeurs informatiques de chaque département, présidé par le directeur de la Direction générale des systèmes d'information de l’Etat (DGSI). Lorsque ce collège a mandaté un groupe de travail pour réfléchir aux questions liées à la GED dans l'administration, il l'a placé assez naturellement sous la présidence de l'archiviste d'Etat au vu des travaux précédents. Ce groupe de travail, composé d'archivistes et d'informaticiens, a reçu un cahier des charges dont l’un des objectifs initiaux était de réfléchir à un nouvel outil de GED. Il lui est cependant vite apparu qu'avant de fournir des solutions et des réponses techniques, il était indispensable d'établir un cadre général pour la gestion des documents électroniques au sein de l'administration cantonale.

5. La politique de gouvernance des documents électroniques

C'est ainsi qu'a été rédigée la politique de Bonne gouvernance des documents électroniques au sein de l'administration. Nous avons souhaité avoir la garantie que ce document soit conforme aux pratiques professionnelles en vigueur, c'est pourquoi nous l'avons soumis au comité Records Management de l'Association eCH, au comité Records Management de l'Association des archivistes suisses ainsi qu’au Centre suisse de coordination pour l'archivage à long terme des documents électroniques. Ces trois instances ont reconnu la conformité de ce document, qui a été validé en février 2013 par le Collège spécialisé des systèmes d'information. Depuis lors, l'administration cantonale est dotée d'une politique de gouvernance des documents électroniques.

Ce document définit tout d’abord plusieurs termes. En effet, le vocabulaire dans le domaine des systèmes et applications de gestion des documents électroniques est encore volatile et les prestataires de service et de solutions n'utilisent pas forcément les mêmes définitions que les professionnels en science de l'information ou les juristes. Ainsi en est-il du mot "archivage", utilisé couramment dans le domaine informatique pour signifier une durée de vie d'une dizaine d'années ou du mot « copie » qui n’a pas le même sens pour un juriste ou un informaticien.

La Gouvernance des documents électroniques a pour but d'exposer les objectifs d'une bonne gestion des documents électroniques pendant leur durée de vie administrative et légale (autrement dit de leur création à leur sort final, qui est la conservation ou l'élimination définitive). Elle vise également à démontrer les avantages liés à de bonnes pratiques ainsi que les risques encourus si celles-ci ne sont pas appliquées. Ce document présente le cadre légal et normatif ainsi que les éléments fondamentaux en matière de gestion des documents électroniques et en décrit le processus général. Nous allons détailler ces points ci-dessous. Il est également important de préciser que les exigences fonctionnelles et les directives techniques sont exclues du document mais en constituent des annexes, et que le texte ne se réfère pas à un outil existant.

Les objectifs sont formulés de la manière suivante:

- rendre l'administration plus performante

- faciliter le travail des collaborateurs

- garantir la valeur légale des documents qui le nécessitent

- répondre aux exigences légales.

Le cadre légal

Le cadre légal en matière de document numérique provient de différentes sources : le droit fédéral, le droit cantonal (dont la loi sur la protection des données) et les lois et règlements spécifiques aux métiers. Pour ce qui est de la valeur légale -ou probante- du document électronique, on se réfère aujourd'hui au code civil suisse, essentiellement aux articles 130 et 177 (accessoirement 139 et 143) qui définissent qu’un document électronique est recevable à titre de preuve. Ainsi, de facto, le document électronique possède la même valeur probante qu’un document papier. Dans l’Ordonnance concernant la tenue et la conservation des livres de comptes (OLICO), le législateur a consacré au niveau fédéral la valeur légale du document électronique, pour autant que certaines conditions soient remplies. Il faut retenir parmi ces conditions, et nous y reviendrons, l'importance de la documentation des processus, l'authenticité, la fiabilité et l'intégrité du document électronique.

Le cadre normatif

Il existe plusieurs normes relatives à la gestion des documents électroniques, dont trois sont essentielles: la norme ISO 15489 de records management, le recueil d’exigences MoReQ (Modular Requirements for Records Systems) spécifiant les exigences fonctionnelles pour un système d’archivage électronique à valeur probante et enfin la norme ISO 14641 sur l'archivage électronique, entendu ici comme archivage pendant la durée de vie légale d'un document. Les standards eCH en matière de cyberadministration suisse doivent également être pris en compte. Ces normes et standards sont brièvement exposés dans le document et détaillés dans une annexe.

Le processus général

La garantie de l'authenticité d'un document repose plus sur la qualité des procédures et processus mis en place, autrement dit de l'organisationnel, que sur l'outil technique. Il faut ainsi prévoir les processus dès le départ et éviter la tentation de choisir un outil et de se reposer entièrement sur lui. Il est néanmoins nécessaire de préciser que tous les documents n’ont pas la même portée. Ils ne relèvent donc pas tous des mêmes exigences légales et, par conséquent, des mêmes obligations en matière de conservation. Un travail d'analyse préalable pour chaque série de documents est indispensable.

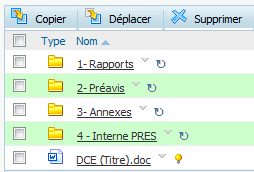

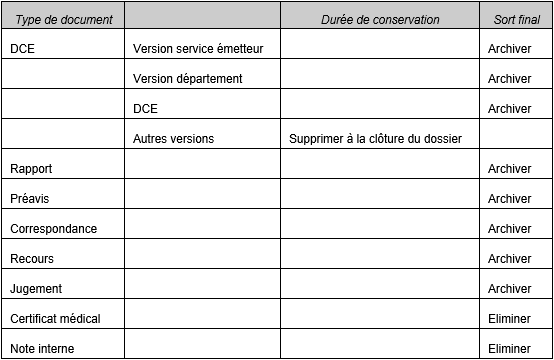

Le processus général, qui doit être adapté à chaque besoin métier, peut de manière simplifiée se schématiser ainsi: le service produit et reçoit numériquement des documents électroniques ou dématérialise des dossiers papier. A la création du document, des métadonnées (dont la durée d'utilisation administrative et légale et le sort final) sont associées à ce document électronique; cette opération est généralement automatisée. A sa validation (stade définitif d'élaboration), le document est nommé correctement et son format transformé en un format d'archivage. S'il faut conserver à ce document sa valeur probante, il est alors transféré dans un coffre-fort électronique. Au terme de sa durée d'utilité administrative et légale, le document est soit détruit, soit versé aux Archives d'Etat, selon le sort final qui lui a été attribué.

6. Les clés d'une bonne gestion des documents électroniques

Notre document met en exergue les clés d'une bonne gestion des documents électroniques. Chaque point fait l'objet d'une directive, qui constitue une annexe.

Le calendrier de conservation

Le calendrier de conservation est un outil essentiel pour gérer le cycle de vie des documents. Il s'agit fondamentalement d'une liste déterminant pour chaque série de documents une durée de conservation et un sort final (destruction ou versement aux archives définitives). En déterminant ces deux éléments, le calendrier permet de libérer de la place dans les espaces de stockage et de répondre aux exigences de la Loi sur l'information du public, l'accès aux documents et la protection des données personnelles (LIPAD, A 2 08), qui requiert que les documents contenant des données personnelles sensibles soient détruits au terme de leur durée d'utilité légale.

Les métadonnées

Les Archives d'Etat et le secteur Environnement documentaire et collaboratif de la DGSI ont élaboré une liste de métadonnées résultant des besoins liés à la bonne gestion des documents électroniques dans l'administration et de ceux liés à l'archivage électronique à long terme. Cette liste comporte un jeu de vingt-neuf métadonnées dont huit sont obligatoires (parmi elles, la durée de conservation et le sort final); elle offre parallèlement la possibilité d'ajouter des métadonnées supplémentaires pour les besoins métier particuliers. Ces métadonnées sont conformes aux normes de Records Management et le format de date exigé répond à la norme ISO 8601. Ce "recueil de métadonnées Etat de Genève" est en vigueur depuis le mois d'octobre 2011; depuis lors, il est utilisé lors de tout nouveau projet de GED.

Les formats

La question des formats est critique, car elle constitue un point particulièrement difficile à résoudre dans la perspective de la conservation à moyen et à long terme de l'information. Les évolutions techniques sont si rapides qu'il est difficile de présager la solution qu'il faudra adopter. C'est pourquoi il est raisonnable de conserver les données dans des formats répondant à des critères définis. Les documents numériques doivent être enregistrés dans des formats les plus pérennes possibles dès leur production; ils seront ensuite au besoin migrés régulièrement. Les Archives d'Etat ont produit une liste de formats de fichiers adaptés à l'archivage électronique à moyen et long terme. Le nombre de formats acceptés est restreint. En effet, un petit nombre de formats soigneusement sélectionnés et contrôlables garantit de manière plus sûre leur lisibilité sur le long terme qu'une grande quantité de formats dont l'entretien sera complexe et onéreux. Les formats choisis dans notre liste correspondent principalement aux critères d'ouverture et d'indépendance. Un format ouvert doit avoir une documentation complète et accessible à tous. C'est à partir de cette documentation qu'il sera possible d'écrire un programme pour lire les données ou les convertir vers un autre format.

Le nommage des fichiers et des répertoires

Les contraintes d'ordre technique ainsi que l'utilisation d'arborescences informatiques communes ont permis de montrer les enjeux liés au choix du nom de dossier et de fichier. Des règles de nommage précises sont nécessaires pour repérer et identifier plus facilement les documents recherchés, éviter les problèmes lors de transfert et de partage et permettre leur conservation à moyen et long terme. Un nom doit être unique et significatif. Des règles doivent donc s'appliquer pour permettre à un document d'être reconnu dans les différents environnements existants et d'être identifiable (ce qui signifie qu'il n'est pas nécessaire d'ouvrir un document pour savoir de quoi il s'agit).

Nous avons alors établi une liste de règles et de recommandations découlant des objectifs suivants: garantir l'accessibilité du document, éviter les problèmes techniques, faciliter la recherche et assurer une bonne gestion des documents. Par exemple: éviter les caractères spéciaux, ne pas utiliser de mots vides comme "le, la, une", ne pas utiliser les signes diacritiques, choisir un nom court et significatif, etc.

Nous avons également produit une typologie des séries des principaux documents de l'administration genevoise en proposant une abréviation pour chacune (A pour "arrêté", AP pour « avant-projet », etc.).

La liste des recommandations peut être adaptée, et chaque département est libre de préconiser ses propres pratiques dans ce cadre.

Il faut relever ici que la validation de cette liste de règles et de recommandations par le Collège des directeurs informatiques a soulevé certaines réticences, notamment lorsqu'il s'est agi d'imposer le format de dates ISO (AAAAMMJJ ou AAAA_MM_JJ). Cette question touche des pratiques quotidiennes qu'il n'est pas facile de modifier ou de faire évoluer.

Le coffre-fort électronique

Le coffre-fort électronique est la seule façon d’assurer l’authenticité, la fiabilité et l'intégrité du document électronique, et donc sa valeur probante.

On entend par :

- authenticité : il peut être prouvé que le document est bien ce qu’il prétend être, qu’il a bien été créé ou envoyé par la personne qui l’a créé ou envoyé et qu’il a bien été créé ou envoyé à la date indiquée

- fiabilité : le document est bien la représentation complète et fidèle de l’opération ou des opérations qu’il atteste (traçabilité)

- intégrité : le document est complet, non altéré et protégé contre toute modification non autorisée ; il n’est pas modifié sans qu’on puisse le constater.

Tous les documents ne nécessitent pas de telles conditions de sécurité, c’est pourquoi l'évaluation des séries documentaires est indispensable. Il est important de bien comprendre ici la différence entre un système d'information métier ou une GED et coffre-fort électronique:

Un système d'information métier / une GED:

- permet la modification des documents, la production et la gestion de plusieurs versions

- permet des mises à jour constantes (données non figées)

- peut permettre la destruction des documents

- peut comprendre un contrôle des durées de conservation

- peut comprendre une structure organisée de stockage, sous le contrôle des utilisateurs

- est a priori dédié à la gestion quotidienne des documents pour la conduite des affaires

- ne garantit pas la valeur probatoire des documents.

Un coffre-fort électronique:

- interdit la modification des documents une fois ceux-ci validés

- contient des données figées

- interdit la destruction des documents

- comprend obligatoirement un contrôle rigoureux des durées de conservation

- comprend obligatoirement une structure rigoureuse de classement (plan de classement) gérée et contrôlée par l'administrateur

- garantit l'authenticité des documents et leur traçabilité.

Les fonctionnalités que doit couvrir un coffre-fort électronique sont décrites dans la norme ISO 14641-1.

Dématérialisation, chaîne de numérisation et mise en GED

Les processus de dématérialisation des documents et leur mise en GED doivent être documentés pour éviter tout conflit ultérieur et toutes les opérations doivent être tracées. Il est ainsi nécessaire de rédiger des procédures et protocoles couvrant toute la chaîne de numérisation afin de s'assurer que les dossiers sont intégralement numérisés et que le processus de numérisation est fiable dans son entier. Cette documentation doit être rassemblée au même endroit et tenue à jour.

Analyse des risques liés au document électronique et à sa sécurité

Les aléas auxquels sont exposés l'information et les systèmes de gestion des documents sont particulièrement nombreux. Afin de définir précisément ces risques, d'identifier leurs causes et de proposer des actions visant à les contrer ou à les limiter, nous avons établi, en collaboration avec le contrôle interne du département de la sécurité, une cartographie des risques liés au document électronique à tous les stades de son cycle de vie. Ces risques relèvent notamment des atteintes potentielles à la confidentialité, à l'intégrité, à la disponibilité et à l'authenticité des documents et données et cette cartographie met en évidence les enjeux financiers, légaux et d'image liés à ces risques.

7. La question de la valeur probante des documents électroniques

Une question récurrente se pose désormais pour la plupart des projets de gestion des documents : « mon service souhaite dématérialiser les processus et les documents et numériser les dossiers papier. Pouvons-nous ensuite détruire les documents papier pour gagner de la place ? » A ce stade, ni les Archives d’Etat ni la DGSI ne pouvaient répondre à cette question, qui sous-entend celle de la valeur probante des documents numérisés et nés-numériques. C’est pourquoi la DGSI a mandaté une société externe pour obtenir une évaluation de l’existant, en lui donnant la mission de valider la conformité des processus et procédures générales et des outils mis en place par rapport aux exigences légales et normatives en matière de numérisation et d’archivage électronique à valeur probante et, si nécessaire, de recommander les évolutions fonctionnelles, techniques et organisationnelles à mettre en œuvre.

Cette étude a permis de mettre en évidence que la plate-forme de dématérialisation et de GED de l’administration offre en standard une couverture fonctionnelle très complète qui répond parfaitement aux besoins métiers mais s’avère insuffisante pour garantir la valeur probante des documents à forte valeur légale. En effet, cette valeur probante ne peut être assurée en l’état que par l’utilisation d’une fonction de « coffre-fort électronique ». La conclusion de cette étude rappelle également l’importance de documenter les procédures et processus et de conserver soigneusement cette documentation, que ce soit la documentation technique ou les processus et la documentation métier.

Les résultats de cette étude, rendus en septembre 2013, ne sont au final que peu surprenants et confirment les besoins mis en évidence dans la Bonne gouvernance des documents électroniques. Il s’agit maintenant de mettre en œuvre ses recommandations afin de pouvoir garantir un archivage à valeur probante dans l’administration genevoise.

Il est nécessaire de relever à nouveau que ce niveau de sécurité n’est pas nécessaire pour toutes les séries documentaires produites et qu’il est donc important d’évaluer pour chacune s’il est nécessaire ou non de mettre en place de telles mesures.

8. Communication liée au projet de gouvernance des documents électroniques

Tout au long du projet, nous avons informé les différents intervenants des nouveaux documents mis à disposition (recueil de métadonnées, catalogue des formats d’archivage, etc.). Des séances ont eu lieu avec les chefs de projets de la DGSI. La problématique a fait l’objet de présentations devant divers publics : forum des archivistes genevois, Centre suisse de coordination de l’archivage (CECO), Groupe de coordination de l’archivage, Commission consultative LArch-LIPAD.

Retours sur les documents produits

Au fil des réunions et des échanges avec les chefs de projets, il ressort que ces derniers sont satisfaits de disposer des documents relatifs à la gestion des documents électroniques. Le recueil de métadonnées, par exemple, répondait à un besoin avéré et évite aux chefs de projets de se poser les mêmes questions lors de chaque projet et de chaque fois réinventer la roue.

Check-list relative à la gestion des documents électroniques

Pour simplifier le travail des chefs de projets et pour les orienter sur toutes ces questions, notre groupe de travail a produit à leur intention une liste de points relatifs à la gestion des documents électroniques. La méthode de gestion des projets dans le domaine des technologies de l'information utilisée à l'Etat de Genève est la méthode Hermès, développée par la Confédération. Nous avons obtenu qu'à un stade précis du développement du projet, au point dit "de cohérence", le chef de projet doive répondre aux questions posées par cette liste (par exemple: l'archiviste de département et/ou les AEG ont-ils été consultés sur ce projet? Le système d'information (SI) peut-il garantir l'authenticité, la fiabilité, l'intégrité et l'exploitabilité des documents à forte valeur légale? Les documents et/ou données concernés par le SI sont-ils pourvus de délais de conservation? Les métadonnées obligatoires sont-elles implémentées? Les Archives d'Etat ont-elles été consultées pour déterminer si le SI contient des documents et/ou données qui devront être conservés à long terme?).

9. La suite de nos travaux

Nous avons constaté qu’il n’est pas forcément évident pour un chef de projet informatique de définir les besoins en matière de gestion des documents électroniques lors de la mise en place d’un projet. C’est pourquoi nous nous attelons à la rédaction d’un vade-mecum rassemblant de manière très succincte l’ensemble des questions auxquelles un chef de projet est confronté lors de la mise en place d’un nouveau système d’information. Ce guide devra également permettre d’exprimer les besoins métier de manière claire et de choisir une solution adaptée aux besoins du service qui en fait la demande.

Il est également nécessaire de fournir un modèle de documentation de procédures de chaînes de dématérialisation et de mise en GED. En effet cette documentation est l’un des points principaux pour garantir la valeur probatoire d’un document et, à notre connaissance, il n’existe pas de modèle de ce type en Suisse, ou en tous les cas pas dans une administration cantonale.

Conclusion

En tant qu’institution cantonale d’archives, notre démarche relative à la conservation à très long terme des documents électroniques nous a donc conduits à la problématique de la gestion des documents électroniques au sein de l’administration. Ces réflexions, au départ théoriques, ne sont pas des priorités, il faut l’avouer, d’autant qu’il s’agissait au départ de questionnements sur des aspects qui ne posaient pas encore problème. Les premières réactions à nos actions, qui se voulaient anticipatrices, étaient plutôt de dire « on verra bien ». Il a fallu convaincre nos interlocuteurs.

Puis les chefs de projets informatiques se sont trouvés face à des problèmes concrets, notamment la question de la valeur probante des e-documents, et les ont relayées à leurs directeurs informatiques, qui se sont alors tournés vers nous. Des synergies se sont ainsi peu à peu créées et la compréhension de la problématique s’est propagée.

Une fois les acteurs convaincus de l’importance de gérer correctement les documents électroniques, il reste ensuite la question du financement, puisque la mise en place de la fonction de coffre-fort électronique représente un certain coût. Une analyse de risque doit maintenant être accomplie et des budgets devront alors peut-être être trouvés.

De tels projets doivent être menés de manière interdisciplinaire entre les métiers (services de l’administration), les juristes, les services informatiques et les Archives ; il n’est pas possible de travailler dans des silos séparés. En tant qu’institution d’archives, nous avons également dû réfléchir à notre positionnement – agir traditionnellement en bout de chaîne uniquement ? Notre choix s’est porté sur une présence durant toute la vie du document et même plus largement, depuis la création même des systèmes d’information. Nous pensons que c’est une question à laquelle toutes les institutions d’archives devront répondre ces prochaines années.

Notes

(1) Anouk Dunant Gonzenbach (coll. Emmanuel Ducry), « L’archivage des documents électroniques à Genève, aspects organisationnels et techniques : le projet Gal@tae », in Françoise Hiraux ( dir.), De la préservation à la conservation. Stratégies pratiques d'archivage, Louvain-la-Neuve, Academia, à paraître.

(2) Exigences de base en matière d'archivage électronique, version 1.0 du 28.09.2009, Centre de coordination à long terme de documents électroniques, Berne.

Bibliographie

CONSEIL FÉDÉRAL SUISSE, 2002. Ordonnance concernant la tenue et la conservation des livres de comptes (Olico) du 24 avril 2002 [en ligne]. 24 avril 2002. [Consulté le 26 novembre 2013]. Disponible à l’adresse : http://www.admin.ch/opc/fr/classified-compilation/20001467/index.html

DLM FORUM FOUNDATION, 2011. MoReq2010: modular requirements for records systems [en ligne]. [Consulté le 26 novembre 2013]. Disponible à l’adresse : http://moreq2010.eu/pdf/MoReq2010-Core+Plugin(v1-0).pdf

ETAT DE GENÈVE. ARCHIVES D’ÉTAT, [sans date]. Politique de gouvernance des documents électroniques à l’Etat de Genève. République et canton de Genève [en ligne]. [Consulté le 26 novembre 2013]. Disponible à l’adresse : http://etat.geneve.ch/dt/archives/politique_gouvernance_documents_electroniques_etat_genave-66-5414-13734.html

GRAND CONSEIL DE LA RÉPUBLIQUE ET CANTON DE GENÈVE, 2000. Loi sur les archives publiques (LArch) du 1er décembre 2000 [en ligne]. 1 décembre 2000. [Consulté le 26 novembre 2013]. Disponible à l’adresse : http://www.geneve.ch/legislation/rsg/f/s/rsg_b2_15.html

GRAND CONSEIL DE LA RÉPUBLIQUE ET CANTON DE GENÈVE, 2001. Loi sur l’information du public, l’accès aux documents et la protection des données personnelles (LIPAD) du 5 octobre 2001 [en ligne]. 5 octobre 2001. [Consulté le 26 novembre 2013]. Disponible à l’adresse : http://www.ge.ch/legislation/rsg/f/s/rsg_a2_08.html

ORGANISATION INTERNATIONALE DE NORMALISATION, 2001. Information et documentation: « records management ». 1ère éd. 2001-09-15. Genève : ISO. Norme internationale ISO, 15489.

ORGANISATION INTERNATIONALE DE NORMALISATION, 2004. Éléments de données et formats d’échange -- Échange d’information -- Représentation de la date et de l’heure. 1ère éd. 1988. Genève : ISO. Norme internationale ISO, 8601.

ORGANISATION INTERNATIONALE DE NORMALISATION, 2012. Electronic archiving = Archivage électronique. 1st ed. 2012-02-01. Genève : ISO. International standard ISO, 14641-1.

Quelle qualité pour les archives électroniques ? Réflexions et retour d’expérience autour du processus décisionnel du Conseil d’Etat valaisan

Alain Dubois, Archives de l'État du Valais

En guise de préambule – quelques réflexions sur la qualité des archives électroniques

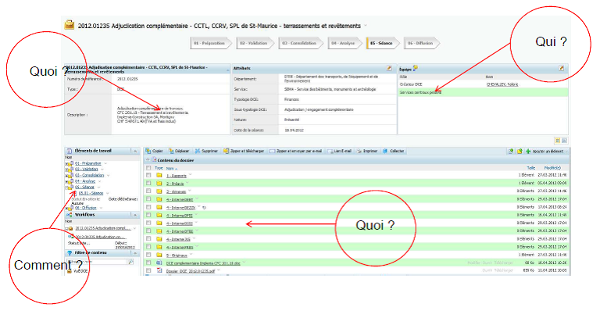

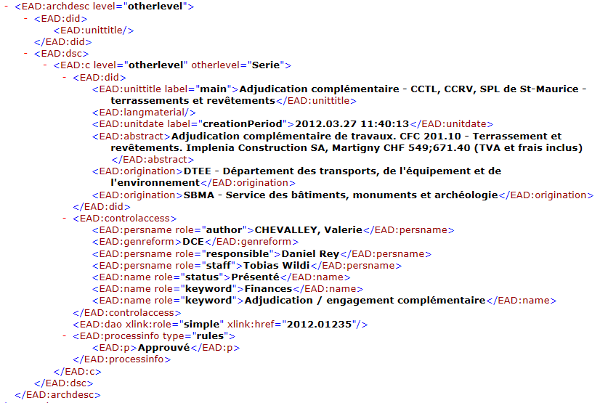

Une hypothèse de travail simple a guidé toute la réflexion des Archives de l’État du Valais en matière d’archivage électronique : la qualité des archives électroniques est étroitement liée à la qualité des données et des métadonnées qui sont extraites ou héritées des systèmes de gestion des documents, qu’il s’agisse d’une structure arborescente gérée par un système d’exploitation, d’un système de gestion électronique des documents ou d’un système de records management électronique(2). Les systèmes de gestion des documents et les plates-formes de pérennisation et d’archivage constituent en effet les deux faces d’une même médaille, dont l’avers dépend de la qualité du revers et réciproquement. C’est ainsi qu’il me paraît possible, en y ajoutant néanmoins une palette de nuances, de dégager trois niveaux de qualité. Et ces niveaux de qualité peuvent se mesurer à l’aune des normes de description du Conseil international des Archives, qui de facto répondent aux trois questions suivantes : Quoi ? Il s’agit de décrire le contenu des dossiers et des documents, ainsi que des données, sur la base de la norme ISAD(G)(3). Qui ? Il s’agit d’identifier et de décrire les producteurs des dossiers, des documents et des données, sur la base de la norme ISAAR (CPF)(4). Comment ? Il s’agit de documenter la manière dont se sont progressivement constitués les dossiers d’affaires, qui résultent toujours d’un processus d’activité, sur la base de la norme ISDF(5). Sur cette base, il est ainsi possible de distinguer :

- un niveau de qualité minimal. L’archiviste a peu de contrôle sur le(s) système(s) qui produi(sen)t les données et les métadonnées avant leur versement aux Archives. Il est dès lors très fortement tributaire de la qualité des systèmes de gestion des documents mis en place, notamment des attributs du système paramétrés par défaut qui lui permettent d’extraire les métadonnées qui décrivent le contenu des dossiers. Il lui sera néanmoins très difficile de garantir a posteriori une qualité qui a fait défaut initialement. Ce niveau de qualité, qui apporte des renseignements sur le quoi, se retrouve, entre autres, dans les structures arborescentes gérées par un système d’exploitation.

- un niveau de qualité intermédiaire. L’archiviste a la possibilité d’extraire des systèmes de gestion des documents des métadonnées qui décrivent le contenu des dossiers et renseignent sur les utilisateurs ou les groupes d’utilisateurs qui ont accès aux dossiers. Ce niveau de qualité, qui apporte des renseignements sur le quoi et le qui, se retrouve, entre autres, dans les systèmes de gestion électronique des documents et dans les systèmes de records management électronique.

- un niveau de qualité maximal. L’archiviste a la possibilité d’extraire des systèmes de gestion des documents des métadonnées qui décrivent le contenu des dossiers et renseignent non seulement sur les utilisateurs et les groupes d’utilisateurs, mais également sur la manière dont ont été progressivement constitués les dossiers. Ce niveau de qualité, qui apporte des renseignements sur le quoi, le qui et le comment, se retrouve dans les systèmes de gestion des affaires, qui intègrent à la fois la gestion par processus d’activités et le records management électronique.

Le niveau de qualité des archives électroniques est donc directement influencé par le système qui gère les données et les documents avant leur versement sur une plate-forme de pérennisation et d’archivage. A ce stade, il me paraît néanmoins nécessaire d’ajouter une seconde variable : le degré d’implication des archivistes dans la conception des systèmes de gestion des documents. En effet, plus l’archiviste participe à la définition et à l’implémentation des systèmes de gestion des documents, meilleures seront les chances d’en extraire des archives électroniques de qualité. Il est ainsi tout à fait possible d’augmenter la qualité des archives électroniques qui proviennent d’une structure arborescente issue d’un système d’exploitation, en y ajoutant nativement certaines métadonnées descriptives, de même que la qualité des archives électroniques extraites d’un système de gestion des affaires pourra être médiocre en raison d’une absence de paramétrage de certaines métadonnées descriptives dans le système d’origine. La prise en compte de ces deux variables milite donc clairement en faveur de l’intervention des archivistes durant tout le cycle de vie des documents et des données électroniques dans une perspective de gestion continue des documents ou de records continuum. Ce sont en tous les cas ces réflexions – cette intime conviction, serais-je tenté de dire – qui ont guidé et nourri l’action des Archives de l’État du Valais au cours des cinq dernières années en matière de gestion des documents et d’archivage électronique.